Un appello per più scienza in SEO

Pubblicato: 2022-04-17- Una brutta sorpresa: è stato solo un errore!

- Allora, dov'è il problema in tutto questo?

- Cosa hanno scoperto i dipendenti sul problema tecnico?

- Perché non eseguire tali analisi?

- Che cos'è un'ipotesi e come si formula una correttamente?

Probabilmente hai già sentito, ma per quelli di voi che non seguono ogni passaggio di Google, ecco un riepilogo:

All'inizio di agosto, c'è stato un massiccio aumento della fluttuazione dei risultati di ricerca su Google, in tutto il mondo e in tutte le lingue. Nei forum dei Webmaster e nei soliti forum di Black Hat, ci sono state speculazioni immediate sul lancio di un massiccio aggiornamento senza preavviso. Le fluttuazioni e i cambiamenti all'interno degli elenchi dei risultati di ricerca sono stati così enormi che diversi importanti portali SEO negli Stati Uniti hanno riportato il più grande aggiornamento di sempre.

In effetti, tutti gli strumenti SEO e i correttori di ranking sono stati improvvisamente colpiti da enormi cambiamenti nei risultati di ricerca di Google. I risultati della ricerca non solo sono cambiati; si sono capovolti, a volte con risultati assurdi, riempiendo le prime posizioni.

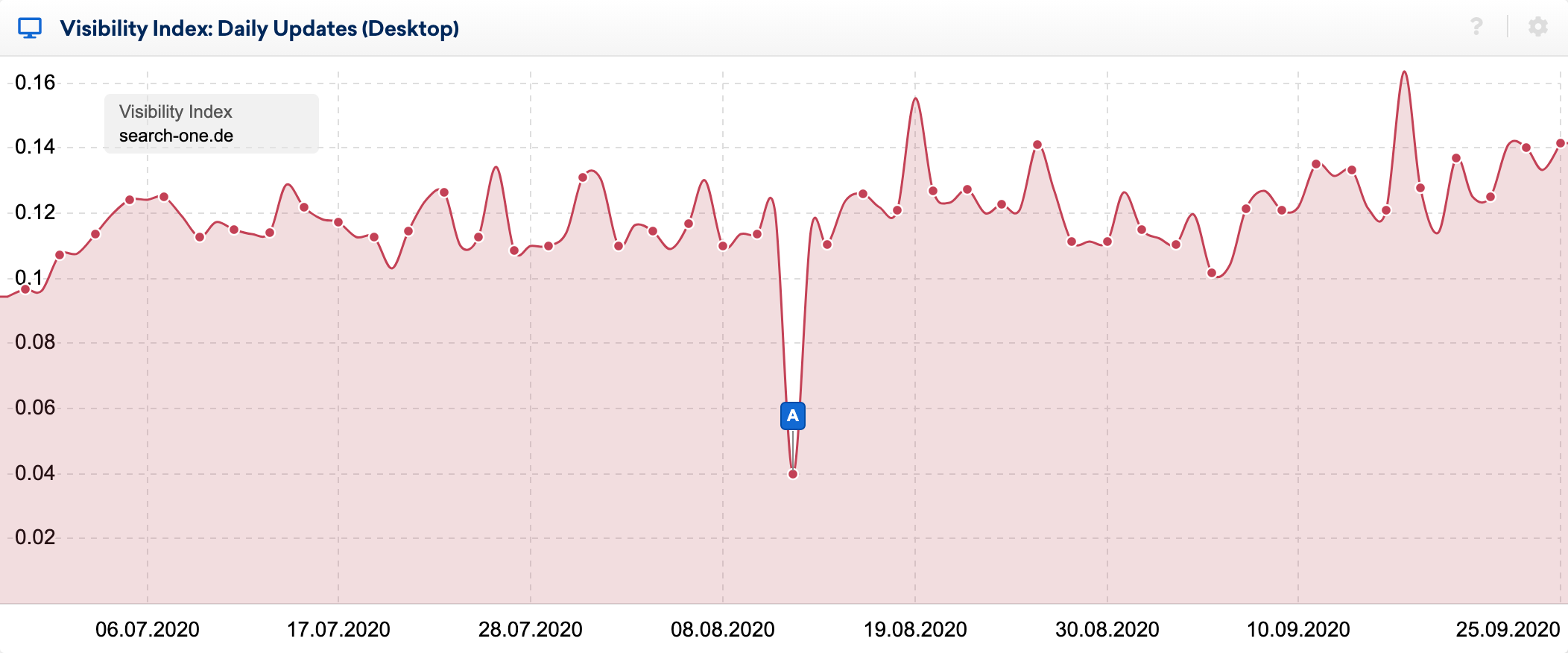

Puoi vedere gli effetti del bug molto chiaramente nell'indice di visibilità giornaliero:

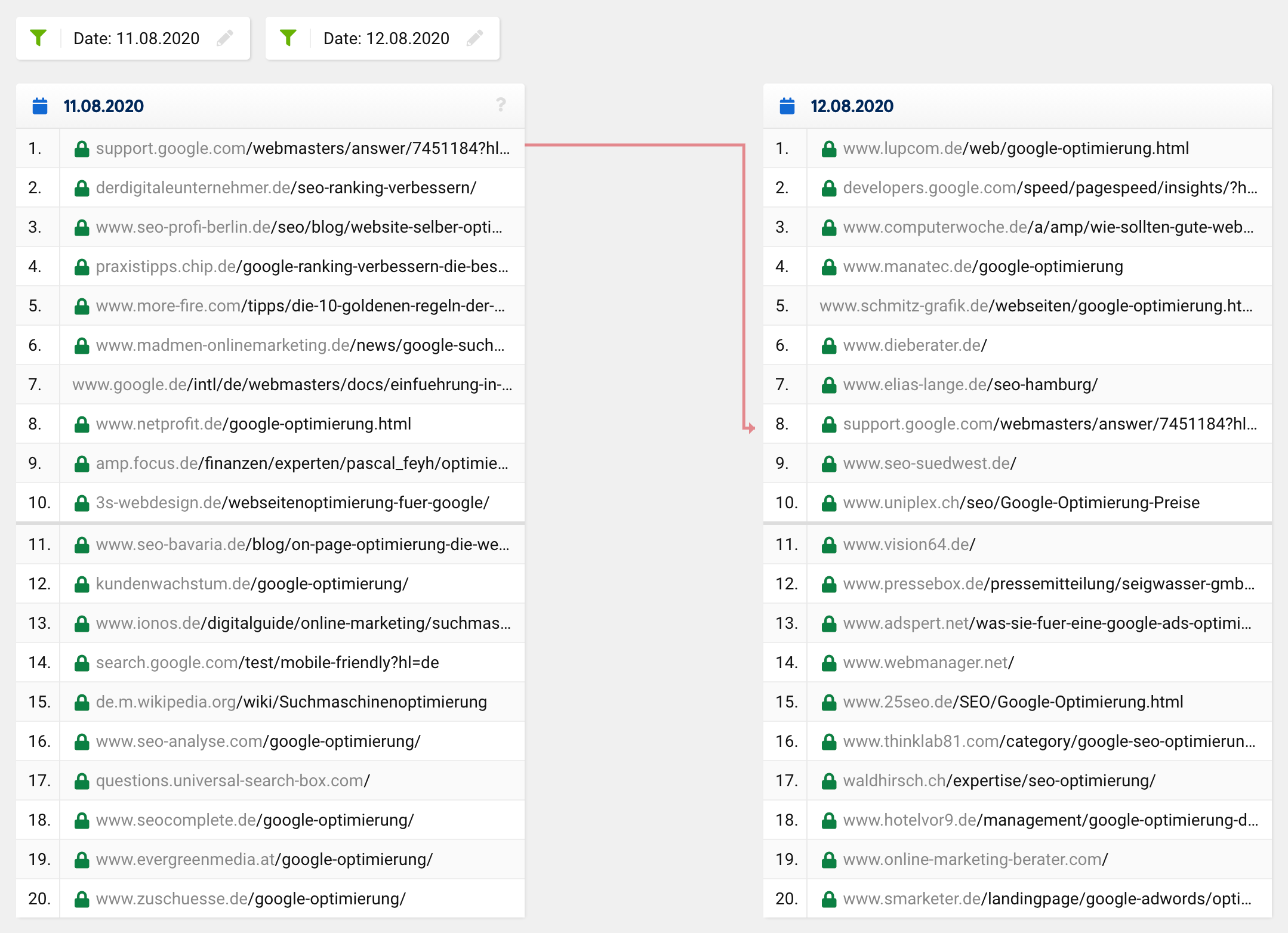

Utilizzando la fantastica funzione di confronto SERP nella casella degli strumenti SISTRIX, ho dato un'occhiata più da vicino ai cambiamenti all'interno delle prime 20 di alcune parole chiave, le cui classifiche osservo da molti anni. Ho fatto dozzine di analisi dei siti Web classificati per queste parole chiave e di solito so relativamente bene perché un URL si classifica dove lo fa.

Se dai un'occhiata al confronto SERP per la parola chiave "ottimizzazione di Google" al momento in questione, vedrai che l'intera top 20, ad eccezione di un URL, è cambiata completamente. Quello che prima era al 1 ° posto è sceso all'8 ° posto, con gli URL rimanenti che escono dal nulla, cioè dall'esterno dei primi 20 ai primi posti.

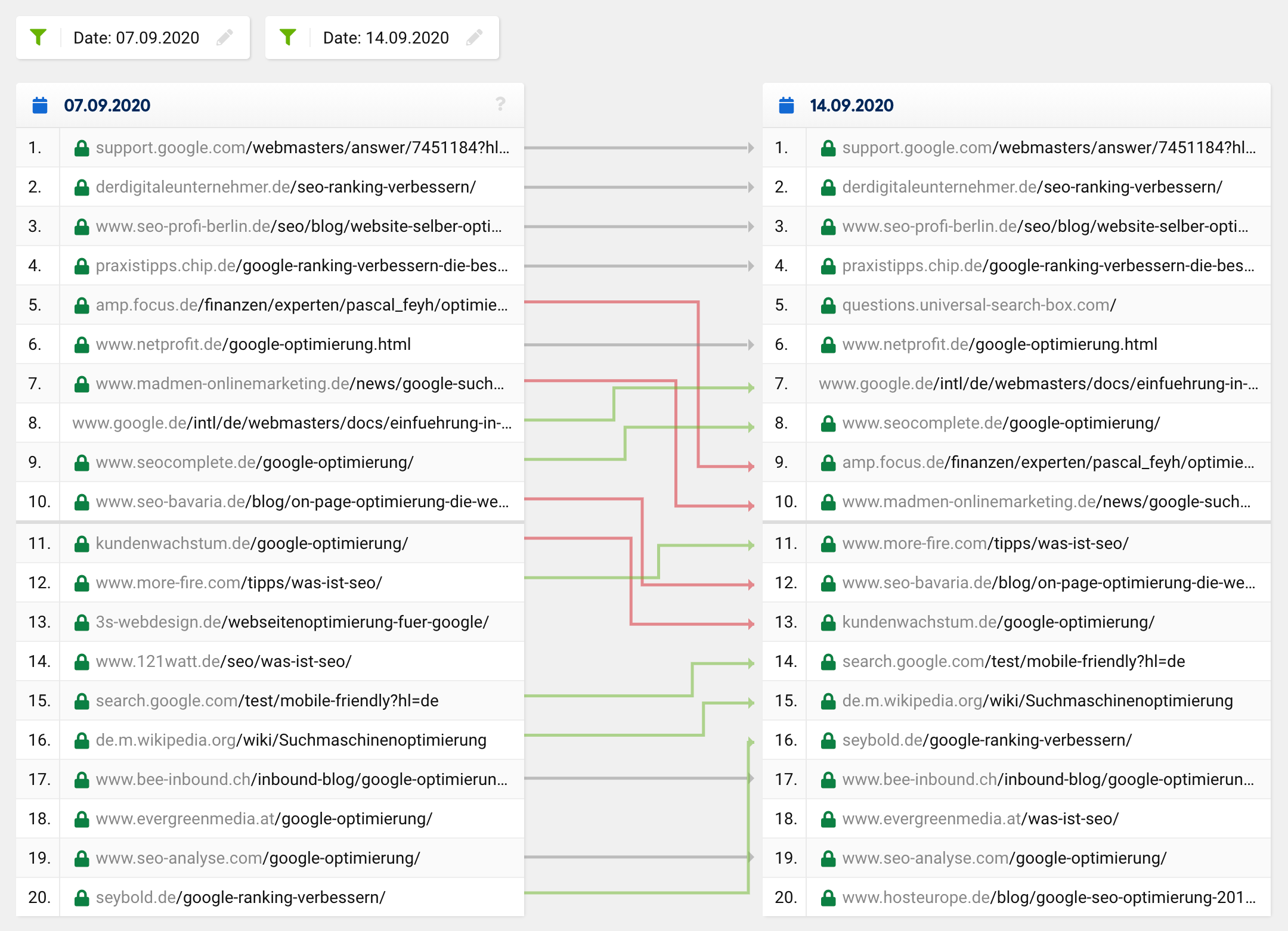

Un normale aggiornamento o un regolare cambio di classifica normalmente sarebbe più simile a questo:

Molti URL rimangono gli stessi, mentre alcuni URL si spostano in alto e altri in basso. Naturalmente, a volte un URL scompare dai primi 20 o si sposta in esso. Tuttavia, è incredibilmente raro che su 20 risultati, solo uno sia rimasto nella "nuova" top 20: questo è stato il caso su tutta la linea, non solo per una parola chiave specifica.

Dati cambiamenti di tale portata simili ai famigerati aggiornamenti fantasma, ci si aspetterebbe di vedere un aggiustamento nell'intento presunto dell'utente di una query di ricerca, che porterebbe quindi a cambiamenti fondamentali nella composizione della top 20 per alcune parole chiave. In tal caso, tuttavia, i risultati della ricerca migliorerebbero, cioè diventerebbero più pertinenti e significativi, cosa che ovviamente non è avvenuta con questo glitch.

La stragrande maggioranza dei SEO è rimasta sorpresa dai risultati di ricerca ovviamente assurdi e ha ipotizzato in tempi relativamente brevi che ci fosse un errore, o almeno sperava che si trattasse solo di un problema temporaneo. Mi sono sentito allo stesso modo, dato che alcuni dei miei siti web hanno perso completamente le loro classifiche più importanti nel giro di poche ore!

Una brutta sorpresa: è stato solo un errore!

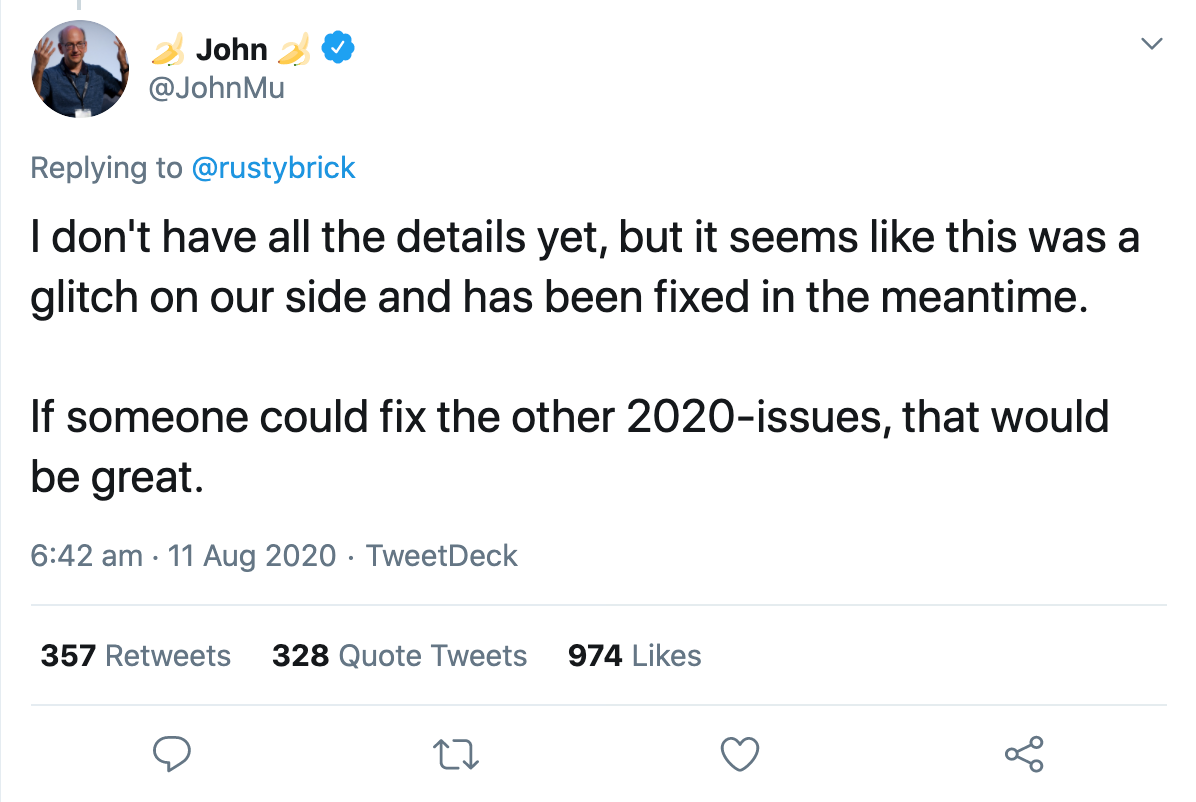

Quella stessa notte, un portavoce di Google ha confermato che si trattava di un bug che stavano risolvendo. Nel giro di poche ore tutto è tornato alla normalità. John Muller ha confermato via Twitter che il bug era stato corretto, ma che non aveva ancora tutti i dettagli:

Solo un giorno dopo, l'account ufficiale del Webmaster di Google ha confermato che i risultati della ricerca erano stati interessati da un apparente problema con il sistema di indicizzazione.

Ed è qui che la gente ha iniziato a speculare su cosa sarebbe potuto accadere esattamente.

Gary Illyes ha cercato di rendere le cose un po' più concrete descrivendo cosa fa effettivamente il sistema di indicizzazione, Caffeine. Secondo il suo tweet, ingerisce fetchlog, esegue il rendering e converte i dati recuperati, estrae collegamenti, metadati e dati strutturati, estrae e calcola alcuni segnali senza nome, pianifica nuove scansioni e crea l'indice che viene inviato alla pubblicazione. Per semplificare la comprensione, ha fornito alcuni esempi di cosa potrebbe andare storto, che si sarebbero poi riflessi nei risultati di ricerca modificati:

“Se la programmazione delle scansioni va storta, la scansione potrebbe rallentare. Se il rendering va storto, Google potrebbe fraintendere le pagine. Se la costruzione dell'indice va male, il ranking e il servizio potrebbero risentirne".

Ha poi sottolineato quanto sia complessa la ricerca e che migliaia di sistemi interconnessi devono lavorare insieme in modo impeccabile per fornire risultati pertinenti agli utenti. Se si gettasse un granello di sabbia nei macchinari, il risultato sarebbe un'interruzione come ieri.

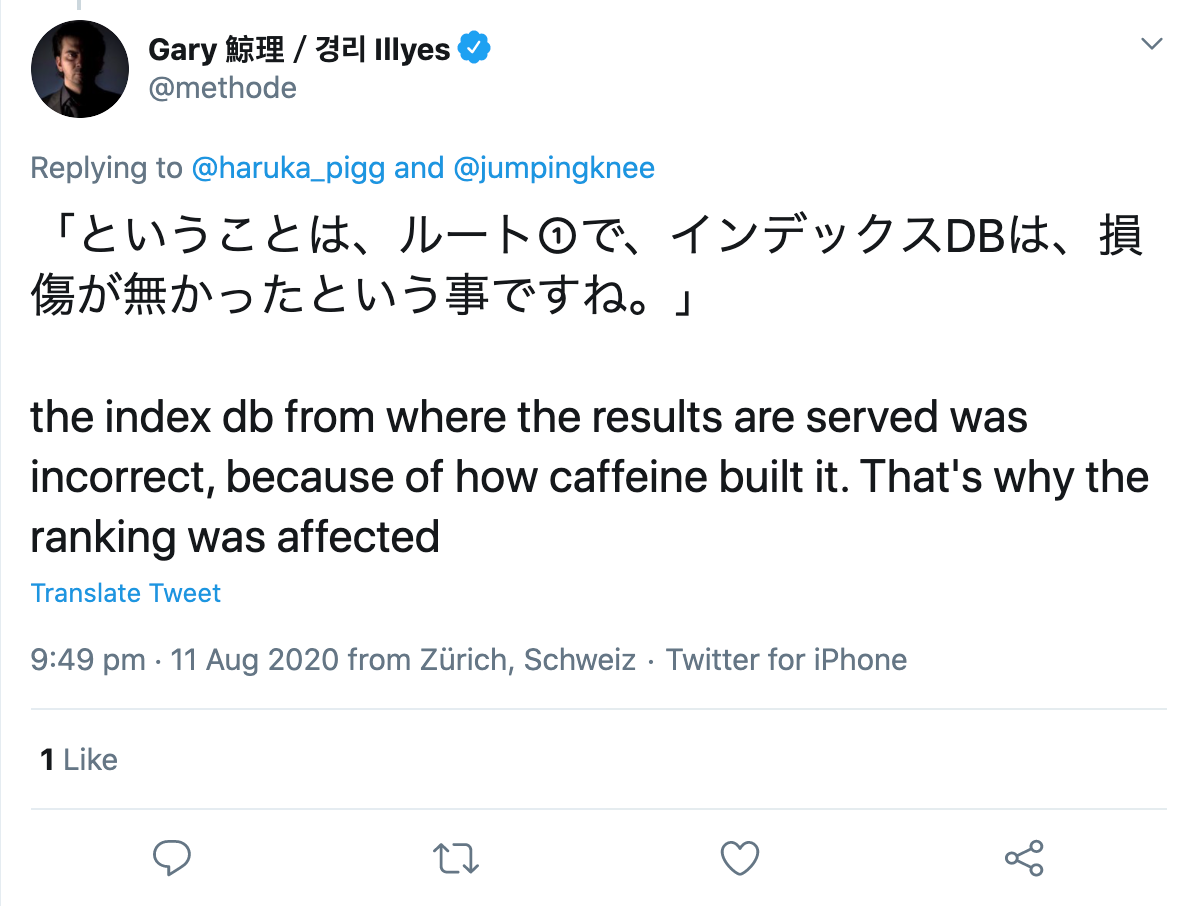

Quando gli è stato chiesto da un utente di Twitter, ha specificato che apparentemente c'era stato un errore nella costruzione dell'indice stesso:

Allora, dov'è il problema in tutto questo?

Il bug in sé non mi ha infastidito, poiché era solo questione di ore prima che Google risolvesse il problema. Tuttavia, alcuni commenti e pubblicazioni a riguardo in seguito mi hanno fatto piuttosto arrabbiare.

Sebbene Google avesse rivelato il problema in modo relativamente trasparente, alcuni SEO hanno cercato di dare un senso al bug con le buone o con le cattive e hanno iniziato a esaminare le modifiche per cercare modelli. Un dipendente di una nota agenzia SEO americana, che non voglio esporre a questo punto, ha iniziato ad analizzare i dati di Google Analytics di ogni cliente attuale ed ex e ha cercato di trarre conclusioni sul motivo dei cambiamenti di ranking.

Ritengo che questo stia superando il limite per diversi motivi, ma ne parleremo più avanti.

Cosa hanno scoperto i dipendenti sul problema tecnico?

Nel caso di aggiornamenti regolari di Google, tutte le sottopagine di un dominio sarebbero generalmente interessate dalla modifica, sia positiva che negativa. Questo non era il caso con l'attuale problema tecnico, perché mentre alcune sottopagine di uno stesso dominio hanno subito enormi perdite, altre hanno tratto profitto e alcune sono cambiate appena, se non del tutto.

La loro prima intuizione è stata quindi che non sembrava un tipico aggiornamento di Google. Fin qui tutto bene.

Ora diventa un po' avventuroso:

“Molte pagine che sono salite più in alto nelle classifiche contenevano informazioni mediche che contraddicevano il consenso scientifico. Per chiarimenti, qui si fa riferimento alle linee guida per la valutazione della qualità di Google che affermano che quando si determina l'EAT di una pagina su argomenti scientifici, dovrebbe essere creata da persone o organizzazioni con esperienza nel rispettivo campo e dovrebbe riflettere il consenso stabilito della scienza, dove uno esiste”.

Questa affermazione è "provata" dall'osservazione che alcuni articoli medici, che ovviamente contraddicono lo stato della scienza e hanno anche backlink cattivi o innaturali, si sono improvvisamente classificati molto meglio di prima e dopo il bug.

La loro teoria è che le pagine che dovrebbero essere svalutate a causa di problemi di qualità in realtà si classificano bene. Ad esempio, le pagine hackerate, le pagine con link innaturali o le pagine con affermazioni che si discostano dal consenso scientifico generale sarebbero state catapultate nelle prime posizioni.

Da ciò l'autore deduce quanto segue:

Se le classifiche di una pagina migliorano, questo potrebbe essere motivo di gioia, o forse era solo

un test per un aggiornamento futuro andato storto. Oppure potrebbe essere un'indicazione di un problema di qualità con il sito Web, che limitava il ranking della pagina, ma potrebbe non aver avuto un ruolo al momento del bug.

D'altra parte, se una pagina si è spostata in basso nelle classifiche, ciò potrebbe significare che sei stato superato da pagine di qualità inferiore o spam, che sono ancora una volta attualmente declassate dagli algoritmi di Google.

Uff! Davvero? A cosa serve questa intuizione per il mio lavoro SEO quotidiano?!

Perché non eseguire tali analisi?

A parte il fatto che hanno ancora accesso e utilizzano i dati di Google Analytics di ex clienti, vedo un problema molto più grande qui con l'approccio del dipendente:

Il problema è che se cerchi schemi senza ipotesi, troverai sempre qualcosa. Se poi prendi quel risultato, senza ulteriori test, come corretto, non ha nulla a che fare con la scienza.

Ci sono sempre schemi, a volte casuali, a volte causati da uno o più fattori. Non puoi prima cercare schemi e poi escogitare una teoria per spiegare ciò che osservi e, in seguito, prenderlo come realtà. Non è così che funziona la conoscenza.

Mi piacerebbe davvero vedere più metodi scientifici utilizzati nella SEO, ad esempio quando si tratta di fare ipotesi e poi testarle!

Che cos'è un'ipotesi e come si formula una correttamente?

Un'ipotesi è un presupposto ragionevole che viene fatto all'inizio di uno studio empirico . Questa ipotesi viene analizzata utilizzando metodi qualitativi o quantitativi e viene quindi confermata o smentita.

Quando si formula un'ipotesi, si assume una correlazione o nessuna correlazione tra due variabili . Una variabile indipendente è la causa, la variabile dipendente è il possibile effetto.

Esistono essenzialmente due tipi di ipotesi: dirette e non dirette.

Con un'ipotesi non orientata, assumi semplicemente che ci sia una correlazione tra due variabili. Ad esempio, il numero di siti web collegati influenza la visibilità di un dominio.

Con un'ipotesi diretta, invece, si valuta la presunta correlazione. Ad esempio: più backlink ha un articolo, migliore sarà il ranking.

Tuttavia, per fare un'ipotesi, dovresti considerare i seguenti criteri:

- Entrambe le variabili utilizzate devono essere misurabili.

- Le ipotesi devono essere formulate in modo obiettivo e conciso.

- Se vengono formulate più ipotesi, queste non devono contraddirsi.

- E: le ipotesi scientifiche devono poter essere confutate.

Poiché la maggior parte delle ipotesi nel campo della SEO non può essere smentita da un esperimento, non ci sono prove di cui parlare da una prospettiva scientifica. Allo stesso modo, non dovresti analizzare i risultati di alcuna query di ricerca per trarre conclusioni sui fattori di ranking utilizzati.

La consapevolezza che la correlazione non è uguale alla causalità è stata fortunatamente accettata negli ultimi anni. Gli studi sui fattori di ranking di qualsiasi fornitore di strumenti oggi non vengono più presi sul serio da nessun SEO esperto, il che significa che vengono eseguiti e pubblicati sempre meno.