Der ultimative On-Site-SEO-Leitfaden für Ihren Online-Shop

Veröffentlicht: 2017-03-14E- Commerce -Suchmaschinenoptimierung – Der ultimative On-Site-SEO-Leitfaden…

Als Blogger und Ladenbesitzer möchten wir unsere Websites sowohl für Suchmaschinen als auch für Benutzer attraktiv machen.

Eine Suchmaschine „betrachtet“ eine Website ganz anders als wir Menschen. Ihr Website-Design, ausgefallene Grafiken und gut geschriebene Blog-Beiträge zählen nichts, wenn Sie die in diesem Beitrag behandelte kritische On-Site-SEO verpasst haben.

SEO ist nicht tot.

Bei modernem SEO geht es nicht darum, die Suchmaschinen zu täuschen – es geht darum, mit den Suchmaschinen zusammenzuarbeiten, um Ihre Produkte und Inhalte bestmöglich zu präsentieren.

In diesem Beitrag zeigt uns SEO-Experte Itamar Gero genau, wie…

Der ultimative On-Site-SEO-Leitfaden für Ladenbesitzer und Blogger

E-Commerce ist ein riesiges Geschäft. Laut dem United States Census Bureau beliefen sich die E-Commerce-Umsätze allein in den USA im Jahr 2016 auf 394,9 Milliarden US-Dollar. Der steigende Trend bei den E-Commerce-Umsätzen und ihr Einfluss auf den Offline-Einzelhandel wird sich voraussichtlich bis weit in die 2020er Jahre weltweit fortsetzen.

Verständlicherweise ringen Online-Shop-Besitzer um Positionen, um immer größere Stücke vom E-Commerce-Kuchen zu nehmen. Aus diesem Grund hatte SEO schon immer oberste Priorität für die meisten E-Commerce-Marketingstrategien. Suchmaschinen sorgen für den qualifiziertesten und motiviertesten Traffic, der sich leichter in zahlende Kunden umwandeln lässt als Besucher von anderen Kanälen. Aus diesem Grund führen Websites hinter den Kulissen einen ständigen „Krieg“, um sich gegenseitig bei Schlüsselwörtern zu übertreffen, die sich auf ihre Produkte und Dienstleistungen beziehen.

Und obwohl es entmutigend ist, viele Konkurrenten zu haben, können Sie sich mit der Tatsache trösten, dass viele E-Commerce-Websites ihre SEO nicht richtig machen. Mit einem soliden Verständnis der Best Practices für SEO und viel harter Arbeit können Sie eine hohe Sichtbarkeit in der Suche erreichen, ohne die Bank zu sprengen.

SEO-Leitfaden für Ihren Online-Shop – Entfernen Sie die Kopfschmerzen!

Besonderer Hinweis zu diesem SEO-Leitfaden:

Dieser SEO-Leitfaden und dieses Tutorial gehören zu den ausführlichsten, die wir je erstellt haben. [Über 7000 Wörter und über 20 Bilder]

Es ist leicht, von SEO überwältigt zu werden und sich verwirrt zu fühlen, aber in Wirklichkeit ist es viel einfacher, dass es zunächst so aussieht.

Die Belohnungen für die richtige Suchmaschinenoptimierung sind RIESIG!

Obwohl sich dieser Leitfaden insbesondere auf eCommerce-SEO konzentriert, gilt vieles von dem, was wir hier beschreiben, gleichermaßen für Ihren Blog oder Ihre Unternehmenswebsite.

Zwei SEO-Ressourcen, die Sie benötigen:

=> Google Search Console

=> Screaming Frog SEO-Spinne

Was ist E-Commerce-SEO?

Einfach ausgedrückt ist E-Commerce-SEO der Prozess der Optimierung eines Online-Shops für eine bessere Sichtbarkeit in Suchmaschinen. Es hat vier Hauptaspekte, darunter:

- Stichwortforschung

- SEO vor Ort

- Linkaufbau

- Nutzungssignaloptimierung

In diesem Beitrag gehe ich auf den grundlegendsten und wohl wichtigsten der vier Bereiche ein: On-Site-SEO. Nach unserer Erfahrung aus der Zusammenarbeit mit Tausenden von Agenturen können wir den größten Einfluss auf das gesamte organische Traffic-Wachstum auf Optimierungen zurückführen, die wir auf den von uns betreuten E-Commerce-Websites vorgenommen haben.

Während Linkbuilding und andere Off-Page-SEO-Aktivitäten wichtig sind, gibt On-Site-SEO jedes Mal den Ton für den Erfolg an.

Das Wiederaufleben von On-Site-SEO

Onsite-SEO ist der Sammelbegriff für alle SEO-Aktivitäten innerhalb der Website. Es kann in zwei Segmente unterteilt werden: technisches SEO und Onpage-SEO. Technisches SEO befasst sich hauptsächlich damit, sicherzustellen, dass die Website betriebsbereit und für Such-Bot-Crawls verfügbar bleibt. On-Page-SEO hingegen ist eher darauf ausgerichtet, Suchmaschinen dabei zu helfen, die kontextbezogene Relevanz Ihrer Website für die von Ihnen anvisierten Keywords zu verstehen.

Ich konzentriere mich heute auf Onsite-SEO, da es in den letzten 3 Jahren oder so unbestreitbar wieder auflebte. Sie sehen, die SEO-Community durchlief Ende der 2000er Jahre bis etwa 2011 eine Phase, in der alle von der Akquisition eingehender Links besessen waren. Damals waren Links die mit Abstand stärkste Determinante des Google-Rankings. E-Commerce-Websites, die in brutale Ranking-Kämpfe verwickelt waren, waren der Kern dieser Bewegung, und der Wettbewerb drehte sich schließlich um die Frage, wer in der Lage ist, die meisten Links zu erhalten – ethisch oder anderweitig.

Schließlich führte Google die Panda- und Penguin-Updates ein, die viele Websites bestraften, die Link- und Inhalts-Spam vermehrten. Qualitativ hochwertige Links, die das Ranking verbesserten, wurden immer schwerer zu bekommen, wodurch der Einfluss von On-Site-SEO-Signalen auf das Ranking stärker ausgeprägt wurde. Die SEO-Community begann bald, erfolgreiche E-Commerce-SEO-Kampagnen zu sehen, die sich mehr auf die technische und On-Page-Optimierung als auf die starke Linkakquise konzentrierten.

Dieser Beitrag zeigt Ihnen, was Sie auf Ihrer Website tun können, um von der On-Site-SEO-Renaissance zu profitieren:

Technisches SEO

Wie bereits erwähnt, geht es beim technischen SEO hauptsächlich darum, sicherzustellen, dass Ihre Website eine gute Betriebszeit hat, schnell lädt, den Benutzern sicheres Surfen bietet und eine gute Bot- und Benutzernavigation durch ihre Seiten ermöglicht. Hier ist eine Liste der Dinge, die Sie ständig überwachen müssen, um ein hohes Maß an technischer Gesundheit zu gewährleisten:

Die Robots.txt-Datei

Die robots.txt-Datei ist ein sehr kleines Dokument, auf das Such-Bots zugreifen, wenn sie Ihre Website besuchen. Dieses Dokument sagt ihnen, auf welche Seiten zugegriffen werden kann, welche Bots dies tun dürfen und welche Seiten tabu sind. Wenn robots.txt den Zugriff auf eine bestimmte Seite oder einen Verzeichnispfad innerhalb einer Website verbietet, halten sich Bots von verantwortlichen Websites an die Anweisung und besuchen diese Seite überhaupt nicht. Das bedeutet, dass unzulässige Seiten nicht in den Suchergebnissen aufgeführt werden. Jeglicher Linkwert, der zu ihnen fließt, wird zunichte gemacht, und diese Seiten können auch keinen Linkwert weitergeben.

Stellen Sie beim Überprüfen Ihrer robots.txt-Datei sicher, dass alle Seiten, die für die Öffentlichkeit zugänglich sind, nicht unter Sperrparameter fallen. Ebenso sollten Sie sicherstellen, dass Seiten, die der Absicht Ihrer Zielgruppe nicht dienen, von der Indexierung ausgeschlossen werden.

Mehr Seiten von Suchmaschinen indizieren zu lassen, mag nach einer guten Sache klingen, ist es aber nicht. Google und andere Webportale versuchen ständig, die Qualität der in ihren SERPs angezeigten Einträge zu verbessern. (Ergebnisseiten von Suchmaschinen)

Daher erwarten sie von Webmastern, dass sie bei den Seiten, die sie zur Indexierung einreichen, vernünftig vorgehen, und sie belohnen diejenigen, die sich daran halten.

Im Allgemeinen fallen Suchmaschinenanfragen unter eine von drei Klassifikationen:

- Navigation

- Transaktional

- Informativ

Wenn Ihre Seiten die dahinter stehenden Absichten nicht erfüllen, sollten Sie die Verwendung von robots.txt in Betracht ziehen, um den Bot-Zugriff darauf zu verhindern. Dadurch wird Ihr Crawl-Budget besser genutzt und der interne Link-Equity Ihrer Website wird auf wichtigere Seiten fließen. Auf einer E-Commerce-Website sind die Arten von URLs, auf die Sie normalerweise den Zugriff sperren möchten, folgende:

- Kassenseiten – Dies sind eine Reihe von Seiten, die Käufer verwenden, um ihre Einkäufe auszuwählen und zu bestätigen. Diese Seiten sind einzigartig für ihre Sitzungen und daher für niemanden im Internet von Interesse.

- Dynamische Seiten – Diese Seiten werden durch eindeutige Benutzeranfragen wie interne Suchen und Seitenfilterkombinationen erstellt. Wie Checkout-Seiten werden diese Seiten für einen bestimmten Benutzer generiert, der die Anfrage gestellt hat. Daher sind sie für die meisten Menschen im Web uninteressant, was den Anreiz für Suchmaschinen, sie zu indizieren, sehr schwach macht. Darüber hinaus verfallen diese Seiten schließlich und senden 404 Not Found-Antworten, wenn sie von Suchmaschinen erneut gecrawlt werden. Dies kann als Signal für einen schlechten Zustand der Website gewertet werden, was sich negativ auf die Sichtbarkeit eines Online-Shops in den Suchergebnissen auswirken kann.

Dynamische Seiten sind leicht an den Zeichen „?“ zu erkennen. und „=“ in ihren URLs. Sie können verhindern, dass sie indexiert werden, indem Sie eine Zeile in der robots.txt-Datei hinzufügen, die etwa so lautet: disallow: *?

- Staging-Seiten – Dies sind Seiten, die sich derzeit in der Entwicklung befinden und für die Öffentlichkeit nicht geeignet sind. Richten Sie im Verzeichnis Ihrer Website einen Pfad speziell für das Staging von Webseiten ein und vergewissern Sie sich, dass die robots.txt-Datei dieses Verzeichnis blockiert.

- Backend-Seiten – Diese Seiten sind nur für Site-Administratoren. Natürlich möchten Sie, dass die Öffentlichkeit die Seiten nicht besucht – geschweige denn sie in den Suchergebnissen findet. Alles, von Ihrer Administrator-Anmeldeseite bis hin zu den internen Site-Kontrollseiten, muss unter eine robots.txt-Einschränkung gestellt werden, um unbefugten Zugriff zu verhindern.

Beachten Sie, dass die robots.txt-Datei nicht die einzige Möglichkeit ist, die Indexierung von Seiten einzuschränken. Zu diesem Zweck kann unter anderem auch das Meta-Richtlinien-Tag noindex verwendet werden. Abhängig von der Art der Deindizierungssituation kann die eine besser geeignet sein als die andere.

Die XML-Sitemap

Die XML-Sitemap ist ein weiteres Dokument, das Suchbots lesen, um nützliche Informationen zu erhalten. Diese Datei listet alle Seiten auf, die von Google und anderen Spidern gecrawlt werden sollen. Eine gute Sitemap enthält Informationen, die Bots eine Vorstellung von Ihrer Informationsarchitektur, der Häufigkeit, mit der jede Seite geändert wird, und dem Verbleib von Assets wie Bildern innerhalb der Dateipfade Ihrer Domain vermitteln.

Obwohl XML-Sitemaps auf keiner Website erforderlich sind, sind sie für Online-Shops aufgrund der Anzahl der Seiten, die eine typische E-Commerce-Website hat, sehr wichtig. Wenn eine Sitemap vorhanden ist und an Tools wie die Google Search Console übermittelt wird, neigen Suchmaschinen dazu, Seiten zu finden und zu indizieren, die sich tief in der URL-Hierarchie Ihrer Website befinden.

Ihr Webentwickler sollte in der Lage sein, eine XML-Sitemap für Ihre E-Commerce-Site einzurichten. Meistens haben E-Commerce-Sites es bereits, wenn ihre Entwicklungszyklen abgeschlossen sind. Sie können dies überprüfen, indem Sie zu [www.yoursite.com/sitemap.xml] gehen. Wenn Sie so etwas sehen, haben Sie Ihre XML-Sitemap bereits eingerichtet und ausgeführt:

Das Vorhandensein einer XML-Sitemap ist keine Garantie dafür, dass alle darin aufgeführten URLs für die Indexierung berücksichtigt werden.

Die Übermittlung der Sitemap an die Google Search Console stellt sicher, dass der Bot des Suchgiganten die Sitemap findet und liest. Melden Sie sich dazu einfach bei Ihrem Search Console-Konto an und suchen Sie die Property, die Sie verwalten möchten. Gehen Sie zu Crawl>Sitemaps und klicken Sie oben rechts auf die Schaltfläche „Neue Sitemap hinzufügen/testen“. Geben Sie einfach den URL-Slug Ihrer XML-Sitemap ein und klicken Sie auf „Senden“.

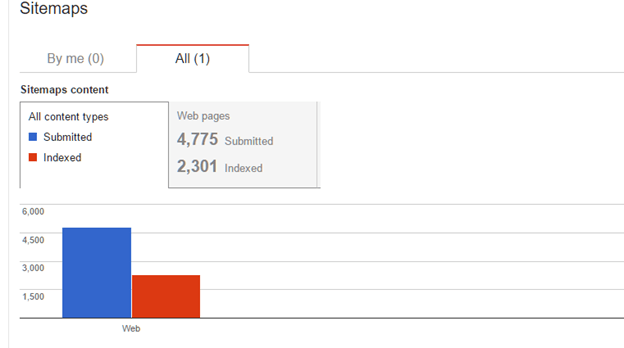

Sie sollten in 2-4 Tagen Daten auf Ihrer Sitemap sehen können. So wird es aussehen:

Beachten Sie, dass der Bericht Ihnen mitteilt, wie viele Seiten in der Sitemap eingereicht (aufgelistet) und wie viele von Google indexiert wurden. In vielen Fällen erhalten E-Commerce-Websites nicht jede Seite, die sie in die von Google indizierte Sitemap einreichen. Eine Seite kann aus einem von mehreren Gründen nicht indexiert werden, darunter:

- Die URL ist tot – Wenn eine Seite absichtlich gelöscht wurde oder mit technischen Problemen behaftet ist, wird sie wahrscheinlich 4xx- oder 5xx-Fehler liefern. Wenn die URL in der Sitemap aufgeführt ist, indexiert Google eine Seite von einer URL, die nicht richtig funktioniert, nicht. Wenn eine einmal live geschaltete Seite, die in der Sitemap aufgeführt ist, für längere Zeit ausfällt, kann sie ebenfalls aus dem Google-Index entfernt werden.

- Die URL wird umgeleitet – Wenn eine URL umgeleitet wird und entweder einen 301- oder einen 302-Antwortcode liefert, macht es keinen Sinn, sie in der Sitemap zu haben. Stattdessen sollte die Zielseite der Weiterleitung aufgelistet werden, falls sie noch nicht vorhanden ist. Wenn eine Weiterleitungs-URL in einer Sitemap aufgeführt ist, besteht eine gute Chance, dass Google sie einfach ignoriert und sie als nicht indexiert meldet.

- Die URL wird blockiert – Wie im Abschnitt „robots.txt“ besprochen, müssen nicht alle Seiten einer E-Commerce-Website indexiert werden. Wenn eine Webseite durch robots.txt oder das Meta-Tag „noindex“ blockiert wird, macht es keinen Sinn, sie in der XML-Sitemap aufzulisten. Die Search Console zählt es genau deshalb als nicht indiziert, weil Sie darum gebeten haben.

Checkout-Seiten, Blog-Tag-Seiten und andere Produktseiten mit Duplicate Content sind Beispiele für Seiten, die nicht in der XML-Sitemap aufgeführt werden müssen.

- Die URL hat einen kanonischen Link – Das HTML-Tag rel=canonical wird häufig in Online-Shops verwendet, um Suchmaschinen mitzuteilen, welche Seite von mehreren sehr ähnlichen Seiten indexiert werden soll. Dies passiert häufig, wenn ein Produkt mehrere SKUs mit sehr kleinen Unterscheidungsmerkmalen hat. Anstatt Google auswählen zu lassen, welche Seite in den SERPs angezeigt werden soll, erhielten Webmaster die Möglichkeit, Suchmaschinen mitzuteilen, welche Seite die „echte“ Seite ist, die sie sehen möchten.

Wenn Ihre E-Commerce-Website Produktseiten mit dem Element rel=canonical enthält, müssen Sie diese nicht in Ihrer Sitemap aufführen. Google wird sie wahrscheinlich sowieso ignorieren und denjenigen anerkennen, auf den sie zeigen.

- Die Seite hat dünnen Inhalt – Google definiert dünnen Inhalt als Seiten mit wenig bis gar keinem Mehrwert. Beispiele hierfür sind Seiten mit wenig oder gar keinem Textinhalt oder Seiten, die zwar Text enthalten, aber andere Seiten innerhalb der Website oder an anderer Stelle im Web duplizieren. Wenn Google eine Seite als dünn einstuft, wird sie in den Suchergebnissen entweder abgelehnt oder komplett ignoriert.

Wenn Sie Produktseiten haben, die Boilerplate-Inhalte enthalten, die von Herstellerseiten oder anderen Seiten Ihrer Website übernommen wurden, ist es in der Regel sinnvoll, die Indizierung darauf zu blockieren, bis Sie die Zeit und die Arbeitskraft haben, aussagekräftigere und einzigartigere Beschreibungen zu schreiben. Daraus folgt auch, dass Sie es vermeiden sollten, diese Seiten in Ihrer XML-Sitemap aufzulisten, nur weil sie weniger wahrscheinlich indexiert werden.

- Es gibt eine Strafe auf Seitenebene – In seltenen Fällen können Suchmaschinen manuelle oder algorithmische Maßnahmen gegen Websites ergreifen, die gegen ihre Qualitätsrichtlinien verstoßen. Wenn eine Seite Spam ist oder gehackt und mit Malware infiziert wurde, kann sie aus dem Index entfernt werden. Natürlich möchten Sie Seiten wie diese aus Ihrer Sitemap entfernen.

- Die URL ist redundant – Doppelte URLs in der XML-Sitemap werden erwartungsgemäß nicht zweimal aufgeführt. Der zweite wird wahrscheinlich ignoriert und aus dem Index entfernt. Sie können dieses Problem lösen, indem Sie Ihre Sitemap in Ihrem Browser öffnen und als XML-Dokument speichern, das Sie in Excel öffnen können. Wechseln Sie von dort zur Registerkarte Daten. Markieren Sie die Spalte, in der sich die URLs in Ihrer Sitemap befinden, und klicken Sie auf Duplikate entfernen.

- Eingeschränkte Seiten – Seiten, die passwortgeschützt sind oder nur Zugriff auf bestimmte IPs gewähren, werden von Suchmaschinen nicht gecrawlt und daher nicht indexiert.

Je weniger unangemessene Seiten Sie in Ihrer Sitemap auflisten, desto besser wird Ihr Verhältnis von Einreichung zu Indizierung sein. Dies hilft Suchmaschinen zu verstehen, welche Seiten innerhalb Ihrer Domain am wichtigsten sind, und ermöglicht es ihnen, eine bessere Leistung für die von ihnen repräsentierten Keywords zu erzielen.

Crawling-Fehler

In Online-Shops werden Produkte routinemäßig hinzugefügt und gelöscht, abhängig von vielen Faktoren. Wenn indexierte Produkt- oder Kategorieseiten gelöscht werden, bedeutet dies nicht zwangsläufig, dass Suchmaschinen diese automatisch vergessen. Bots werden einige Monate lang weiterhin versuchen, diese URLs zu crawlen, bis sie repariert oder aufgrund chronischer Nichtverfügbarkeit aus dem Index genommen werden.

Technisch gesehen sind Crawling-Fehler Seiten, auf die Bots nicht erfolgreich zugreifen können, weil sie HTTP-Fehlercodes zurückgeben. Unter diesen Codes ist 404 der gebräuchlichste, aber es gelten auch andere im 4xx-Bereich. Obwohl Suchmaschinen erkennen, dass Crawling-Fehler auf jeder Website normal sind, können zu viele davon die Sichtbarkeit der Suche beeinträchtigen. Crawling-Fehler sehen in der Regel wie lose Enden auf einer Website aus, die den ordnungsgemäßen Fluss der internen Link-Equity zwischen den Seiten stören können.

Crawling-Fehler werden normalerweise durch die folgenden Vorkommnisse verursacht:

- Absichtlich gelöschte Seiten

- Versehentlich gelöschte Seiten

- Abgelaufene dynamische Seiten

- Serverprobleme

Um zu sehen, wie viele Crawling-Fehler Sie auf Ihrer E-Commerce-Website haben und welche URLs betroffen sind, können Sie auf die Google Search Console zugreifen und zu der betreffenden Eigenschaft gehen. Gehen Sie im linken Seitenleistenmenü zu Crawl>Crawling-Fehler . Sie sollten einen ähnlichen Bericht wie diesen sehen:

Abhängig von den Arten von Seiten, die Sie in Ihrem Crawling-Fehlerbericht finden, gibt es verschiedene Möglichkeiten, sie anzugehen, darunter:

- Versehentlich gelöschte Seiten reparieren – Wenn die URL zu einer Seite gehört, die versehentlich gelöscht wurde, wird das Problem durch einfaches erneutes Veröffentlichen der Seite unter derselben Webadresse behoben.

- Indexierung dynamischer Seiten blockieren – Wie bereits empfohlen, können dynamische Seiten, die ablaufen und zu Crawling-Fehlern führen, verhindert werden, indem der Bot-Zugriff mithilfe von robots.txt blockiert wird. Wenn überhaupt keine dynamische Seite indexiert wird, wird kein Crawl-Fehler von Suchmaschinen erkannt.

- 301-Umleitung von der alten Seite auf die neue Seite – Wenn eine Seite absichtlich gelöscht und eine neue veröffentlicht wurde, um sie zu ersetzen, verwenden Sie eine 301-Umleitung, um Such-Bots und menschliche Benutzer auf die Seite zu leiten, die ihren Platz eingenommen hat. Dies verhindert nicht nur das Auftreten eines Crawl-Fehlers, sondern gibt auch den Linkwert weiter, den die gelöschte Seite einmal hatte. Gehen Sie jedoch nicht davon aus, dass die Lösung für jeden Crawling-Fehler eine 301-Umleitung ist. Zu viele Weiterleitungen können sich negativ auf die Geschwindigkeit der Website auswirken.

- Beheben Sie Serverprobleme – Wenn Serverprobleme die Hauptursache für Ausfallzeiten sind, ist die Zusammenarbeit mit Ihrem Webentwickler und Ihrem Hosting-Dienstleister Ihre beste Lösung.

- Ignorieren Sie sie – Wenn Seiten absichtlich gelöscht werden, aber keine große Bedeutung haben und keine Ersatzseite geplant ist, können Sie Suchmaschinen einfach erlauben, sie in ein paar Monaten aus dem Index zu entfernen.

So wenige Crawling-Fehler wie möglich zu haben, ist ein Markenzeichen einer verantwortungsbewussten Online-Shop-Administration. Eine monatliche Überprüfung Ihres Crawling-Fehlerberichts sollte es Ihnen ermöglichen, den Überblick zu behalten.

SEO-Leitfaden für defekte Links

Defekte Links verhindern die Bewegung von Suchspinnen von Seite zu Seite. Sie sind auch schlecht für die Benutzererfahrung, da sie Besucher auf einer Website in Sackgassen führen. Aufgrund des Umfangs der Seiten und der komplexen Informationsarchitektur der meisten E-Commerce-Websites kommt es häufig vor, dass hier und da fehlerhafte Links auftreten.

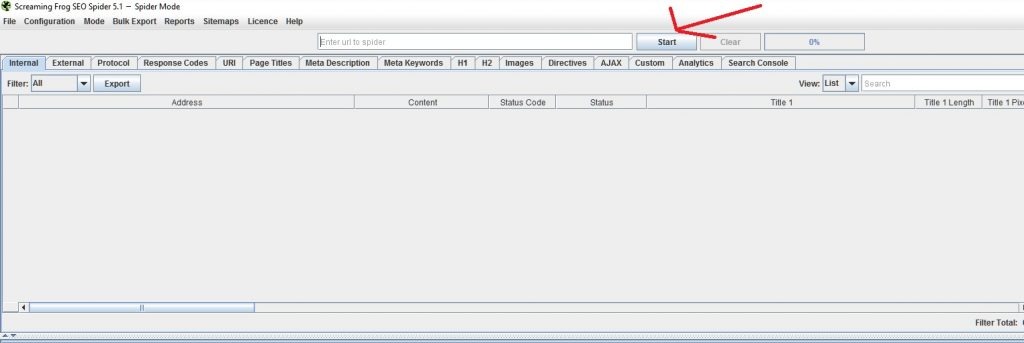

Kaputte Links werden normalerweise entweder durch Fehler in den Ziel-URLs von Links oder durch Links zu Seiten verursacht, die 404-Nicht-gefunden-Server-Antwortcodes anzeigen. Um Ihre Website auf Crawl-Fehler zu überprüfen, können Sie ein Tool namens Screaming Frog SEO Spider verwenden. Es gibt eine kostenlose, eingeschränkte Version und eine Vollversion, die 99 GBP pro Jahr kostet. Für kleinere Online-Shops sollte die kostenlose Version ausreichen. Bei Websites mit Tausenden von Seiten benötigen Sie die kostenpflichtige Version für einen gründlichen Scan.

Um mit Screaming Frog nach defekten Links zu suchen, stellen Sie die App einfach so ein, dass sie im Standard-Spider-Modus funktioniert. Geben Sie die URL Ihrer Homepage ein und klicken Sie auf die Schaltfläche Start.

Warten Sie, bis der Crawl beendet ist. Abhängig von der Anzahl der Seiten und Ihrer Verbindungsgeschwindigkeit kann das Crawlen mehrere Minuten bis zu einer Stunde dauern.

Wenn der Crawl beendet ist, gehen Sie zu Bulk Export und klicken Sie auf „All Anchor Text“. Anschließend müssen Sie die Daten als CSV-Datei speichern und in Excel öffnen. Es sollte so aussehen:

Gehen Sie zu Spalte F (Statuscode) und sortieren Sie die Werte vom größten zum kleinsten. Sie sollten in der Lage sein, die defekten Links oben zu finden. In diesem Fall hat diese Seite nur 4 defekte Links.

Spalte B (Quelle) verweist auf die Seite, auf der der Link gefunden und bearbeitet werden kann. Spalte C (Ziel) bezieht sich auf die URL, auf die der Link zeigt. Spalte E (Anker) bezieht sich auf den Text, an dem der Link auf der Quellseite angehängt ist.

Sie können defekte Links mit einer der folgenden Methoden reparieren:

- Korrigieren Sie die Ziel-URL – Wenn die Ziel-URL falsch geschrieben wurde, korrigieren Sie den Tippfehler und schalten Sie den Link live.

- Entfernen Sie den Link – Wenn es keinen Schreibfehler in der Ziel-URL gab, aber die Seite, auf die verlinkt wurde, nicht mehr existiert, entfernen Sie einfach den Hyperlink.

- Ersetzen Sie den Link – Wenn der Link auf eine Seite verweist, die gelöscht wurde, es aber eine Ersatzseite oder eine andere Seite gibt, die sie ersetzen kann, ersetzen Sie die Ziel-URL in Ihrem CMS.

Das Reparieren defekter Links verbessert die Verbreitung von Link Equity und gibt Suchmaschinen einen besseren Eindruck vom technischen Zustand Ihrer Website.

Duplicate Content und SEO für Ihren Online-Shop

Wie bereits erwähnt, leiden Online-Shops aufgrund der Anzahl der von ihnen angebotenen Produkte und der Ähnlichkeiten in den Namen ihrer SKUs häufiger unter Problemen mit der Duplizierung von Inhalten. Wenn Google genügend Ähnlichkeiten zwischen Seiten erkennt, entscheidet es, welche Seiten in seinen Suchergebnissen angezeigt werden. Leider stimmt die Seitenauswahl von Google normalerweise nicht mit Ihrer überein.

Um Seiten in Ihrer E-Commerce-Website zu finden, die möglicherweise von Duplizierungsproblemen betroffen sind, gehen Sie zur Google Search Console und klicken Sie in der linken Seitenleiste auf Search Appearance. Klicken Sie auf den HTML-Verbesserungsbericht und Sie sollten so etwas sehen:

Der blaue verlinkte Text weist darauf hin, dass Ihre Website Probleme mit einer bestimmten Art von HTML-Problem hat. In diesem Fall handelt es sich um doppelte Title-Tags. Durch Anklicken gelangen Sie zu den betreffenden Seiten. Anschließend können Sie den Bericht in eine CSV-Datei exportieren und in Excel öffnen.

Untersuchen Sie den Bericht und die betroffenen URLs. Analysieren Sie, warum sich Titel-Tags und Meta-Beschreibungen möglicherweise duplizieren. Bei Online-Shops kann dies folgende Ursachen haben:

- Lazy Title Tag Writing – Auf einigen schlecht optimierten Websites hinterlassen Webentwickler möglicherweise alle Seiten mit denselben Titel-Tags. Normalerweise ist es der Markenname der Website. Dies kann behoben werden, indem die Titel-Tags bearbeitet und jede Seite entsprechend der Essenz ihres Inhalts benannt wird.

- Sehr ähnliche Produkte – Einige Online-Shops haben Produkte mit sehr ähnlichen Eigenschaften. Beispielsweise kann ein E-Commerce-Geschäft, das Kleidungsstücke verkauft, ein Hemd verkaufen, das in 10 verschiedenen Farben erhältlich ist. Wenn jede Farbe als eindeutige SKU behandelt wird und mit einer eigenen Seite geliefert wird, können die Titel-Tags und Meta-Beschreibungen sehr ähnlich sein.

Wie in einem vorherigen Abschnitt erwähnt, kann die Verwendung des HTML-Elements rel=canonical Bots auf die Version dieser Seiten verweisen, die Sie indizieren möchten. Es hilft Suchmaschinen auch zu verstehen, dass die Duplizierung auf Ihrer Website beabsichtigt ist.

- Versehentliche Duplizierung – In einigen Fällen könnten E-Commerce-CMS-Plattformen falsch konfiguriert sein und mit Seitenduplizierungen Amok laufen. In diesem Fall ist die Hilfe eines Webentwicklers bei der Behebung der Grundursache erforderlich. Wahrscheinlich müssen Sie die doppelten Seiten löschen und per 301 auf das Original umleiten.

Bonus : Die Seiten, die mit kurzen oder langen Titel-Tags und Meta-Beschreibungen gekennzeichnet sind, können einfach bearbeitet werden, indem Sie diese Felder bearbeiten und sicherstellen, dass die Längenparameter eingehalten werden. Mehr dazu im Abschnitt Titel-Tags und Meta-Beschreibungen dieses Handbuchs.

Website-Geschwindigkeit

Im Laufe der Jahre hat sich die Seitengeschwindigkeit zu einem der wichtigsten Rankingfaktoren bei Google entwickelt. Damit Ihr Online-Shop sein volles Ranking-Potenzial erreichen kann, muss er sowohl für mobile als auch für Desktop-Geräte schnell geladen werden. In wettbewerbsorientierten Keyword-Schlachten zwischen konkurrierenden Online-Shops übertrifft die Website, die den Geschwindigkeitsvorteil hat, normalerweise ihre langsameren Konkurrenten.

Um zu testen, wie gut Ihre Website in der Geschwindigkeitsabteilung abschneidet, gehen Sie zu Google PageSpeed Insights . Kopieren Sie die URL der Seite, die Sie testen möchten, fügen Sie sie ein und drücken Sie die Eingabetaste.

Google bewertet die Seite auf einer Skala von 1-100. 85 und höher sind die bevorzugten Werte. In diesem Beispiel lag die getestete Website weit unter der idealen Geschwindigkeit auf dem Desktop und auf Mobilgeräten. Glücklicherweise bietet Google technische Ratschläge zur Behebung der Ladezeitprobleme. Seitenkomprimierung, besseres Caching, Minimierung von CSS-Dateien und andere Techniken können die Leistung erheblich verbessern. Ihr Webentwickler und -designer kann Ihnen bei diesen Verbesserungen helfen.

Sichere URLs

Vor ein paar Jahren hat Google angekündigt, sichere URLs zu einem Rankingfaktor zu machen. Dies zwang viele E-Commerce-Websites, das Protokoll zu übernehmen, um organische Traffic-Gewinne zu erzielen. Während wir beobachtet haben, dass die SEO-Vorteile marginal sind, sind die wahren Gewinner die Endbenutzer, die sicherere Einkaufserlebnisse genießen, bei denen die Datensicherheit schwerer zu kompromittieren ist.

Sie können überprüfen, ob Ihr Online-Shop sichere URLs verwendet, indem Sie in der Adressleiste Ihres Webbrowsers nach dem Vorhängeschloss-Symbol suchen. Wenn es nicht vorhanden ist, sollten Sie erwägen, es von Ihrem Entwickler implementieren zu lassen. Bisher haben die meisten E-Commerce-Websites nur sichere URLs auf ihren Checkout-Seiten. Immer mehr Online-Shop-Besitzer stellen jedoch auf das SSL-Protokoll um.

Das Implementieren sicherer URLs auf einer E-Commerce-Website kann eine entmutigende Aufgabe sein. Suchmaschinen sehen HTTP- und HTTPS-Gegenseiten als zwei verschiedene Webadressen. Daher müssten Sie jede Seite Ihrer Website in HTTPS neu erstellen und alle alten HTTP-Entsprechungen per 301-Weiterleitung umleiten, damit die Dinge funktionieren. Unnötig zu erwähnen, dass dies eine wichtige Entscheidung ist, bei der SEO nur einer von mehreren zu berücksichtigenden Faktoren ist.

OnPage-SEO

On-Page-SEO bezieht sich auf den Prozess der Optimierung einzelner Seiten für eine bessere Sichtbarkeit in der Suche. Dies beinhaltet hauptsächlich die Verbesserung der Inhaltsqualität und die Sicherstellung, dass Schlüsselwörter in Elementen jeder Seite vorhanden sind, wo sie zählen.

On-Page-SEO kann eine große Aufgabe für große E-Commerce-Websites sein, aber es muss irgendwann erledigt werden. Hier sind die Elemente jeder Seite, die Sie optimieren sollten:

Kanonische URL-Slugs

Eines der Dinge, auf die Suchmaschinen achten, wenn sie die Relevanz einer Seite für Keywords messen, ist ihr URL-Slug. Suchmaschinen bevorzugen URLs, die echte Wörter enthalten, gegenüber nicht entzifferbaren Zeichen. Zum Beispiel könnte eine URL wie [www.clothes.com/112-656-11455] technisch funktionieren, aber Suchmaschinen würden eine bessere Vorstellung davon bekommen, worum es geht, wenn sie eher wie [www.yourshop.com/pants] aussehen würde. URLs, die statt alphanumerischer Kombinationen echte Wörter verwenden, werden als „kanonische URLs“ bezeichnet. Diese sind nicht mit den bereits erwähnten rel=canonical-Links zu verwechseln, die nichts mit URL-Slugs zu tun haben.

Die meisten Online-Shopping-Plattformen verwenden bereits kanonische URLs. Einige jedoch möglicherweise nicht, und darauf müssen Sie achten. Ihr Webentwickler kann Ihnen beim Einrichten von kanonischen URL-Slugs helfen, wenn Ihr CMS diese nicht standardmäßig verwendet.

SEO-Leitfaden – Meta-Richtlinien

Abgesehen von der robots.txt-Datei gibt es eine weitere Möglichkeit, die Indizierung auf Ihren Seiten einzuschränken. Dies geschieht durch die Verwendung sogenannter Meta-Direktiven-Tags. Einfach ausgedrückt sind dies HTML-Anweisungen im <head>-Teil des Quellcodes jeder Seite, die Bots mitteilen, was sie mit einer Seite tun können und was nicht. Die häufigsten sind:

- Noindex – Dieses Tag weist Suchmaschinen an, eine Seite nicht zu indizieren. Ähnlich wie bei einem robots.txt-Disallow wird eine Seite mit diesem Tag nicht in den SERPs gelistet. Der Unterschied besteht jedoch darin, dass ein verantwortungsbewusster Bot eine durch robots.txt eingeschränkte Seite nicht crawlt, während eine Seite mit noindex dennoch gecrawlt wird – sie wird einfach nicht indexiert. In dieser Hinsicht können Suchspinnen immer noch die Links einer nicht indexierten Seite passieren und Link-Equity kann immer noch durch diese Links fließen.

Das noindex-Tag wird am besten zum Ausschließen von Blog-Tag-Seiten, nicht optimierten Kategorieseiten und Checkout-Seiten verwendet.

- Noarchive – Dieses Meta-Tag ermöglicht es Bots, Ihre Seite zu indizieren, aber keine zwischengespeicherte Version davon in ihrem Speicher zu behalten.

- Noodp – Dieses Tag weist Bots an, eine Website nicht im Open Directory Project (DMOZ) aufzulisten.

- Nofollow – Dieses Tag teilt Suchmaschinen mit, dass die Seite möglicherweise indiziert ist, den darin enthaltenen Links jedoch nicht gefolgt werden soll.

Wie bereits erwähnt, ist es am besten, mit Bedacht zu entscheiden, welche Seiten Google indexieren darf. Hier sind ein paar schnelle Tipps zur Handhabung der Indizierung für gängige Seitentypen:

- Homepage – Indizierung zulassen.

- Produktkategorieseiten – Indizierung zulassen. Fügen Sie diesen Seiten so viel Breite wie möglich hinzu, indem Sie die Kopie der Seite verbessern. Mehr dazu im Abschnitt „Einzigartige Kategorie- und Produktkopie“.

- Produktseiten – Erlauben Sie die Indizierung nur, wenn für Ihre Seiten ein eindeutiger Text geschrieben wurde. Wenn Sie die Produktbeschreibungen aus einem Katalog oder einer Herstellerseite entnommen haben, verbieten Sie die Indexierung mit dem Meta-Tag „noindex,follow“.

- Blog-Artikelseiten – Wenn Ihr Online-Shop einen Blog hat, erlauben Sie auf jeden Fall Suchmaschinen, Ihre Artikel zu indizieren.

- Blog-Kategorieseiten – Erlauben Sie die Indizierung nur, wenn Sie einzigartigen Inhalt hinzugefügt haben. Verwenden Sie andernfalls das „noindex,follow“-Tag.

- Blog-Tag-Seiten – Verwenden Sie das „noindex,follow“-Tag.

- Blog-Autorenarchiv – Verwenden Sie das Tag „noindex,follow“.

- Blog-Datumsarchiv – Verwenden Sie das Tag „noindex,follow“.

Beliebte E-Commerce-Plattformen wie Shopify, Magento und WordPress verfügen alle über integrierte Funktionen oder Plugins, mit denen Webadministratoren Meta-Anweisungen auf einer Seite einfach verwalten können.

In Fällen, in denen Sie sich fragen, warum eine bestimmte Seite nicht indexiert wird oder warum eine vermeintlich eingeschränkte Seite in den SERPs erscheint, können Sie deren Quellcodes manuell überprüfen. Alternativ können Sie die Liste der Meta-Anweisungen Ihrer gesamten Website prüfen, indem Sie einen Screaming-Frog-Crawl ausführen.

Überprüfen Sie nach dem Ausführen eines Crawls einfach die Spalte Meta Robots. Sie sollten sehen können, welche Meta-Direktiven-Tags jede Seite Ihrer Website hat. Wie bei jedem Screaming Frog-Bericht können Sie diesen zur einfacheren Datenverwaltung in eine Excel-Tabelle exportieren.

Titel-Tags

Der Titel-Tag bleibt für die meisten Suchmaschinen der wichtigste Onpage-Ranking-Faktor. Dies ist der Text, der das Suchergebnis überschreibt, und seine Hauptfunktion besteht darin, menschlichen Suchenden und Bots in 60 Zeichen oder weniger mitzuteilen, worum es auf einer Seite geht.

Aufgrund der Kürze und Bedeutung, die Titel-Tags von Natur aus haben, ist es für jede E-Commerce-SEO-Kampagne entscheidend, diese richtig zu machen. Gut geschriebene Title-Tags müssen die folgenden Qualitäten aufweisen, um die Ranking-Fähigkeit einer Seite zu maximieren:

- 60 Zeichen oder weniger einschließlich Leerzeichen

- Geben Sie einfach an, worum es auf der Seite geht

- Das primäre Keyword der Seite muss frühzeitig erwähnt werden

- Muss auf die Kaufabsicht eingehen, indem Kaufaktionswörter erwähnt werden

- Erwähnen Sie optional die Marke der Website

- Verwendet Trennzeichen wie „-“ und „|“ um den Kern des Titeltags und den Markennamen abzugrenzen.

Hier ist ein Beispiel für ein gutes Titel-Tag:

Denim-Jeans online kaufen | Herrenbekleidung.com

Wir sehen, dass das Kaufwort „Kaufen“ vorhanden ist, aber der Produkttyp „Denim Jeans“ noch früh erwähnt wird. Das Wort „Online“ wird auch erwähnt, um anzuzeigen, dass der Kauf über das Internet getätigt werden kann und die Seite dem Suchenden nicht nur sagt, wo er oder sie physisch einkaufen kann. Die Marke des Online-Shops wird ebenfalls erwähnt, aber der gesamte Textblock liegt immer noch innerhalb der empfohlenen Länge von 60 Zeichen.

SEO-Leitfaden – Meta-Beschreibungen

Meta-Beschreibungen sind die Textblöcke, die Sie unter den Titel-Tags in den Suchergebnissen sehen können. Im Gegensatz zu Titel-Tags sind dies keine direkten Ranking-Faktoren. Tatsächlich können Sie davonkommen, sie nicht zu schreiben, und Google würde nur den Text aus dem Inhalt der Seite auswählen, den es für eine Suchanfrage als am relevantesten erachtet.

Das bedeutet jedoch nicht, dass Sie sich nicht um Meta-Beschreibungen kümmern sollten. Wenn sie gut formuliert und überzeugend geschrieben sind, können diese bestimmen, ob ein Benutzer auf Ihren Eintrag klickt oder auf die Seite eines Konkurrenten geht. Die Meta-Beschreibung ist vielleicht kein Ranking-Faktor, aber die Klickrate (CTR) einer Seite ist es sicherlich. CTR ist ein wichtiges Engagement-Signal, das Google verwendet, um zu sehen, welche Suchergebnisse die Absicht ihrer Nutzer am besten erfüllen.

Gute Meta-Beschreibungen haben folgende Eigenschaften:

- ca. 160 Zeichen lang (inkl. Leerzeichen)

- Bietet Benutzern eine Vorstellung davon, was sie von der Seite erwarten können

- Erwähnt das Hauptkeyword der Seite mindestens einmal

- Macht ein kurzes, aber überzeugendes Argument dafür, warum der Benutzer auf den Eintrag klicken sollte

Hier ist ein nettes Beispiel aus einem Online-Shop, der bei Google auf Platz 1 für das Keyword „billige Druckertinten“ rangiert.

Notice how the meta description makes it clear from the start that they sell the products mentioned in the query with the phrase “Shop for ink cartridges, printer cartridges and toner cartridges.” This part also mentions the main keywords that the site targets. Meanwhile, the phrase “Find cheap printer ink for all brands at Carrotink.com. Free Shipping!” conveys additional details such as the brands covered and the value-add offer that promises free shipping. In much less than 160 characters, the listing tells shoppers looking for affordable inks that CarrotInk.com is a good destination for them.

SEO Guide – Header Text

Header text is the general term for text on a webpage that's formatted with the H1, H2, and H3 elements. This text is used to make headline and sub-headline text stand out, giving it more visual weight to users and contextual weight to search engines.

In online stores, it's important to format main page headlines with the H1 tag. Typically, the product or category name is automatically made the main header text like we see in the example blow. Sub-headings that indicate the page's various sections can then be marked up as H2, H3 and so on.

If your online store publishes articles and blog posts, remember to format main headlines in H1 and sub-headings in H2 and H3 as well. Effective header text is brief, direct and indicative of the context that the text under it conveys. It preferably mentions the main keyword in the text it headlines at least once.

If you want to check whether all your pages have proper header text, you can do an audit with Screaming Frog. Simply run a crawl and filter the results to just HTML using the Filter drop-down on the top left section of the app window. You can find column headings that say “H1-1”and “H2-1” when you scroll right. The text there are the headings in the page.

You can export these to Excel for easy data management and reference when applying changes.

SEO Guide – Image Alt Text

Google and other search engines have gotten dramatically smarter these past two decades. They're now so much better at understanding language, reading code and interpreting user behavior as engagement signals. What they haven't refined to a science just yet is their ability to understand what a picture shows and what it means in relation to a page's content.

Since bots read code and don't necessarily “see” pages the way human eyes do, it's our responsibility to help them understand visual content. With images, the most powerful relevance signal is the alt text (shorthand for alternate text). This is a string of text included in the image's code that provides a short description of what's being shown.

Adding accurate, descriptive and keyword-laced anchor text is very important to online stores since online shoppers tend to buy from sites with richer visual content. Adding alt text helps enhance your pages' relevance to their target keywords and it gets you incremental traffic from Google Image Search.

To check if your site uses proper image alt text, we can use trusty Screaming Frog once more. Do a crawl of your site from the home page and wait for the session to finish. Go to the main menu and click Bulk Export>Images>All Alt Tex t. Name the file and save it. Open the file in Excel and you should see something like this:

Column B (Source) tells us which page the image was found on. Column C (Destination) tells us the web address of the image file. Column D (Anchor) is where we'll find the anchor text if something has already been written. If you see a blank cell, it means no anchor text is in place and you'll need to write it at some point.

Good image alt texts have the following qualities:

- About 50 characters long at most

- Describes what's depicted in the image directly in one phrase

- Mentions the image's main keyword at least once

Different CMS platforms have different means of editing image alt texts. In a lot of cases, a spreadsheet being fed into the CMS for bulk uploads can contain image alt text information.

SEO Guide – Unique Category and Product Copy

SEO has everything to do with the age-old Internet adage “content is king” and that applies even to ecommerce websites. Analyses have continually shown that Google tends to favor pages and sites with more breadth and depth in their content. While most online store owners would cringe at the idea of turning their site into “some kind of library,” smarter online retailers know that content can co-exist with their desired web design schemes to produce positive results.

One of the fundamental flaws that a lot of ecommerce sites face from an on-page SEO perspective is the proliferation of thin content on unoptimized category pages and product pages with boilerplate content. Regular category pages have little text and no fundamental reason for existence other than to link to subcategory pages or product pages. Product pages with boilerplate content, on the other hand, don't deliver unique value to searchers. If your online store is guilty of both shortcomings, search engines won't look at it with much favor, allowing other pages with better content to outrank yours.

Category pages are of particularly high importance due to the fact that they usually represent non-branded, short and medium-length keywords. These keywords represent query intents that correspond with the top and middle parts of sales funnels. In short, these pages are the ones that users look for when they're in the early stages of forming their buying decisions.

Category pages can be optimized for SEO by adding one or both of the following:

- A short text blurb that states what the category is about and issues a call to action. This is usually a 2-3 sentence paragraph situated between the H1 text and the selection of subcategory product links.

- Longer copy that further discusses the category and the items listed under it. This can be one or more paragraphs and is positioned near the bottom of the page's body, under the list of subcategories or products in the page. This text isn't meant for human readers as much as it is for bots to consume and understand text.

For both text block types, the goal is to increase the amount of text and provide greater relevance between the page and its target keyword. The text blocks also provide opportunities for internal linking as the text can be used as anchors for links to other pages.

Produktseiten hingegen stellen Abfrageabsichten dar, die sich am unteren Rand des Verkaufstrichters befinden. Produktseiten entsprechen den Absichten von Benutzern, die bereits eine gute Vorstellung davon haben, was sie kaufen möchten, und nur nach dem besten Anbieter suchen, um es ihnen zu verkaufen. Die Keywords, die Produktseiten darstellen, haben in der Regel ein geringeres Suchvolumen, aber eine höhere Konversionsrate.

Das Optimieren des Textes auf Produktseiten ist normalerweise nicht allzu schwierig, da es arbeitsintensiv ist. Das Recherchieren von Hunderten oder sogar Tausenden von Produktdetails und das anschließende Umschreiben auf Einzigartigkeit kann eine Menge Arbeitsstunden in Anspruch nehmen. In der Regel tun SEO-versierte Online-Shop-Besitzer dies selektiv nur für ihre vorrangigen Produktlinien. Produktseiten, die nicht mit einzigartigen Inhalten gefüllt sind, werden normalerweise mit dem noindex-Tag eingeschränkt, um den Linkwert und das Crawl-Budget auf Seiten zu konzentrieren, die mit einzigartigen Kopien optimiert wurden.

Wenn Sie einzigartige Texte für Produktseiten schreiben, konzentrieren Sie sich darauf, Folgendes auf Ihre eigene Weise zu schreiben:

- Die Nutzenerklärung – Der Teil der Kopie, der 3 oder 4 Aufzählungspunkte auflistet, die angeben, wie das Produkt ein Problem löst oder das Leben für den Zielkunden verbessert.

- Anwendungsfälle – Ein Abschnitt in der Kopie, in dem Sie mögliche Verwendungen und Anwendungen des Produkts erwähnen.

- How-to-Abschnitt – Ein Teil der Kopie, in dem Sie Anweisungen geben, wie das Produkt verwendet oder installiert werden kann.

- Kundenrezensionen – Der Teil des Textes, in dem Sie Käufern erlauben, Feedback zu einem Produkt zu schreiben. Stellen Sie einfach sicher, dass nur verifizierte Kunden posten dürfen. Es kann auch hilfreich sein, den Inhalt im Hinblick auf Qualität und Lesbarkeit zu moderieren.

Wenn Sie ein gutes Beispiel für eine reichhaltige, einzigartige und nützliche Kopie einer Produktseite sehen möchten, finden Sie hier eine .

Kategorie- und Produktseiteninhalte können auch dazu beitragen, dass Ihre Seiten bei Google die Position Null erreichen. Dies ist das Sofortantwortfeld, das in einigen Abfragen über allem anderen angezeigt wird. Wenn der von Ihnen geschriebene Inhalt eine Frage klar und direkt beantwortet, die richtigen Header-Tags verwendet und die richtigen HTML-Tags für Aufzählungs- und Nummerierungslisten verwendet, werden Sie möglicherweise feststellen, dass Ihr Inhalt in den SERPs prominent hervorgehoben wird.

Seitennummerierung

Produktkategorieseiten enthalten manchmal so viele Artikel, dass es schrecklich aussehen würde, sie alle auf einer Seite anzuzeigen. Um dieses Designproblem zu lösen, verwenden Webdesigner paginierte Inhalte. Dies ist eine Methode, die es einer Kategorieseite ermöglicht, einen Teil der Einträge darunter anzuzeigen, während der Rest verborgen bleibt. Wenn ein Benutzer den Rest sehen möchte, kann er oder sie auf Seitenzahlen klicken, die ihn zu einer identischen Seite führen, auf der andere Elemente in der Liste angezeigt werden.

Dies funktioniert zwar hervorragend für Design und Benutzerfreundlichkeit, kann aber zu einem SEO-Problem werden, wenn Sie nicht aufpassen. Suchmaschinen sind nicht gut darin, herauszufinden, dass eine Reihe von Seiten manchmal zu einem größeren Ganzen gehören kann. Als solche neigen sie dazu, Seiten in einer paginierten Serie zu crawlen und zu indizieren und sie aufgrund der identischen Titel-Tags, Meta-Beschreibung und angezeigten Kopie der Kategorieseite als Duplikate anzusehen.

Um Suchmaschinen dabei zu helfen, eine paginierte Serie auf Ihren Kategorieseiten zu identifizieren, lassen Sie einfach Ihren Webentwickler die Elemente rel=“prev“ und rel=“next“ in paginierten Inhalten implementieren. Diese Elemente teilen Suchmaschinen mit, dass Seiten zu einer Serie gehören und nur die erste indexiert werden soll. Näheres zu diesen HTML-Elementen können Sie hier nachlesen.

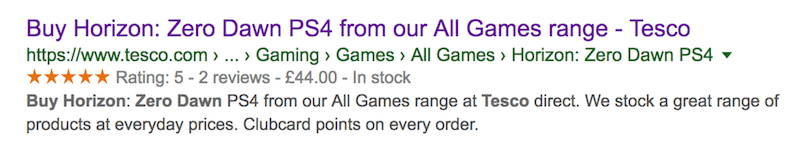

SEO GUIDE – Aggregiertes Bewertungsschema

Sie haben wahrscheinlich schon Suchergebnisse für Produkte und Dienstleistungen mit Bewertungssternen gesehen, die den Einträgen hinzugefügt wurden. Diese Sterne besetzen nicht nur Platz auf SERPs und erregen visuelle Aufmerksamkeit – sie fördern auch ein besseres Klickverhalten der Suchenden. Für Online-Shops kann es sehr praktisch sein, Bewertungssterne in den Auflistungen der Produktseiten erscheinen zu lassen. Diese Rich Snippets können der entscheidende Faktor dafür sein, ob ein Benutzer auf Ihren Eintrag oder den Ihres Konkurrenten klickt.

Glücklicherweise ist die Implementierung von Bewertungssternen relativ einfach. Alles, was Sie tun müssen, ist diese Code-Zeichenfolge zu Ihren Produktseiten hinzuzufügen, und Sie sollten fertig sein:

<script type="application/ld+json">

{ „@context“: „http://schema.org“,

„@type“: „Produkt“,

„Name“: „##PRODUKT###“,

„GesamtBewertung“:

{„@type“: „AggregateRating“,

„ratingValue“: „##RATING##“,

„reviewCount“: „##REVIEWS##“

}

}

</script>

Sie müssen den Teil ##PRODUCT### mit dem Produktnamen, den Teil ##RATING## mit den aggregierten Bewertungen des Produkts und den Teil ##REVIEWS## mit der Anzahl der Bewertungen ausfüllen. Wenn Sie sich mit dem Umgang mit Code nicht wohl fühlen, wird die Übertragung dieser Aufgabe an einen Webentwickler die Dinge in die richtige Richtung bewegen.

Das Hinzufügen dieses Markups ist natürlich keine Garantie dafür, dass Google die Bewertungssterne tatsächlich anzeigt. Der Suchgigant hat eine Reihe von Algorithmen zu befolgen. Beachten Sie Folgendes, um Ihre Chancen zu erhöhen, dass zusammengefasste Bewertungssterne angezeigt werden:

- Fügen Sie den Markup-Code nur zu bestimmten Produktseiten hinzu. Das Hinzufügen zur Startseite und den Kategorieseiten der E-Commerce-Website hat keine Auswirkungen.

- Ermutigen Sie echte Kundenbewertungen und vermeiden Sie es, Ihre eigenen Bewertungsergebnisse zu erfinden.

- Versuchen Sie, ein gesundes Gleichgewicht zwischen Bewertungen innerhalb der Website und aus externen Quellen zu fördern.

- Wenn Sie vorhaben, dass Personen Ihren Seiten auf Ihren Wunsch hin Bewertungen zuweisen, tun Sie dies nicht für jedes Produkt auf einmal. Wenn jede Seite plötzlich Bewertungen erhält, sieht das unnatürlich aus und kann von Google negativ bewertet werden.

Beachten Sie, dass einige CMS-Plattformen mit Schema-Markups besser sind als andere. WordPress hat beispielsweise Schema-Markups eingebaut, wenn Sie ein Genesis-basiertes Design ausführen.

Bonus: Linkbuilding-Strategie

Während es in diesem Beitrag um On-Site-SEO geht, ist es für E-Commerce-Site-Besitzer unvermeidlich, irgendwann über den Aufbau von Links nachzudenken, wenn sie ihre Nische auf dem Suchmarkt dominieren wollen. Income Diary hat in der Vergangenheit darüber gepostet, wie man Links richtig aufbaut, also werden wir darauf nicht näher eingehen. Wir werden jedoch besprechen, wohin diese Backlinks verweisen sollen.

Im Allgemeinen folgen Websites pyramidenförmigen Informationsarchitekturen. Stellen Sie sich die Homepage als Spitze der Pyramide vor, während ihre Hauptkategorien und Unterkategorien die nächsten Ebenen darunter bilden. An der Basis der Pyramide befinden sich die Produktseiten. Sie sind der zahlreichste Seitentyp, aber sie stehen am Ende der Hierarchie.

Stellen Sie sich nun die Pyramide als eine vor, die ein internes Wasserverteilungssystem hat. In diesem Fall ist das Wasser die Link Equity. Das meiste davon kommt vom Tipp (der Homepage), da die meisten eingehenden Links darauf verweisen. Das Eigenkapital fließt nach unten zu den Kategorieseiten, die von der Homepage verlinkt sind, steigt dann ab und verteilt sich über die Produktseiten.

Allerdings ist die Homepage die beste Seite, auf die eingehende Links verweisen, wenn Ihr Ziel darin besteht, die Ranking-Power aller Ihrer Seiten zu steigern. Dies hilft der Homepage, für die kurzen Schlüsselwörter, die sie darstellt, einen besseren Rang einzunehmen, während Kategorie- und Produktseiten inkrementelle Boosts erhalten.

Wenn Sie zufällig eine Produktlinie haben, die Sie gegenüber den anderen priorisieren, wäre es gut, Links zu den jeweiligen Kategorieseiten zu erstellen. Dies trägt nicht nur dazu bei, dass die Kategorieseite in den SERPs besser abschneidet, sondern kaskadiert auch mehr potenten Linkwert auf Ihre Produktseiten.

Letztendlich geht es bei guter SEO für Online-Shops darum, ein höheres Maß an Crawlbarkeit und Relevanz für Ihre Seiten zu fördern. Das Hinzufügen dieser Optimierungsaufgaben zu Ihrer Bucket-Liste für die Website-Wartung mag wie eine große Aufgabe aussehen, aber die Belohnungen sind die Mühe wert.

Autoren-Bio: Itamar Gero ist im Netz, seit es noch schwarz auf weiß war. Geboren und aufgewachsen in Israel, lebt er heute auf den Philippinen. Er ist der Gründer von SEOReseller.com und hat kürzlich Siteoscope.com ins Leben gerufen.

Beliebte Beiträge:

=> Ray Edwards Werbetexter | Podcast: Wie man Texte schreibt, die sich verkaufen

=> SEO-LEITFADEN: 10 Schritte zum Veröffentlichen von SEO-Blogposts, die die meisten Blogger vergessen