Vincent Terrasi: A importância da atualização de conteúdo útil

Publicados: 2022-08-26O que é a atualização do algoritmo de conteúdo útil?

Na semana passada, o Google anunciou o lançamento de uma atualização de algoritmo que busca melhorar a qualidade dos resultados de busca promovendo o Conteúdo Útil, que está sendo lançado no momento. Esta atualização se aplicará inicialmente apenas a sites em inglês e poderá desvalorizar o conteúdo de todo o site se o site tiver uma quantidade significativa de conteúdo inútil.

Assim como no EAT, a noção de “útil” não pode ser facilmente quantificada por métricas concretas; o algoritmo depende do aprendizado de máquina para identificar conteúdo inútil.

SEOs experientes especializados em EAT e atualizações de algoritmos já analisaram, em detalhes, o que se sabe e como reagir à atualização de Conteúdo Útil. Vale a pena ler as análises de Marie Haynes, Glenn Gabe e Lily Ray.

Para levar a discussão adiante, conversei com Vincent Terrasi, diretor de produtos da Oncrawl e especialista em SEO de dados com foco em aprendizado de máquina e modelos de linguagem como BERT e GPT-3.

A entrevista com Vincent Terrasi

“Podemos identificar o conteúdo puro de IA como não natural e, portanto, será penalizado. Mas por outro lado, por trás dessa noção de Conteúdo Útil, há outro assunto que pode afetar negativamente todas as novas ferramentas semânticas que são baseadas nas SERPs. O Google finalmente será capaz de detectar otimização excessiva, quero dizer, alguém que faria engenharia reversa da pegada perfeita para ranquear no Google.”

Análise de conteúdo e detecção de otimização excessiva: o que a atualização de conteúdo útil realmente mudará

Rebecca: Fico pensando em vários elementos do seu trabalho que ganharam o segundo lugar no Tech SEO Boost 2019 onde você falou sobre geração de texto para SEO, os impactos e os perigos. Também discutimos o tema, principalmente quando o Google lançou o BERT, falando sobre os próximos passos e como eles poderiam generalizar a análise de texto por meio do aprendizado de máquina. Nesse caso, é como uma classificação e depois uma análise semântica em cima disso. É isso que você está ganhando com isso também? Esta atualização surpreende você?

Vincent: Sim, foi isso que eu anunciei no SEO Boost Tech: que eles [Google] iriam atrás desse tipo de conteúdo.

Continuo dizendo aos clientes interessados em geração de texto no Oncrawl porque eles precisam ter cuidado com o conteúdo gerado.

Você precisa ter cuidado ao falar sobre conteúdo gerado por IA (inteligência artificial). Com a atualização de conteúdo útil, não estamos falando de uma ação manual, mesmo que pareça o tipo de coisa que levaria a uma ação manual. Você pode ter visto algumas das notícias recentes sobre sites gerados por IA, e eu definitivamente classificaria isso como ação manual. Isso foi há três meses: havia fortes ações manuais onde havia sites que diziam estar ganhando US$ 100.000 por mês. Todos foram desindexados. Essas são ações manuais.

Agora, há essa atualização com um modelo de aprendizado de máquina capaz de identificar se é um texto sem valor agregado. Então prefiro não falar de IA, mas de sites com ou sem conteúdo sem valor agregado.

Rebecca: Sim, há uma confirmação do Google de que não se trata de ações manuais. É interessante que, neste caso, o Google esteja dizendo claramente que é aprendizado de máquina e está funcionando o tempo todo. Assim, nos meses seguintes, um site impactado poderia ser reclassificado... ou não.

Vincent: Vou falar sobre isso na minha conferência em setembro com Christian Meline no SEO Camp Paris, porque é algo que identificamos há cinco meses. Você pode imaginar? Já havíamos identificado que havia coisas acontecendo com o Google.

No geral, são dois tópicos:

Há o tópico de conteúdo gerado por IA. Podemos dizer que o conteúdo com spam pode ser muito fácil de identificar porque a IA se repete. Se você dividir em grupos de palavras de três, quatro, cinco palavras, verá que repete as mesmas frases. Isso é muito fácil de detectar. Você não precisa fazer aprendizado de máquina.

E, por outro lado, a parte do aprendizado de máquina é que, de fato, existem probabilidades muito estáveis de a próxima palavra aparecer.

Rebecca: Sim, também conversamos sobre isso quando estávamos trabalhando em seus cursos de treinamento. Internamente no Oncrawl, isso levou ao trabalho atualmente em andamento para criar um sistema de pontuação para a qualidade dos textos gerados, a fim de encontrar conteúdo que seja facilmente identificável como tal.

Vicente: Isso mesmo.

Podemos identificar o conteúdo puro de IA como não natural e, portanto, será penalizado. Então essa é a primeira questão.

Mas por outro lado, por trás dessa noção de Conteúdo Útil, há outro assunto que pode afetar negativamente todas as novas ferramentas semânticas que são baseadas nas SERPs.

O Google finalmente será capaz de detectar otimização excessiva, quero dizer, alguém que faria engenharia reversa da pegada perfeita para ranquear no Google. E aqui temos jogadores fortes e talentosos na França que ainda não reagiram muito às notícias: os Freres Peyronnet, 1.fr, SEO Quantum, etc. Eles estão diretamente preocupados com o problema da otimização excessiva. Eles são diretamente afetados por esta atualização.

Rebecca: Vamos pegar seu site transfer-learning.ai, que era mais um sandbox para testar se poderíamos classificar com conteúdo totalmente gerado, enquanto adicionamos algo que não existe hoje (neste caso, o link entre pesquisa acadêmica e cursos de treinamento sobre tópicos de aprendizado de máquina relacionados). Na sua opinião, ainda é possível fazer esse tipo de coisa?

Vincent: Se trouxer originalidade e não for detectado como spam, sim, sempre será possível fazer esse tipo de coisa.

No entanto, se não for considerado útil, não será possível.

Além disso, quero deixar um lembrete claro aos criadores franceses: estamos falando de inglês. Sabemos que o lançamento em inglês pode durar meses e, muitas vezes, um ano. Quando olhamos para as antigas atualizações maciças do núcleo, como Panda ou Penguin, elas duraram vários anos em alguns casos. Acho que algumas pessoas vão aproveitar esse período de tempo para continuar praticando técnicas de spam. E então o Google vai intervir.

O que vou discutir durante minha apresentação com Christian Meline é que ao invés de propor assuntos que o Google já tem e que não tem interesse, podemos usar novas tecnologias que nos ajudam a propor novos assuntos.

Vou te dar um exemplo. Se eu testar todas as ferramentas de SEO e gerar ideias de tópicos com GPT-3, ou em uma ferramenta francesa como yourtext.guru, por exemplo, obterei 40 ideias. Se eu usar a técnica de Christian Meline, vou conseguir 4.500. E alguns deles são até tópicos que nunca foram usados antes e nem estão no Google.

O que você acha que o Google vai preferir? Ter conteúdo que já conhece, ou ter temas muito interessantes que ninguém nunca aprofundou?

Acho que esse é o futuro do SEO: ser capaz de detectar coisas novas. Eu sei que Koray também está indo nessa direção semântica.

Rebecca: Sim, no sentido de analisar lacunas ou lacunas de conteúdo onde você pode estabelecer uma expertise, porque são aquelas áreas semânticas de um tópico que não estão sendo abordadas.

Vicente: Exatamente. Por outro lado, acho que esta atualização não fará isso imediatamente. Haverá uma versão 1, uma versão 2 e assim por diante. Mas o objetivo final desta atualização é fazer isso.

[Estudo de caso] Gerenciando o rastreamento de bot do Google

Outros idiomas e outras mídias: como essa atualização será implantada?

Rebecca: Você mencionou anteriormente a diferença entre o inglês e outras línguas como o francês. Fizemos grandes avanços na tradução, no processamento agnóstico de linguagem, como no MuM. Você acha que realmente vai levar tanto tempo para essa atualização passar para outros idiomas?

Vincent: Francamente, eu fiz algum trabalho meu. Não tenho a tecnologia do Google, não conheço o Google, mas nunca vi um algoritmo que demore tanto para rodar. Isso significa que para um parágrafo de 300 palavras, leva cerca de dez segundos. É uma eternidade. Normalmente estamos falando de cálculos TF-IDF, incorporação de palavras... e leva um segundo. Em outras palavras, esse tipo de algoritmo é bastante pesado para implantar. Agora eu sei que o Google tem a tecnologia, eles têm TPUs, eles têm engenheiros super inteligentes, mas eu acho que eles vão ter esse limite ao usar um modelo de linguagem: você tem que carregar o modelo de linguagem. E quando há 200 bilhões de parâmetros, pode doer.

É engraçado, é na mesma época do lançamento do modelo de geração de texto no HuggingFace. Então eu acho, e não há ninguém que possa dizer isso com certeza, mas é nisso que eles basearam sua detecção. Na verdade, eles lançaram um modelo de geração de texto para detectar a geração de texto. O Google está combatendo fogo com fogo, como dizem.

Rebecca: Sim, é mais ou menos assim que funciona, certo? Sempre foi assim na detecção de textos automatizados. Usamos o que sabemos sobre como ele é construído para detectá-lo.

Vincent: Mas o que me impressiona são as ferramentas de SEO que fornecem uma impressão digital dos SERPs. O Google agora está dizendo: “Temos a pegada e poderemos dizer se você está muito inspirado por ela”. Ninguém sabe como eles fazem isso. Eu sei como outras ferramentas de SEO fazem isso, mas como eles [Google] fazem isso? Ninguém sabe.

Rebecca: Na verdade, a outra coisa que se destacou para mim foi que é uma análise no nível do site e, para cada site, há, se realmente estamos falando de generalização de alto nível, um "valor" de Conteúdo útil ou inútil atribuído para o site que pode afetar outros conteúdos nesse site. E isso é muita análise individual e muito armazenamento de informações. Então, mesmo para processar ou reprocessar isso, leva muito tempo.

Vincent: Acho que essa é a restrição que eles têm. Eles anunciaram que estão fazendo isso apenas na Pesquisa do Google, não no Google Discover.

É um pouco paradoxal porque no Google Discover, todo mundo está trapaceando, todo mundo está otimizando o conteúdo “SEO” apenas para estar no Google Discover. Acho que eles têm um grande problema agora com a Pesquisa do Google e todo esse conteúdo gerado automaticamente. Existem alguns sites que exageraram no conteúdo gerado automaticamente.

Eles não estão falando sobre uma penalidade, então eles estão meio que girando isso como com o Google RankBrain, como um novo sinal.

E nem todos os sites serão afetados. Estou pensando em particular em sites de comércio eletrônico com todas as descrições de seus produtos. Sabemos que todos estão copiando uns aos outros.

Rebecca: Sim, criando variantes com base nas descrições oficiais dos produtores, das marcas.

Vicente: Sim.

Mas alguns sites de mídia estão mais em risco. Existe um fenômeno que é conhecido em SEO há muito tempo. Por exemplo, alguns sites pegam conteúdo em inglês e o traduzem sem agregar nenhum valor. Ninguém falou sobre isso, mas há um grande risco para esse tipo de site porque não acrescenta nada e ainda por cima, e eles têm o defeito de não citar suas fontes.

Rebecca: E eles também terão o conteúdo original em inglês para fazer uma comparação.

Vincent: Sim, o estágio em que passamos do inglês para o francês com esta atualização provavelmente prejudicará muitos dos sites com spam.

De todas as notícias de SEO dos últimos meses, esta é a atualização mais importante. RankBrain também, poderíamos dizer, mas tem sido muito menos óbvio apontar, difícil ver quais são os resultados reais de sua aplicação.

Rebecca: Eu acho que é bem próximo, com o conceito de análise semântica e as partes do site que não estão relacionadas com o resto do site.

Vicente: Exatamente.

Eu sei que eles estão trabalhando nisso há um tempo. Eu tinha um amigo que trabalha no Google, que disse estar trabalhando nisso desde 2009; havia duas equipes de pesquisa sobre isso. Eles estão tentando fazer isso agora em tempo real e vão fazer muita limpeza.

Mas ainda não sabemos muito sobre a implementação. Como eles vão fazer isso? Com um sinal? Aqueles que trapaceiam serão menos bem indexados? Ninguém pode responder a essa pergunta, exceto John Mueller.

Rebecca: Duvido até que ele tenha permissão. Imagino que eles manterão sua linha de: “crie conteúdo útil para usuários, não para mecanismos de busca, e você não terá problemas”.

Vincent: No Twitter, ele está sendo bombardeado com perguntas sobre esse tópico e suas respostas têm sido um pouco amplas.

Fonte: Twitter

O impacto na criação de conteúdo no futuro

Rebecca: Não estou surpresa com isso. Acho que ele provavelmente não tem nenhuma informação mais específica. E mesmo que o faça, deve ser absolutamente proibido falar sobre o algoritmo.

Enfim, estou muito ansioso para começar a ver as patentes que estão relacionadas a essa atualização, fazer uma reanálise das patentes daqui a um ano, dois anos, para ver o que está por aí e se há alguma indicação de uso um pouco mais tarde. Mas isso é outro assunto.

Vincent: Para me preparar para minha conferência em setembro, listei como reconhecemos conteúdo de qualidade e conteúdo útil. Baseei-me no artigo do jornaldunet (em francês) onde Christian Meline havia escrito sobre o assunto [três] anos atrás. Seu conteúdo ainda é completamente relevante. Por outro lado, ele não depende de aprendizado de máquina. Ele odeia isso, então essas são métricas básicas e úteis: o título está bem escrito? Há algum erro de ortografia? Fornece novos conhecimentos? Raramente coisas em que você precisará de aprendizado de máquina para fazê-las.

Rebecca: Esse tipo de conselho será super importante porque a maioria dos SEOs não necessariamente tem os recursos, os dados, o tempo ou apenas as habilidades para implementar o aprendizado de máquina, para poder analisar seus sites, para saber se há riscos de cair nisso ou não.

Vicente: Exatamente. Temos que acompanhar isso muito, muito de perto.

Além disso, temos que ter muito cuidado com o que dizemos. Temos que falar no tempo condicional. Não há ninguém que tenha certeza sobre este assunto.

Rebeca: Com certeza. Só temos coisas de nível muito alto, o que significa que não temos provas, nem pistas e nem informações. Então, claramente, tudo o que podemos dizer sobre isso não são conclusões, são teorias.

Vicente: Exatamente.

Aqui está o que eu configurei como ponto de partida:

- A análise de tokens para observar a repetição: identifique quando é excessivo, quando é apenas para classificar.

- Então, as probabilidades entre as palavras que mencionei anteriormente.

- E finalmente um, grupos de palavras.

Apenas com esses três combos, posso detectar 90% dos textos gerados por IA que não foram otimizados por um humano. Então imagine o que o Google pode fazer! É alucinante.

Rebecca: Então, definitivamente devemos participar de sua conferência SEO Campus em 23 de setembro com Christian.

Vincent: Sim, queríamos desmembrar um pouco o tópico de conteúdo útil. É engraçado: antes mesmo do Google começar a falar sobre a atualização, já tínhamos isso planejado.

Eu também gosto deste tópico porque eu sou muito ecológico. Faz-me sentir melhor saber que existem controles como esse para impedir que as pessoas enviem spam. Porque nos custa recursos inimagináveis.

Rebeca: Sim, tem. Com esta atualização, todos estão prestando muita atenção. Acho que as pessoas que pensam que não vai mudar nada estão erradas. Podemos ver que isso vai mudar não apenas como criamos conteúdo, mas também como o Google avalia o conteúdo. E estas são estratégias que não vimos antes.

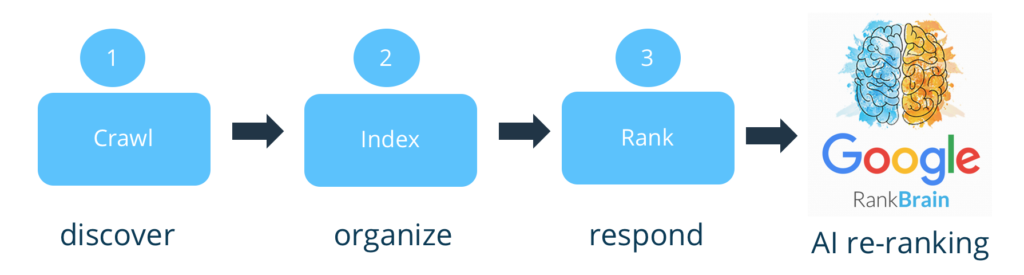

Vicente: Exatamente. Na verdade, se você quer adotar uma postura extrema, o Google não avalia conteúdo. Isso é uma grande fraqueza. Ele costumava apenas indexar e classificar. Agora eles vão filtrar a montante. E é isso que o Bing estava criticando o Google por não fazer.

Rebecca: Sim, a maior parte da análise [de conteúdo] veio na hora do ranking.

Vicente: Isso mesmo. Agora parece ter um pequeno filtro. Concordo com você: mal posso esperar para ver a patente que sairá sobre isso. Eles terão que revelar onde colocaram o filtro. Onde você aposta que eles colocam o filtro? Antes, depois da indexação ou antes, depois da classificação? Onde você colocaria?

Rebecca: Já que você precisa ter a maior parte do site para poder fazer isso, eu diria…

Vincent: Não esqueça que você precisa da pegada dos SERPs, como discutimos, para indexação. Então você tem que indexá-los.

Rebecca: Sim, isso é o que eu ia dizer. Acho que deveria ser um passo a mais, não corremos o risco de desindexar, então estamos falando de um impacto após a indexação, talvez depois da classificação [inicial] também.

Vincent: Sim, para mim, é depois do ranking. Se eu fosse o Google, isso é algo que eu teria adicionado ao Google RankBrain, porque ele é capaz de agregar sinais, etc. Agora, a questão é quão impactante será nos sites.

Rebecca: Com o aprendizado de máquina, pode variar muito de site para site, porque você pode ter muito mais controle sobre seu impacto e a quantidade de conteúdo inútil em cada site.

Vincent: O limite com o Google são falsos positivos. Isso seria desindexar [ou penalizar] páginas legítimas. Então, acho que o impacto inicial será muito, muito baixo, mas eles realmente vão atrás dos trapaceiros.

Eu tive pessoas que entraram em contato comigo, porém, que estavam um pouco preocupadas. Eu disse a eles que, no início, ele detectaria apenas texto sem qualidade. Ou seja, acho que um texto [gerado], seguido de revisão humana, pode ter toda a sua utilidade.

Não sou tão rigoroso quanto outros que dizem “AI = lixo”. Eu também não acredito muito nisso.

Rebecca: Isso não me surpreende, vindo de você!

É um pouco frustrante, sabendo que vai ser lento. Como você disse, para evitar falsos positivos, esse é outro motivo para lançar em inglês: eles têm um domínio melhor do inglês. Isso torna possível colocar controles adicionais que são muito mais caros, antes de generalizar para toda a web e para outras linguagens menos dominadas, menos automatizadas.

De qualquer forma, foi uma discussão muito rica. Muito obrigado por esta troca.

Vincent: Podemos falar sobre isso novamente quando você quiser.

Rebecca: Foi um prazer.