فنسنت تيراسي: أهمية تحديث المحتوى المفيد

نشرت: 2022-08-26ما المقصود بتحديث خوارزمية المحتوى المفيد؟

أعلنت Google الأسبوع الماضي عن إصدار تحديث خوارزمية يسعى إلى تحسين جودة نتائج البحث من خلال الترويج للمحتوى المفيد ، والذي يتم إصداره حاليًا. سيتم تطبيق هذا التحديث مبدئيًا على مواقع الويب باللغة الإنجليزية فقط ، وقد يقلل من قيمة محتوى الموقع بأكمله إذا كان الموقع يحتوي على قدر كبير من المحتوى غير المفيد.

كما هو الحال مع EAT ، لا يمكن قياس فكرة "المساعدة" بسهولة عن طريق مقاييس محددة ؛ تعتمد الخوارزمية على التعلم الآلي لتحديد المحتوى غير المفيد.

لقد قام مُحسِّنو خدمة تحسين محركات البحث (SEO) المتمرسين والمتخصصين في EAT وتحديثات الخوارزميات بالفعل بتحليل ، بالتفصيل ، ما هو معروف عنه وكيفية الرد على تحديث المحتوى المفيد. تستحق التحليلات التي أجرتها ماري هاينز وجلين غابي وليلي راي القراءة.

لمزيد من المناقشة ، تحدثت مع Vincent Terrasi ، مدير المنتج في Oncrawl وخبير في تحسين محركات البحث (Data SEO) مع التركيز على التعلم الآلي ونماذج اللغة مثل BERT و GPT-3.

المقابلة مع فينسينت تيراسي

"يمكننا تحديد محتوى الذكاء الاصطناعي الخالص على أنه غير طبيعي ، وبالتالي سيتم معاقبته. ولكن من ناحية أخرى ، خلف فكرة المحتوى المفيد ، هناك موضوع آخر يمكن أن يؤثر سلبًا على جميع الأدوات الدلالية الجديدة التي تستند إلى SERPs. ستتمكن Google أخيرًا من اكتشاف التحسين المفرط ، أعني ، شخص ما سيعكس هندسة البصمة المثالية للترتيب في Google ".

تحليل المحتوى والكشف عن التحسين الزائد: ما الذي سيتغيره تحديث المحتوى المفيد حقًا

ريبيكا: ما زلت أفكر في عناصر مختلفة من عملك فازت بالمركز الثاني في Tech SEO Boost 2019 حيث تحدثت عن إنشاء نص من أجل تحسين محركات البحث والتأثيرات والمخاطر. ناقشنا أيضًا الموضوع ، خاصةً عندما أصدرت Google BERT ، وتحدثنا عن الخطوات التالية وكيف سيكونون قادرين على تعميم تحليل النص من خلال التعلم الآلي. في هذه الحالة ، إنه نوع من التصنيف المشابه ثم التحليل الدلالي فوق ذلك. هل هذا إلى حد كبير ما تحصل عليه منه أيضًا؟ هل يفاجئك هذا التحديث؟

فينسينت: نعم ، هذا ما أعلنته في SEO Boost Tech: أنهم [Google] سيتبعون هذا النوع من المحتوى.

أستمر في إخبار العملاء المهتمين بتوليد النص في Oncrawl لماذا يجب عليهم توخي الحذر بشأن المحتوى الذي تم إنشاؤه.

يجب أن تكون حذرًا عند الحديث عن المحتوى الذي تم إنشاؤه بواسطة AI (الذكاء الاصطناعي). مع تحديث "المحتوى المفيد" ، لا نتحدث على الإطلاق عن إجراء يدوي ، على الرغم من أنه قد يبدو من نوع الشيء الذي قد يؤدي إلى إجراء يدوي. ربما تكون قد شاهدت بعض الأخبار الحديثة حول المواقع التي تم إنشاؤها بواسطة الذكاء الاصطناعي ، وأنا بالتأكيد سأصنف ذلك كإجراء يدوي. كان هذا قبل ثلاثة أشهر: كانت هناك إجراءات يدوية قوية حيث كانت هناك مواقع قالت إنها كانت تجني 100000 دولار شهريًا. كانوا جميعا deindexed. هذه إجراءات يدوية.

الآن ، يوجد هذا التحديث بنموذج التعلم الآلي الذي يمكنه تحديد ما إذا كان نصًا غير ذي قيمة مضافة. لذلك أفضل عدم التحدث عن الذكاء الاصطناعي ، ولكن عن المواقع ذات المحتوى غير ذي القيمة المضافة أو بدونها.

ريبيكا: نعم ، هناك تأكيد من Google بأن الأمر لا يتعلق بالإجراءات اليدوية. من المثير للاهتمام أنه في هذه الحالة ، تقول Google بوضوح إنها تعلم آلي وتعمل إلى حد كبير طوال الوقت. لذلك في الأشهر التالية ، يمكن إعادة تصنيف موقع متأثر ... أو لا.

فينسينت: سأتحدث عن هذا في مؤتمري في سبتمبر مع كريستيان ميلين في SEO Camp Paris ، لأنه شيء حددناه قبل خمسة أشهر. هل يمكنك أن تتخيل؟ لقد حددنا بالفعل أن هناك أشياء تحدث مع Google.

بشكل عام ، هناك موضوعان:

هناك موضوع المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي. يمكننا القول أنه من السهل جدًا تحديد المحتوى غير المرغوب فيه لأن الذكاء الاصطناعي يعيد نفسه. إذا قمت بتقسيمها إلى مجموعات كلمات من ثلاث أو أربع أو خمس كلمات ، فسترى أنها تكرر نفس العبارات. من السهل جدًا اكتشاف ذلك. لا تحتاج إلى تعلم الآلة.

ومن ناحية أخرى ، يتمثل جزء التعلم الآلي في وجود احتمالات مستقرة جدًا لظهور الكلمة التالية.

ريبيكا: نعم ، لقد تحدثنا أيضًا عن هذا عندما كنا نعمل في دوراتك التدريبية. داخليًا في Oncrawl ، أدى ذلك إلى العمل الجاري حاليًا لإنشاء نظام تسجيل لجودة النصوص التي تم إنشاؤها ، من أجل العثور على محتوى يسهل التعرف عليه على هذا النحو.

فنسنت: هذا صحيح.

يمكننا تحديد محتوى AI الخالص على أنه غير طبيعي ، وبالتالي سيتم معاقبته. إذن هذه هي القضية الأولى.

ولكن من ناحية أخرى ، خلف فكرة المحتوى المفيد ، هناك موضوع آخر يمكن أن يؤثر سلبًا على جميع الأدوات الدلالية الجديدة التي تستند إلى SERPs.

ستتمكن Google أخيرًا من اكتشاف التحسين المفرط ، أعني ، شخص ما سيعكس هندسة البصمة المثالية للترتيب في Google. وهنا لدينا لاعبون أقوياء وموهوبون في فرنسا لم يتفاعلوا كثيرًا مع الأخبار: فرير بيرونيت ، 1.fr ، SEO Quantum ، إلخ. إنهم قلقون بشكل مباشر من مشكلة الإفراط في التحسين. هم يتأثرون مباشرة بهذا التحديث.

ريبيكا: لنأخذ موقع Transfer-learning.ai الخاص بك والذي كان أكثر من وضع الحماية لاختبار ما إذا كان بإمكاننا الترتيب بمحتوى تم إنشاؤه بالكامل ، مع إضافة شيء غير موجود اليوم (في هذه الحالة ، الرابط بين البحث الأكاديمي والدورات التدريبية على موضوعات التعلم الآلي ذات الصلة). برأيك ، هل لا يزال من الممكن القيام بهذا النوع من الأشياء؟

فنسنت: إذا كان يجلب الأصالة ولم يتم اكتشافه على أنه بريد عشوائي ، نعم ، سيكون من الممكن دائمًا القيام بهذا النوع من الأشياء.

ومع ذلك ، إذا لم يتم اعتباره مفيدًا ، فلن يكون ذلك ممكنًا.

بالإضافة إلى ذلك ، أود أن أعطي تذكيرًا واضحًا للمبدعين الفرنسيين: نحن نتحدث عن اللغة الإنجليزية. نحن نعلم أن النشر باللغة الإنجليزية يمكن أن يستمر لأشهر ، وغالبًا لمدة عام. عندما ننظر إلى الوراء في التحديثات الأساسية الضخمة القديمة مثل Panda أو Penguin ، فقد استمرت لعدة سنوات في بعض الحالات. أعتقد أن بعض الأشخاص سيستفيدون من هذه الفترة الزمنية لمواصلة ممارسة أساليب البريد العشوائي. وبعد ذلك ستتدخل Google.

ما سأناقشه خلال عرضي التقديمي مع كريستيان ميلين هو أنه بدلاً من اقتراح الموضوعات التي تمتلكها Google بالفعل والتي لا تهتم بها ، يمكننا استخدام التقنيات الجديدة التي تساعدنا في اقتراح مواضيع جديدة.

سأعطيك مثالا. إذا اختبرت جميع أدوات تحسين محركات البحث (SEO) وأنشأت أفكارًا للموضوعات باستخدام GPT-3 ، أو في أداة فرنسية مثل yourtext.guru على سبيل المثال ، فسأحصل على 40 فكرة. إذا استخدمت تقنية كريستيان ميلين ، فسأحصل على 4500. وبعضها حتى مواضيع لم يتم استخدامها من قبل ولا توجد حتى في Google.

ماذا تعتقد أن جوجل ستفضل؟ أن يكون لديك محتوى يعرفه بالفعل ، أو أن يكون لديك موضوعات شيقة للغاية لم يجرها أحد من قبل؟

أعتقد أن هذا هو مستقبل مُحسنات محركات البحث: القدرة على اكتشاف أشياء جديدة. أعلم أن كوراي يسير أيضًا في هذا الاتجاه الدلالي.

ريبيكا: نعم ، بمعنى تحليل فجوات المحتوى أو الثغرات حيث يمكنك إنشاء خبرة ، لأنها تلك المجالات الدلالية للموضوع التي لم يتم تناولها على الإطلاق.

فنسنت: بالضبط. من ناحية أخرى ، أعتقد أن هذا التحديث لن يفعل ذلك على الفور. سيكون هناك إصدار 1 ونسخة 2 وهكذا. لكن الهدف النهائي لهذا التحديث هو القيام بذلك.

[دراسة حالة] إدارة زحف روبوت Google

اللغات والوسائط الأخرى: كيف سيتم نشر هذا التحديث؟

ريبيكا: لقد ذكرت سابقًا الفرق بين اللغة الإنجليزية ولغات أخرى مثل الفرنسية. لقد قطعنا خطوات كبيرة في الترجمة ، في المعالجة الحيادية للغة ، كما هو الحال مع MuM. هل تعتقد أن هذا التحديث سيستغرق هذا الوقت الطويل للانتقال إلى لغات أخرى؟

فينسينت: بصراحة ، لقد قمت ببعض الأعمال بنفسي. لا أمتلك تقنية Google ، ولا أعرف Google ، لكنني لم أر مطلقًا خوارزمية تستغرق وقتًا طويلاً للتشغيل. هذا يعني أن فقرة من 300 كلمة تستغرق حوالي عشر ثوان. إنه خلود. عادة نتحدث عن حسابات TF-IDF ، كلمة تزوير ... ويستغرق الأمر ثانية. بمعنى آخر ، هذا النوع من الخوارزمية ثقيل جدًا في الاستخدام. الآن أعلم أن Google لديها التكنولوجيا ، ولديهم TPU ، ولديهم مهندسون أذكياء للغاية ، لكنني أعتقد أنه سيكون لديهم هذا الحد عند استخدام نموذج اللغة: عليك تحميل نموذج اللغة. وعندما يكون هناك 200 مليار عامل ، يمكن أن يضر.

إنه أمر مضحك ، إنه في نفس وقت إصدار نموذج إنشاء النص على HuggingFace. لذلك أعتقد ، ولا يوجد أحد يمكنه أن يقول هذا بالتأكيد ، لكن هذا ما استندوا إليه في اكتشافهم. في الواقع ، أصدروا نموذج إنشاء نص لاكتشاف إنشاء النص. جوجل تكافح النار بالنار ، كما يقولون.

ريبيكا: نعم ، هذا نوع من كيف يعمل ، أليس كذلك؟ كان الأمر دائمًا على هذا النحو في اكتشاف النصوص الآلية. نستخدم ما نعرفه عن كيفية بنائه لاكتشافه.

فينسينت: ولكن ما يثير إعجابي هو أدوات تحسين محركات البحث التي توفر بصمة من SERPs. تقول Google الآن ، "لدينا البصمة وسنكون قادرين على معرفة ما إذا كنت ملهمًا جدًا منها." لا أحد يعرف كيف يفعلون ذلك. أعرف كيف تفعل ذلك أدوات تحسين محركات البحث الأخرى ، ولكن كيف يفعلون ذلك [Google]؟ لا أحد يعلم.

ريبيكا: في الواقع ، الشيء الآخر الذي كان مميزًا بالنسبة لي هو أنه تحليل على مستوى الموقع ، ثم لكل موقع ، إذا كنا نتحدث حقًا عن تعميم عالي المستوى ، تم تعيين "قيمة" للمحتوى المفيد أو غير المفيد إلى الموقع الذي يمكن أن يؤثر على المحتوى الآخر على ذلك الموقع. وهذا كثير من التحليلات الفردية ، والكثير من تخزين المعلومات. لذا ، حتى لمجرد معالجة ذلك أو إعادة معالجته ، فإن الأمر يستغرق الكثير من الوقت.

فينسينت: أعتقد أن هذا هو القيد الذي لديهم. لقد أعلنوا أنهم يفعلون ذلك فقط على بحث Google وليس Google Discover.

إنها مفارقة بعض الشيء لأنه في Google Discover ، الجميع يغشون ، والجميع يقوم بتحسين محتوى "SEO" فقط ليكون في Google Discover. أعتقد أن لديهم مشكلة كبيرة في الوقت الحالي مع بحث Google وكل هذا المحتوى الذي تم إنشاؤه تلقائيًا. هناك بعض المواقع التي تجاوزت المحتوى الذي تم إنشاؤه تلقائيًا.

إنهم لا يتحدثون عن ركلة جزاء ، لذا فهم يدورون هذا مثل Google RankBrain ، كإشارة جديدة.

ولن تتأثر جميع المواقع. أفكر بشكل خاص في مواقع التجارة الإلكترونية بكل أوصاف منتجاتها. نحن نعلم أن الجميع يقلد بعضهم البعض.

ريبيكا: نعم ، إنشاء متغيرات بناءً على الأوصاف الرسمية للمنتجين والعلامات التجارية.

فنسنت: نعم.

لكن بعض المواقع الإعلامية أكثر عرضة للخطر. هناك ظاهرة معروفة في تحسين محركات البحث لفترة طويلة. على سبيل المثال ، تأخذ بعض المواقع محتوى باللغة الإنجليزية وترجمته دون إضافة أي قيمة. لم يتحدث أحد عن ذلك ، ولكن هناك مخاطرة كبيرة لهذا النوع من المواقع لأنه لا يضيف شيئًا وفوق ذلك ، ولديهم عيب عدم الاستشهاد بمصادرهم.

ريبيكا: وسيكون لديهم أيضًا المحتوى الأصلي باللغة الإنجليزية لإجراء مقارنة معه أيضًا.

فينسينت: نعم ، المرحلة التي ننتقل فيها من الإنجليزية إلى الفرنسية بهذا التحديث ستؤذي على الأرجح العديد من المواقع غير المرغوب فيها.

من بين جميع أخبار تحسين محركات البحث على مدار الأشهر العديدة الماضية ، يعد هذا هو التحديث الأهم. يمكن أن نقول RankBrain أيضًا ، لكن الإشارة إليه كانت أقل وضوحًا ، ومن الصعب معرفة النتائج الفعلية لتطبيقه.

ريبيكا: أعتقد أنه قريب بالفعل من مفهوم التحليل الدلالي وأجزاء الموقع غير المرتبطة ببقية الموقع.

فنسنت: بالضبط.

أعلم أنهم كانوا يعملون على هذا لفترة من الوقت. كان لدي صديق يعمل في Google ، قال إنه يعمل على هذا منذ عام 2009 ؛ كان هناك فريقان بحثيان حول هذا الموضوع. إنهم يحاولون القيام بذلك الآن في الوقت الفعلي وسيقومون بالكثير من التنظيف.

لكننا ما زلنا لا نعرف الكثير عن التنفيذ. كيف سيفعلون ذلك؟ بإشارة؟ هل ستتم فهرسة أولئك الذين يغشون بشكل أقل؟ لا أحد يستطيع أن يجيب على هذا السؤال باستثناء جون مولر.

ريبيكا: أشك حتى أنه سيسمح له. أتصور أنهم سوف يلتزمون بسطرهم: "إنشاء محتوى مفيد للمستخدمين ، وليس لمحركات البحث ، ولن تواجهك مشكلة".

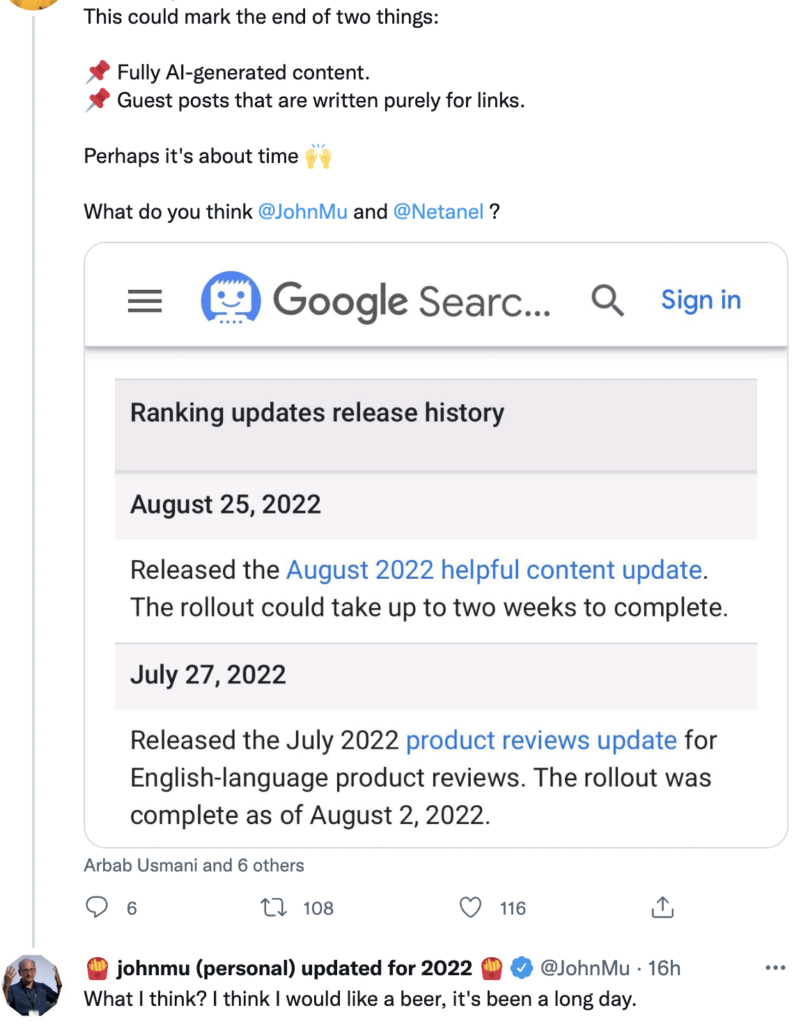

فينسينت: على تويتر ، يتعرض للقصف بالأسئلة حول هذا الموضوع وكانت إجاباته واسعة بعض الشيء.

المصدر: تويتر

التأثير على إنشاء المحتوى في المستقبل

ريبيكا: لست متفاجئًا بذلك. أعتقد أنه ربما ليس لديه المزيد من المعلومات المحددة. وحتى لو فعل ذلك ، يجب أن يكون ممنوعًا تمامًا الحديث عن الخوارزمية.

على أي حال ، أنا حريص جدًا على البدء في رؤية براءات الاختراع المتعلقة بهذا التحديث ، لإجراء إعادة تحليل لبراءات الاختراع في غضون عام أو عامين لمعرفة ما هو موجود وما إذا كان هناك أي مؤشر على الاستخدام بعد ذلك بقليل. لكن هذا موضوع آخر.

فينسينت: للتحضير لمؤتمري في سبتمبر ، قمت بإدراج كيفية التعرف على جودة المحتوى والمحتوى المفيد. استندت في ذلك إلى مقال نُشر في جريدة Journalaldunet (بالفرنسية) حيث كتب كريستيان ميلين عن هذا الموضوع قبل [ثلاث] سنوات. محتواه لا يزال وثيق الصلة تماما. من ناحية أخرى ، لا يعتمد على التعلم الآلي. إنه يكره ذلك ، لذا فهذه مقاييس أساسية ومفيدة: هل العنوان مكتوب جيدًا؟ هل توجد أخطاء إملائية؟ هل توفر معرفة جديدة؟ نادرًا ما تحتاج إلى تعلم آلي للقيام بها.

ريبيكا: سيكون هذا النوع من النصائح مهمًا للغاية لأن معظم مُحسنات محركات البحث ليس لديهم بالضرورة الموارد أو البيانات أو الوقت أو المهارات فقط لتنفيذ التعلم الآلي ، حتى يتمكنوا من تحليل مواقعهم ، ومعرفة ما إذا كان هناك مخاطر الوقوع في ذلك أم لا.

فنسنت: بالضبط. علينا أن نتابع هذا عن كثب للغاية.

بالإضافة إلى ذلك ، يجب أن نكون حذرين للغاية بشأن ما نقوله. يجب أن نتحدث بصيغة الشرط. لا يوجد من هو متأكد من هذا الموضوع.

ريبيكا: هذا مؤكد. لدينا فقط أشياء عالية المستوى ، مما يعني أنه ليس لدينا دليل ولا أدلة ولا معلومات. لذا من الواضح أن كل ما يمكننا قوله عن ذلك ليس استنتاجات ، بل نظريات.

فنسنت: بالضبط.

إليك ما قمت بإعداده كنقطة انطلاق:

- تحليل الرموز للنظر في التكرار: حدد متى يكون مفرطًا ، ومتى يكون مجرد ترتيب.

- ثم الاحتمالات بين الكلمات التي ذكرتها سابقا.

- وأخيرًا ، مجموعة كلمات واحدة.

فقط باستخدام هذه المجموعات الثلاثة ، يمكنني اكتشاف 90٪ من النصوص التي تم إنشاؤها بواسطة الذكاء الاصطناعي والتي لم يتم تحسينها بواسطة إنسان. لذا تخيل ما يمكن أن تفعله Google! إنه أمر مذهل.

ريبيكا: لذلك يجب علينا بالتأكيد حضور مؤتمر SEO Campus الخاص بك في 23 سبتمبر مع كريستيان.

فينسينت: نعم ، أردنا فصل موضوع المحتوى المفيد قليلاً. إنه أمر مضحك: حتى قبل أن تبدأ Google في الحديث عن التحديث ، كنا قد خططنا لذلك.

يعجبني هذا الموضوع أيضًا لأنني مهتم جدًا بالبيئة. يجعلني أشعر بشعور أفضل عندما أعرف أن هناك عناصر تحكم من هذا القبيل لمنع الناس من إرسال البريد العشوائي. لأنه يكلفنا موارد لا يمكن تصورها.

ريبيكا: نعم ، إنها كذلك. مع هذا التحديث ، يولي الجميع اهتمامًا وثيقًا. أعتقد أن الناس الذين يعتقدون أنه لن يغير أي شيء هم مخطئون. يمكننا أن نرى أنه سيتغير ليس فقط كيفية إنشاء المحتوى ، ولكن أيضًا كيفية تقييم Google للمحتوى. وهذه استراتيجيات لم نرها من قبل.

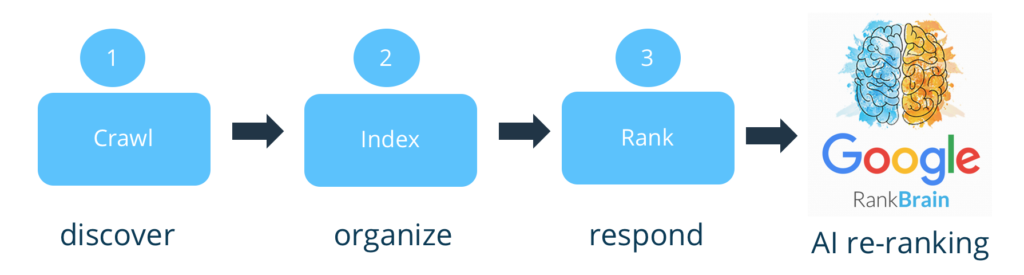

فنسنت: بالضبط. في الواقع ، إذا كنت تريد اتخاذ موقف متطرف ، فإن Google لا تقيم المحتوى. هذا ضعف كبير. كانت تستخدم فقط للفهرسة والترتيب. الآن سوف يقومون بتصفية المنبع. وهذا ما كان بينج ينتقد Google لعدم فعله.

ريبيكا: نعم ، جاء معظم التحليل [على المحتوى] في وقت التصنيف.

فنسنت: هذا صحيح. الآن يبدو أن لديها مرشح صغير. أتفق معك: لا أطيق الانتظار لرؤية براءة الاختراع التي تظهر في هذا الشأن. سيتعين عليهم الكشف عن مكان وضع الفلتر. أين تراهن أنهم وضعوا المرشح؟ قبل ، بعد الفهرسة أو قبل ذلك ، بعد الترتيب؟ أين تضعه؟

ريبيكا: نظرًا لأنه يجب أن يكون لديك معظم الموقع لتتمكن من القيام بذلك ، أود أن أقول ...

فينسينت: لا تنس أنك بحاجة إلى أثر SERPs ، كما ناقشنا ، للفهرسة. لذلك عليك فهرستها.

ريبيكا: نعم ، هذا ما كنت سأقوله. أعتقد أنه يجب أن تكون خطوة إضافية ، فنحن لا نجازف بإلغاء الفهرسة ، لذلك نحن نتحدث عن التأثير بعد الفهرسة ، ربما بعد الترتيب [الأولي] أيضًا.

فينسينت: نعم ، بالنسبة لي ، يأتي ذلك بعد الترتيب. إذا كنت Google ، فهذا شيء كنت سأضيفه إلى Google RankBrain ، لأنه قادر على تجميع الإشارات ، إلخ. الآن ، السؤال هو مدى تأثير ذلك على المواقع.

ريبيكا: مع التعلم الآلي ، يمكن أن يختلف كثيرًا من موقع إلى آخر ، لأنه يمكنك التحكم بشكل أكبر في تأثيره ومقدار المحتوى غير المفيد على كل موقع.

فنسنت: الحد مع Google هو الإيجابيات الكاذبة. سيكون ذلك بمثابة إلغاء فهرسة [أو معاقبة] الصفحات الشرعية. لذلك أعتقد أن التأثير الأولي سيكون منخفضًا جدًا جدًا ، لكنهم سيتبعون الغشاشين حقًا.

لقد اتصل بي أشخاص ، رغم ذلك ، كانوا قلقين قليلاً. أخبرتهم أنه في البداية ، سيكتشف فقط النص بدون جودة. أي ، أعتقد أن النص [الذي تم إنشاؤه] ، متبوعًا بالتدقيق اللغوي البشري ، يمكن أن يكون له كل فائدته.

لست صارمًا مثل الآخرين الذين يقولون "الذكاء الاصطناعي = القمامة". أنا لا أصدق ذلك أيضًا.

ريبيكا: هذا لا يفاجئني ، قادم منك!

إنه أمر محبط بعض الشيء ، مع العلم أنه سيكون بطيئًا. كما تقول ، لتجنب الإيجابيات الكاذبة ، هذا سبب آخر للانطلاق باللغة الإنجليزية: لديهم إتقان أفضل للغة الإنجليزية. هذا يجعل من الممكن وضع ضوابط إضافية باهظة الثمن ، قبل التعميم على الويب بالكامل وعلى اللغات الأخرى الأقل إتقانًا والأتمتة الأقل.

على أي حال ، كانت مناقشة غنية للغاية. شكرا جزيلا لك على هذا التبادل.

فينسينت: يمكننا التحدث عنها مرة أخرى وقتما تشاء.

ريبيكا: كان من دواعي سروري.