Vincent Terrasi: Die Bedeutung des Updates für hilfreiche Inhalte

Veröffentlicht: 2022-08-26Was ist das Update des Algorithmus für hilfreiche Inhalte?

Letzte Woche kündigte Google die Veröffentlichung eines Algorithmus-Updates an, das die Qualität der Suchergebnisse verbessern soll, indem es hilfreiche Inhalte fördert, die derzeit veröffentlicht werden. Dieses Update gilt zunächst nur für englischsprachige Websites und kann den Inhalt der gesamten Website entwerten, wenn die Website eine erhebliche Menge nicht hilfreicher Inhalte enthält.

Wie bei EAT kann der Begriff „hilfreich“ nicht einfach durch konkrete Metriken quantifiziert werden; Der Algorithmus stützt sich auf maschinelles Lernen, um nicht hilfreiche Inhalte zu identifizieren.

Erfahrene SEOs, die sich auf EAT- und Algorithmus-Updates spezialisiert haben, haben bereits ausführlich analysiert, was über das Helpful-Content-Update bekannt ist und wie darauf zu reagieren ist. Lesenswert sind die Analysen von Marie Haynes, Glenn Gabe und Lily Ray.

Um die Diskussion weiterzuführen, sprach ich mit Vincent Terrasi, Product Director bei Oncrawl und Experte für Daten-SEO mit Schwerpunkt auf maschinellem Lernen und Sprachmodellen wie BERT und GPT-3.

Das Interview mit Vincent Terrasi

„Wir können reine KI-Inhalte als unnatürlich identifizieren und werden daher bestraft. Aber auf der anderen Seite steckt hinter diesem Begriff des hilfreichen Inhalts ein anderes Thema, das all die neuen semantischen Werkzeuge, die auf den SERPs basieren, negativ beeinflussen kann. Google wird endlich in der Lage sein, eine Überoptimierung zu erkennen, ich meine, jemand, der den perfekten Fußabdruck zurückentwickeln würde, um in Google zu ranken.“

Inhaltsanalyse und Überoptimierungserkennung: Was das Update für hilfreiche Inhalte wirklich ändern wird

Rebecca: Ich denke immer wieder an verschiedene Elemente Ihrer Arbeit, die beim Tech SEO Boost 2019 den zweiten Platz gewonnen haben, wo Sie über die Textgenerierung für SEO, die Auswirkungen und die Gefahren gesprochen haben. Wir haben das Thema auch diskutiert, insbesondere als Google BERT veröffentlichte, und über die nächsten Schritte gesprochen und darüber, wie sie die Textanalyse durch maschinelles Lernen verallgemeinern könnten. In diesem Fall ist es so etwas wie eine Klassifizierung und dann noch eine semantische Analyse. Ist das auch so ziemlich das, was Sie davon haben? Überrascht Sie dieses Update?

Vincent: Ja, das habe ich auf der SEO Boost Tech angekündigt: dass sie [Google] nach dieser Art von Inhalten suchen würden.

Ich sage Kunden, die sich für die Textgenerierung bei Oncrawl interessieren, immer wieder, warum sie mit generierten Inhalten vorsichtig sein müssen.

Sie müssen vorsichtig sein, wenn Sie über von KI (künstliche Intelligenz) generierte Inhalte sprechen. Mit dem Update für hilfreiche Inhalte sprechen wir überhaupt nicht von einer manuellen Aktion, auch wenn es so aussehen mag, als würde es zu einer manuellen Aktion führen. Sie haben vielleicht einige der jüngsten Nachrichten über KI-generierte Websites gesehen, und ich würde das definitiv als manuelle Aktion klassifizieren. Das war vor drei Monaten: Es gab starke manuelle Maßnahmen, wo es Seiten gab, die angaben, dass sie 100.000 Dollar im Monat verdienten. Sie wurden alle deindexiert. Das sind manuelle Aktionen.

Jetzt gibt es dieses Update mit einem maschinellen Lernmodell, das erkennen kann, ob es sich um Text ohne Mehrwert handelt. Ich spreche also lieber nicht von KI, sondern von Seiten mit oder ohne Inhalt ohne Mehrwert.

Rebecca: Ja, es gibt eine Bestätigung von Google, dass es nicht um die manuellen Maßnahmen geht. Es ist interessant, dass Google in diesem Fall eindeutig sagt, dass es sich um maschinelles Lernen handelt und es so ziemlich die ganze Zeit läuft. In den folgenden Monaten könnte eine betroffene Website also möglicherweise neu klassifiziert werden … oder auch nicht.

Vincent: Ich werde darüber auf meiner Konferenz im September mit Christian Meline im SEO Camp Paris sprechen, weil es etwas ist, das wir vor fünf Monaten identifiziert haben. Kannst Du Dir vorstellen? Wir hatten bereits festgestellt, dass bei Google Dinge im Gange waren.

Insgesamt gibt es zwei Themen:

Da ist das Thema KI-generierter Content. Wir können sagen, dass Spam-Inhalte sehr leicht zu identifizieren sind, da sich KI wiederholt. Wenn Sie es in Wortgruppen von drei, vier, fünf Wörtern aufteilen, werden Sie sehen, dass es dieselben Sätze wiederholt. Das ist sehr einfach zu erkennen. Sie müssen kein maschinelles Lernen durchführen.

Und auf der anderen Seite besteht der Teil des maschinellen Lernens darin, dass es tatsächlich sehr stabile Wahrscheinlichkeiten gibt, dass das nächste Wort auftaucht.

Rebecca: Ja, darüber haben wir auch gesprochen, als wir an Ihren Schulungen gearbeitet haben. Intern bei Oncrawl hat dies dazu geführt, dass derzeit daran gearbeitet wird, ein Bewertungssystem für die Qualität von generierten Texten zu erstellen, um Inhalte zu finden, die zu leicht als solche erkennbar sind.

Vincent: Das stimmt.

Wir können reine KI-Inhalte als unnatürlich identifizieren und werden daher bestraft. Das ist also das erste Problem.

Aber auf der anderen Seite steckt hinter diesem Begriff des hilfreichen Inhalts ein anderes Thema, das all die neuen semantischen Werkzeuge, die auf den SERPs basieren, negativ beeinflussen kann.

Google wird endlich in der Lage sein, eine Überoptimierung zu erkennen, ich meine, jemand, der den perfekten Fußabdruck zurückentwickeln würde, um in Google zu ranken. Und hier haben wir starke und talentierte Spieler in Frankreich, die noch nicht viel auf die Nachrichten reagiert haben: die Freres Peyronnet, 1.fr, SEO Quantum usw. Sie sind direkt vom Problem der Überoptimierung betroffen. Sie sind von diesem Update direkt betroffen.

Rebecca: Nehmen wir Ihre Website transfer-learning.ai, die eher eine Sandbox war, um zu testen, ob wir mit vollständig generierten Inhalten ranken können, während wir etwas hinzufügen, das heute nicht existiert (in diesem Fall die Verbindung zwischen akademischer Forschung und Schulungen). verwandten Themen zum maschinellen Lernen). Ist so etwas Ihrer Meinung nach überhaupt noch möglich?

Vincent: Wenn es Originalität bringt und nicht als Spam erkannt wird, ja, so etwas wird immer möglich sein.

Wenn es jedoch nicht als hilfreich angesehen wird, ist es nicht möglich.

Außerdem möchte ich französische YouTuber klar daran erinnern: Wir sprechen über Englisch. Wir wissen, dass die Einführung in englischer Sprache Monate und oft ein Jahr dauern kann. Wenn wir auf die alten massiven Core-Updates wie Panda oder Penguin zurückblicken, dauerten sie in einigen Fällen bis zu mehreren Jahren. Ich denke, dass einige Leute diese Zeit nutzen werden, um weiterhin Spam-Techniken zu üben. Und dann greift Google ein.

Was ich während meiner Präsentation mit Christian Meline besprechen werde, ist, dass wir, anstatt Themen vorzuschlagen, die Google bereits hat und an denen es nicht interessiert ist, neue Technologien verwenden können, die uns helfen, neue Themen vorzuschlagen.

Ich gebe Ihnen ein Beispiel. Wenn ich alle SEO-Tools teste und Themenideen mit GPT-3 oder in einem französischen Tool wie beispielsweise yourtext.guru generiere, bekomme ich 40 Ideen. Wenn ich die Technik von Christian Meline anwende, bekomme ich 4.500. Und einige davon sind sogar Themen, die noch nie verwendet wurden und nicht einmal in Google sind.

Was denkst du, wird Google bevorzugen? Inhalte zu haben, die es bereits kennt, oder sehr interessante Themen zu haben, mit denen sich noch nie jemand beschäftigt hat?

Ich denke, das ist die Zukunft von SEO: neue Dinge erkennen zu können. Ich weiß, dass Koray auch in diese semantische Richtung geht.

Rebecca: Ja, im Sinne der Analyse von inhaltlichen Lücken oder Lücken, wo man eine Expertise aufbauen kann, denn es sind die semantischen Bereiche eines Themas, die überhaupt nicht angesprochen werden.

Vincent: Genau. Andererseits denke ich, dass dieses Update das nicht sofort tun wird. Es wird eine Version 1, eine Version 2 usw. geben. Aber das ultimative Ziel dieses Updates ist genau das.

[Fallstudie] Verwaltung des Bot-Crawlings von Google

Andere Sprachen und andere Medien: Wie wird dieses Update bereitgestellt?

Rebecca: Du hast vorhin den Unterschied zwischen Englisch und anderen Sprachen wie Französisch erwähnt. Wir haben große Fortschritte bei der Übersetzung gemacht, bei der sprachunabhängigen Verarbeitung, wie bei MuM. Glauben Sie, dass es wirklich so lange dauern wird, bis dieses Update in anderen Sprachen verfügbar ist?

Vincent: Ehrlich gesagt habe ich einige eigene Arbeiten gemacht. Ich habe die Technologie von Google nicht, ich kenne Google nicht, aber ich habe noch nie einen Algorithmus gesehen, dessen Ausführung so lange dauert. Das bedeutet, dass es für einen Absatz mit 300 Wörtern etwa zehn Sekunden dauert. Es ist eine Ewigkeit. Normalerweise reden wir über TF-IDF-Berechnungen, Worteinbettungen … und es dauert eine Sekunde. Mit anderen Worten, diese Art von Algorithmus ist ziemlich schwer zu implementieren. Jetzt weiß ich, dass Google die Technologie hat, sie haben TPUs, sie haben superintelligente Ingenieure, aber ich denke, sie werden diese Grenze haben, wenn sie ein Sprachmodell verwenden: Sie müssen das Sprachmodell laden. Und bei 200 Milliarden Parametern kann es weh tun.

Es ist lustig, es ist ungefähr zur gleichen Zeit wie die Veröffentlichung des Textgenerierungsmodells auf HuggingFace. Also denke ich, und es gibt niemanden, der das mit Sicherheit sagen kann, aber darauf haben sie ihre Entdeckung gestützt. Tatsächlich veröffentlichten sie ein Textgenerierungsmodell, um die Textgenerierung zu erkennen. Google bekämpft Feuer mit Feuer, wie man so schön sagt.

Rebecca: Ja, so funktioniert es, oder? Das war schon immer so bei der Erkennung von automatisierten Texten. Wir nutzen das, was wir darüber wissen, wie es aufgebaut ist, um es zu erkennen.

Vincent: Aber was mich beeindruckt, sind die SEO-Tools, die einen Fingerabdruck der SERPs liefern. Google sagt jetzt: „Wir haben den Fußabdruck und wir werden feststellen können, ob Sie zu sehr davon inspiriert sind.“ Niemand weiß, wie sie das machen. Ich weiß, wie es andere SEO-Tools machen, aber wie machen sie [Google] es? Niemand weiß.

Rebecca: Das andere, was mir aufgefallen ist, war, dass es sich um eine Analyse auf Site-Ebene handelt und dass dann für jede Site, wenn wir wirklich von einer sehr hohen Verallgemeinerung sprechen, ein „Wert“ von hilfreichem oder nicht hilfreichem Inhalt zugewiesen wird auf die Website, die sich auf andere Inhalte auf dieser Website auswirken kann. Und das ist eine Menge individueller Analysen und eine Menge Informationsspeicherung. Allein das zu verarbeiten oder erneut zu verarbeiten, kostet viel Zeit.

Vincent: Ich denke, das ist die Einschränkung, die sie haben. Sie haben angekündigt, dass sie dies nur in der Google-Suche tun, nicht in Google Discover.

Es ist ein bisschen paradox, denn bei Google Discover schummelt jeder, jeder optimiert „SEO“-Inhalte, nur um in Google Discover zu sein. Ich denke, sie haben derzeit ein großes Problem mit der Google-Suche und all diesen automatisch generierten Inhalten. Es gibt einige Websites, die mit automatisch generierten Inhalten über Bord gegangen sind.

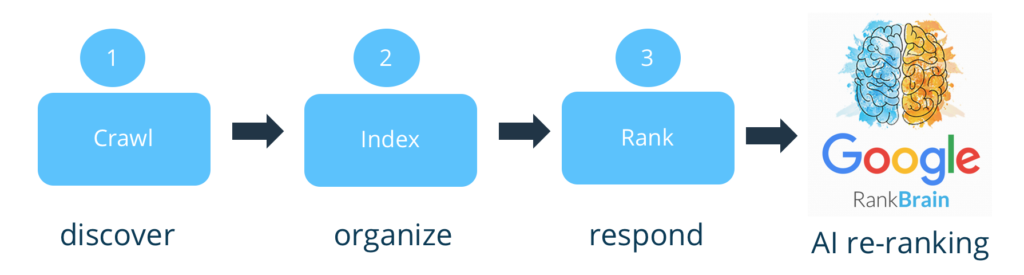

Sie sprechen nicht von einer Strafe, also drehen sie das so wie mit Google RankBrain als neues Signal.

Und nicht alle Seiten sind betroffen. Ich denke insbesondere an E-Commerce-Sites mit all ihren Produktbeschreibungen. Wir wissen, dass jeder den anderen kopiert.

Rebecca: Ja, das Erstellen von Varianten auf der Grundlage der offiziellen Beschreibungen der Hersteller, der Marken.

Vinzenz: Ja.

Einige Medienseiten sind jedoch stärker gefährdet. Es gibt ein Phänomen, das im SEO schon lange bekannt ist. Einige Websites nehmen beispielsweise englische Inhalte und übersetzen sie, ohne einen Mehrwert hinzuzufügen. Niemand hat darüber gesprochen, aber es besteht ein großes Risiko für diese Art von Sites, weil sie nichts hinzufügen und obendrein den Fehler haben, ihre Quellen nicht zu zitieren.

Rebecca: Und sie werden auch den Originalinhalt auf Englisch haben, um einen Vergleich anstellen zu können.

Vincent: Ja, die Phase, in der wir mit diesem Update vom Englischen zum Französischen wechseln, wird wahrscheinlich vielen der Spam-Websites schaden.

Von allen SEO-News der letzten Monate ist dies das wichtigste Update. RankBrain auch, könnten wir sagen, aber es war viel weniger offensichtlich, darauf hinzuweisen, schwer zu erkennen, was die tatsächlichen Ergebnisse seiner Anwendung sind.

Rebecca: Ich denke, es ist eigentlich nah, mit dem Konzept der semantischen Analyse und den Teilen der Website, die nichts mit dem Rest der Website zu tun haben.

Vincent: Genau.

Ich weiß, dass sie schon eine Weile daran arbeiten. Ich hatte einen Freund, der bei Google arbeitet und sagte, er arbeite seit 2009 daran; Es gab zwei Forschungsteams dazu. Sie versuchen es jetzt in Echtzeit und sie werden viel aufräumen.

Aber wir wissen noch nicht viel über die Umsetzung. Wie werden sie es tun? Mit Signal? Werden diejenigen, die schummeln, weniger gut indiziert? Niemand außer John Mueller kann diese Frage beantworten.

Rebecca: Ich bezweifle, dass sogar er das darf. Ich kann mir vorstellen, dass sie an ihrer Linie festhalten werden: „Erstellen Sie nützliche Inhalte für Benutzer, nicht für Suchmaschinen, und Sie werden kein Problem haben.“

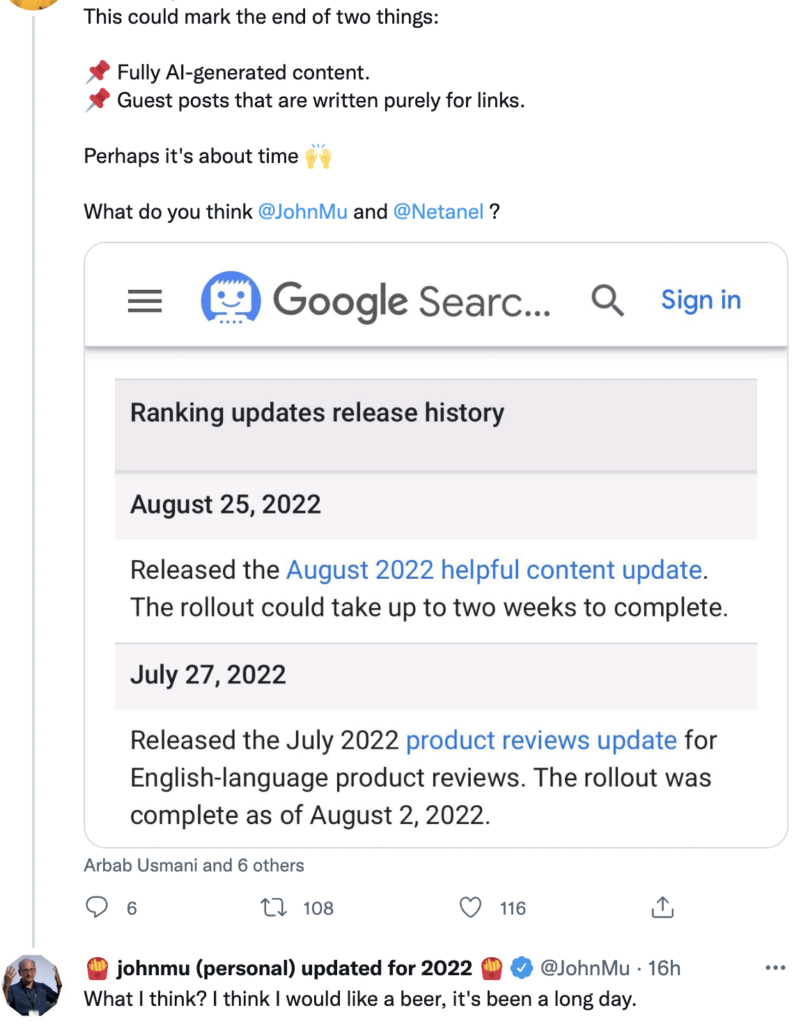

Vincent: Auf Twitter wird er mit Fragen zu diesem Thema bombardiert und seine Antworten waren etwas breit gefächert.

Quelle: Twitter

Die Auswirkungen auf die Inhaltserstellung in der Zukunft

Rebecca: Das überrascht mich nicht. Ich denke, er hat wahrscheinlich keine genaueren Informationen. Und selbst wenn, muss es absolut verboten sein, über den Algorithmus zu sprechen.

Wie auch immer, ich bin sehr gespannt darauf, die Patente zu sehen, die sich auf dieses Update beziehen, um eine erneute Analyse der Patente in einem Jahr, zwei Jahren durchzuführen, um zu sehen, was da draußen ist und ob es etwas später Hinweise auf eine Verwendung gibt. Aber das ist ein anderes Thema.

Vincent: Um mich auf meine Konferenz im September vorzubereiten, habe ich aufgelistet, wie wir qualitativ hochwertigen Inhalt und nützlichen Inhalt erkennen. Ich stützte mich auf den Artikel im Journaldunet (auf Französisch), in dem Christian Meline vor [drei] Jahren über das Thema geschrieben hatte. Sein Inhalt ist nach wie vor absolut aktuell. Andererseits setzt er nicht auf maschinelles Lernen. Er hasst es, also sind dies grundlegende, nützliche Metriken: Ist der Titel gut geschrieben? Gibt es Rechtschreibfehler? Bringt es neues Wissen? Selten Dinge, bei denen Sie maschinelles Lernen benötigen, um sie zu erledigen.

Rebecca: Diese Art von Beratung wird sehr wichtig sein, da die meisten SEOs nicht unbedingt über die Ressourcen, die Daten, die Zeit oder die Fähigkeiten verfügen, um maschinelles Lernen zu implementieren, um ihre Websites analysieren zu können, um zu wissen, ob es welche gibt Gefahr, hineinzufallen oder nicht.

Vincent: Genau. Wir müssen das sehr, sehr genau verfolgen.

Außerdem müssen wir sehr vorsichtig sein mit dem, was wir sagen. Wir müssen im Konditional sprechen. Es gibt niemanden, der sich bei diesem Thema sicher ist.

Rebecca: Das ist sicher. Wir haben nur Dinge auf sehr hohem Niveau, was bedeutet, dass wir keine Beweise, keine Hinweise und keine Informationen haben. Alles, was wir dazu sagen können, sind also keine Schlussfolgerungen, sondern Theorien.

Vincent: Genau.

Hier ist, was ich als Ausgangspunkt eingerichtet habe:

- Die Analyse von Tokens, um Wiederholungen zu betrachten: Identifizieren Sie, wann es übertrieben ist, wann es nur um Rangfolge geht.

- Dann die Wahrscheinlichkeiten zwischen Wörtern, die ich zuvor erwähnt habe.

- Und schließlich eins, Wortgruppen.

Allein mit diesen drei Kombinationen kann ich 90 % der KI-generierten Texte erkennen, die nicht von einem Menschen optimiert wurden. Stellen Sie sich also vor, was Google tun kann! Es ist überwältigend.

Rebecca: Also sollten wir unbedingt mit Christian zu deiner SEO Campus Konferenz am 23. September gehen.

Vincent: Ja, wir wollten das Thema hilfreiche Inhalte etwas auseinander nehmen. Es ist lustig: Schon bevor Google anfing, über das Update zu sprechen, hatten wir dies geplant.

Ich mag dieses Thema auch, weil ich sehr umweltbewusst bin. Es gibt mir ein besseres Gefühl zu wissen, dass es Kontrollen wie diese gibt, die Leute davon abhalten sollen, zu spammen. Denn es kostet uns unvorstellbare Ressourcen.

Rebekka: Ja, das tut es. Bei diesem Update achten alle genau darauf. Ich denke, die Leute, die denken, dass es nichts ändern wird, liegen falsch. Wir können sehen, dass es nicht nur ändern wird, wie wir Inhalte erstellen, sondern auch, wie Google Inhalte bewertet. Und das sind Strategien, die wir vorher noch nicht gesehen haben.

Vincent: Genau. In der Tat, wenn Sie eine extreme Haltung einnehmen möchten, Google bewertet keine Inhalte. Das ist eine riesige Schwäche. Früher wurde nur indexiert und gerankt. Jetzt filtern sie stromaufwärts. Und das ist es, was Bing Google dafür kritisierte, es nicht zu tun.

Rebecca: Ja, die meisten Analysen [zum Inhalt] kamen zum Zeitpunkt des Rankings.

Vincent: Das stimmt. Jetzt scheint es einen kleinen Filter zu haben. Ich stimme Ihnen zu: Ich kann es kaum erwarten, das Patent zu sehen, das dazu herauskommt. Sie müssen offenbaren, wo sie den Filter platziert haben. Wetten, wo sie den Filter hinstellen? Vor, nach der Indizierung oder vor, nach dem Ranking? Wo würdest du es hinstellen?

Rebecca: Da man dafür den größten Teil der Seite haben muss, würde ich sagen…

Vincent: Vergessen Sie nicht, dass Sie, wie wir besprochen haben, den Fußabdruck der SERPs für die Indizierung benötigen. Sie müssen sie also indizieren.

Rebecca: Ja, das wollte ich sagen. Ich denke, es sollte ein zusätzlicher Schritt sein, wir gehen nicht das Risiko einer De-Indexierung ein, also sprechen wir von einer Auswirkung nach der Indexierung, vielleicht auch nach dem [ersten] Ranking.

Vincent: Ja, für mich kommt es auf die Rangliste an. Wenn ich Google wäre, hätte ich das zu Google RankBrain hinzugefügt, weil es in der Lage ist, Signale usw. zu aggregieren. Nun stellt sich die Frage, wie wirkungsvoll es auf Websites sein wird.

Rebecca: Beim maschinellen Lernen kann es von Website zu Website sehr unterschiedlich sein, da Sie viel mehr Kontrolle über die Auswirkungen und die Anzahl der nicht hilfreichen Inhalte auf jeder Website haben.

Vincent: Das Limit bei Google sind Fehlalarme. Das würde legitime Seiten de-indexieren [oder bestrafen]. Ich denke also, dass die anfängliche Wirkung sehr, sehr gering sein wird, aber sie werden wirklich hinter den Betrügern her sein.

Ich hatte jedoch Leute, die sich mit mir in Verbindung setzten, die ein wenig besorgt waren. Ich habe ihnen gesagt, dass es am Anfang nur Text ohne Qualität erkennen wird. Das heißt, ich denke, dass ein [generierter] Text, gefolgt von menschlichem Korrekturlesen, all seinen Nutzen haben kann.

Ich bin nicht so streng wie andere, die sagen „KI = Müll“. Das glaube ich auch nicht wirklich.

Rebecca: Das wundert mich nicht, das kommt von dir!

Es ist ein wenig frustrierend, zu wissen, dass es langsam sein wird. Wie Sie sagen, um Fehlalarme zu vermeiden, ist dies ein weiterer Grund für den Start auf Englisch: Sie verfügen über bessere Englischkenntnisse. Dies macht es möglich, zusätzliche Kontrollen einzubauen, die viel teurer sind, bevor sie auf das gesamte Web und auf andere Sprachen, die weniger gut beherrscht und weniger gut automatisiert sind, verallgemeinert werden.

Auf jeden Fall war es eine sehr reichhaltige Diskussion. Vielen Dank für diesen Austausch.

Vincent: Wir können darüber reden, wann immer Sie wollen.

Rebecca: Es war mir ein Vergnügen.