Vincent Terrasi: La importancia de la actualización de contenido útil

Publicado: 2022-08-26¿Qué es la actualización del algoritmo de contenido útil?

La semana pasada, Google anunció el lanzamiento de una actualización de algoritmo que busca mejorar la calidad de los resultados de búsqueda mediante la promoción de contenido útil, que se está lanzando actualmente. Esta actualización se aplicará inicialmente solo a los sitios web en inglés y puede devaluar el contenido de todo el sitio si el sitio tiene una cantidad significativa de contenido inútil.

Al igual que con EAT, la noción de "útil" no se puede cuantificar fácilmente mediante métricas concretas; el algoritmo se basa en el aprendizaje automático para identificar contenido inútil.

Los SEO experimentados que se especializan en EAT y actualizaciones de algoritmos ya han analizado en detalle qué se sabe y cómo reaccionar ante la actualización de contenido útil. Vale la pena leer los análisis de Marie Haynes, Glenn Gabe y Lily Ray.

Para profundizar en la discusión, hablé con Vincent Terrasi, director de producto de Oncrawl y experto en SEO de datos con un enfoque en el aprendizaje automático y modelos de lenguaje como BERT y GPT-3.

La entrevista con Vicente Terrasi

“Podemos identificar el contenido puro de IA como antinatural y, por lo tanto, será penalizado. Pero por otro lado, detrás de esta noción de Contenido Útil, hay otro tema que puede afectar negativamente a todas las nuevas herramientas semánticas que se basan en las SERPs. Google finalmente podrá detectar la optimización excesiva, es decir, alguien que haría ingeniería inversa de la huella perfecta para clasificar en Google”.

Análisis de contenido y detección de sobreoptimización: lo que realmente cambiará la actualización de contenido útil

Rebecca: Sigo pensando en varios elementos de su trabajo que ganaron el segundo lugar en Tech SEO Boost 2019, donde habló sobre la generación de texto para SEO, los impactos y los peligros. También discutimos el tema, especialmente cuando Google lanzó BERT, hablando sobre los próximos pasos y cómo podrían generalizar el análisis de texto a través del aprendizaje automático. En este caso, es como una clasificación y luego un análisis semántico además de eso. ¿Es eso más o menos lo que estás sacando de esto también? ¿Te sorprende esta actualización?

Vincent: Sí, eso es lo que anuncié en SEO Boost Tech: que ellos [Google] iban a buscar este tipo de contenido.

Sigo diciendo a los clientes que están interesados en la generación de texto en Oncrawl por qué deben tener cuidado con el contenido generado.

Hay que tener cuidado cuando se habla de contenido generado por IA (inteligencia artificial). Con la actualización de Contenido útil, no estamos hablando en absoluto de una acción manual, aunque podría parecer el tipo de cosa que conduciría a una acción manual. Es posible que haya visto algunas de las noticias recientes sobre sitios generados por IA, y definitivamente lo clasificaría como acción manual. Esto fue hace tres meses: hubo fuertes acciones manuales donde había sitios que decían que estaban ganando $100,000 al mes. Todos fueron desindexados. Esas son acciones manuales.

Ahora, existe esta actualización con un modelo de aprendizaje automático que puede identificar si se trata de texto sin valor agregado. Así que prefiero no hablar de IA, sino de sitios con o sin contenido sin valor agregado.

Rebecca: Sí, hay una confirmación de Google de que no se trata de acciones manuales. Es interesante que, en este caso, Google diga claramente que es aprendizaje automático y que se ejecuta prácticamente todo el tiempo. Entonces, en los meses siguientes, un sitio afectado posiblemente podría ser reclasificado... o no.

Vincent: Voy a hablar de esto en mi conferencia en septiembre con Christian Meline en SEO Camp Paris, porque es algo que identificamos hace cinco meses. ¿Puedes imaginar? Ya habíamos identificado que estaban pasando cosas con Google.

En general, hay dos temas:

Está el tema del contenido generado por IA. Podemos decir que el contenido de spam puede ser muy fácil de identificar porque la IA se repite. Si lo divide en grupos de palabras de tres, cuatro, cinco palabras, verá que repite las mismas frases. Eso es muy fácil de detectar. No es necesario hacer aprendizaje automático.

Y por otro lado, la parte del aprendizaje automático es que, de hecho, hay probabilidades muy estables de que aparezca la siguiente palabra.

Rebecca: Sí, también hablamos de esto cuando estábamos trabajando en sus cursos de capacitación. Internamente en Oncrawl, esto ha llevado al trabajo que se está realizando actualmente para crear un sistema de puntuación de la calidad de los textos generados, con el fin de encontrar contenido que sea fácilmente identificable como tal.

Vicente: Así es.

Podemos identificar el contenido de IA pura como antinatural y, por lo tanto, será penalizado. Así que ese es el primer problema.

Pero por otro lado, detrás de esta noción de Contenido Útil, hay otro tema que puede afectar negativamente a todas las nuevas herramientas semánticas que se basan en las SERPs.

Google finalmente podrá detectar la optimización excesiva, es decir, alguien que haría ingeniería inversa de la huella perfecta para clasificar en Google. Y aquí tenemos jugadores fuertes y talentosos en Francia que aún no han reaccionado mucho a las noticias: Freres Peyronnet, 1.fr, SEO Quantum, etc. Están directamente afectados por el problema de la sobreoptimización. Se ven directamente afectados por esta actualización.

Rebecca: Tomemos su sitio transfer-learning.ai, que era más una caja de arena para probar si podíamos clasificar con contenido completamente generado, mientras agregamos algo que no existe hoy (en este caso, el vínculo entre la investigación académica y los cursos de capacitación sobre temas relacionados con el aprendizaje automático). En tu opinión, ¿sigue siendo posible hacer este tipo de cosas?

Vincent: Si aporta originalidad y no se detecta como spam, sí, siempre será posible hacer este tipo de cosas.

Sin embargo, si no se considera útil, entonces no será posible.

Además, quiero hacer un claro recordatorio a los creadores franceses: estamos hablando del inglés. Sabemos que la implementación en inglés puede durar meses y, a menudo, un año. Cuando miramos hacia atrás a las antiguas actualizaciones principales masivas como Panda o Penguin, duraron hasta varios años en algunos casos. Creo que algunas personas aprovecharán este período de tiempo para seguir practicando técnicas de spam. Y luego intervendrá Google.

Lo que voy a discutir durante mi presentación con Christian Meline es que en lugar de proponer temas que Google ya tiene y que no le interesan, podemos usar nuevas tecnologías que nos ayuden a proponer nuevos temas.

Te daré un ejemplo. Si pruebo todas las herramientas de SEO y genero ideas de temas con GPT-3, o en una herramienta en francés como yourtext.guru, por ejemplo, obtendré 40 ideas. Si uso la técnica de Christian Meline, obtendré 4.500. Y algunos de ellos son incluso temas que nunca antes se han utilizado y ni siquiera están en Google.

¿Qué crees que preferirá Google? ¿Tener contenido que ya conoce o tener temas muy interesantes en los que nadie ha profundizado nunca?

Creo que ese es el futuro del SEO: ser capaz de detectar cosas nuevas. Sé que Koray también va en esa dirección semántica.

Rebecca: Sí, en el sentido de analizar las brechas o lagunas de contenido donde se puede establecer una experiencia, porque son esas áreas semánticas de un tema las que no se abordan en absoluto.

Vicente: Exacto. Por otro lado, creo que esta actualización no lo hará de inmediato. Habrá una versión 1, una versión 2, y así sucesivamente. Pero el objetivo final de esta actualización es hacer eso.

[Estudio de caso] Administrar el rastreo de bots de Google

Otros idiomas y otros medios: ¿Cómo se implementará esta actualización?

Rebecca: Mencionaste antes la diferencia entre el inglés y otros idiomas como el francés. Hemos hecho grandes avances en la traducción, en el procesamiento agnóstico del idioma, como con MuM. ¿Crees que realmente tomará tanto tiempo para que esta actualización se mueva a otros idiomas?

Vincent: Francamente, he hecho algunos trabajos por mi cuenta. No tengo la tecnología de Google, no conozco a Google, pero nunca he visto un algoritmo que tarde tanto en ejecutarse. Eso significa que para un párrafo de 300 palabras, toma alrededor de diez segundos. Es una eternidad. Por lo general, estamos hablando de cálculos TF-IDF, incrustaciones de palabras... y lleva un segundo. En otras palabras, este tipo de algoritmo es bastante pesado de implementar. Ahora sé que Google tiene la tecnología, tienen TPU, tienen ingenieros súper inteligentes, pero creo que van a tener este límite al usar un modelo de idioma: tienes que cargar el modelo de idioma. Y cuando hay 200 mil millones de parámetros, puede doler.

Es divertido, es casi al mismo tiempo que el lanzamiento del modelo de generación de texto en HuggingFace. Eso creo, y no hay nadie que pueda decir esto con certeza, pero en eso basaron su detección. De hecho, lanzaron un modelo de generación de texto para detectar la generación de texto. Google combate el fuego con fuego, como dicen.

Rebecca: Sí, así es como funciona, ¿verdad? Siempre ha sido así en la detección de textos automatizados. Usamos lo que sabemos sobre cómo está construido para detectarlo.

Vincent: Pero lo que me impresiona son las herramientas de SEO que brindan una huella digital de las SERP. Google ahora dice: "Tenemos la huella y podremos saber si está demasiado inspirado por ella". Nadie sabe cómo lo hacen. Sé cómo lo hacen otras herramientas de SEO, pero ¿cómo lo hacen [Google]? Nadie sabe.

Rebecca: En realidad, la otra cosa que me llamó la atención fue que se trata de un análisis a nivel del sitio y luego, para cada sitio, si realmente estamos hablando de una generalización de muy alto nivel, se asigna un "valor" de contenido útil o no útil. al sitio que puede impactar otro contenido en ese sitio. Y eso es mucho análisis individual y mucho almacenamiento de información. Entonces, incluso solo para procesar o volver a procesar eso, lleva mucho tiempo.

Vincent: Creo que esa es la restricción que tienen. Han anunciado que solo lo están haciendo en la Búsqueda de Google, no en Google Discover.

Es un poco paradójico porque en Google Discover, todos hacen trampa, todos optimizan el contenido de "SEO" solo para estar en Google Discover. Creo que ahora mismo tienen un gran problema con la Búsqueda de Google y todo este contenido generado automáticamente. Hay algunos sitios que se han pasado de la raya con el contenido generado automáticamente.

No están hablando de una penalización, por lo que están haciendo girar esto como con Google RankBrain, como una nueva señal.

Y no todos los sitios se verán afectados. Estoy pensando en particular en los sitios de comercio electrónico con todas sus descripciones de productos. Sabemos que todos se están copiando unos a otros.

Rebecca: Sí, creando variantes basadas en las descripciones oficiales de los productores, las marcas.

Vicente: Sí.

Pero algunos sitios de medios corren más riesgo. Hay un fenómeno que se conoce en SEO desde hace mucho tiempo. Por ejemplo, algunos sitios toman contenido en inglés y lo traducen sin agregar ningún valor. Nadie ha hablado de eso, pero hay un riesgo mayor para este tipo de sitios porque no agregan nada y encima tienen el defecto de no citar sus fuentes.

Rebecca: Y también tendrán el contenido original en inglés para hacer una comparación.

Vincent: Sí, la etapa en la que pasamos del inglés al francés con esta actualización probablemente perjudicará a muchos de los sitios con spam.

De todas las noticias de SEO de los últimos meses, esta es la actualización más importante. RankBrain también, podríamos decir, pero ha sido mucho menos obvio señalarlo, es difícil ver cuáles son los resultados reales de su aplicación.

Rebecca: Creo que en realidad está cerca, con el concepto de análisis semántico y las partes del sitio web que no están relacionadas con el resto del sitio web.

Vicente: Exacto.

Sé que han estado trabajando en esto por un tiempo. Tenía un amigo que trabaja en Google, que dijo que ha estado trabajando en esto desde 2009; había dos equipos de investigación sobre esto. Están tratando de hacerlo ahora en tiempo real y van a hacer mucha limpieza.

Pero todavía no sabemos mucho sobre la implementación. ¿Cómo lo harán? ¿Con una señal? ¿Serán indexados menos bien los que hacen trampa? Nadie puede responder a esa pregunta excepto John Mueller.

Rebecca: Dudo que incluso a él se le permita hacerlo. Me imagino que seguirán con su línea de: “crea contenido útil para los usuarios, no para los buscadores, y no tendrás problema”.

Vincent: En Twitter, está siendo bombardeado con preguntas sobre este tema y sus respuestas han sido un poco amplias.

Fuente: Gorjeo

El impacto en la creación de contenido en el futuro

Rebecca: No me sorprende eso. Creo que probablemente no tiene más información específica. E incluso si lo hace, debe estar absolutamente prohibido hablar sobre el algoritmo.

De todos modos, estoy muy ansioso por comenzar a ver las patentes que están relacionadas con esta actualización, para hacer un nuevo análisis de las patentes en un año, dos años, para ver qué hay y si hay alguna indicación de uso un poco más adelante. Pero ese es otro tema.

Vincent: Para prepararme para mi conferencia en septiembre, he enumerado cómo reconocemos contenido de calidad, contenido útil. Me basé en el artículo del journaldunet (en francés) donde Christian Meline había escrito sobre el tema hace [tres] años. Su contenido sigue siendo completamente relevante. Por otro lado, no se basa en el aprendizaje automático. Lo odia, así que estas son métricas básicas y útiles: ¿está bien escrito el título? ¿Hay errores ortográficos? ¿Proporciona nuevos conocimientos? Rara vez cosas en las que necesitará aprendizaje automático para hacerlas.

Rebecca: Este tipo de consejo va a ser muy importante porque la mayoría de los SEO no necesariamente tienen los recursos, los datos, el tiempo o simplemente las habilidades para implementar el aprendizaje automático, para poder analizar sus sitios, para saber si hay riesgos de caer en eso o no.

Vicente: Exacto. Tenemos que seguir esto muy, muy de cerca.

Además, tenemos que tener mucho cuidado con lo que decimos. Tenemos que hablar en el tiempo condicional. No hay nadie que esté seguro sobre este tema.

rebeca: eso es seguro Solo tenemos cosas de muy alto nivel, lo que significa que no tenemos pruebas, pistas ni información. Claramente, todo lo que podemos decir al respecto no son conclusiones, son teorías.

Vicente: Exacto.

Esto es lo que configuré como punto de partida:

- El análisis de tokens para observar la repetición: identificar cuándo es excesiva, cuándo es solo para clasificar.

- Luego, las probabilidades entre palabras que mencioné anteriormente.

- Y finalmente uno, grupos de palabras.

Solo con estos tres combos, puedo detectar el 90% de los textos generados por IA que no han sido optimizados por un humano. ¡Así que imagina lo que Google puede hacer! Es alucinante.

Rebecca: Así que definitivamente deberíamos asistir a su conferencia SEO Campus el 23 de septiembre con Christian.

Vincent: Sí, queríamos desmenuzar un poco el tema del contenido útil. Es gracioso: incluso antes de que Google comenzara a hablar sobre la actualización, teníamos esto planeado.

También me gusta este tema porque soy muy ecologista. Me hace sentir mejor saber que existen controles como ese para evitar que la gente envíe spam. Porque nos cuesta recursos inimaginables.

rebeca: sí, lo hace. Con esta actualización, todos están prestando mucha atención. Creo que la gente que piensa que no va a cambiar nada está equivocada. Podemos ver que va a cambiar no solo la forma en que creamos contenido, sino también la forma en que Google evalúa el contenido. Y estas son estrategias que no hemos visto antes.

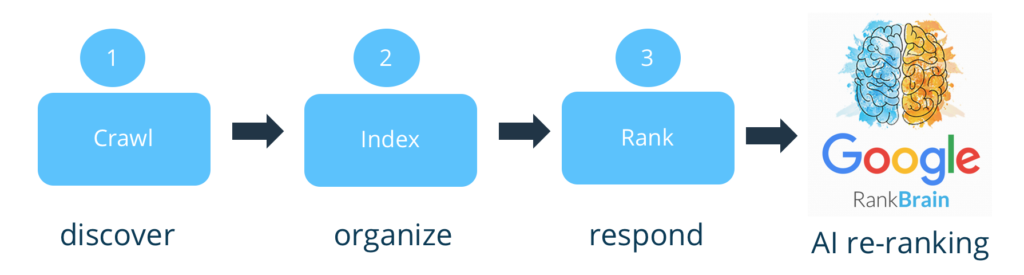

Vicente: Exacto. De hecho, si quieres tomar una postura extrema, Google no evalúa el contenido. Esa es una gran debilidad. Solía solo indexar y clasificar. Ahora se filtrarán río arriba. Y eso es lo que Bing estaba criticando a Google por no hacer.

Rebecca: Sí, la mayor parte del análisis [sobre el contenido] se produjo en el momento de la clasificación.

Vicente: Así es. Ahora parece tener un pequeño filtro. Estoy de acuerdo contigo: no veo la hora de ver la patente que sale sobre esto. Tendrán que revelar dónde pusieron el filtro. ¿Dónde apuestas a que pusieron el filtro? ¿Antes, después de la indexación o antes, después de la clasificación? ¿Dónde lo pondrías?

Rebecca: Ya que tienes que tener la mayor parte del sitio para poder hacer eso, yo diría...

Vincent: No olvide que necesita la huella de las SERP, como comentamos, para la indexación. Así que tienes que indexarlos.

Rebecca: Sí, eso es lo que iba a decir. Creo que debería ser un paso adicional, no corremos el riesgo de desindexar, por lo que estamos hablando de un impacto después de la indexación, tal vez también después de la clasificación [inicial].

Vincent: Sí, para mí es después del ranking. Si yo fuera Google, esto es algo que habría agregado a Google RankBrain, porque puede agregar señales, etc. Ahora, la pregunta es qué impacto tendrá en los sitios.

Rebecca: Con el aprendizaje automático, puede variar mucho de un sitio a otro, porque puede tener mucho más control sobre su impacto y la cantidad de contenido inútil que hay en cada sitio.

Vincent: El límite con Google son los falsos positivos. Eso sería desindexar [o penalizar] páginas legítimas. Así que creo que el impacto inicial va a ser muy, muy bajo, pero realmente van a perseguir a los tramposos.

Sin embargo, me han contactado personas que estaban un poco preocupadas. Les dije que al principio solo detectará texto sin calidad. Es decir, creo que un texto [generado], seguido de revisión humana, puede tener toda su utilidad.

No soy tan estricto como otros que dicen “AI = basura”. Yo tampoco creo eso.

Rebecca: ¡Eso no me sorprende viniendo de ti!

Es un poco frustrante saber que va a ser lento. Como dices, para evitar falsos positivos, ese es otro motivo para lanzar en inglés: dominan mejor el inglés. Esto permite poner controles adicionales que son mucho más costosos, antes de generalizar a toda la web y a otros lenguajes menos dominados, menos automatizados.

En cualquier caso, fue una discusión muy rica. Muchas gracias por este intercambio.

Vincent: Podemos volver a hablar de eso cuando quieras.

Rebeca: Ha sido un placer.