Vincent Terrasi: Pentingnya Pembaruan Konten yang Bermanfaat

Diterbitkan: 2022-08-26Apa itu pembaruan algoritme Konten Bermanfaat?

Pekan lalu, Google mengumumkan rilis pembaruan algoritme yang berupaya meningkatkan kualitas hasil pencarian dengan mempromosikan Konten Bermanfaat, yang saat ini sedang dirilis. Pembaruan ini awalnya hanya berlaku untuk situs web berbahasa Inggris, dan dapat menurunkan nilai konten seluruh situs jika situs tersebut memiliki sejumlah besar konten yang tidak membantu.

Seperti halnya EAT, gagasan "membantu" tidak dapat dengan mudah diukur dengan metrik konkret; algoritme bergantung pada pembelajaran mesin untuk mengidentifikasi konten yang tidak membantu.

SEO berpengalaman yang berspesialisasi dalam pembaruan EAT dan algoritme telah menganalisis, secara terperinci, apa yang diketahui tentang dan bagaimana bereaksi terhadap pembaruan Konten Bermanfaat. Analisis Marie Haynes, Glenn Gabe dan Lily Ray layak dibaca.

Untuk diskusi lebih lanjut, saya berbicara dengan Vincent Terrasi, Direktur Produk di Oncrawl dan pakar SEO Data dengan fokus pada pembelajaran mesin dan model bahasa seperti BERT dan GPT-3.

Wawancara dengan Vincent Terrasi

“Kami dapat mengidentifikasi konten AI murni sebagai tidak wajar, dan karena itu akan dikenakan sanksi. Namun di sisi lain, di balik gagasan Konten Bermanfaat ini, ada subjek lain yang dapat berdampak negatif pada semua alat semantik baru yang didasarkan pada SERP. Google akhirnya akan dapat mendeteksi optimasi yang berlebihan, maksud saya, seseorang yang akan merekayasa balik jejak yang sempurna untuk mendapatkan peringkat di Google.”

Analisis konten dan deteksi optimasi berlebihan: apa yang akan benar-benar berubah dari pembaruan Konten Bermanfaat

Rebecca: Saya terus memikirkan berbagai elemen pekerjaan Anda yang memenangkan tempat kedua di Tech SEO Boost 2019 di mana Anda berbicara tentang pembuatan teks untuk SEO, dampak dan bahayanya. Kami juga membahas topik tersebut, terutama ketika Google merilis BERT, berbicara tentang langkah selanjutnya dan bagaimana mereka dapat menggeneralisasi analisis teks melalui pembelajaran mesin. Dalam hal ini, semacam klasifikasi dan kemudian analisis semantik di atas itu. Apakah itu yang Anda dapatkan juga? Apakah pembaruan ini mengejutkan Anda?

Vincent: Ya, itulah yang saya umumkan di SEO Boost Tech: bahwa mereka [Google] akan mengejar jenis konten ini.

Saya terus memberi tahu klien yang tertarik dengan pembuatan teks di Oncrawl mengapa mereka harus berhati-hati dengan konten yang dihasilkan.

Anda harus berhati-hati ketika berbicara tentang konten yang dihasilkan AI (kecerdasan buatan). Dengan pembaruan Konten Bermanfaat, kami sama sekali tidak berbicara tentang tindakan manual, meskipun mungkin tampak seperti jenis hal yang akan mengarah pada tindakan manual. Anda mungkin telah melihat beberapa berita terbaru tentang situs yang dibuat dengan AI, dan saya pasti akan mengklasifikasikannya sebagai tindakan manual. Ini terjadi tiga bulan yang lalu: ada tindakan manual yang kuat di mana ada situs yang mengatakan bahwa mereka menghasilkan $100.000 per bulan. Mereka semua di-deindex. Itu adalah tindakan manual.

Sekarang, ada pembaruan ini dengan model pembelajaran mesin yang dapat mengidentifikasi apakah itu teks yang tidak bernilai tambah. Jadi saya lebih suka tidak berbicara tentang AI, tetapi tentang situs dengan atau tanpa konten yang tidak bernilai tambah.

Rebecca: Ya, ada konfirmasi dari Google bahwa ini bukan tentang tindakan manual. Sangat menarik bahwa dalam hal ini, Google dengan jelas mengatakan itu adalah pembelajaran mesin dan itu berjalan sepanjang waktu. Jadi di bulan-bulan berikutnya, situs yang terkena dampak mungkin dapat diklasifikasi ulang…atau tidak.

Vincent: Saya akan membicarakan hal ini di konferensi saya pada bulan September dengan Christian Meline di SEO Camp Paris, karena ini adalah sesuatu yang kami identifikasi lima bulan lalu. Bisakah Anda bayangkan? Kami telah mengidentifikasi bahwa ada sesuatu yang terjadi dengan Google.

Secara keseluruhan, ada dua topik:

Ada topik konten yang dihasilkan AI. Kami dapat mengatakan bahwa konten berisi spam bisa sangat mudah diidentifikasi karena AI berulang. Jika Anda memecahnya menjadi kelompok kata yang terdiri dari tiga, empat, lima kata, Anda akan melihatnya mengulangi frasa yang sama. Itu sangat mudah dideteksi. Anda tidak perlu melakukan pembelajaran mesin.

Dan di sisi lain, bagian pembelajaran mesin adalah bahwa sebenarnya ada probabilitas yang sangat stabil untuk kemunculan kata berikutnya.

Rebecca: Ya, kami juga membicarakan hal ini ketika kami mengerjakan kursus pelatihan Anda. Secara internal di Oncrawl, ini mengarah pada pekerjaan yang sedang dilakukan untuk membuat sistem penilaian kualitas teks yang dihasilkan, untuk menemukan konten yang terlalu mudah diidentifikasi.

Vinsensius: Itu benar.

Kami dapat mengidentifikasi konten AI murni sebagai tidak wajar, dan karena itu akan dikenakan sanksi. Jadi itu masalah pertama.

Namun di sisi lain, di balik gagasan Konten Bermanfaat ini, ada subjek lain yang dapat berdampak negatif pada semua alat semantik baru yang didasarkan pada SERP.

Google akhirnya akan dapat mendeteksi optimasi yang berlebihan, maksud saya, seseorang yang akan merekayasa balik jejak yang sempurna untuk mendapatkan peringkat di Google. Dan di sini kami memiliki pemain yang kuat dan berbakat di Prancis yang belum bereaksi banyak terhadap berita: Freres Peyronnet, 1.fr, SEO Quantum, dll. Mereka secara langsung prihatin dengan masalah optimasi berlebihan. Mereka secara langsung terpengaruh oleh pembaruan ini.

Rebecca: Mari kita gunakan transfer-learning.ai situs Anda yang lebih merupakan kotak pasir untuk menguji apakah kita dapat memberi peringkat dengan konten yang sepenuhnya dibuat, sambil menambahkan sesuatu yang tidak ada saat ini (dalam hal ini hubungan antara penelitian akademis dan kursus pelatihan di topik pembelajaran mesin terkait). Menurut Anda, apakah hal seperti ini masih bisa dilakukan?

Vincent: Jika itu membawa orisinalitas dan tidak terdeteksi sebagai spam, ya, itu akan selalu memungkinkan untuk melakukan hal semacam ini.

Namun, jika tidak dianggap membantu, maka itu tidak akan mungkin.

Selain itu, saya ingin memberikan pengingat yang jelas kepada pembuat konten Prancis: kita berbicara tentang bahasa Inggris. Kita tahu bahwa peluncuran dalam bahasa Inggris dapat berlangsung selama berbulan-bulan, dan seringkali setahun. Ketika kita melihat kembali Pembaruan Inti besar-besaran lama seperti Panda atau Penguin, mereka bertahan hingga beberapa tahun dalam beberapa kasus. Saya pikir beberapa orang akan memanfaatkan periode waktu ini untuk terus berlatih teknik spam. Dan kemudian Google akan campur tangan.

Apa yang akan saya diskusikan selama presentasi saya dengan Christian Meline adalah bahwa alih-alih mengusulkan topik yang sudah dimiliki Google dan tidak diminati, kami dapat menggunakan teknologi baru yang membantu kami mengusulkan topik baru.

Saya akan memberi Anda sebuah contoh. Jika saya menguji semua alat SEO dan menghasilkan ide topik dengan GPT-3, atau dalam alat bahasa Prancis seperti yourtext.guru misalnya, saya akan mendapatkan 40 ide. Jika saya menggunakan teknik Christian Meline, saya akan mendapatkan 4.500. Dan beberapa di antaranya bahkan merupakan topik yang belum pernah digunakan sebelumnya dan bahkan tidak ada di Google.

Menurut Anda, apa yang akan disukai Google? Untuk memiliki konten yang sudah diketahuinya, atau memiliki topik yang sangat menarik yang belum pernah digali siapa pun?

Saya pikir itulah masa depan SEO: mampu mendeteksi hal-hal baru. Saya tahu Koray juga menuju ke arah semantik itu.

Rebecca: Ya, dalam arti menganalisis kesenjangan konten atau kekosongan di mana Anda dapat membangun keahlian, karena area semantik dari suatu topik yang tidak dibahas sama sekali.

Vincent: Tepat sekali. Di sisi lain, saya pikir pembaruan ini tidak akan segera melakukannya. Akan ada versi 1, versi 2, dan seterusnya. Tetapi tujuan akhir dari pembaruan ini adalah untuk melakukan itu.

[Studi Kasus] Mengelola perayapan bot Google

Bahasa dan media lain: Bagaimana pembaruan ini akan diterapkan?

Rebecca: Anda tadi menyebutkan perbedaan antara bahasa Inggris dan bahasa lain seperti bahasa Prancis. Kami telah membuat langkah besar dalam penerjemahan, dalam pemrosesan bahasa-agnostik, seperti dengan MuM. Menurut Anda, apakah pembaruan ini akan memakan waktu lama untuk pindah ke bahasa lain?

Vincent: Terus terang, saya telah melakukan beberapa pekerjaan saya sendiri. Saya tidak memiliki teknologi Google, saya tidak tahu Google, tetapi saya belum pernah melihat algoritma yang membutuhkan waktu lama untuk dijalankan. Artinya, untuk satu paragraf 300 kata, dibutuhkan waktu sekitar sepuluh detik. Ini adalah keabadian. Biasanya kita berbicara tentang perhitungan TF-IDF, penyisipan kata… dan itu membutuhkan waktu beberapa detik. Dengan kata lain, jenis algoritma ini cukup berat untuk digunakan. Sekarang saya tahu bahwa Google memiliki teknologi, mereka memiliki TPU, mereka memiliki insinyur yang sangat cerdas, tetapi saya pikir mereka akan memiliki batasan ini saat menggunakan model bahasa: Anda harus memuat model bahasa. Dan ketika ada 200 miliar parameter, itu bisa menyakitkan.

Ini lucu, tepat pada waktu yang sama dengan rilis model pembuatan teks di HuggingFace. Jadi saya pikir, dan tidak ada orang yang bisa mengatakan ini dengan pasti, tapi itulah yang menjadi dasar pendeteksian mereka. Bahkan, mereka merilis model pembuatan teks untuk mendeteksi pembuatan teks. Google melawan api dengan api, seperti yang mereka katakan.

Rebecca: Ya, begitulah cara kerjanya, kan? Selalu seperti itu dalam mendeteksi teks otomatis. Kami menggunakan apa yang kami ketahui tentang cara pembuatannya untuk mendeteksinya.

Vincent: Tapi yang membuat saya terkesan adalah alat SEO yang menyediakan sidik jari SERP. Google sekarang mengatakan, "Kami memiliki jejak dan kami akan dapat mengetahui apakah Anda terlalu terinspirasi olehnya." Tidak ada yang tahu bagaimana mereka melakukannya. Saya tahu bagaimana alat SEO lain melakukannya, tetapi bagaimana mereka [Google] melakukannya? Tidak ada yang tahu.

Rebecca: Sebenarnya, hal lain yang menonjol bagi saya adalah bahwa ini adalah analisis tingkat situs dan kemudian untuk setiap situs ada, jika kita benar-benar berbicara tentang generalisasi tingkat yang sangat tinggi, "nilai" dari Konten Bermanfaat atau Tidak Membantu yang ditetapkan ke situs yang dapat memengaruhi konten lain di situs tersebut. Dan itu banyak analisis individu, dan banyak penyimpanan informasi. Jadi walaupun hanya untuk mengolah atau mengolah ulang itu, butuh banyak waktu.

Vincent: Saya pikir itu kendala yang mereka miliki. Mereka telah mengumumkan bahwa mereka hanya melakukannya di Google Penelusuran bukan Google Discover.

Ini sedikit paradoks karena di Google Discover, semua orang curang, semua orang mengoptimalkan konten "SEO" hanya untuk berada di Google Discover. Saya pikir mereka memiliki masalah besar sekarang dengan Google Penelusuran dan semua konten yang dibuat secara otomatis ini. Ada beberapa situs yang berlebihan dengan konten yang dibuat secara otomatis.

Mereka tidak berbicara tentang penalti, jadi mereka berputar seperti ini dengan Google RankBrain, sebagai sinyal baru.

Dan tidak semua situs akan terpengaruh. Saya memikirkan khususnya situs e-niaga dengan semua deskripsi produknya. Kami tahu semua orang saling meniru.

Rebecca: Ya, membuat varian berdasarkan deskripsi resmi dari produsen, merek.

Vincent: Ya.

Tetapi beberapa situs media lebih berisiko. Ada sebuah fenomena yang sudah lama dikenal dalam SEO. Misalnya, beberapa situs mengambil konten bahasa Inggris dan menerjemahkannya tanpa menambahkan nilai apa pun. Tidak ada yang membicarakannya, tetapi ada risiko besar untuk jenis situs ini karena tidak menambahkan apa pun dan di atas itu, dan mereka memiliki kekurangan untuk tidak mengutip sumbernya.

Rebecca: Dan mereka juga akan memiliki konten asli dalam bahasa Inggris untuk dijadikan perbandingan.

Vincent: Ya, tahap di mana kami beralih dari bahasa Inggris ke bahasa Prancis dengan pembaruan ini kemungkinan besar akan merugikan banyak situs spam.

Dari semua berita SEO selama beberapa bulan terakhir, ini adalah pembaruan yang paling penting. RankBrain juga, bisa kita katakan, tetapi sudah jauh lebih tidak jelas untuk ditunjukkan, sulit untuk melihat apa hasil sebenarnya dari penerapannya.

Rebecca: Menurut saya sebenarnya mendekati, dengan konsep analisis semantik dan bagian-bagian situs web yang tidak terkait dengan bagian situs web lainnya.

Vincent: Tepat sekali.

Saya tahu mereka telah mengerjakan ini untuk sementara waktu. Saya punya teman yang bekerja di Google, yang mengatakan bahwa dia telah mengerjakan ini sejak 2009; ada dua tim peneliti dalam hal ini. Mereka mencoba melakukannya sekarang secara real time dan mereka akan melakukan banyak pembersihan.

Tapi kita masih belum tahu banyak tentang implementasinya. Bagaimana mereka akan melakukannya? Dengan sinyal? Apakah mereka yang curang akan terindeks dengan kurang baik? Tidak ada yang bisa menjawab pertanyaan itu kecuali John Mueller.

Rebecca: Saya ragu dia akan diizinkan. Saya membayangkan mereka akan tetap pada baris mereka: "buat konten yang bermanfaat bagi pengguna, bukan untuk mesin pencari, dan Anda tidak akan memiliki masalah."

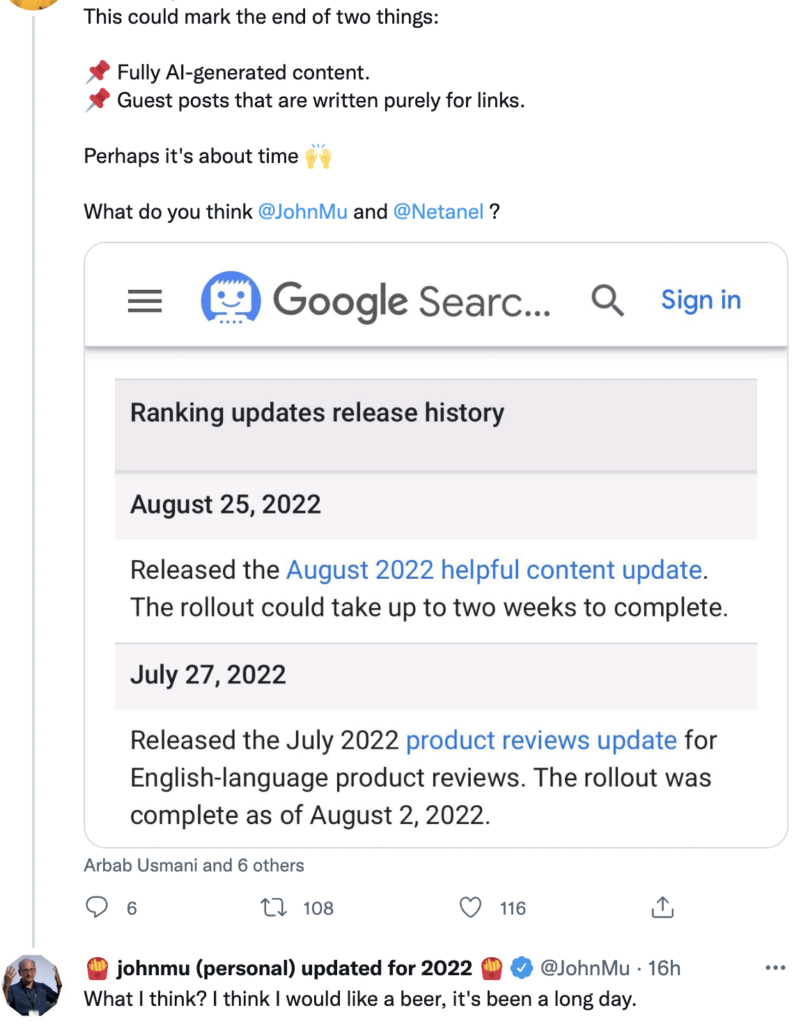

Vincent: Di Twitter, dia dibombardir dengan pertanyaan tentang topik ini dan jawabannya agak luas.

Sumber: Twitter

Dampaknya pada pembuatan konten di masa depan

Rebecca: Saya tidak terkejut dengan itu. Saya pikir dia mungkin tidak memiliki informasi yang lebih spesifik. Dan bahkan jika dia melakukannya, itu harus benar-benar dilarang untuk berbicara tentang algoritme.

Bagaimanapun, saya sangat ingin mulai melihat paten yang terkait dengan pembaruan ini, untuk melakukan analisis ulang paten dalam satu tahun, dua tahun, untuk melihat apa yang ada di luar sana dan jika ada indikasi penggunaan nanti. Tapi itu topik lain.

Vincent: Untuk mempersiapkan konferensi saya di bulan September, saya telah membuat daftar bagaimana kami mengenali konten berkualitas, konten yang bermanfaat. Saya mendasarkannya pada artikel di journaldunet (dalam bahasa Prancis) di mana Christian Meline telah menulis tentang masalah ini [tiga] tahun yang lalu. Kontennya masih sepenuhnya relevan. Di sisi lain, ia tidak bergantung pada pembelajaran mesin. Dia membencinya, jadi ini adalah metrik dasar yang berguna: apakah judulnya ditulis dengan baik? Apakah ada kesalahan ejaan? Apakah itu memberikan pengetahuan baru? Jarang hal di mana Anda akan membutuhkan pembelajaran mesin untuk melakukannya.

Rebecca: Jenis saran ini akan menjadi sangat penting karena sebagian besar SEO tidak selalu memiliki sumber daya, data, waktu, atau hanya keterampilan untuk menerapkan pembelajaran mesin, untuk dapat menganalisis situs mereka, untuk mengetahui apakah ada risiko jatuh ke dalamnya atau tidak.

Vincent: Tepat sekali. Kita harus mengikuti ini dengan sangat, sangat dekat.

Selain itu, kita harus sangat berhati-hati dengan apa yang kita katakan. Kita harus berbicara dalam conditional tense. Tidak ada seorang pun yang yakin tentang subjek ini.

Rebecca: Itu pasti. Kami hanya memiliki hal-hal tingkat yang sangat tinggi, yang berarti kami tidak memiliki bukti, tidak ada petunjuk dan tidak ada informasi. Jadi jelas semua yang bisa kita katakan tentang itu bukanlah kesimpulan, itu adalah teori.

Vincent: Tepat sekali.

Inilah yang saya siapkan sebagai titik awal:

- Analisis token untuk melihat pengulangan: mengidentifikasi kapan itu berlebihan, kapan hanya untuk peringkat.

- Kemudian, probabilitas antara kata-kata yang saya sebutkan sebelumnya.

- Dan akhirnya satu, kelompok kata.

Hanya dengan tiga kombo ini, saya dapat mendeteksi 90% teks yang dihasilkan AI yang belum dioptimalkan oleh manusia. Jadi bayangkan apa yang bisa dilakukan Google! Ini menakjubkan.

Rebecca: Jadi kami pasti harus menghadiri konferensi Kampus SEO Anda pada tanggal 23 September dengan Christian.

Vincent: Ya, kami ingin sedikit membahas topik konten yang bermanfaat. Ini lucu: bahkan sebelum Google mulai berbicara tentang pembaruan, kami sudah merencanakan ini.

Saya juga menyukai topik ini karena saya sangat berpikiran ekologis. Saya merasa lebih baik mengetahui bahwa ada kontrol seperti itu untuk mencegah orang melakukan spam. Karena itu menghabiskan sumber daya yang tak terbayangkan.

Rebecca: Ya, benar. Dengan pembaruan ini, semua orang memperhatikan dengan seksama. Saya pikir orang-orang yang berpikir itu tidak akan mengubah apa pun adalah salah. Kami dapat melihat bahwa ini tidak hanya akan mengubah cara kami membuat konten, tetapi juga cara Google mengevaluasi konten. Dan ini adalah strategi yang belum pernah kita lihat sebelumnya.

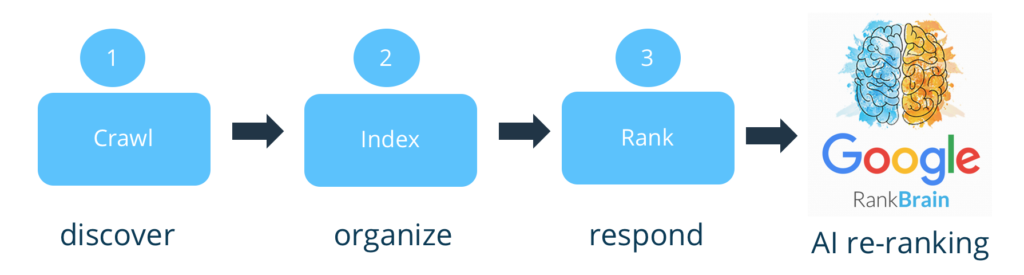

Vincent: Tepat sekali. Bahkan, jika Anda ingin mengambil sikap ekstrem, Google tidak mengevaluasi konten. Itu kelemahan besar. Dulu hanya indeks dan peringkat. Sekarang mereka akan menyaring ke hulu. Dan itulah yang Bing mengkritik Google karena tidak melakukannya.

Rebecca: Ya, sebagian besar analisis [konten] datang pada saat pemeringkatan.

Vinsensius: Itu benar. Sekarang tampaknya memiliki sedikit filter. Saya setuju dengan Anda: Saya tidak sabar untuk melihat paten yang keluar untuk ini. Mereka harus mengungkapkan di mana mereka meletakkan filter. Di mana Anda bertaruh mereka memasang filter? Sebelum, setelah pengindeksan atau sebelum, setelah peringkat? Di mana Anda akan meletakkannya?

Rebecca: Karena Anda harus memiliki sebagian besar situs untuk dapat melakukan itu, saya akan mengatakan…

Vincent: Jangan lupa bahwa Anda memerlukan jejak SERP, seperti yang telah kita diskusikan, untuk pengindeksan. Jadi, Anda harus mengindeksnya.

Rebecca: Ya, itulah yang akan saya katakan. Saya pikir itu harus menjadi langkah tambahan, kami tidak menjalankan risiko de-indexing, jadi kami berbicara tentang dampak setelah pengindeksan, mungkin setelah peringkat [awal] juga.

Vincent: Ya, bagi saya, itu setelah peringkat. Jika saya adalah Google, ini adalah sesuatu yang akan saya tambahkan ke Google RankBrain, karena ia mampu mengumpulkan sinyal, dll. Sekarang, pertanyaannya adalah seberapa besar pengaruhnya di situs.

Rebecca: Dengan pembelajaran mesin, ini dapat sangat bervariasi dari satu situs ke situs lainnya, karena Anda dapat memiliki lebih banyak kontrol atas dampaknya dan seberapa banyak konten yang tidak membantu di setiap situs.

Vincent: Batas dengan Google adalah positif palsu. Itu akan menghapus indeks [atau menghukum] halaman yang sah. Jadi saya pikir dampak awalnya akan sangat, sangat rendah, tetapi mereka benar-benar akan mengejar para penipu.

Saya memiliki orang-orang yang menghubungi saya, yang sedikit khawatir. Saya mengatakan kepada mereka bahwa pada awalnya, itu hanya akan mendeteksi teks tanpa kualitas. Artinya, saya berpikir bahwa teks [yang dihasilkan], ditindaklanjuti dengan proofreading manusia, dapat memiliki semua kegunaannya.

Saya tidak seketat orang lain yang mengatakan “AI = sampah”. Aku juga tidak begitu percaya.

Rebecca: Itu tidak mengejutkan saya, datang dari Anda!

Ini sedikit membuat frustrasi, mengetahui bahwa itu akan menjadi lambat. Seperti yang Anda katakan, untuk menghindari kesalahan positif, itulah alasan lain untuk meluncurkan dalam bahasa Inggris: mereka memiliki kemampuan bahasa Inggris yang lebih baik. Hal ini memungkinkan untuk memasukkan kontrol tambahan yang jauh lebih mahal, sebelum menggeneralisasi ke seluruh web dan ke bahasa lain yang kurang dikuasai dengan baik, kurang otomatis.

Bagaimanapun, itu adalah diskusi yang sangat kaya. Terima kasih banyak atas pertukaran ini.

Vincent: Kita bisa membicarakannya lagi kapan pun Anda mau.

Rebecca: Ini menyenangkan.