Vincent Terrasi: ความสำคัญของการอัปเดตเนื้อหาที่เป็นประโยชน์

เผยแพร่แล้ว: 2022-08-26การอัปเดตอัลกอริธึม Helpful Content คืออะไร?

เมื่อสัปดาห์ที่แล้ว Google ได้ประกาศเปิดตัวการอัปเดตอัลกอริทึมที่พยายามปรับปรุงคุณภาพของผลการค้นหาด้วยการโปรโมตเนื้อหาที่เป็นประโยชน์ซึ่งกำลังเผยแพร่อยู่ ในขั้นต้น การอัปเดตนี้จะมีผลกับเว็บไซต์ภาษาอังกฤษเท่านั้น และอาจลดคุณค่าเนื้อหาของเว็บไซต์ทั้งหมดหากเว็บไซต์มีเนื้อหาที่ไม่เป็นประโยชน์จำนวนมาก

เช่นเดียวกับ EAT แนวคิดเรื่อง "มีประโยชน์" ไม่สามารถหาปริมาณได้ง่ายด้วยเมตริกที่เป็นรูปธรรม อัลกอริทึมอาศัยการเรียนรู้ของเครื่องเพื่อระบุเนื้อหาที่ไม่ช่วยเหลือ

SEO ที่มีประสบการณ์ซึ่งเชี่ยวชาญด้าน EAT และการอัปเดตอัลกอริธึมได้วิเคราะห์โดยละเอียดแล้วถึงสิ่งที่ทราบและวิธีตอบสนองต่อการอัปเดตเนื้อหาที่เป็นประโยชน์ การวิเคราะห์โดย Marie Haynes, Glenn Gabe และ Lily Ray นั้นน่าอ่าน

ในการพูดคุยเพิ่มเติม ฉันได้พูดคุยกับ Vincent Terrasi ผู้อำนวยการฝ่ายผลิตภัณฑ์ของ Oncrawl และผู้เชี่ยวชาญด้าน Data SEO โดยเน้นที่การเรียนรู้ของเครื่องและโมเดลภาษา เช่น BERT และ GPT-3

บทสัมภาษณ์กับ Vincent Terrasi

“เราสามารถระบุเนื้อหา AI ล้วนๆ ว่าผิดธรรมชาติ ดังนั้นจึงจะถูกลงโทษ แต่ในทางกลับกัน เบื้องหลังแนวคิดเรื่องเนื้อหาที่มีประโยชน์นี้มีอีกเรื่องหนึ่งที่อาจส่งผลเสียต่อเครื่องมือเชิงความหมายใหม่ทั้งหมดซึ่งอิงตาม SERP ในที่สุด Google ก็จะสามารถตรวจจับการเพิ่มประสิทธิภาพที่มากเกินไปได้ ฉันหมายถึงคนที่จะทำวิศวกรรมย้อนรอยรอยเท้าที่สมบูรณ์แบบเพื่อจัดอันดับใน Google”

การวิเคราะห์เนื้อหาและการตรวจจับการเพิ่มประสิทธิภาพเกิน: สิ่งที่การอัปเดตเนื้อหาที่เป็นประโยชน์จะเปลี่ยนไปจริงๆ

รีเบคก้า: ฉันเอาแต่นึกถึงองค์ประกอบต่างๆ ในงานของคุณที่คว้าอันดับสองที่ Tech SEO Boost 2019 ที่คุณพูดถึงการสร้างข้อความสำหรับ SEO ผลกระทบและอันตราย เรายังได้พูดคุยกันในหัวข้อนี้ โดยเฉพาะอย่างยิ่งเมื่อ Google เปิดตัว BERT โดยพูดถึงขั้นตอนต่อไปและวิธีที่พวกเขาสามารถสรุปการวิเคราะห์ข้อความผ่านการเรียนรู้ของเครื่อง ในกรณีนี้ มันเหมือนกับการจำแนกประเภทและการวิเคราะห์เชิงความหมาย นั่นคือสิ่งที่คุณได้รับจากมันเช่นกัน? การอัปเดตนี้ทำให้คุณประหลาดใจไหม

Vincent: ใช่ นั่นคือสิ่งที่ฉันได้ประกาศที่ SEO Boost Tech: พวกเขา [Google] กำลังจะติดตามเนื้อหาประเภทนี้

ฉันคอยบอกลูกค้าที่สนใจในการสร้างข้อความที่ Oncrawl ว่าทำไมพวกเขาถึงต้องระมัดระวังกับเนื้อหาที่สร้างขึ้น

คุณต้องระวังเมื่อพูดถึงเนื้อหาที่สร้างโดย AI (ปัญญาประดิษฐ์) ด้วยการอัปเดตเนื้อหาที่เป็นประโยชน์ เราไม่ได้พูดถึงการดำเนินการโดยเจ้าหน้าที่เลย แม้ว่าจะดูเหมือนเป็นประเภทของสิ่งที่จะนำไปสู่การดำเนินการโดยเจ้าหน้าที่ก็ตาม คุณอาจเคยเห็นข่าวล่าสุดเกี่ยวกับไซต์ที่สร้างโดย AI และฉันจะจัดประเภทนั้นเป็นการดำเนินการโดยเจ้าหน้าที่อย่างแน่นอน เมื่อสามเดือนที่แล้ว มีการดำเนินการโดยเจ้าหน้าที่ที่เข้มงวดซึ่งมีไซต์ที่ระบุว่าพวกเขาทำเงินได้ 100,000 ดอลลาร์ต่อเดือน พวกเขาทั้งหมดถูก deindexed นั่นคือการดำเนินการโดยเจ้าหน้าที่

ขณะนี้ มีการอัปเดตนี้ด้วยโมเดลการเรียนรู้ของเครื่องที่สามารถระบุได้ว่าไม่ใช่ข้อความที่เพิ่มมูลค่าหรือไม่ ดังนั้น ฉันไม่อยากพูดถึง AI แต่เกี่ยวกับไซต์ที่มีหรือไม่มีเนื้อหาที่ไม่เพิ่มมูลค่า

รีเบคก้า: ใช่ มีคำยืนยันจาก Google ว่าไม่เกี่ยวกับการดำเนินการโดยเจ้าหน้าที่ เป็นเรื่องที่น่าสนใจที่ในกรณีนี้ Google พูดอย่างชัดเจนว่าเป็นการเรียนรู้ของเครื่องและทำงานอยู่ตลอดเวลา ดังนั้นในเดือนต่อๆ ไป ไซต์ที่ได้รับผลกระทบอาจถูกจัดประเภทใหม่…หรือไม่

Vincent: ฉันจะพูดถึงเรื่องนี้ในการประชุมของฉันในเดือนกันยายนกับ Christian Meline ที่ SEO Camp Paris เพราะเป็นสิ่งที่เราระบุเมื่อห้าเดือนที่แล้ว คุณสามารถจินตนาการ? เราได้ระบุแล้วว่ามีหลายสิ่งที่เกิดขึ้นกับ Google

โดยรวมมีสองหัวข้อ:

มีหัวข้อของเนื้อหาที่สร้างโดย AI เราสามารถพูดได้ว่าเนื้อหาที่เป็นสแปมนั้นสามารถระบุได้ง่ายมากเพราะ AI ทำซ้ำตัวเอง หากคุณแบ่งคำออกเป็นกลุ่มคำที่มีสาม สี่ หรือห้าคำ คุณจะเห็นว่าคำนั้นซ้ำวลีเดียวกัน ที่ตรวจจับได้ง่ายมาก คุณไม่จำเป็นต้องทำแมชชีนเลิร์นนิง

และในทางกลับกัน ส่วนการเรียนรู้ของเครื่องก็คือ ในความเป็นจริงแล้ว มีความน่าจะเป็นที่คงที่มากของคำถัดไปที่ปรากฏ

รีเบคก้า: ใช่ เรายังพูดถึงเรื่องนี้ตอนที่เรากำลังทำหลักสูตรฝึกอบรมของคุณอยู่ ภายในที่ Oncrawl สิ่งนี้นำไปสู่งานที่กำลังดำเนินการเพื่อสร้างระบบการให้คะแนนสำหรับคุณภาพของข้อความที่สร้างขึ้น เพื่อค้นหาเนื้อหาที่สามารถระบุได้ง่ายเกินไปเช่นนี้

วินเซนต์: ถูกต้อง

เราสามารถระบุเนื้อหา AI ล้วนๆ ว่าผิดธรรมชาติ ดังนั้นจึงจะถูกลงโทษ นั่นคือประเด็นแรก

แต่ในทางกลับกัน เบื้องหลังแนวคิดเรื่องเนื้อหาที่มีประโยชน์นี้มีอีกเรื่องหนึ่งที่อาจส่งผลเสียต่อเครื่องมือเชิงความหมายใหม่ทั้งหมดซึ่งอิงตาม SERP

ในที่สุด Google ก็จะสามารถตรวจจับการเพิ่มประสิทธิภาพที่มากเกินไปได้ ฉันหมายถึงใครบางคนที่จะทำวิศวกรรมย้อนรอยรอยเท้าที่สมบูรณ์แบบเพื่อจัดอันดับใน Google และที่นี่ เรามีผู้เล่นที่แข็งแกร่งและมีความสามารถในฝรั่งเศสซึ่งยังไม่ได้ตอบสนองต่อข่าวนี้มากนัก: Freres Peyronnet, 1.fr, SEO Quantum เป็นต้น พวกเขากังวลโดยตรงเกี่ยวกับปัญหาการเพิ่มประสิทธิภาพที่มากเกินไป พวกเขาจะได้รับผลกระทบโดยตรงจากการปรับปรุงนี้

รีเบคก้า: ลองใช้ไซต์ของคุณ transfer-learning.ai ซึ่งเป็นแซนด์บ็อกซ์มากกว่าเพื่อทดสอบว่าเราสามารถจัดอันดับด้วยเนื้อหาที่สร้างขึ้นทั้งหมดได้หรือไม่ ในขณะที่เพิ่มบางสิ่งที่ไม่มีอยู่ในปัจจุบัน (ในกรณีนี้คือความเชื่อมโยงระหว่างการวิจัยเชิงวิชาการและหลักสูตรฝึกอบรมเกี่ยวกับ หัวข้อแมชชีนเลิร์นนิงที่เกี่ยวข้อง) ในความเห็นของคุณ ยังทำเรื่องแบบนี้ได้อยู่ไหม?

Vincent: ถ้ามันทำให้เกิดความคิดริเริ่มและไม่ถูกตรวจพบว่าเป็นสแปม ใช่ มันเป็นไปได้ที่จะทำสิ่งนี้เสมอ

อย่างไรก็ตาม หากเห็นว่าไม่เป็นประโยชน์ ก็ไม่สามารถทำได้

นอกจากนี้ ฉันต้องการเตือนครีเอเตอร์ชาวฝรั่งเศสอย่างชัดเจนว่า เรากำลังพูดถึงภาษาอังกฤษ เรารู้ว่าการเปิดตัวเป็นภาษาอังกฤษอาจใช้เวลานานหลายเดือนและบ่อยครั้งเป็นปี เมื่อเรามองย้อนกลับไปที่ Core Updates รุ่นเก่าๆ อย่าง Panda หรือ Penguin การอัปเดตนั้นใช้เวลานานถึงหลายปีในบางกรณี ฉันคิดว่าบางคนจะใช้ประโยชน์จากช่วงเวลานี้เพื่อฝึกฝนเทคนิคสแปมต่อไป จากนั้น Google จะเข้าไปแทรกแซง

สิ่งที่ฉันจะพูดคุยระหว่างนำเสนอกับ Christian Meline คือแทนที่จะเสนอหัวข้อที่ Google มีอยู่แล้วและไม่สนใจ เราสามารถใช้เทคโนโลยีใหม่ที่ช่วยให้เราเสนอหัวข้อใหม่ได้

ฉันจะให้ตัวอย่าง ถ้าฉันทดสอบเครื่องมือ SEO ทั้งหมดและสร้างแนวคิดหัวข้อด้วย GPT-3 หรือในเครื่องมือภาษาฝรั่งเศส เช่น yourtext.guru ฉันจะได้รับ 40 แนวคิด ถ้าฉันใช้เทคนิคของ Christian Meline ฉันจะได้ 4,500 และบางหัวข้อก็เป็นหัวข้อที่ไม่เคยใช้มาก่อนและไม่ได้อยู่ใน Google ด้วยซ้ำ

คุณคิดว่า Google จะชอบอะไรมากกว่ากัน? มีเนื้อหาที่รู้อยู่แล้วหรือมีหัวข้อที่น่าสนใจมากที่ไม่มีใครเคยขุดมา?

ฉันคิดว่านั่นคืออนาคตของ SEO: ความสามารถในการตรวจจับสิ่งใหม่ ฉันรู้ว่าโคเรย์กำลังไปในทิศทางนั้นด้วย

รีเบคก้า: ใช่ ในแง่ของการวิเคราะห์ช่องว่างของเนื้อหาหรือช่องว่างที่คุณสามารถสร้างความเชี่ยวชาญได้ เนื่องจากเป็นพื้นที่เชิงความหมายของหัวข้อที่ไม่ได้กล่าวถึงเลย

วินเซนต์: ถูกต้อง ในทางกลับกัน ฉันคิดว่าการอัปเดตนี้จะไม่เกิดขึ้นทันที จะมีรุ่น 1 รุ่น 2 และอื่นๆ แต่เป้าหมายสูงสุดของการอัปเดตนี้คือการทำเช่นนั้น

[กรณีศึกษา] การจัดการการรวบรวมข้อมูลบอทของ Google

ภาษาอื่นและสื่ออื่น ๆ: การอัปเดตนี้จะถูกปรับใช้อย่างไร?

รีเบคก้า: คุณพูดถึงความแตกต่างระหว่างภาษาอังกฤษกับภาษาอื่นๆ เช่น ภาษาฝรั่งเศสก่อนหน้านี้ เรามีความก้าวหน้าอย่างมากในด้านการแปล การประมวลผลแบบไม่เชื่อเรื่องภาษา เช่นเดียวกับ MuM คุณคิดว่าจะใช้เวลานานมากในการย้ายการอัปเดตนี้ไปยังภาษาอื่นๆ หรือไม่

Vincent: ตรงไปตรงมา ฉันทำงานบางอย่างด้วยตัวเอง ฉันไม่มีเทคโนโลยีของ Google ฉันไม่รู้จัก Google แต่ฉันไม่เคยเห็นอัลกอริทึมที่ใช้เวลานานขนาดนี้มาก่อน นั่นหมายความว่าในย่อหน้า 300 คำ จะใช้เวลาประมาณสิบวินาที มันเป็นนิรันดร์ โดยปกติเรากำลังพูดถึงการคำนวณ TF-IDF การฝังคำ... และใช้เวลาสักครู่ กล่าวอีกนัยหนึ่ง อัลกอริทึมประเภทนี้ค่อนข้างหนักในการปรับใช้ ตอนนี้ฉันรู้แล้วว่า Google มีเทคโนโลยี พวกเขามี TPU พวกเขามีวิศวกรที่ชาญฉลาด แต่ฉันคิดว่าพวกเขาจะมีข้อจำกัดนี้เมื่อใช้โมเดลภาษา คุณต้องโหลดโมเดลภาษา และเมื่อมีพารามิเตอร์ 2 แสนล้านพารามิเตอร์ ก็สามารถทำร้ายได้

ตลกดี มันเป็นช่วงเวลาเดียวกับการเปิดตัวโมเดลการสร้างข้อความบน HuggingFace ดังนั้นฉันคิดว่า และไม่มีใครสามารถพูดแบบนี้ได้อย่างแน่นอน แต่นั่นคือสิ่งที่พวกเขาตรวจจับได้ อันที่จริง พวกเขาเปิดตัวโมเดลการสร้างข้อความเพื่อตรวจจับการสร้างข้อความ Google กำลังต่อสู้กับไฟอย่างที่พวกเขาพูด

รีเบคก้า: ใช่ นั่นเป็นวิธีการทำงานใช่ไหม การตรวจจับข้อความอัตโนมัติก็เป็นเช่นนั้นเสมอมา เราใช้สิ่งที่เรารู้เกี่ยวกับวิธีที่มันสร้างขึ้นเพื่อตรวจจับ

Vincent: แต่สิ่งที่ทำให้ฉันประทับใจคือเครื่องมือ SEO ที่ให้ข้อมูลลายนิ้วมือของ SERP Google กำลังพูดว่า "เรามีรอยเท้าและเราจะสามารถบอกได้ว่าคุณได้รับแรงบันดาลใจมากเกินไปหรือไม่" ไม่มีใครรู้ว่าพวกเขาทำอย่างไร ฉันรู้ว่าเครื่องมือ SEO อื่นๆ ทำอย่างไร แต่พวกเขา [Google] ทำอย่างไร ไม่มีใครรู้ว่า.

รีเบคก้า: อันที่จริง อีกสิ่งหนึ่งที่โดดเด่นสำหรับฉันคือเป็นการวิเคราะห์ระดับไซต์ และสำหรับแต่ละไซต์ ถ้าเรากำลังพูดถึงการวางนัยทั่วไปในระดับสูงจริงๆ "คุณค่า" ของเนื้อหาที่เป็นประโยชน์หรือไม่ช่วยเหลือ กับไซต์ที่อาจส่งผลต่อเนื้อหาอื่นบนไซต์นั้น และนั่นเป็นการวิเคราะห์รายบุคคลจำนวนมาก และการจัดเก็บข้อมูลจำนวนมาก ดังนั้นแม้เพียงการประมวลผลหรือประมวลผลใหม่ก็ต้องใช้เวลามาก

Vincent: ฉันคิดว่านั่นเป็นข้อจำกัดที่พวกเขามี พวกเขาได้ประกาศว่าพวกเขากำลังดำเนินการบน Google Search เท่านั้น ไม่ใช่ Google Discover

ค่อนข้างขัดแย้งเพราะใน Google Discover ทุกคนโกง ทุกคนปรับเนื้อหา "SEO" ให้เหมาะสมเพื่อให้อยู่ใน Google Discover ฉันคิดว่าตอนนี้พวกเขามีปัญหาใหญ่กับ Google Search และเนื้อหาที่สร้างขึ้นโดยอัตโนมัติทั้งหมด มีบางไซต์ที่มีเนื้อหาที่สร้างขึ้นโดยอัตโนมัติ

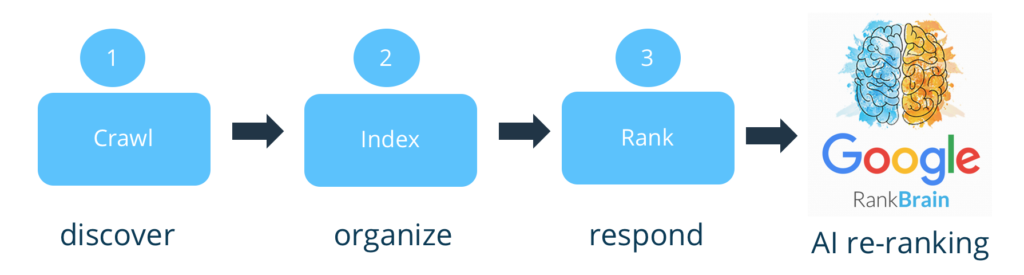

พวกเขาไม่ได้พูดถึงจุดโทษ ดังนั้นพวกเขากำลังหมุนสิ่งนี้เหมือนกับ Google RankBrain เป็นสัญญาณใหม่

และไม่ใช่ทุกไซต์จะได้รับผลกระทบ ฉันกำลังนึกถึงไซต์อีคอมเมิร์ซโดยเฉพาะที่มีคำอธิบายผลิตภัณฑ์ทั้งหมด เรารู้ว่าทุกคนลอกเลียนกัน

รีเบคก้า: ใช่ การสร้างตัวแปรตามคำอธิบายอย่างเป็นทางการของผู้ผลิต แบรนด์ต่างๆ

วินเซนต์: ใช่

แต่ไซต์สื่อบางแห่งมีความเสี่ยงมากกว่า มีปรากฎการณ์ที่เป็นที่รู้จักในวงการ SEO มาอย่างยาวนาน ตัวอย่างเช่น บางไซต์ใช้เนื้อหาภาษาอังกฤษและแปลโดยไม่เพิ่มคุณค่าใดๆ ไม่มีใครพูดถึงมัน แต่มีความเสี่ยงที่สำคัญสำหรับไซต์ประเภทนี้เนื่องจากไม่ได้เพิ่มอะไรและยิ่งไปกว่านั้น และพวกเขาก็มีข้อบกพร่องในการไม่อ้างอิงแหล่งที่มา

รีเบคก้า: และพวกเขาก็มีเนื้อหาต้นฉบับเป็นภาษาอังกฤษเพื่อเปรียบเทียบด้วยเช่นกัน

Vincent: ใช่ ขั้นตอนที่เราเปลี่ยนจากภาษาอังกฤษเป็นภาษาฝรั่งเศสในการอัปเดตนี้ มีแนวโน้มว่าจะส่งผลกระทบต่อไซต์สแปมหลายแห่ง

จากข่าว SEO ทั้งหมดในช่วงหลายเดือนที่ผ่านมา นี่คือการอัปเดตที่สำคัญที่สุด RankBrain เช่นกัน เราสามารถพูดได้ แต่มันไม่ค่อยชัดเจนนักที่จะชี้ให้เห็น ยากที่จะดูว่าผลลัพธ์ที่แท้จริงของแอปพลิเคชันคืออะไร

รีเบคก้า: ฉันคิดว่ามันใกล้เคียงกันจริงๆ ด้วยแนวคิดของการวิเคราะห์เชิงความหมายและส่วนต่างๆ ของเว็บไซต์ที่ไม่เกี่ยวข้องกับส่วนที่เหลือของเว็บไซต์

วินเซนต์: ถูกต้อง

ฉันรู้ว่าพวกเขาทำงานเรื่องนี้มาระยะหนึ่งแล้ว ฉันมีเพื่อนที่ทำงานที่ Google ซึ่งบอกว่าเขาทำงานนี้มาตั้งแต่ปี 2009; มีสองทีมวิจัยเกี่ยวกับเรื่องนี้ ตอนนี้พวกเขากำลังพยายามทำแบบเรียลไทม์ และพวกเขากำลังจะทำการล้างข้อมูลจำนวนมาก

แต่เรายังไม่รู้อะไรมากเกี่ยวกับการนำไปปฏิบัติ พวกเขาจะทำอย่างไร? ด้วยสัญญาณ? คนที่โกงจะถูกจัดทำดัชนีน้อยลงหรือไม่? คำถามนั้นไม่มีใครตอบได้นอกจากจอห์น มูลเลอร์

รีเบคก้า: ฉันสงสัยว่าแม้เขาจะได้รับอนุญาต ฉันคิดว่าพวกเขาจะคงไว้ซึ่ง: "สร้างเนื้อหาที่มีประโยชน์สำหรับผู้ใช้ ไม่ใช่สำหรับเครื่องมือค้นหา และคุณจะไม่มีปัญหา"

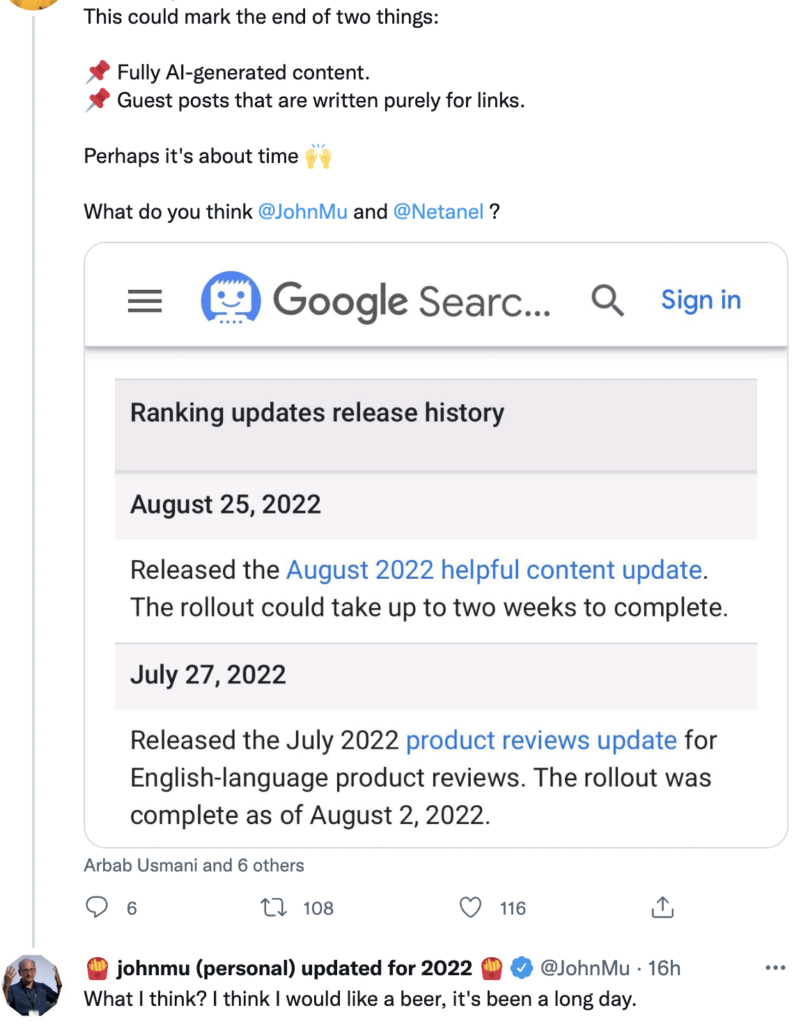

Vincent: บน Twitter เขาถูกระดมยิงด้วยคำถามเกี่ยวกับหัวข้อนี้ และคำตอบของเขาก็ค่อนข้างกว้าง

ที่มา: Twitter

ผลกระทบต่อการสร้างเนื้อหาในอนาคต

รีเบคก้า: ฉันไม่แปลกใจเลย ฉันคิดว่าเขาอาจไม่มีข้อมูลเฉพาะเจาะจงมากกว่านี้ และถึงแม้เขาจะทำเช่นนั้น ก็ต้องห้ามพูดเกี่ยวกับอัลกอริธึมโดยเด็ดขาด

อย่างไรก็ตาม ฉันกังวลมากที่จะเริ่มเห็นสิทธิบัตรที่เกี่ยวข้องกับการอัปเดตนี้ เพื่อวิเคราะห์สิทธิบัตรอีกครั้งในหนึ่งปี สองปี เพื่อดูว่ามีอะไรเกิดขึ้นบ้าง และหากมีข้อบ่งชี้ในการใช้งานในภายหลัง แต่นั่นเป็นอีกหัวข้อหนึ่ง

Vincent: เพื่อเตรียมพร้อมสำหรับการประชุมในเดือนกันยายน ฉันได้ระบุวิธีที่เราตระหนักถึงเนื้อหาที่มีคุณภาพ เนื้อหาที่มีประโยชน์ ฉันอ้างอิงจากบทความในวารสาร dunet (ภาษาฝรั่งเศส) ที่ Christian Meline เขียนเกี่ยวกับเรื่องนี้เมื่อ [สาม] ปีที่แล้ว เนื้อหาของเขายังคงมีความเกี่ยวข้องอย่างสมบูรณ์ ในทางกลับกัน เขาไม่ได้พึ่งพาการเรียนรู้ของเครื่อง เขาเกลียดมัน ดังนั้นสิ่งเหล่านี้จึงเป็นตัวชี้วัดพื้นฐานที่มีประโยชน์: ชื่อเรื่องนั้นเขียนได้ดีหรือไม่? มีการสะกดผิดหรือไม่? มันให้ความรู้ใหม่หรือไม่? สิ่งที่คุณต้องใช้แมชชีนเลิร์นนิงทำได้ยาก

รีเบคก้า: คำแนะนำประเภทนี้จะมีความสำคัญอย่างยิ่งเพราะ SEO ส่วนใหญ่ไม่จำเป็นต้องมีทรัพยากร ข้อมูล เวลา หรือเพียงแค่ทักษะในการดำเนินการแมชชีนเลิร์นนิง เพื่อให้สามารถวิเคราะห์ไซต์ของตนได้ เพื่อให้ทราบว่ามี เสี่ยงที่จะตกลงไปในนั้นหรือไม่

วินเซนต์: ถูกต้อง เราต้องติดตามเรื่องนี้อย่างใกล้ชิด

นอกจากนี้เราต้องระวังให้มากเกี่ยวกับสิ่งที่เราพูด เราต้องพูดในกาลเงื่อนไข ไม่มีใครแน่ใจเกี่ยวกับเรื่องนี้

รีเบคก้า: แน่นอน เรามีเพียงสิ่งที่ระดับสูงเท่านั้น ซึ่งหมายความว่าเราไม่มีหลักฐาน ไม่มีเบาะแส และไม่มีข้อมูล ชัดเจนว่าทั้งหมดที่เราสามารถพูดเกี่ยวกับเรื่องนี้ไม่ใช่ข้อสรุป แต่เป็นทฤษฎี

วินเซนต์: ถูกต้อง

นี่คือสิ่งที่ฉันตั้งเป็นจุดเริ่มต้น:

- การวิเคราะห์โทเค็นเพื่อดูการทำซ้ำ: ระบุว่าเมื่อใดที่มากเกินไป เมื่อใดเพียงเพื่อจัดอันดับ

- แล้วความน่าจะเป็นระหว่างคำที่ผมกล่าวถึงก่อนหน้านี้

- และสุดท้าย หนึ่งกลุ่มคำ

ด้วยคอมโบทั้งสามนี้ ฉันสามารถตรวจจับ 90% ของข้อความที่สร้างโดย AI ที่มนุษย์ไม่ได้ปรับให้เหมาะสม ลองนึกภาพว่า Google ทำอะไรได้บ้าง! มันเหลือเชื่อ

Rebecca: ดังนั้น เราควรเข้าร่วมการประชุม SEO Campus ของคุณในวันที่ 23 กันยายนกับ Christian

Vincent: ใช่ เราต้องการแยกหัวข้อของเนื้อหาที่เป็นประโยชน์ออกเล็กน้อย เป็นเรื่องตลก ก่อนที่ Google จะเริ่มพูดถึงการอัปเดต เราได้วางแผนไว้แล้ว

ฉันยังชอบหัวข้อนี้เพราะฉันมีความคิดเชิงนิเวศน์มาก มันทำให้ฉันรู้สึกดีขึ้นที่รู้ว่ามีการควบคุมแบบนั้นเพื่อป้องกันไม่ให้ผู้คนส่งสแปม เพราะมันทำให้เราใช้ทรัพยากรที่ไม่คาดคิด

รีเบคก้า: ใช่ มันเป็นเช่นนั้น ด้วยการอัปเดตนี้ ทุกคนให้ความสนใจอย่างใกล้ชิด ฉันคิดว่าคนที่คิดว่ามันจะไม่เปลี่ยนแปลงอะไรผิด เราจะเห็นได้ว่าการเปลี่ยนแปลงไม่เพียงแต่วิธีการสร้างเนื้อหาเท่านั้น แต่ยังรวมถึงวิธีที่ Google ประเมินเนื้อหาด้วย และนี่คือกลยุทธ์ที่เราไม่เคยเห็นมาก่อน

วินเซนต์: ถูกต้อง ที่จริงแล้ว หากคุณต้องการแสดงจุดยืนที่รุนแรง Google จะไม่ประเมินเนื้อหา นั่นเป็นจุดอ่อนที่ยิ่งใหญ่ ใช้เพื่อจัดทำดัชนีและอันดับเท่านั้น ตอนนี้พวกเขาจะกรองต้นน้ำ และนั่นคือสิ่งที่ Bing วิจารณ์ว่า Google ไม่ได้ทำ

รีเบคก้า: ใช่ การวิเคราะห์ส่วนใหญ่ [เกี่ยวกับเนื้อหา] มาในช่วงเวลาของการจัดอันดับ

วินเซนต์: ถูกต้อง ตอนนี้ดูเหมือนว่าจะมีตัวกรองเล็กน้อย ฉันเห็นด้วยกับคุณ: ฉันไม่สามารถรอที่จะเห็นสิทธิบัตรที่ออกมาในเรื่องนี้ พวกเขาจะต้องเปิดเผยว่าพวกเขาวางตัวกรองไว้ที่ไหน คุณเดิมพันที่พวกเขาใส่ตัวกรองที่ไหน? ก่อน หลัง ดัชนี หรือ ก่อน หลัง อันดับ? คุณจะวางมันไว้ที่ไหน?

รีเบคก้า: เนื่องจากคุณต้องมีไซต์ส่วนใหญ่จึงจะทำได้ ฉันจะบอกว่า...

Vincent: อย่าลืมว่าคุณต้องการรอยเท้าของ SERPs ตามที่เราพูดถึง สำหรับการจัดทำดัชนี ดังนั้นคุณต้องจัดทำดัชนี

รีเบคก้า: ใช่ นั่นคือสิ่งที่ฉันจะพูด ฉันคิดว่ามันควรจะเป็นขั้นตอนเพิ่มเติม เราไม่เสี่ยงที่จะยกเลิกการจัดทำดัชนี เรากำลังพูดถึงผลกระทบหลังจากการจัดทำดัชนี บางทีอาจหลังจากการจัดอันดับ [เริ่มต้น] เช่นกัน

Vincent: ใช่ สำหรับฉัน มันอยู่หลังการจัดอันดับ ถ้าฉันเป็น Google นี่คือสิ่งที่ฉันจะเพิ่มใน Google RankBrain เพราะมันสามารถรวมสัญญาณ ฯลฯ ได้ ตอนนี้คำถามก็คือว่ามันจะส่งผลอย่างไรกับไซต์ต่างๆ

รีเบคก้า: ด้วยแมชชีนเลิร์นนิง การเรียนรู้อาจแตกต่างกันมากในแต่ละไซต์ เนื่องจากคุณสามารถควบคุมผลกระทบของมันได้มากขึ้น และเนื้อหาที่ไม่ช่วยเหลือในแต่ละไซต์มีมากน้อยเพียงใด

Vincent: ขีดจำกัดของ Google นั้นเป็นผลบวกที่ผิดพลาด นั่นจะเป็นการยกเลิกการจัดทำดัชนี [หรือลงโทษ] หน้าที่ถูกต้องตามกฎหมาย ดังนั้นฉันคิดว่าผลกระทบเริ่มแรกจะน้อยมาก แต่พวกเขาจะไล่ตามคนขี้โกงจริงๆ

มีคนติดต่อมาบ้างแล้ว กังวลนิดหน่อย ฉันบอกพวกเขาว่าในตอนแรกจะตรวจจับเฉพาะข้อความที่ไม่มีคุณภาพ นั่นคือ ฉันคิดว่าข้อความ [ที่สร้างขึ้น] ตามด้วยการตรวจทานโดยมนุษย์ มีประโยชน์ทั้งหมด

ฉันไม่เข้มงวดเหมือนคนอื่นที่พูดว่า "AI = ขยะ" ฉันไม่เชื่ออย่างนั้นจริงๆ

รีเบคก้า: ฉันไม่แปลกใจเลยที่มาจากคุณ!

มันน่าหงุดหงิดเล็กน้อยที่รู้ว่ามันจะช้า อย่างที่คุณพูด เพื่อหลีกเลี่ยงผลบวกลวง นั่นเป็นอีกเหตุผลหนึ่งที่เปิดตัวเป็นภาษาอังกฤษ: พวกเขาสามารถใช้ภาษาอังกฤษได้ดีกว่า ซึ่งทำให้เป็นไปได้ที่จะใส่การควบคุมเพิ่มเติมที่มีราคาแพงกว่ามาก ก่อนสรุปไปยังทั้งเว็บและภาษาอื่นๆ ที่ไม่ค่อยเชี่ยวชาญ การทำงานอัตโนมัติไม่ค่อยดี

ไม่ว่าในกรณีใดมันเป็นการสนทนาที่เข้มข้นมาก ขอบคุณมากสำหรับการแลกเปลี่ยนนี้

Vincent: เราสามารถพูดคุยเรื่องนี้ได้อีกครั้งเมื่อคุณต้องการ

รีเบคก้า: เป็นเรื่องน่ายินดี