Vincent Terrasi : L'importance de la mise à jour du contenu utile

Publié: 2022-08-26Qu'est-ce que la mise à jour de l'algorithme de contenu utile ?

La semaine dernière, Google a annoncé la publication d'une mise à jour de l'algorithme qui vise à améliorer la qualité des résultats de recherche en faisant la promotion du contenu utile, qui est actuellement en cours de publication. Cette mise à jour ne s'appliquera initialement qu'aux sites Web de langue anglaise et peut dévaluer le contenu de l'ensemble du site si le site contient une quantité importante de contenu inutile.

Comme pour EAT, la notion d'« utile » ne peut pas être facilement quantifiée par des mesures concrètes ; l'algorithme s'appuie sur l'apprentissage automatique pour identifier le contenu inutile.

Des référenceurs expérimentés spécialisés dans les mises à jour d'EAT et d'algorithmes ont déjà analysé en détail ce que l'on sait et comment réagir à la mise à jour du contenu utile. Les analyses de Marie Haynes, Glenn Gabe et Lily Ray valent la peine d'être lues.

Pour approfondir la discussion, j'ai parlé avec Vincent Terrasi, directeur produit chez Oncrawl et expert en référencement de données avec un accent sur l'apprentissage automatique et les modèles de langage comme BERT et GPT-3.

L'entretien avec Vincent Terrasi

"Nous pouvons identifier le contenu purement IA comme non naturel, et donc il sera pénalisé. Mais en revanche, derrière cette notion de Helpful Content, il y a un autre sujet qui peut impacter négativement tous les nouveaux outils sémantiques qui se basent sur les SERPs. Google va enfin être en mesure de détecter une sur-optimisation, je veux dire, quelqu'un qui procéderait à la rétro-ingénierie de l'empreinte parfaite pour se classer dans Google.

Analyse de contenu et détection de sur-optimisation : ce que la mise à jour Helpful Content va vraiment changer

Rebecca : Je pense sans cesse à divers éléments de votre travail qui ont remporté la deuxième place au Tech SEO Boost 2019 où vous avez parlé de la génération de texte pour le référencement, des impacts et des dangers. Nous avons également discuté du sujet, en particulier lorsque Google a publié BERT, en parlant des prochaines étapes et de la manière dont ils pourraient généraliser l'analyse de texte grâce à l'apprentissage automatique. Dans ce cas, c'est un peu comme une classification, puis une analyse sémantique en plus de cela. C'est à peu près ce que vous en retirez aussi ? Cette mise à jour vous surprend-elle ?

Vincent : Oui, c'est ce que j'ai annoncé au SEO Boost Tech : qu'ils [Google] allaient s'en prendre à ce type de contenu.

Je n'arrête pas de dire aux clients qui s'intéressent à la génération de texte chez Oncrawl pourquoi ils doivent être prudents avec le contenu généré.

Vous devez être prudent lorsque vous parlez de contenu généré par l'IA (intelligence artificielle). Avec la mise à jour du contenu utile, nous ne parlons pas du tout d'une action manuelle, même si cela peut sembler être le genre de chose qui conduirait à une action manuelle. Vous avez peut-être vu certaines des nouvelles récentes sur les sites générés par l'IA, et je classerais certainement cela comme une action manuelle. C'était il y a trois mois : il y avait de fortes actions manuelles où certains sites disaient qu'ils gagnaient 100 000 $ par mois. Ils ont tous été désindexés. Ce sont des actions manuelles.

Maintenant, il y a cette mise à jour avec un modèle d'apprentissage automatique qui est capable d'identifier s'il s'agit de texte sans valeur ajoutée. Alors je préfère ne pas parler d'IA, mais de sites avec ou sans contenu sans valeur ajoutée.

Rebecca : Oui, il y a une confirmation de Google qu'il ne s'agit pas d'actions manuelles. Il est intéressant de noter que dans ce cas, Google dit clairement qu'il s'agit d'apprentissage automatique et qu'il fonctionne à peu près tout le temps. Ainsi dans les mois suivants, un site impacté pourra éventuellement être reclassé… ou pas.

Vincent : Je vais en parler lors de ma conférence en septembre avec Christian Meline au SEO Camp Paris, car c'est quelque chose que nous avons identifié il y a cinq mois. Peux-tu imaginer? Nous avions déjà identifié qu'il se passait des choses avec Google.

Globalement, il y a deux sujets :

Il y a le sujet du contenu généré par l'IA. On peut dire que le contenu spammé peut être très facile à identifier car l'IA se répète. Si vous le décomposez en groupes de mots de trois, quatre, cinq mots, vous verrez qu'il répète les mêmes phrases. C'est très facile à détecter. Vous n'avez pas besoin de faire du machine learning.

Et d'autre part, la partie machine learning c'est qu'il y a en fait des probabilités très stables d'apparition du mot suivant.

Rebecca : Oui, on en parlait aussi quand on travaillait sur vos formations. En interne chez Oncrawl, cela a conduit au travail actuellement en cours pour créer un système de notation de la qualité des textes générés, afin de trouver des contenus trop facilement identifiables comme tels.

Vincent : C'est vrai.

Nous pouvons identifier le contenu purement IA comme non naturel, et donc il sera pénalisé. C'est donc le premier problème.

Mais en revanche, derrière cette notion de Helpful Content, il y a un autre sujet qui peut impacter négativement tous les nouveaux outils sémantiques qui se basent sur les SERPs.

Google va enfin être en mesure de détecter une sur-optimisation, je veux dire, quelqu'un qui procéderait à la rétro-ingénierie de l'empreinte parfaite pour se classer dans Google. Et voilà des acteurs forts et talentueux en France qui n'ont pas encore beaucoup réagi à l'actualité : les Frères Peyronnet, 1.fr, SEO Quantum, etc. Ils sont directement concernés par le problème de la sur-optimisation. Ils sont directement concernés par cette mise à jour.

Rebecca : Prenons votre site transfer-learning.ai qui était plutôt une sandbox pour tester si on pouvait se classer avec du contenu entièrement généré, tout en ajoutant quelque chose qui n'existe pas aujourd'hui (en l'occurrence le lien entre la recherche académique et les formations sur sujets liés à l'apprentissage automatique). A votre avis, est-ce encore possible de faire ce genre de chose ?

Vincent : Si ça apporte de l'originalité et n'est pas détecté comme spam, oui, il sera toujours possible de faire ce genre de choses.

Cependant, si cela n'est pas considéré comme utile, cela ne sera pas possible.

De plus, je veux faire un rappel clair aux créateurs français : on parle d'anglais. Nous savons que le déploiement en anglais peut durer des mois, et souvent un an. Lorsque nous regardons les anciennes mises à jour massives du noyau comme Panda ou Penguin, elles ont duré jusqu'à plusieurs années dans certains cas. Je pense que certaines personnes profiteront de cette période de temps pour continuer à pratiquer des techniques de spam. Et puis Google interviendra.

Ce dont je vais parler lors de ma présentation avec Christian Meline, c'est que plutôt que de proposer des sujets que Google a déjà et qui ne l'intéressent pas, nous sommes capables d'utiliser les nouvelles technologies qui nous aident à proposer de nouveaux sujets.

Je vais vous donner un exemple. Si je teste tous les outils SEO et génère des idées de sujets avec GPT-3, ou dans un outil français comme yourtext.guru par exemple, j'obtiendrai 40 idées. Si j'utilise la technique de Christian Méline, j'obtiendrai 4 500. Et certains d'entre eux sont même des sujets qui n'ont jamais été utilisés auparavant et ne sont même pas dans Google.

Que pensez-vous que Google va préférer ? Avoir du contenu qu'il connaît déjà, ou avoir des sujets très intéressants dans lesquels personne n'a jamais creusé ?

Je pense que c'est le futur du SEO : être capable de détecter de nouvelles choses. Je sais que Koray va également dans cette direction sémantique.

Rebecca : Oui, dans le sens d'analyser les lacunes ou les lacunes de contenu où vous pouvez établir une expertise, car ce sont ces domaines sémantiques d'un sujet qui ne sont pas du tout abordés.

Vincent : Exactement. D'un autre côté, je pense que cette mise à jour ne va pas le faire tout de suite. Il y aura une version 1, une version 2, etc. Mais le but ultime de cette mise à jour est de le faire.

[Étude de cas] Gérer le bot crawling de Google

Autres langues et autres supports : Comment cette mise à jour sera-t-elle déployée ?

Rebecca : Vous avez mentionné plus tôt la différence entre l'anglais et d'autres langues comme le français. Nous avons fait d'énormes progrès dans la traduction, dans le traitement indépendant de la langue, comme avec MuM. Pensez-vous que cela va vraiment prendre autant de temps pour que cette mise à jour passe dans d'autres langues ?

Vincent : Franchement, j'ai fait mon propre travail. Je n'ai pas la technologie de Google, je ne connais pas Google, mais je n'ai jamais vu un algorithme aussi long à s'exécuter. Cela signifie que pour un paragraphe de 300 mots, cela prend environ dix secondes. C'est une éternité. Habituellement, nous parlons de calculs TF-IDF, d'incorporations de mots… et cela prend une seconde. Autrement dit, ce type d'algorithme est assez lourd à déployer. Maintenant, je sais que Google a la technologie, ils ont des TPU, ils ont des ingénieurs super intelligents, mais je pense qu'ils vont avoir cette limite lorsqu'ils utilisent un modèle de langage : vous devez charger le modèle de langage. Et quand il y a 200 milliards de paramètres, ça peut faire mal.

C'est drôle, c'est à peu près au même moment que la sortie du modèle de génération de texte sur HuggingFace. Donc je pense, et personne ne peut le dire avec certitude, mais c'est sur quoi ils ont basé leur détection. En fait, ils ont publié un modèle de génération de texte pour détecter la génération de texte. Google combat le feu par le feu, comme on dit.

Rebecca : Ouais, c'est un peu comme ça que ça marche, n'est-ce pas ? Il en a toujours été ainsi dans la détection de textes automatisés. Nous utilisons ce que nous savons sur la façon dont il est construit pour le détecter.

Vincent : Mais ce qui m'impressionne, ce sont les outils SEO qui fournissent une empreinte digitale des SERP. Google dit maintenant : "Nous avons l'empreinte et nous serons en mesure de dire si vous en êtes trop inspiré." Personne ne sait comment ils font. Je sais comment font les autres outils de référencement, mais comment font-ils [Google] ? Personne ne sait.

Rebecca : En fait, l'autre chose qui m'a frappé, c'est qu'il s'agit d'une analyse au niveau du site, puis pour chaque site, si nous parlons vraiment d'une généralisation de très haut niveau, une « valeur » de contenu utile ou inutile est attribuée. au site qui peuvent avoir un impact sur d'autres contenus de ce site. Et cela représente beaucoup d'analyses individuelles et beaucoup de stockage d'informations. Donc, même juste pour traiter ou retraiter cela, cela prend beaucoup de temps.

Vincent : Je pense que c'est la contrainte qu'ils ont. Ils ont annoncé qu'ils ne le faisaient que sur Google Search et non sur Google Discover.

C'est un peu paradoxal car sur Google Discover, tout le monde triche, tout le monde optimise le contenu « SEO » rien que pour être dans Google Discover. Je pense qu'ils ont un gros problème en ce moment avec la recherche Google et tout ce contenu généré automatiquement. Certains sites sont allés trop loin avec du contenu généré automatiquement.

Ils ne parlent pas d'une pénalité, donc ils tournent un peu comme avec Google RankBrain, comme un nouveau signal.

Et tous les sites ne seront pas concernés. Je pense notamment aux sites e-commerce avec toutes leurs fiches produits. Nous savons que tout le monde se copie.

Rebecca : Oui, créer des variantes basées sur les descriptions officielles des producteurs, des marques.

Vincent : Oui.

Mais certains sites de médias sont plus à risque. Il y a un phénomène connu en SEO depuis longtemps. Par exemple, certains sites prennent du contenu en anglais et le traduisent sans y ajouter de valeur. Personne n'en a parlé, mais il y a un risque majeur pour ce type de site car il n'apporte rien et en plus, ils ont le défaut de ne pas citer leurs sources.

Rebecca : Et ils auront également le contenu original en anglais pour faire une comparaison.

Vincent : Oui, l'étape où nous passons de l'anglais au français avec cette mise à jour nuira probablement à de nombreux sites de spam.

De toutes les actualités SEO de ces derniers mois, il s'agit de la mise à jour la plus importante. RankBrain aussi, pourrait-on dire, mais cela a été beaucoup moins évident à pointer, difficile de voir quels sont les résultats réels de son application.

Rebecca : Je pense que c'est en fait proche, avec le concept d'analyse sémantique et les parties du site Web qui ne sont pas liées au reste du site Web.

Vincent : Exactement.

Je sais qu'ils travaillent dessus depuis un moment. J'avais un ami qui travaille chez Google, qui a dit qu'il travaillait là-dessus depuis 2009 ; il y avait deux équipes de recherche là-dessus. Ils essaient de le faire maintenant en temps réel et ils vont faire beaucoup de nettoyage.

Mais nous ne savons toujours pas grand-chose sur la mise en œuvre. Comment vont-ils le faire? Avec un signe ? Ceux qui trichent seront-ils moins bien indexés ? Personne ne peut répondre à cette question, sauf John Mueller.

Rebecca : Je doute même qu'il y soit autorisé. J'imagine qu'ils s'en tiendront à leur ligne de conduite : "créez du contenu utile pour les utilisateurs, pas pour les moteurs de recherche, et vous n'aurez pas de problème".

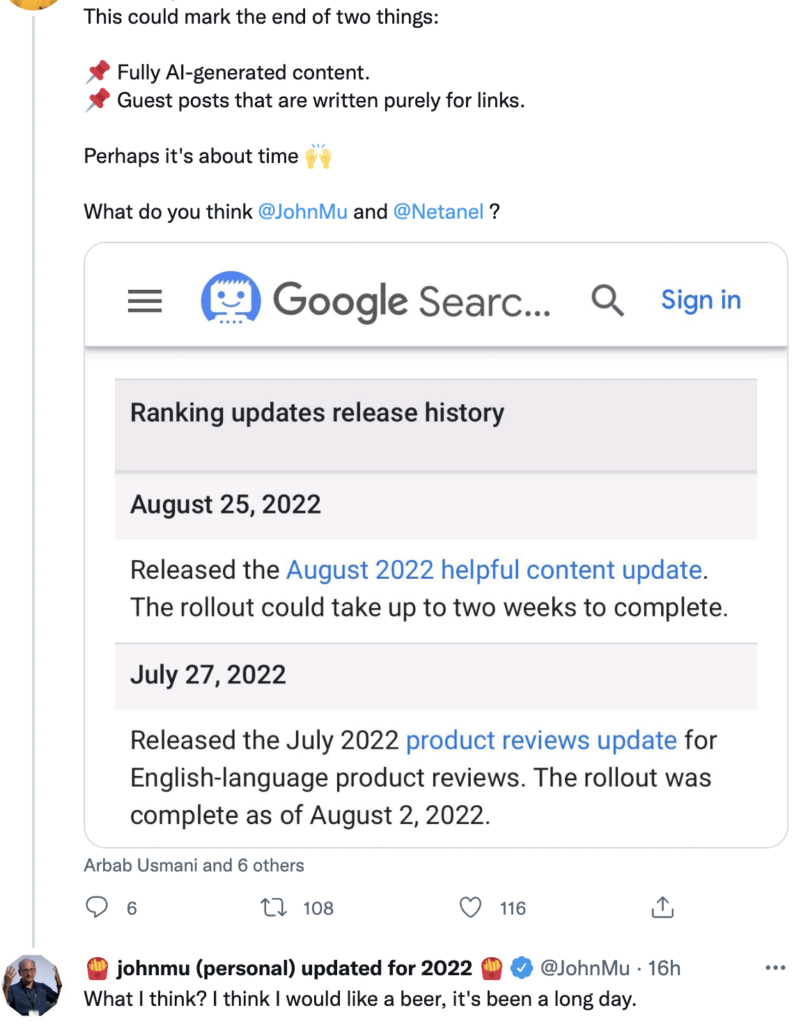

Vincent : Sur Twitter, il est bombardé de questions sur ce sujet et ses réponses ont été un peu larges.

Source : Gazouillement

L'impact sur la création de contenu à l'avenir

Rebecca : Cela ne m'étonne pas. Je pense qu'il n'a probablement pas d'informations plus précises. Et même s'il le fait, il doit être absolument interdit de parler de l'algorithme.

Quoi qu'il en soit, j'ai très hâte de commencer à voir les brevets liés à cette mise à jour, de faire une réanalyse des brevets dans un an, deux ans, pour voir ce qui existe et s'il y a une indication d'utilisation un peu plus tard. Mais c'est un autre sujet.

Vincent : Pour préparer ma conférence de septembre, j'ai listé comment on reconnaît un contenu de qualité, un contenu utile. Je me suis basé sur l'article du journal dunet où Christian Méline avait écrit sur le sujet il y a [trois] ans. Son contenu est toujours d'actualité. En revanche, il ne s'appuie pas sur l'apprentissage automatique. Il déteste ça, donc ce sont des mesures basiques et utiles : le titre est-il bien écrit ? Y a-t-il des fautes d'orthographe ? Apporte-t-il de nouvelles connaissances ? Rarement des choses pour lesquelles vous aurez besoin d'un apprentissage automatique pour les faire.

Rebecca : Ce type de conseil va être super important car la plupart des référenceurs n'ont pas forcément les ressources, les données, le temps ou juste les compétences pour mettre en place le machine learning, pour pouvoir analyser leurs sites, pour savoir s'il y a risques d'y tomber ou non.

Vincent : Exactement. Nous devons suivre cela de très, très près.

De plus, nous devons faire très attention à ce que nous disons. Il faut parler au conditionnel. Il n'y a personne qui soit certain à ce sujet.

Rebecca : C'est sûr. Nous n'avons que des choses de très haut niveau, ce qui signifie que nous n'avons aucune preuve, aucun indice et aucune information. Il est donc clair que tout ce que nous pouvons dire à ce sujet ne sont pas des conclusions, ce sont des théories.

Vincent : Exactement.

Voici ce que j'ai mis en place comme point de départ :

- L'analyse des jetons pour regarder la répétition : identifier quand c'est excessif, quand c'est juste pour classer.

- Ensuite, les probabilités entre les mots que j'évoquais plus tôt.

- Et enfin un, les groupes de mots.

Rien qu'avec ces trois combos, je peux détecter 90% des textes générés par l'IA qui n'ont pas été optimisés par un humain. Alors imaginez ce que Google peut faire ! C'est époustouflant.

Rebecca : Nous devrions donc absolument assister à votre conférence SEO Campus le 23 septembre avec Christian.

Vincent : Oui, nous voulions décomposer un peu le sujet du contenu utile. C'est marrant : avant même que Google commence à parler de la mise à jour, nous l'avions prévu.

J'aime aussi ce sujet parce que je suis très écologiste. Cela me fait du bien de savoir qu'il existe des contrôles comme celui-là pour empêcher les gens de spammer. Parce que cela nous coûte des ressources inimaginables.

Rebecca : Oui, c'est vrai. Avec cette mise à jour, tout le monde fait très attention. Je pense que les gens qui pensent que cela ne changera rien ont tort. Nous pouvons voir que cela va changer non seulement la façon dont nous créons du contenu, mais aussi la façon dont Google évalue le contenu. Et ce sont des stratégies que nous n'avons jamais vues auparavant.

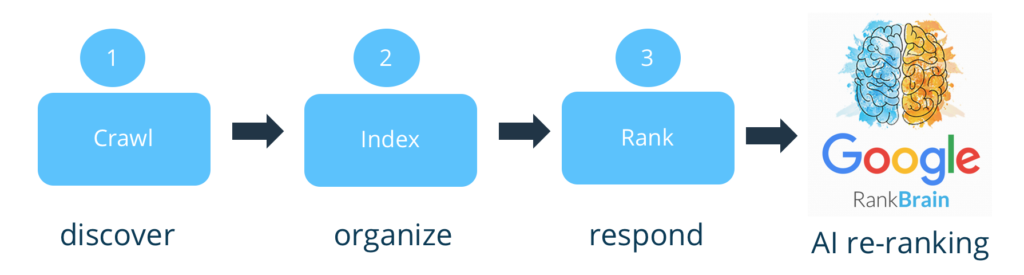

Vincent : Exactement. En fait, si vous voulez adopter une position extrême, Google n'évalue pas le contenu. C'est une énorme faiblesse. Auparavant, il ne faisait qu'indexer et classer. Maintenant, ils filtreront en amont. Et c'est ce que Bing reprochait à Google de ne pas faire.

Rebecca : Oui, la plupart des analyses [sur le contenu] ont eu lieu au moment du classement.

Vincent : C'est vrai. Maintenant, il semble avoir un petit filtre. Je suis d'accord avec vous : j'ai hâte de voir le brevet qui sortira là-dessus. Ils devront révéler où ils ont mis le filtre. Où pariez-vous qu'ils mettent le filtre? Avant, après indexation ou avant, après classement ? Tu le mettrais où ?

Rebecca : Puisque vous devez avoir la majeure partie du site pour pouvoir faire cela, je dirais…

Vincent : N'oubliez pas que vous avez besoin de l'empreinte des SERP, comme nous en avons discuté, pour l'indexation. Il faut donc les indexer.

Rebecca : Ouais, c'est ce que j'allais dire. Je pense que ça devrait être une étape supplémentaire, on ne court pas le risque de désindexer, donc on parle d'un impact après l'indexation, peut-être après le classement [initial] aussi.

Vincent : Oui, pour moi, c'est après le classement. Si j'étais Google, c'est quelque chose que j'aurais ajouté à Google RankBrain, car il est capable d'agréger des signaux, etc. Maintenant, la question est de savoir quel sera son impact sur les sites.

Rebecca : Avec l'apprentissage automatique, cela peut varier considérablement d'un site à l'autre, car vous pouvez avoir beaucoup plus de contrôle sur son impact et sur la quantité de contenu inutile sur chaque site.

Vincent : La limite avec Google, ce sont les faux positifs. Ce serait désindexer [ou pénaliser] les pages légitimes. Je pense donc que l'impact initial sera très, très faible, mais ils s'en prendront vraiment aux tricheurs.

J'ai eu des gens qui m'ont contacté, cependant, qui étaient un peu inquiets. Je leur ai dit qu'au début, il ne détecterait que les textes sans qualité. C'est-à-dire que je pense qu'un texte [généré], suivi d'une relecture humaine, peut avoir toute son utilité.

Je ne suis pas aussi strict que d'autres qui disent « IA = ordures ». Je n'y crois pas vraiment non plus.

Rebecca : Ça ne me surprend pas, venant de toi !

C'est un peu frustrant, sachant que ça va être lent. Comme vous le dites, pour éviter les faux positifs, c'est une autre raison de se lancer en anglais : ils maîtrisent mieux l'anglais. Cela permet de mettre en place des contrôles supplémentaires beaucoup plus coûteux, avant de généraliser à l'ensemble du web et à d'autres langages moins maîtrisés, moins bien automatisés.

En tout cas, ce fut une discussion très riche. Merci beaucoup pour cet échange.

Vincent : On peut en reparler quand tu veux.

Rebecca : Ça a été un plaisir.