Vincent Terrasi: 役立つコンテンツの更新の重要性

公開: 2022-08-26ヘルプ コンテンツ アルゴリズムの更新とは何ですか?

先週、Google は、現在リリースされている Helpful Content を宣伝することで検索結果の品質を向上させるアルゴリズム アップデートのリリースを発表しました。 この更新プログラムは、最初は英語の Web サイトにのみ適用されます。サイトに役に立たないコンテンツが大量にある場合は、サイト全体のコンテンツの価値が下がる可能性があります。

EAT と同様に、「役立つ」という概念は、具体的な指標によって簡単に定量化することはできません。 アルゴリズムは機械学習に依存して、役に立たないコンテンツを識別します。

EAT とアルゴリズムの更新を専門とする経験豊富な SEO は、ヘルプコンテンツの更新について何がわかっているのか、どのように対応すればよいのかをすでに詳細に分析しています。 マリー・ヘインズ、グレン・ゲイブ、リリー・レイによる分析は読む価値があります。

議論をさらに進めるために、Oncrawl のプロダクト ディレクターであり、機械学習と BERT や GPT-3 などの言語モデルに焦点を当てたデータ SEO の専門家である Vincent Terrasi に話を聞きました。

ヴィンセント・テラシへのインタビュー

「純粋な AI コンテンツは不自然であると特定できるため、罰せられます。 しかしその一方で、この役立つコンテンツの概念の背後には、SERP に基づくすべての新しいセマンティック ツールに悪影響を与える可能性のある別の問題があります。 Google は最終的に過剰な最適化、つまり Google でランク付けするのに最適なフットプリントをリバース エンジニアリングする人物を検出できるようになるでしょう。」

コンテンツ分析と過剰な最適化の検出: 役立つコンテンツの更新によって実際に何が変わるか

Rebecca: Tech SEO Boost 2019 で 2 位を獲得したあなたの作品のさまざまな要素について考え続けています。そこであなたは SEO のためのテキスト生成、影響、危険性について話しました。 また、特に Google が BERT をリリースしたときに、次のステップと、機械学習を通じてテキスト分析を一般化する方法について話しました。 この場合、それは一種の分類のようなもので、その上に意味分析があります。 それはあなたがそれから得ていることでもありますか? このアップデートはあなたを驚かせますか?

Vincent:はい、それは私が SEO Boost Tech で発表したことです: 彼ら [Google] はこの種のコンテンツを追求するつもりだった.

Oncrawl でのテキスト生成に関心のあるクライアントに、生成されたコンテンツに注意する必要がある理由を伝え続けています。

AI (人工知能) によって生成されたコンテンツについて話すときは注意が必要です。 Helpful Content の更新では、手動のアクションにつながるタイプのもののように見えるかもしれませんが、手動のアクションについてはまったく話していません。 AI によって生成されたサイトに関する最近のニュースを見たことがあるかもしれません。 これは 3 か月前のことです。月に 100,000 ドルを稼いでいると主張するサイトでは、強力な手作業が行われていました。 それらはすべて索引付け解除されました。 それらは手動のアクションです。

現在、付加価値のないテキストかどうかを識別できる機械学習モデルを使用したこの更新があります。 したがって、私は AI についてではなく、付加価値のないコンテンツの有無にかかわらずサイトについて話したいと思います。

Rebecca:はい、Google から、手動による対策に関するものではないという確認があります。 この場合、Google が明らかに機械学習であり、ほぼ常に実行されていると言っているのは興味深いことです。 そのため、影響を受けたサイトは次の数か月で再分類される可能性がありますが、そうでない場合もあります。

Vincent:これについては、9 月に開催される SEO Camp Paris での Christian Meline とのカンファレンスでお話しする予定です。5 か月前に確認したことだからです。 想像できますか? 私たちは、Google で何かが起こっていることをすでに確認していました。

全体として、次の 2 つのトピックがあります。

AI 生成コンテンツのトピックがあります。 AI が繰り返されるため、スパム コンテンツは非常に簡単に特定できると言えます。 3 語、4 語、5 語の単語グループに分解すると、同じフレーズが繰り返されていることがわかります。 それは非常に簡単に検出できます。 機械学習を行う必要はありません。

一方、機械学習の部分は、実際には次の単語が現れる確率が非常に安定しているということです。

レベッカ:はい、トレーニング コースに取り組んでいたときにも、このことについて話しました。 Oncrawl の内部では、これにより、生成されたテキストの品質を評価するスコアリング システムを作成する作業が現在進行中です。

ヴィンセント:その通りです。

純粋な AI コンテンツは不自然であると特定できるため、ペナルティが科せられます。 それが最初の問題です。

しかしその一方で、この役立つコンテンツの概念の背後には、SERP に基づくすべての新しいセマンティック ツールに悪影響を与える可能性のある別の問題があります。

Google は最終的に過剰な最適化、つまり Google でランク付けするのに最適なフットプリントをリバース エンジニアリングする人物を検出できるようになります。 フランスには、このニュースにまだあまり反応していない強力で才能のあるプレーヤーがいます。Freres Peyronnet、1.fr、SEO Quantum などです。彼らは、過度の最適化の問題に直接関係しています。 これらは、この更新プログラムの影響を直接受けます。

Rebecca:あなたのサイト transfer-learning.ai を取り上げてみましょう。これはサンドボックスのようなもので、完全に生成されたコンテンツでランク付けできるかどうかをテストする一方で、現在存在しない何かを追加します (この場合、学術研究とトレーニング コース間のリンク)関連する機械学習のトピック)。 あなたの意見では、この種のことはまだ可能ですか?

ヴィンセント:オリジナリティがあり、スパムとして検出されない場合、はい、この種のことはいつでも可能です。

ただし、役に立たないと考えられる場合は、それは不可能です。

さらに、フランスのクリエーターにはっきりと伝えておきたいのは、私たちは英語について話しているということです。 英語での展開は数か月、場合によっては 1 年かかることはわかっています。 Panda や Penguin のような古い大規模なコア アップデートを振り返ると、場合によっては数年に及ぶものもありました。 この期間を利用してスパム行為を継続する人もいると思います。 そして、Googleが介入します。

Christian Meline とのプレゼンテーションで話し合おうとしているのは、Google が既に持っていて、Google が関心を持っていないテーマを提案するのではなく、新しいテーマを提案するのに役立つ新しいテクノロジーを使用できるということです。

例を挙げましょう。 すべての SEO ツールをテストし、GPT-3 や yourtext.guru などのフランスのツールでトピックのアイデアを生成すると、40 個のアイデアが得られます。 Christian Meline のテクニックを使えば 4,500 になります。 そして、それらのいくつかは、これまで使用されたことのないトピックであり、Google にも含まれていません。

Googleは何を好むと思いますか? すでに知っているコンテンツを持っているのか、それとも誰も掘り下げたことのない非常に興味深いトピックを持っているのか?

それが SEO の未来だと思います。新しいものを検出できるようになることです。 Koray もそのセマンティックな方向に進んでいることを私は知っています。

Rebecca:はい、専門知識を確立できるコンテンツのギャップや欠落を分析するという意味で。トピックのセマンティック領域はまったく扱われていないからです。

ヴィンセント:その通りです。 一方で、今回のアップデートですぐにそうなるわけではないと思います。 バージョン 1、バージョン 2 などがあります。 しかし、このアップデートの最終的な目標はそれを実現することです。

[ケース スタディ] Google のボット クロールの管理

他の言語と他のメディア: この更新プログラムはどのように展開されますか?

Rebecca:先ほど、英語とフランス語などの他の言語との違いについておっしゃいましたね。 MuM のように、言語に依存しない処理において、翻訳において大きな進歩を遂げました。 このアップデートが他の言語に移行するのに、本当にこれほど時間がかかると思いますか?

ヴィンセント:率直に言って、私は自分でいくつかの仕事をしました。 私は Google のテクノロジーを持っていません。Google のことは知りませんが、実行にこれほど時間がかかるアルゴリズムは見たことがありません。 つまり、300 ワードの段落の場合、約 10 秒かかります。 それは永遠です。 通常、TF-IDF の計算、単語の埋め込みについて話しているのですが、1 秒かかります。 言い換えれば、このタイプのアルゴリズムは、展開するのにかなりの負荷がかかります。 Google には技術があり、TPU があり、非常に優秀なエンジニアがいることがわかりましたが、言語モデルを使用する場合、言語モデルをロードする必要があるという制限があると思います。 そして、2000 億のパラメーターがある場合、それは害になる可能性があります。

面白いことに、HuggingFace でのテキスト生成モデルのリリースとほぼ同じ時期です。 これを確実に言える人は誰もいないと思いますが、それが彼らの検出に基づいたものです. 実際、彼らはテキスト生成を検出するテキスト生成モデルをリリースしました。 彼らが言うように、Googleは火で火と戦っています。

レベッカ:ええ、そういう仕組みですよね? 自動化されたテキストの検出では、常にそのようになっています。 私たちは、それがどのように構築されているかについて知っていることを使用して、それを検出します。

Vincent:しかし、私が感銘を受けたのは、SERP のフィンガープリントを提供する SEO ツールです。 グーグルは現在、「足跡があり、あなたがそれに触発されすぎているかどうかを判断できるようになるだろう」と言っています。 彼らがどのようにそれを行うかは誰も知りません。 他の SEO ツールがそれを行う方法は知っていますが、[Google] はどのように行うのでしょうか? 誰も知らない。

Rebecca:実際、私が他に際立っていたのは、これがサイト レベルの分析であり、各サイトに対して、非常に高レベルの一般化について話しているのであれば、役立つコンテンツまたは役に立たないコンテンツの「値」が割り当てられていることです。そのサイトの他のコンテンツに影響を与える可能性のあるサイトに。 そして、それは多くの個々の分析であり、多くの情報ストレージです. それを処理したり、再処理したりするだけでも、かなりの時間がかかります。

Vincent:それが彼らの制約だと思います。 彼らは、Google Discover ではなく Google Search でのみ行っていると発表しました。

Google Discover では、誰もが不正行為を行っており、Google Discover に掲載されるためだけに「SEO」コンテンツを最適化しているため、これは少し矛盾しています。 彼らは現在、Google 検索と自動生成されたすべてのコンテンツに大きな問題を抱えていると思います。 自動生成されたコンテンツで行き過ぎたサイトがいくつかあります。

彼らはペナルティについて話しているわけではないので、新しいシグナルとして、Google RankBrain のようにこれを回転させているのです。

また、すべてのサイトが影響を受けるわけではありません。 特に、すべての製品の説明を含む e コマース サイトについて考えています。 誰もがお互いをコピーしていることを知っています。

Rebecca:はい、生産者やブランドの公式説明に基づいてバリエーションを作成しています。

ヴィンセント:はい。

しかし、一部のメディア サイトはより危険にさらされています。 SEOで古くから知られている現象があります。 たとえば、一部のサイトでは、英語のコンテンツを何の付加価値も持たずに翻訳しています。 誰もそれについて話していませんが、このタイプのサイトには大きなリスクがあります。なぜなら、何も追加しない上に、ソースを引用しないという欠点があるからです。

Rebecca:また、英語の元のコンテンツと比較することもできます。

ヴィンセント:はい、このアップデートで英語からフランス語に移行する段階では、多くのスパム サイトが被害を受ける可能性があります。

過去数か月のすべての SEO ニュースの中で、これは最も重要な更新です。 RankBrain もそうだと言えます。

レベッカ:意味分析の概念と、ウェブサイトの残りの部分とは関係のないウェブサイトの部分で、実際に近いと思います。

ヴィンセント:その通りです。

私は彼らがしばらくの間これに取り組んできたことを知っています。 Google で働いている友人がいて、2009 年からこれに取り組んでいるとのことでした。 これには2つの研究チームがありました。 彼らは現在リアルタイムでそれを行おうとしており、多くのクリーンアップを行う予定です。

しかし、実装についてはまだよくわかっていません。 彼らはどのようにそれをしますか? 信号で? チートをする人は、インデックスにうまく登録されませんか? その質問に答えられる人は、ジョン・ミューラー以外にはいません。

レベッカ:彼でさえ許されるとは思えない. 「検索エンジンのためではなく、ユーザーにとって有用なコンテンツを作成すれば、問題は発生しない」という方針を維持すると思います。

Vincent: Twitter では、このトピックに関する質問が殺到しています。

出典:ツイッター

今後のコンテンツ制作への影響

レベッカ:それには驚かないわ。 おそらく、彼はこれ以上の詳細な情報を持っていないと思います。 仮にそうだったとしても、アルゴリズムについて話すことは絶対に禁じられていなければなりません。

いずれにせよ、この更新に関連する特許を見始めて、1 年、2 年後に特許の再分析を行い、そこに何があるかを確認し、少し後に使用の兆候があるかどうかを非常に心配しています. しかし、それは別のトピックです。

Vincent: 9 月の私の会議に備えて、質の高いコンテンツ、有用なコンテンツをどのように認識しているかをリストアップしました。 これは、[3] 年前に Christian Meline がこの件について書いたジャーナルデュネット (フランス語) の記事に基づいています。 彼のコンテンツは今でも完全に関連しています。 一方で、彼は機械学習に頼っていません。 彼はそれを嫌っているので、これらは基本的で有用な指標です: タイトルはよく書かれていますか? スペルミスはありますか? それは新しい知識を提供しますか? それらを行うために機械学習が必要になることはめったにありません。

Rebecca:この種のアドバイスは非常に重要です。なぜなら、ほとんどの SEO は、機械学習を実装し、サイトを分析し、機械学習があるかどうかを知るためのリソース、データ、時間、またはスキルを持っているとは限らないからです。それに陥るかどうかのリスク。

ヴィンセント:その通りです。 私たちはこれに非常に厳密に従わなければなりません。

さらに、私たちは自分の発言に細心の注意を払う必要があります。 条件付きの時制で話さなければなりません。 この問題について確信を持っている人は誰もいません。

レベッカ:それは確かです。 私たちは非常に高レベルのものしか持っていません。つまり、証拠も手がかりも情報もありません。 明らかに、それについて私たちが言えることは結論ではなく、理論です。

ヴィンセント:その通りです。

出発点として設定したものは次のとおりです。

- 繰り返しを調べるためのトークンの分析: 繰り返しが過剰な場合と、ランク付けするためだけの場合を特定します。

- 次に、先に述べた単語間の確率。

- 最後に単語グループです。

この 3 つの組み合わせだけで、人間が最適化していない AI 生成テキストの 90% を検出できます。 Google ができることを想像してみてください。 それは驚くべきことです。

Rebecca:ですから、9 月 23 日に開催される SEO Campus カンファレンスに必ず Christian と一緒に出席する必要があります。

Vincent:はい、役に立つコンテンツのトピックを少し分解したいと思いました。 面白いことに、Google がアップデートについて話し始める前から、私たちはこれを計画していました。

私は非常に環境に配慮しているので、このトピックも好きです。 人々がスパム行為をしないようにするためのそのようなコントロールがあることを知って、気分が良くなります. 想像を絶するリソースが必要になるからです。

レベッカ:はい、そうです。 この更新により、誰もが細心の注意を払っています。 何も変わらないと思っている人は間違っていると思います。 コンテンツの作成方法だけでなく、Google によるコンテンツの評価方法も変わることがわかります。 そして、これらはこれまで見たことのない戦略です。

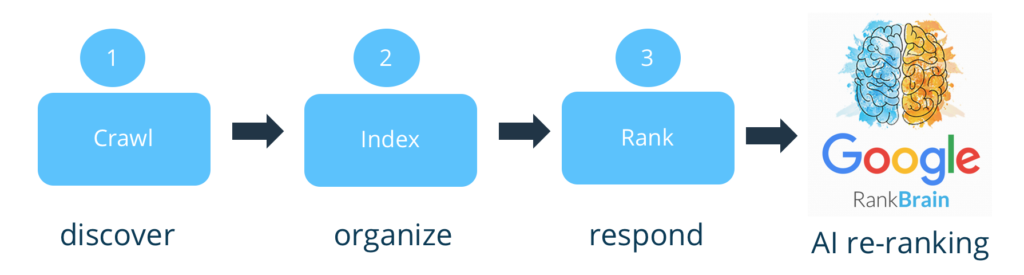

ヴィンセント:その通りです。 実際、極端なスタンスを取りたい場合、Google はコンテンツを評価しません。 それは大きな弱点です。 以前はインデックスとランク付けだけでした。 これで、上流でフィルタリングされます。 それこそが、Bing が Google を批判していたことです。

Rebecca:はい、[コンテンツに関する] 分析のほとんどはランキングの時点で行われました。

ヴィンセント:その通りです。 今は少しフィルターがかかっているようです。 私はあなたに同意します。これに関する特許が公開されるのが待ちきれません。 彼らは、フィルターをどこに置いたかを明らかにする必要があります。 彼らがフィルターをどこに置いたと思いますか? インデックスの前、後、またはランキングの前、後? あなたはそれをどこに置きますか?

レベッカ:それを行うには、サイトのほとんどを持っている必要があるので、私は…

Vincent:先ほど説明したように、インデックス作成には SERP のフットプリントが必要であることを忘れないでください。 したがって、それらにインデックスを付ける必要があります。

レベッカ:ええ、それが私が言おうとしていたことです。 これは追加のステップであるべきだと思います。インデックスを削除するリスクはありません。したがって、インデックス作成後の影響について話しているのです。おそらく [最初の] ランキングの後にも同様です。

Vincent:はい、私にとっては、ランキングの後です。 もし私が Google だったら、これを Google RankBrain に追加したでしょう。なぜなら、シグナルを集約できるからです。

Rebecca:機械学習を使用すると、サイトごとに大きく異なる可能性があります。その影響と、各サイトにある役に立たないコンテンツの量をより細かく制御できるからです。

Vincent: Google の限界は誤検知です。 これは、正当なページのインデックスを削除する (またはペナルティを科す) ことになります。 したがって、最初の影響は非常に小さいと思いますが、彼らは本当に詐欺師を追いかけます.

でも、少し気になっている人から連絡がありました。 最初は、品質のないテキストのみを検出すると伝えました。 つまり、[生成された] テキストは、人間の校正によってフォローアップされ、すべての有用性を持つことができると思います。

私は「AI=ゴミ」と言う人ほど厳しくありません。 私もそれを本当に信じていません。

レベッカ:それは私を驚かせません、あなたから来る!

遅くなることがわかっているので、少しイライラします。 おっしゃる通り、誤検知を避けるためにも、英語でローンチするもう 1 つの理由があります。 これにより、Web 全体や、あまり習得されておらず、自動化されていない他の言語に一般化する前に、はるかにコストのかかる追加のコントロールを配置することが可能になります。

いずれにせよ、非常に充実した議論でした。 この度の交換、誠にありがとうございました。

ヴィンセント:それについては、いつでも話せます。

レベッカ: とても楽しかったです。