Vincent Terrasi: Znaczenie aktualizacji pomocnej zawartości

Opublikowany: 2022-08-26Co to jest aktualizacja algorytmu Pomocnych treści?

W zeszłym tygodniu Google ogłosił wydanie aktualizacji algorytmu, która ma na celu poprawę jakości wyników wyszukiwania poprzez promowanie Helpful Content, która jest obecnie udostępniana. Ta aktualizacja będzie początkowo dotyczyć tylko witryn anglojęzycznych i może obniżyć wartość całej zawartości witryny, jeśli zawiera ona znaczną ilość nieprzydatnych treści.

Podobnie jak w przypadku EAT, pojęcia „pomocny” nie da się łatwo określić ilościowo za pomocą konkretnych wskaźników; algorytm opiera się na uczeniu maszynowym w celu identyfikacji nieprzydatnych treści.

Doświadczeni SEO, specjalizujący się w aktualizacjach EAT i algorytmów, szczegółowo przeanalizowali już, co wiadomo i jak zareagować na aktualizację Helpful Content. Warto przeczytać analizy Marie Haynes, Glenna Gabe'a i Lily Ray.

Aby pogłębić dyskusję, rozmawiałem z Vincentem Terrasi, dyrektorem produktu w Oncrawl i ekspertem ds. SEO z naciskiem na uczenie maszynowe i modele językowe, takie jak BERT i GPT-3.

Wywiad z Vincentem Terrasi

„Możemy zidentyfikować czystą zawartość AI jako nienaturalną i dlatego będzie karana. Ale z drugiej strony za pojęciem Helpful Content kryje się inny temat, który może negatywnie wpłynąć na wszystkie nowe narzędzia semantyczne oparte na SERP. Google w końcu będzie w stanie wykryć nadmierną optymalizację, mam na myśli kogoś, kto odwróciłby idealny ślad, aby uzyskać pozycję w Google”.

Analiza treści i wykrywanie nadmiernej optymalizacji: co naprawdę zmieni aktualizacja Helpful Content

Rebecca: Ciągle myślę o różnych elementach Twojej pracy, które zajęły drugie miejsce na Tech SEO Boost 2019, gdzie mówiłaś o generowaniu tekstu dla SEO, skutkach i zagrożeniach. Dyskutowaliśmy również na ten temat, zwłaszcza gdy Google wypuścił BERT, rozmawiając o kolejnych krokach i o tym, jak będą mogli uogólnić analizę tekstu poprzez uczenie maszynowe. W tym przypadku jest to rodzaj klasyfikacji, a na dodatek analiza semantyczna. Czy to też jest to, co z tego czerpiesz? Czy ta aktualizacja Cię zaskakuje?

Vincent: Tak, właśnie to ogłosiłem na SEO Boost Tech: że [Google] zamierzają szukać tego typu treści.

Ciągle mówię klientom, którzy są zainteresowani generowaniem tekstów w Oncrawl, dlaczego muszą uważać na generowane treści.

Musisz być ostrożny mówiąc o treściach generowanych przez AI (sztuczną inteligencję). W przypadku aktualizacji Pomocnej zawartości w ogóle nie mówimy o ręcznych działaniach, nawet jeśli wydaje się, że takie działania mogą prowadzić do ręcznego działania. Być może widzieliście niektóre z ostatnich wiadomości o witrynach generowanych przez sztuczną inteligencję i zdecydowanie zaklasyfikowałbym to jako ręczne działanie. To było trzy miesiące temu: były silne ręczne działania w przypadku witryn, które twierdziły, że zarabiają 100 000 USD miesięcznie. Wszyscy zostali zdeindeksowani. To są działania ręczne.

Teraz jest ta aktualizacja z modelem uczenia maszynowego, który jest w stanie określić, czy jest to tekst bez wartości dodanej. Więc wolałbym nie mówić o sztucznej inteligencji, ale o witrynach z treściami niebędącymi wartością dodaną lub bez nich.

Rebecca: Tak, jest potwierdzenie od Google, że nie chodzi o ręczne działania. Ciekawe, że w tym przypadku Google wyraźnie mówi, że to uczenie maszynowe i prawie cały czas działa. Tak więc w kolejnych miesiącach witryna, której dotyczy problem, może zostać przeklasyfikowana… lub nie.

Vincent: Porozmawiam o tym na mojej konferencji we wrześniu z Christianem Meline na SEO Camp Paris, ponieważ jest to coś, co zidentyfikowaliśmy pięć miesięcy temu. Czy możesz sobie wyobrazić? Zidentyfikowaliśmy już, że coś się dzieje z Google.

Ogólnie rzecz biorąc, są dwa tematy:

Jest temat treści generowanych przez sztuczną inteligencję. Można powiedzieć, że spamerskie treści mogą być bardzo łatwe do zidentyfikowania, ponieważ sztuczna inteligencja się powtarza. Jeśli podzielisz go na grupy słów składające się z trzech, czterech, pięciu słów, zobaczysz, że powtarza te same frazy. Bardzo łatwo to wykryć. Nie musisz robić uczenia maszynowego.

Z drugiej strony uczenie maszynowe polega na tym, że w rzeczywistości istnieją bardzo stabilne prawdopodobieństwa pojawienia się kolejnego słowa.

Rebecca: Tak, rozmawialiśmy o tym również podczas pracy nad twoimi kursami szkoleniowymi. Wewnętrznie w Oncrawl doprowadziło to do trwających obecnie prac nad stworzeniem systemu oceny jakości generowanych tekstów w celu znalezienia treści, które jako takie są zbyt łatwe do zidentyfikowania.

Vincent: Zgadza się.

Możemy zidentyfikować czystą zawartość AI jako nienaturalną i dlatego będzie karana. Więc to jest pierwszy problem.

Ale z drugiej strony za pojęciem Helpful Content kryje się inny temat, który może negatywnie wpłynąć na wszystkie nowe narzędzia semantyczne oparte na SERP.

Google w końcu będzie w stanie wykryć nadmierną optymalizację, mam na myśli kogoś, kto odwróciłby idealny ślad, aby uzyskać pozycję w Google. A tutaj mamy silnych i utalentowanych graczy we Francji, którzy jeszcze nie zareagowali zbytnio na wiadomości: Freres Peyronnet, 1.fr, SEO Quantum itp. Są oni bezpośrednio zaniepokojeni problemem nadmiernej optymalizacji. Ta aktualizacja ma na nie bezpośredni wpływ.

Rebecca: Weźmy na przykład Twoją witrynę transfer-learning.ai, która była bardziej piaskownicą do przetestowania, czy możemy rankingować z całkowicie wygenerowaną treścią, dodając coś, co nie istnieje dzisiaj (w tym przypadku powiązanie między badaniami akademickimi a kursami szkoleniowymi na powiązane tematy uczenia maszynowego). Czy Twoim zdaniem jest jeszcze możliwe robienie tego typu rzeczy?

Vincent: Jeśli przynosi oryginalność i nie jest wykrywany jako spam, tak, zawsze będzie można zrobić tego typu rzeczy.

Jeśli jednak nie zostanie to uznane za pomocne, nie będzie to możliwe.

Dodatkowo chcę wyraźnie przypomnieć francuskim twórcom: mówimy o języku angielskim. Wiemy, że wdrożenie w języku angielskim może trwać miesiące, a często nawet rok. Kiedy spojrzymy wstecz na stare, ogromne aktualizacje podstawowe, takie jak Panda czy Penguin, w niektórych przypadkach trwały one nawet kilka lat. Myślę, że niektórzy ludzie wykorzystają ten czas, aby dalej ćwiczyć techniki spamowania. A potem interweniuje Google.

Podczas mojej prezentacji z Christianem Meline zamierzam omówić to, że zamiast proponować tematy, które Google już ma i którymi nie jest zainteresowany, jesteśmy w stanie wykorzystać nowe technologie, które pomagają nam proponować nowe tematy.

Dam ci przykład. Jeśli przetestuję wszystkie narzędzia SEO i wygeneruję pomysły na tematy za pomocą GPT-3 lub na przykład we francuskim narzędziu, takim jak yourtext.guru, otrzymam 40 pomysłów. Jeśli użyję techniki Christiana Meline, dostanę 4500. A niektóre z nich to nawet tematy, które nigdy wcześniej nie były używane i nie ma nawet w Google.

Jak myślisz, co woli Google? Mieć treść, którą już zna, lub mieć bardzo interesujące tematy, w które nikt nigdy się nie zagłębił?

Myślę, że to przyszłość SEO: umiejętność wykrywania nowych rzeczy. Wiem, że Koray również zmierza w tym semantycznym kierunku.

Rebecca: Tak, w sensie analizowania luk w treści lub luk, w których można ustalić ekspertyzę, ponieważ to te semantyczne obszary tematu nie są w ogóle poruszane.

Vincent: Dokładnie. Z drugiej strony myślę, że ta aktualizacja nie zrobi tego od razu. Będzie wersja 1, wersja 2 i tak dalej. Ale ostatecznym celem tej aktualizacji jest zrobienie tego.

[Studium przypadku] Zarządzanie indeksowaniem botów Google

Inne języki i inne media: Jak zostanie wdrożona ta aktualizacja?

Rebecca: Wspomniałeś wcześniej o różnicy między angielskim a innymi językami, takimi jak francuski. Poczyniliśmy ogromne postępy w tłumaczeniu, przetwarzaniu agnostycznym, jak w przypadku MuM. Czy myślisz, że to naprawdę zajmie tyle czasu, zanim ta aktualizacja zostanie przeniesiona na inne języki?

Vincent: Szczerze, sam wykonałem trochę pracy. Nie mam technologii Google, nie znam Google, ale nigdy nie widziałem algorytmu, który działa tak długo. Oznacza to, że dla akapitu składającego się z 300 słów zajmuje to około dziesięciu sekund. To wieczność. Zwykle mówimy o obliczeniach TF-IDF, osadzeniu słów… i zajmuje to sekundę. Innymi słowy, ten typ algorytmu jest dość trudny do wdrożenia. Teraz wiem, że Google ma technologię, ma TPU, ma super inteligentnych inżynierów, ale myślę, że będą mieli ten limit, gdy użyje modelu językowego: musisz załadować model językowy. A kiedy jest 200 miliardów parametrów, może to zaszkodzić.

To zabawne, dzieje się to mniej więcej w tym samym czasie, co wydanie modelu generowania tekstu w HuggingFace. Tak myślę i nie ma nikogo, kto mógłby to powiedzieć na pewno, ale na tym oparli swoje wykrywanie. W rzeczywistości wydali model generowania tekstu do wykrywania generowania tekstu. Jak mówią, Google walczy z ogniem ogniem.

Rebecca: Tak, tak to działa, prawda? Zawsze tak było w wykrywaniu automatycznych tekstów. Wykorzystujemy to, co wiemy o sposobie jego budowy, aby to wykryć.

Vincent: Ale to, co mi imponuje, to narzędzia SEO, które zapewniają odcisk palca SERP. Google mówi teraz: „Mamy ślad i będziemy w stanie stwierdzić, czy jesteś nim zbyt zainspirowany”. Nikt nie wie, jak to robią. Wiem, jak robią to inne narzędzia SEO, ale jak to robią [Google]? Nikt nie wie.

Rebecca: Właściwie inną rzeczą, która mnie wyróżniała, było to, że jest to analiza na poziomie witryny, a następnie dla każdej witryny istnieje, jeśli naprawdę mówimy o uogólnieniu bardzo wysokiego poziomu, przypisana „wartość” Pomocnych lub Nieprzydatnych treści do witryny, co może mieć wpływ na inne treści w tej witrynie. A to dużo indywidualnej analizy i dużo przechowywania informacji. Więc nawet samo przetworzenie lub ponowne przetworzenie zajmuje dużo czasu.

Vincent: Myślę, że to jest ich ograniczenie. Ogłosili, że robią to tylko w wyszukiwarce Google, a nie w Google Discover.

To trochę paradoks, ponieważ w Google Discover wszyscy oszukują, wszyscy optymalizują treści „SEO” tylko po to, by znaleźć się w Google Discover. Myślę, że mają teraz duży problem z wyszukiwarką Google i całą tą automatycznie generowaną treścią. Istnieje kilka witryn, które przesadziły z treścią generowaną automatycznie.

Nie mówią o karze, więc kręcą to tak, jak z Google RankBrain, jako nowy sygnał.

Nie dotyczy to wszystkich witryn. Mam na myśli w szczególności witryny e-commerce ze wszystkimi ich opisami produktów. Wiemy, że wszyscy się naśladują.

Rebecca: Tak, tworzenie wariantów na podstawie oficjalnych opisów producentów, marek.

Vincent: Tak.

Ale niektóre witryny medialne są bardziej zagrożone. Istnieje zjawisko znane w SEO od dawna. Na przykład niektóre witryny pobierają treść w języku angielskim i tłumaczą ją bez dodawania żadnej wartości. Nikt o tym nie mówił, ale istnieje duże ryzyko dla tego typu stron, ponieważ nic nie dodaje, a na dodatek mają wadę nie cytowania swoich źródeł.

Rebecca: Będą też mieli oryginalną treść w języku angielskim do porównania.

Vincent: Tak, etap, w którym wraz z tą aktualizacją przechodzimy z języka angielskiego na francuski, prawdopodobnie zaszkodzi wielu witrynom spamerskim.

Spośród wszystkich nowości SEO z ostatnich kilku miesięcy jest to najważniejsza aktualizacja. RankBrain też, moglibyśmy powiedzieć, ale o wiele mniej oczywiste było wskazywanie, trudno zobaczyć, jakie są rzeczywiste wyniki jego zastosowania.

Rebecca: Myślę, że jest blisko, z koncepcją analizy semantycznej i częściami witryny, które nie są powiązane z resztą witryny.

Vincent: Dokładnie.

Wiem, że pracowali nad tym od jakiegoś czasu. Miałem znajomego, który pracuje w Google, który powiedział, że pracuje nad tym od 2009 roku; w tej sprawie były dwa zespoły badawcze. Próbują to zrobić teraz w czasie rzeczywistym i będą dużo sprzątać.

Ale wciąż niewiele wiemy o implementacji. Jak to zrobią? Z sygnałem? Czy ci, którzy oszukują, będą gorzej indeksowani? Nikt nie może odpowiedzieć na to pytanie oprócz Johna Muellera.

Rebecca: Wątpię nawet jemu. Wyobrażam sobie, że będą trzymać się swojej linii: „stwórz przydatne treści dla użytkowników, a nie dla wyszukiwarek, a nie będziesz miał problemu”.

Vincent: Na Twitterze jest bombardowany pytaniami na ten temat, a jego odpowiedzi były dość szerokie.

Źródło: Twitter

Wpływ na tworzenie treści w przyszłości

Rebecca: Nie jestem tym zaskoczona. Myślę, że prawdopodobnie nie ma żadnych bardziej szczegółowych informacji. A nawet jeśli tak, to absolutnie zabrania się mówienia o algorytmie.

W każdym razie bardzo mi zależy na tym, aby zacząć oglądać patenty związane z tą aktualizacją, dokonać ponownej analizy patentów za rok, dwa lata, aby zobaczyć, co tam jest i czy są jakieś oznaki użycia trochę później. Ale to już inny temat.

Vincent: Aby przygotować się do mojej wrześniowej konferencji, wymieniłem, w jaki sposób rozpoznajemy wysokiej jakości treści, przydatne treści. Oparłem to na artykule z Journaldunet (w języku francuskim), gdzie Christian Meline napisał na ten temat [trzy] lata temu. Jego treść jest nadal całkowicie aktualna. Z drugiej strony nie opiera się na uczeniu maszynowym. Nienawidzi tego, więc są to podstawowe, przydatne wskaźniki: czy tytuł jest dobrze napisany? Czy są jakieś błędy ortograficzne? Czy dostarcza nowej wiedzy? Rzadkie rzeczy, do których potrzebne jest uczenie maszynowe.

Rebecca: Ten rodzaj porad będzie bardzo ważny, ponieważ większość SEO niekoniecznie ma zasoby, dane, czas lub tylko umiejętności, aby wdrożyć uczenie maszynowe, aby móc analizować swoje witryny, aby wiedzieć, czy istnieją ryzyko popadnięcia w to lub nie.

Vincent: Dokładnie. Musimy to bardzo, bardzo uważnie śledzić.

Ponadto musimy bardzo uważać na to, co mówimy. Musimy mówić w czasie warunkowym. Nikt nie jest pewien tego tematu.

Rebecca: To na pewno. Mamy tylko rzeczy bardzo wysokiego poziomu, co oznacza, że nie mamy dowodów, wskazówek ani informacji. Tak więc oczywiście wszystko, co możemy o tym powiedzieć, to nie wnioski, to teorie.

Vincent: Dokładnie.

Oto, co ustawiłem jako punkt wyjścia:

- Analiza tokenów, aby spojrzeć na powtórzenia: określić, kiedy jest przesadne, a kiedy chodzi tylko o ranking.

- Następnie prawdopodobieństwa między słowami, o których wspomniałem wcześniej.

- I wreszcie jedno, grupy słów.

Dzięki tym trzem kombinacjom mogę wykryć 90% tekstów generowanych przez AI, które nie zostały zoptymalizowane przez człowieka. Więc wyobraź sobie, co może zrobić Google! To oszałamiające.

Rebecca: Więc zdecydowanie powinniśmy wziąć udział w konferencji SEO Campus 23 września z Christianem.

Vincent: Tak, chcieliśmy nieco rozłożyć temat przydatnych treści. To zabawne: jeszcze zanim Google zaczął mówić o aktualizacji, mieliśmy to zaplanowane.

Podoba mi się również ten temat, ponieważ jestem bardzo proekologiczny. Czuję się lepiej, wiedząc, że istnieją takie elementy sterujące, które zapobiegają spamowaniu. Ponieważ kosztuje nas niewyobrażalne zasoby.

Rebecca: Tak, ma. Dzięki tej aktualizacji wszyscy zwracają szczególną uwagę. Myślę, że ludzie, którzy myślą, że to nic nie zmieni, są w błędzie. Widzimy, że zmieni to nie tylko sposób tworzenia treści, ale także sposób oceny treści przez Google. I to są strategie, których wcześniej nie widzieliśmy.

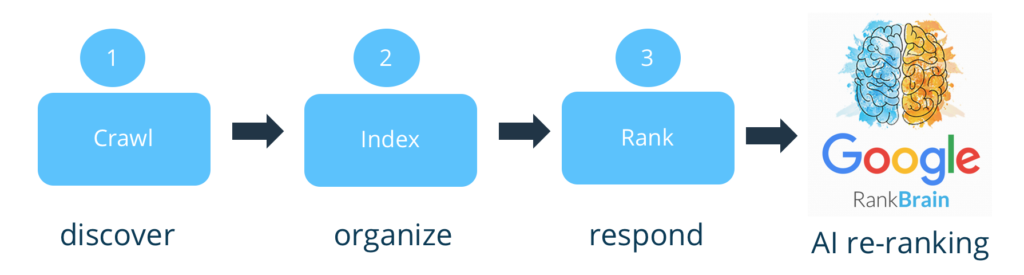

Vincent: Dokładnie. W rzeczywistości, jeśli chcesz zająć ekstremalne stanowisko, Google nie ocenia treści. To ogromna słabość. Kiedyś po prostu indeksował i klasyfikował. Teraz będą filtrować w górę. I to właśnie Bing krytykował Google za to, że tego nie robi.

Rebecca: Tak, większość analiz [na temat treści] pojawiła się w czasie rankingu.

Vincent: Zgadza się. Teraz wydaje się, że ma mały filtr. Zgadzam się z tobą: nie mogę się doczekać, aż zobaczę patent, który na to wychodzi. Będą musieli ujawnić, gdzie umieścili filtr. Założysz się, że gdzie umieścili filtr? Przed, po indeksowaniu czy przed, po rankingu? Gdzie byś to położył?

Rebecca: Ponieważ musisz mieć większość strony, aby móc to zrobić, powiedziałabym…

Vincent: Nie zapominaj, że do indeksowania potrzebujesz śladu SERP, o którym mówiliśmy. Więc musisz je zindeksować.

Rebecca: Tak, to właśnie chciałam powiedzieć. Myślę, że powinien to być dodatkowy krok, nie narażamy się na ryzyko deindeksowania, więc mówimy o wpływie po indeksowaniu, być może również po [początkowym] rankingu.

Vincent: Tak, dla mnie to już po rankingu. Gdybym był Google, dodałbym to do Google RankBrain, ponieważ jest w stanie agregować sygnały itp. Teraz pytanie brzmi, jak będzie to miało wpływ na witryny.

Rebecca: Dzięki uczeniu maszynowemu może się znacznie różnić w zależności od witryny, ponieważ możesz mieć znacznie większą kontrolę nad jego wpływem i ilością nieprzydatnych treści w każdej witrynie.

Vincent: Granica z Google to fałszywe alarmy. Byłoby to deindeksowanie [lub karanie] legalnych stron. Więc myślę, że początkowy wpływ będzie bardzo, bardzo niski, ale oni naprawdę będą ścigać oszustów.

Kontaktowali się ze mną ludzie, którzy byli trochę zaniepokojeni. Powiedziałem im, że na początku wykryje tylko tekst bez jakości. To znaczy, myślę, że [wygenerowany] tekst, uzupełniony ludzką korektą, może mieć całą swoją użyteczność.

Nie jestem tak surowy jak inni, którzy mówią „AI = śmieci”. W to też nie wierzę.

Rebecca: Nie dziwi mnie to, że pochodzisz od ciebie!

To trochę frustrujące, wiedząc, że będzie powoli. Jak mówisz, aby uniknąć fałszywych trafień, jest to kolejny powód, dla którego warto rozpocząć działalność w języku angielskim: lepiej władają językiem angielskim. Umożliwia to wprowadzenie dodatkowych kontroli, które są znacznie droższe, przed uogólnieniem na całą sieć i inne języki, które są gorzej opanowane, gorzej zautomatyzowane.

W każdym razie była to bardzo bogata dyskusja. Bardzo dziękuję za tę wymianę.

Vincent: Możemy jeszcze o tym porozmawiać, kiedy tylko zechcesz.

Rebecca: To była przyjemność.