Wir stellen vor: Fin: Intercoms bahnbrechender KI-Chatbot, der auf GPT-4 basiert

Veröffentlicht: 2023-03-15Die Einführung von ChatGPT von OpenAI veränderte alles – die enormen Auswirkungen auf den Kundenservice waren sofort offensichtlich.

Wir haben schnell eine Sammlung von KI-Funktionen für unseren Posteingang eingeführt und diese Technologie eingesetzt, um Effizienzgewinne zu erzielen. Aber die erste Frage, die uns gestellt wurde, war: „Kann ChatGPT einfach meine Kundenfragen beantworten?“ Es war einfach so klar, dass es die natürliche Sprache besser verstehen konnte als alles, was wir zuvor gesehen hatten.

Leider zeigten unsere anfänglichen Untersuchungen, dass Halluzinationen ein zu großes Problem darstellten. GPT-3.5, das ChatGPT antreibt, war einfach zu anfällig dafür, Dinge zu erfinden, wenn es die Antwort nicht kannte.

Aber die kürzliche Ankündigung von GPT-4 hat die Dinge geändert – dieses Modell wurde entwickelt, um Halluzinationen zu reduzieren. Wir freuen uns, Ihnen mitteilen zu können, was wir in unseren frühen Tests mit GPT-4 erstellt haben.

Wir stellen unseren neuen KI-Chatbot vor: Fin

Heute geben wir bekannt, dass wir einen KI-gestützten Kundenservice-Bot entwickelt haben, der die Vorteile dieser neuen Technologie bietet und für geschäftliche Anforderungen geeignet ist. Es heißt Fin und wir glauben, dass es das Potenzial hat, ein wertvoller Partner für Ihr Support-Team zu werden.

Als wir anfingen, mit dem Bau eines GPT-basierten Chatbots zu experimentieren, hatten wir eine Reihe von Designzielen im Sinn. Wir wollten einen Bot bauen, der Folgendes kann:

- Unterhalten Sie sich natürlich mit der GPT-Technologie.

- Beantworten Sie Fragen zu Ihrem Unternehmen anhand von Informationen, die Sie kontrollieren.

- Reduzieren Sie Halluzinationen und ungenaue Reaktionen auf ein akzeptables Maß.

- Minimale Konfiguration und Einrichtung erforderlich.

Wir glauben, dass uns dies gelungen ist. Unser neuer KI-Chatbot funktioniert „out of the box“ und reduziert sofort Ihr Supportvolumen und Ihre Lösungszeiten.

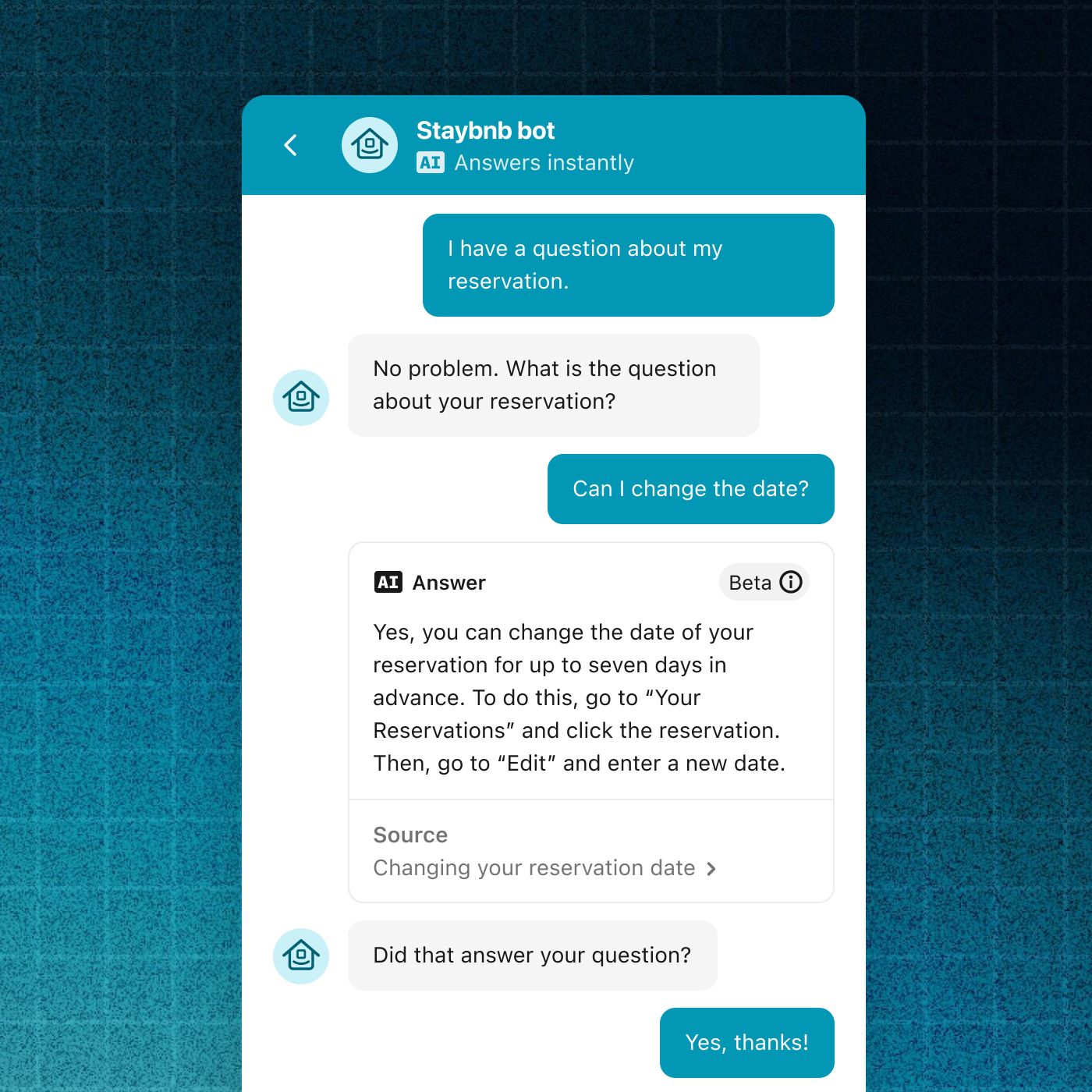

Es kann sich viel natürlicher über Supportanfragen unterhalten als bestehende Bots – und bringt die natürliche Konversationsfähigkeit moderner KI in den Kundenservice.

Es kann Fragen verstehen, die sich über mehrere Gesprächsrunden erstrecken, sodass Ihre Kunden Folgefragen stellen und zusätzliche Erläuterungen erhalten können.

Fin führt natürliche Gespräche mit Kunden

Wir haben GPT-4 um Funktionen und Sicherheitsvorkehrungen erweitert, die speziell auf die Bereitstellung von Kundensupport zugeschnitten sind, bei denen Vertrauen und Zuverlässigkeit von entscheidender Bedeutung sind.

Fin weigert sich, auf Fragen außerhalb der Domäne zu antworten

Fin ist so konzipiert, dass es nur Antworten basierend auf Inhalten in Ihrem bestehenden Hilfezentrum bereitstellt, wodurch die Genauigkeit und Vertrauenswürdigkeit erhöht wird. Um dieses Vertrauensgefühl zu stärken, verlinkt es immer auf seine Quellartikel, damit Ihre Kunden die Antworten validieren können.

Es ist nicht perfekt, wie wir weiter unten besprechen werden, aber wir glauben, dass es jetzt für viele Unternehmen bereit ist.

Fin erfordert praktisch keine anfängliche Einrichtungszeit. Es nimmt die Informationen in Ihr vorhandenes Intercom- oder Zendesk-Help-Center auf und nutzt die Leistungsfähigkeit der KI, um komplexe Kundenfragen sofort zu interpretieren und Ihr Help-Center-Wissen anzuwenden, um sie zu beantworten.

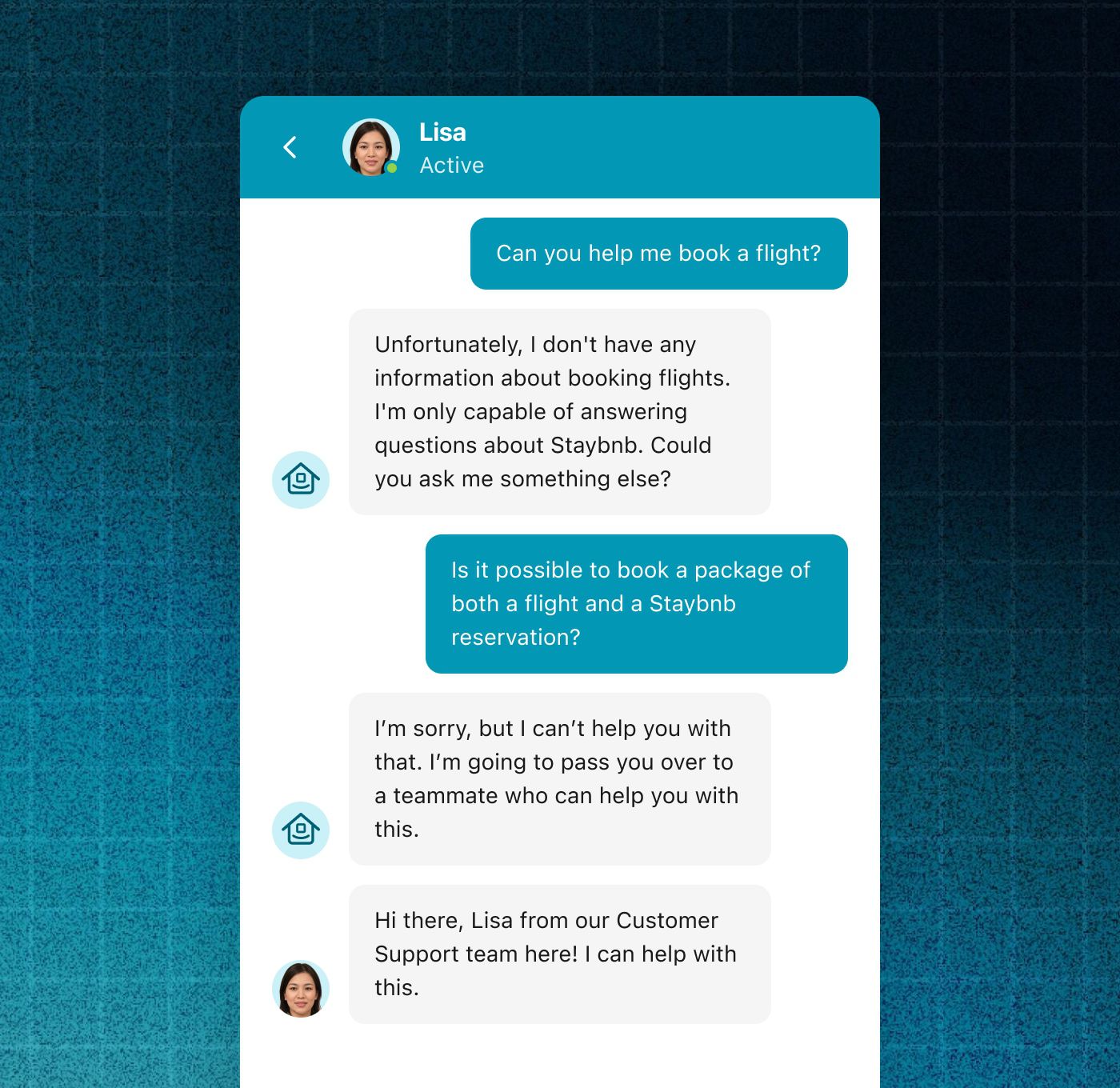

Der Chatbot wird zwangsläufig nicht alle Kundenanfragen beantworten können. In diesen Situationen kann es schwierigere Fragen nahtlos an menschliche Support-Teams weiterleiten. Es arbeitet effektiv als Teil des Kundendienstteams und nutzt alle Arbeitsabläufe, die Intercom ermöglicht.

Wenn Fin eine Frage nicht beantworten kann, kann sie nahtlos an einen CS-Mitarbeiter weitergeleitet werden, der dies kann

Wie wir diesen KI-Chatbot gebaut haben

Um Fin zu entwickeln, haben wir die bestehende Technologie hinter unserem Resolution Bot mit dem neuen GPT-4 von OpenAI kombiniert.

Wir haben Resolution Bot vor mehr als vier Jahren eingeführt und es funktioniert sehr gut, wenn es eingerichtet ist, aber es erfordert, dass „Antworten“ oder „Intents“ manuell kuratiert werden. Leider wissen wir, dass einige Kunden Schwierigkeiten haben, diese erste Hürde zu nehmen.

„Wir haben Fin so konzipiert, dass es das Wissen nutzt, das bereits in Ihrem Help Center vorhanden ist.“

Für unseren neuen Bot wollten wir diese Reibung reduzieren.

Daher haben wir es so konzipiert, dass es mit dem Wissen ausgeführt wird, das bereits für Ihr Hilfezentrum erstellt wurde. Es verarbeitet Ihre Help-Center-Artikel und verwendet die Informationen, um Kundenfragen direkt zu beantworten.

Wenn eine Frage gestellt wird, verwendet der Chatbot dann seine KI, um die Informationen aus dem Artikel automatisch in eine natürlich klingende Antwort umzuformulieren. Und wenn Sie einen Artikel aktualisieren, wird die Antwort des Bots fast sofort aktualisiert. Das bedeutet, dass Sie Ihre Hilfeinhalte nur an einem Ort pflegen müssen und die aktuellste Version automatisch an Kunden geliefert werden kann.

Dies bietet Unternehmen eine Möglichkeit, die Vorteile moderner KI auf sichere und vorhersehbare Weise zu nutzen und ihre bestehenden Prozesse rund um die Erstellung von Help-Center-Inhalten zu nutzen.

In Zukunft planen wir, weiter zu gehen und unsere andere maschinelle Lerntechnologie zu integrieren, um den KI-Bot bei der Beantwortung von Fragen zu unterstützen, indem wir die Erstanbieterdaten verwenden, die Sie über Ihre Kunden haben.

Erstellen eines vertrauenswürdigen Chatbots

Wir haben diesen Chatbot so konzipiert, dass er Fragen ausschließlich mithilfe von Hilfeinhalten beantwortet, die Sie bereits erstellt haben, um das Risiko ungenauer oder unerwarteter Antworten zu vermeiden. Dies gibt Ihnen ein hohes Maß an Kontrolle darüber, was Fin sagen kann.

„Einige andere GPT-Bots stützen ihre Antworten auf riesige Mengen an Informationen aus dem Internet, aber die Beschränkung der Informationen, die der Bot verwenden kann, erhöht seine Vorhersagbarkeit und Vertrauenswürdigkeit radikal.“

Wenn jemand eine Frage stellt, die nicht in Ihrer Hilfe behandelt wird, wird angezeigt, dass er die Antwort nicht kennt. Dies ist ein wichtiges Merkmal. Einige andere GPT-Bots basieren ihre Antworten auf riesigen Mengen an Informationen aus dem Internet, aber die Beschränkung der Informationen, die der Bot verwenden kann, erhöht seine Vorhersagbarkeit und Vertrauenswürdigkeit radikal.

Wir haben Ungenauigkeiten weiter verringert, indem wir eine neue Benutzeroberfläche für Fin mit Blick auf Vertrauenswürdigkeit entworfen haben – sie verlinkt eindeutig auf den Quellartikel, wenn eine Antwort gegeben wird, wodurch der Benutzer überprüfen kann, ob die Quelle relevant ist, wodurch die Auswirkungen kleinerer Fehler reduziert werden.

Fin wird immer eine Quelle für seine Antworten angeben, sodass Kunden seine Antworten überprüfen können

Wir haben auch Maßnahmen ergriffen, um die Fähigkeit des Benutzers zu verringern, den Bot zu einem Dialog zu einem Thema zu veranlassen, das nicht im Hilfecenter enthalten ist.

Einschränkungen

Genauigkeit

Es ist möglich, dass Endbenutzer die von uns entworfenen Einschränkungen absichtlich umgehen und den KI-Chatbot dazu bringen, unangemessene Dinge zu sagen. Wenn dies geschieht, glauben wir, dass dies nur nach entschlossenen Versuchen und nicht in natürlichen Interaktionen mit Kunden der Fall sein wird.

Wir müssen darauf hinweisen, dass die KI nicht perfekt ist. Es gibt einige Kunden, für die das Risiko irrelevanter oder falscher Informationen nicht akzeptabel ist. Sie möchten diesen KI-gestützten Chatbot vielleicht noch nicht übernehmen.

Große Sprachmodelle haben derzeit einen anderen Fehlermodus als frühere Bots, die wir erstellt haben, wie z. B. Resolution Bot. Während Resolution Bot manchmal eine irrelevante Antwort liefert, liefert unser KI-Bot manchmal eine falsche Antwort. Zum Beispiel könnte es durch den Inhalt eines Artikels verwirrt werden und dem Benutzer eine Aussage machen, die nicht wahr ist. Während diese Chance bei neueren Modellen stark zurückgegangen ist, ist sie nicht gleich null.

Damit Sie diese Einschränkung quantifizieren können, bauen wir eine Erfahrung auf, bei der Sie Ihr vorhandenes Hilfecenter in den Bot importieren und manuell testen können.

„Wir glauben, dass sich diese Modelle weiter verbessern werden und dass sich die Genauigkeit dadurch verbessern wird.“

Insgesamt sind wir angesichts der jüngsten Verbesserungen an GPT-4 und der von uns erstellten Designbeschränkungen zuversichtlich, dass seine Leistung über der von vielen Unternehmen geforderten Genauigkeitsgrenze liegt.

Mit Blick auf die Zukunft glauben wir, dass sich diese Modelle weiter verbessern werden und dass sich die Genauigkeit dadurch verbessern wird. Wir glauben auch, dass das Verständnis der Benutzer für die Einschränkungen dieser Technologie im Laufe der Zeit zunehmen wird; unsere KI-Bot-Antworten sind eindeutig als „KI“ gekennzeichnet, um dies zu ermöglichen.

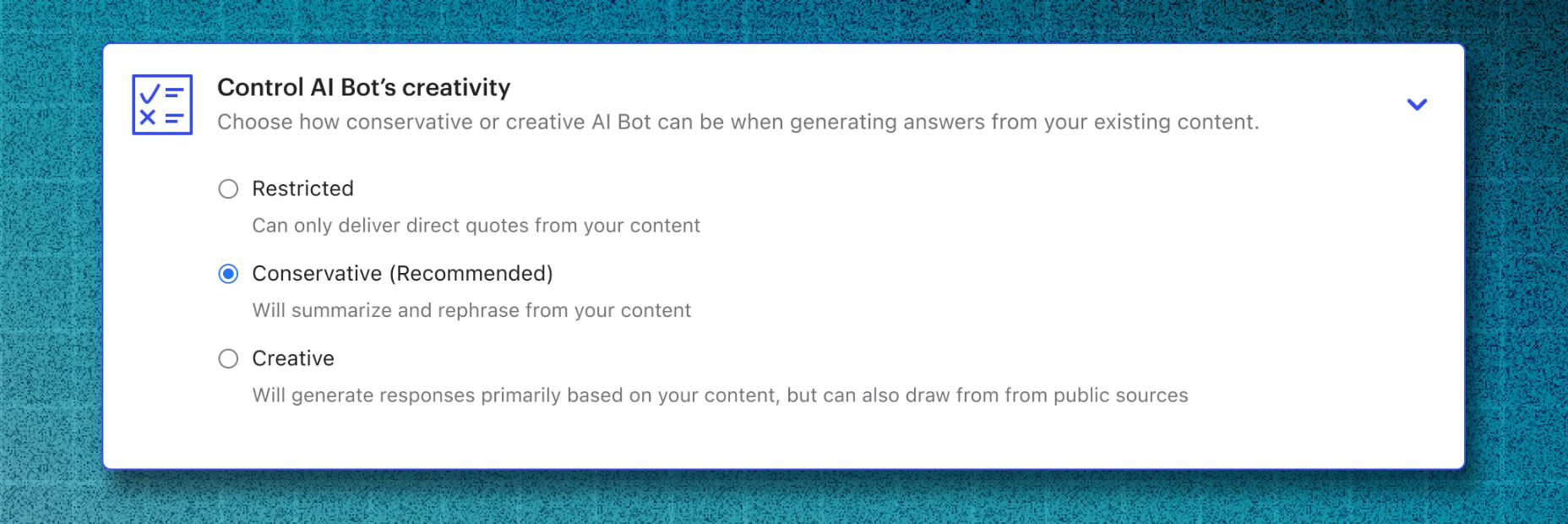

Schließlich glauben wir, dass verschiedene Unternehmen in diesem Bereich natürlich unterschiedliche Kompromisse eingehen werden. Insofern bauen wir Konfigurationseinstellungen auf, die es Unternehmen ermöglichen, den Kompromiss festzulegen, den sie eingehen möchten, wie in diesem Designprototyp zu sehen ist.

Wir untersuchen Konfigurationseinstellungen, um Fins Kreativität zu steuern

Kosten von GPT-Modellen

Es ist wichtig zu beachten, dass der Betrieb der großen Sprachmodelle, die für diesen Chatbot verwendet werden, derzeit teuer ist. Dies ist eine Spitzentechnologie, die viel Rechenleistung erfordert. Wir glauben jedoch, dass sich diese Kosten im Laufe der Zeit wahrscheinlich verringern werden.

Wir sind zuversichtlich, dass die Implementierung unseres KI-Chatbots für viele Unternehmen ROI-positiv sein wird, verglichen mit der Beantwortung der gleichen Fragen durch Support-Mitarbeiter.

Latenz

Schließlich haben fortgeschrittene große Sprachmodelle wie GPT-4 eine inhärente Latenz. Dies ist bei der Interaktion mit dem Bot zu sehen – 10 oder mehr Sekunden Latenz sind keine Seltenheit. Wir erwarten auch, dass sich dies im Laufe der Zeit verbessern wird.

Wie schnell wird Fin verfügbar sein?

Wir haben eine erste Version von Fin erstellt, die wir bisher für interne Tests verwendet haben, und werden bald in einer begrenzten Betaversion eingeführt. Im Moment sind unsere Haupteinschränkungen Kosten und Preise.

Wir sind weiterhin dabei, die Benutzererfahrung auf der Grundlage von Tests zu iterieren und zu verbessern und die Integration zwischen Fin und Resolution Bot zu iterieren. Wir glauben, dass fortgeschrittene Kunden Resolution Bot und ähnliche Technologien weiterhin verwenden werden, insbesondere in Situationen, in denen eine Maßnahme ergriffen werden muss, um die Anfrage des Benutzers vollständig zu lösen – wie beispielsweise das Stornieren einer Bestellung.

„Bei Intercom arbeiten wir seit langem an einer Zukunft, in der die meisten Kundengespräche ohne menschliche Unterstützung erfolgreich gelöst werden.“

Wir gehen davon aus, dass wir den Testprozess in den kommenden Wochen und Monaten zügig durchlaufen werden. Als Referenz: Die von uns Ende Januar angekündigten GPT-gestützten KI-Funktionen für den Posteingang stehen jetzt allen unseren Kunden zur Verfügung und werden bereits von Tausenden von ihnen verwendet.

Melden Sie sich für die Zukunft des Kundenservice an

Bei Intercom arbeiten wir seit langem an einer Zukunft, in der die meisten Kundengespräche erfolgreich gelöst werden können, ohne dass menschliche Unterstützung erforderlich ist, wodurch Ihr Team Zeit hat, an höherwertigen Kundengesprächen zu arbeiten.

Wir glauben, dass die heutige Ankündigung einen Paradigmenwechsel im Bereich Kundenservice markiert – die Zukunft findet gerade jetzt statt.

Hier können Sie mehr über den neuen KI-gestützten Bot erfahren und sich für die Warteliste anmelden.