25 melhores ferramentas de rastreamento da Web para extração eficiente de dados de sites

Publicados: 2023-06-15Uma introdução às ferramentas de rastreamento da Web

As ferramentas de rastreamento da Web, também conhecidas como spiders ou web scrapers, são essenciais para empresas que buscam extrair dados valiosos de sites para fins de análise e mineração de dados. Essas ferramentas têm uma ampla gama de aplicações, desde pesquisas de mercado até otimização de mecanismos de busca (SEO). Eles coletam dados de várias fontes públicas e os apresentam em um formato estruturado e utilizável. Ao usar ferramentas de rastreamento da Web, as empresas podem acompanhar notícias, mídias sociais, imagens, artigos, concorrentes e muito mais.

25 melhores ferramentas de rastreamento da Web para extrair dados de sites rapidamente

Scrapy

Scrapy é uma popular estrutura de rastreamento da Web baseada em Python de código aberto que permite aos desenvolvedores criar rastreadores da Web escaláveis. Ele oferece um conjunto abrangente de recursos que facilitam a implementação de rastreadores da Web e a extração de dados de sites. O Scrapy é assíncrono, o que significa que não faz solicitações uma de cada vez, mas em paralelo, resultando em rastreamento eficiente. Como uma ferramenta de rastreamento da web bem estabelecida, o Scrapy é adequado para projetos de raspagem da web em grande escala.

Características principais

- Ele gera exportações de feed em formatos como JSON, CSV e XML.

- Ele possui suporte integrado para selecionar e extrair dados de fontes por XPath ou expressões CSS.

- Permite extrair dados das páginas da web automaticamente usando aranhas.

- É rápido e poderoso , com uma arquitetura escalável e tolerante a falhas.

- É facilmente extensível , com um sistema de plug-in e uma API rica.

- É portátil , rodando em Linux, Windows, Mac e BSD.

Preços

- É uma ferramenta gratuita.

ParseHub

O ParseHub é uma ferramenta de rastreador da Web que pode coletar dados de sites que usam a tecnologia AJAX, JavaScript, cookies e muito mais. Sua tecnologia de aprendizado de máquina pode ler, analisar e transformar documentos da web em dados relevantes. O aplicativo de desktop do ParseHub oferece suporte aos sistemas operacionais Windows, Mac OS X e Linux. Ao oferecer uma interface amigável, o ParseHub foi projetado para não programadores que desejam extrair dados de sites.

Características principais

- Ele pode raspar sites dinâmicos que usam AJAX, JavaScript, rolagem infinita, paginação, menus suspensos, logins e outros elementos.

- É fácil de usar e não requer habilidades de codificação.

- É baseado em nuvem e pode armazenar dados em seus servidores.

- Ele suporta rotação de IP , coleta agendada , expressões regulares , API e web-hooks.

- Pode exportar dados nos formatos JSON e Excel .

Preços

- O ParseHub possui planos gratuitos e pagos. Os preços dos planos pagos começam em $ 149 por mês e oferecem velocidades de projeto atualizadas, um limite maior no número de páginas raspadas por execução e a capacidade de criar mais projetos.

Octoparse

O Octoparse é uma ferramenta de rastreamento da Web baseada em cliente que permite aos usuários extrair dados da Web em planilhas sem a necessidade de codificação. Com uma interface de apontar e clicar, o Octoparse foi desenvolvido especificamente para não codificadores. Os usuários podem criar seus próprios rastreadores da Web para coletar dados de qualquer site, e o Octoparse fornece raspadores pré-construídos para sites populares como Amazon, eBay e Twitter. A ferramenta também oferece recursos avançados, como extração de nuvem agendada, limpeza de dados e desvio de bloqueio com servidores proxy IP.

Características principais

- Interface de apontar e clicar : você pode selecionar facilmente os elementos da web que deseja raspar clicando neles, e o Octoparse identificará automaticamente os padrões de dados e extrairá os dados para você.

- Modo avançado : você pode personalizar suas tarefas de raspagem com várias ações, como inserir texto, clicar em botões, rolar páginas, percorrer listas, etc. Você também pode usar XPath ou RegEx para localizar os dados com precisão.

- Serviço de nuvem : você pode executar suas tarefas de raspagem nos servidores de nuvem da Octoparse 24 horas por dia, 7 dias por semana e armazenar seus dados na plataforma de nuvem. Você também pode agendar suas tarefas e usar a rotação automática de IP para evitar ser bloqueado por sites.

- API : Você pode acessar seus dados via API e integrá-los a outros aplicativos ou plataformas. Você também pode transformar quaisquer dados em APIs personalizadas com o Octoparse.

Preços

- Tem planos gratuitos e pagos. Os planos pagos começam em US$ 89/mês.

WebHarvyName

O WebHarvy é um software de raspagem da Web do tipo apontar e clicar projetado para não programadores. Ele pode extrair automaticamente texto, imagens, URLs e e-mails de sites e salvá-los em vários formatos, como XML, CSV, JSON ou TSV. O WebHarvy também suporta rastreamento anônimo e manipulação de sites dinâmicos, utilizando servidores proxy ou serviços VPN para acessar sites de destino.

Características principais

- Interface de apontar e clicar para selecionar dados sem codificação ou script

- Mineração de várias páginas com rastreamento e raspagem automáticos

- Raspagem de categoria para raspagem de dados de páginas ou listagens semelhantes

- Download de imagens das páginas de detalhes do produto de sites de comércio eletrônico

- Detecção automática de padrões para raspagem de listas ou tabelas sem configuração extra

- Extração baseada em palavras-chave enviando palavras-chave de entrada para formulários de pesquisa

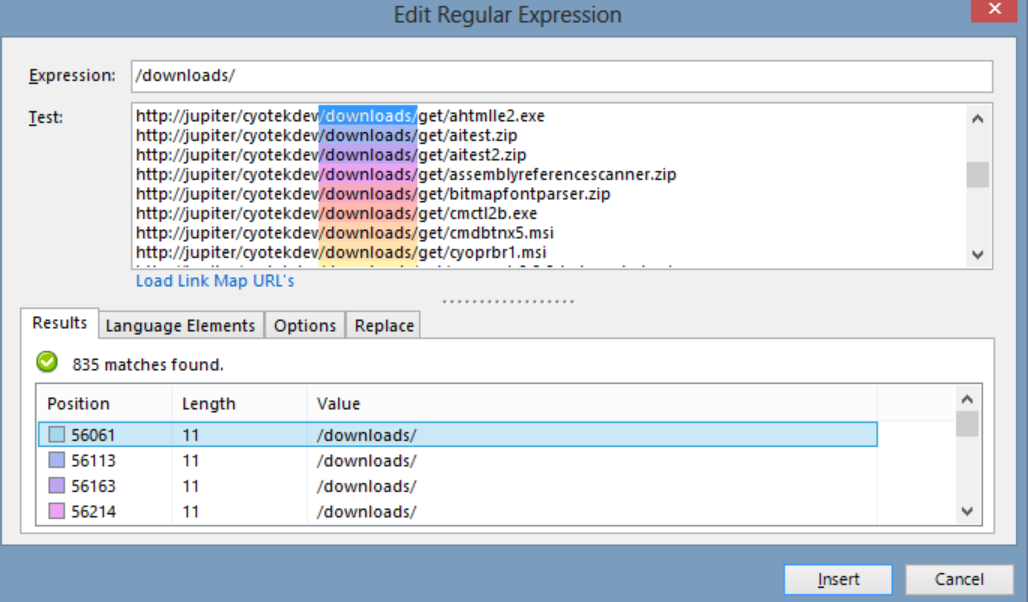

- Expressões regulares para mais flexibilidade e controle sobre a raspagem

- Interação automatizada do navegador para executar tarefas como clicar em links, selecionar opções, rolar e muito mais

Preços

- O WebHarvy é um software de raspagem da web que possui uma taxa de licença única.

- O preço da licença começa em $ 139 por um ano.

bela sopa

Beautiful Soup é uma biblioteca Python de código aberto usada para analisar documentos HTML e XML. Ele cria uma árvore de análise que facilita a extração de dados da web. Embora não seja tão rápido quanto o Scrapy, o Beautiful Soup é elogiado principalmente por sua facilidade de uso e suporte da comunidade quando surgem problemas.

Características principais

- Análise : Você pode usar o Beautiful Soup com vários analisadores, como html.parser, lxml, html5lib, etc., para analisar diferentes tipos de documentos da web.

- Navegando : Você pode navegar na árvore de análise usando métodos e atributos Pythonic, como find(), find_all(), select(), .children, .parent, .next_sibling, etc.

- Pesquisa : Você pode pesquisar a árvore de análise usando filtros, como nomes de tags, atributos, texto, seletores CSS, expressões regulares, etc., para encontrar os elementos que deseja.

- Modificação : você pode modificar a árvore de análise adicionando, excluindo, substituindo ou editando os elementos e seus atributos.

Preços

Beautiful Soup é uma biblioteca gratuita e de código aberto que você pode instalar usando pip.

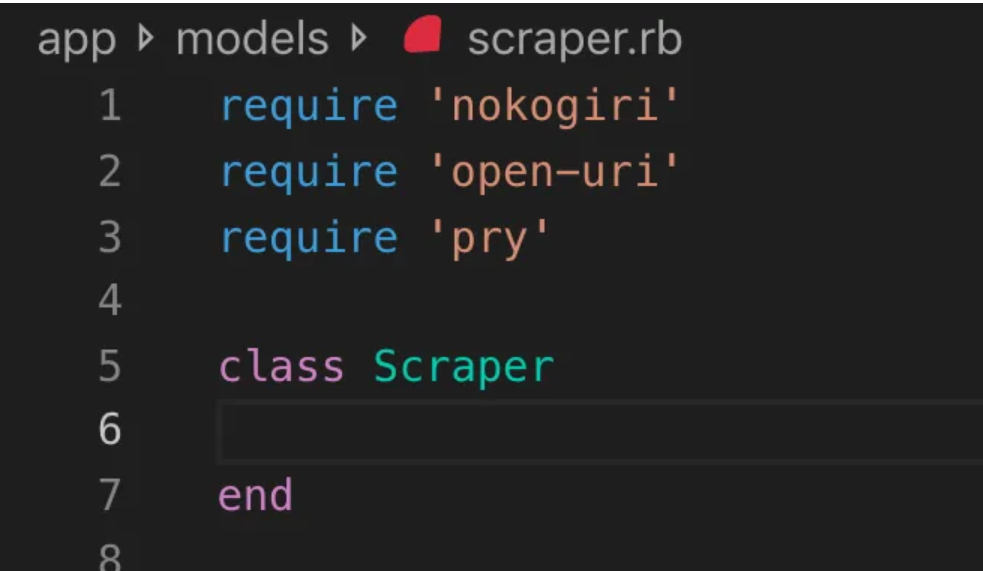

Nokogiri

Nokogiri é uma ferramenta de rastreamento da web que facilita a análise de documentos HTML e XML usando Ruby, uma linguagem de programação amigável para iniciantes no desenvolvimento da web. Nokogiri depende de analisadores nativos, como libxml2 de C e xerces de Java, tornando-o uma ferramenta poderosa para extrair dados de sites. É adequado para desenvolvedores da Web que desejam trabalhar com uma biblioteca de rastreamento da Web baseada em Ruby.

Características principais

- Analisador DOM para XML, HTML4 e HTML5

- Analisador SAX para XML e HTML4

- Analisador push para XML e HTML4

- Pesquisa de documentos via XPath 1.0

- Pesquisa de documentos via seletores CSS3, com algumas extensões do tipo jquery

- Validação do esquema XSD

- transformação XSLT

- DSL “Builder” para documentos XML e HTML

Preços

- Nokogiri é um projeto de código aberto de uso gratuito.

Zyte (anteriormente Scrapinghub)

Zyte (anteriormente Scrapinghub) é uma ferramenta de extração de dados baseada em nuvem que ajuda milhares de desenvolvedores a buscar dados valiosos de sites. Sua ferramenta de raspagem visual de código aberto permite que os usuários raspem sites sem nenhum conhecimento de programação. A Zyte usa o Crawlera, um rotador de proxy inteligente que permite ignorar as contra-medidas de bot para rastrear facilmente sites grandes ou protegidos por bot e permite que os usuários rastreiem de vários IPs e locais sem a dor do gerenciamento de proxy por meio de uma API HTTP simples.

Características principais

- Dados sob demanda: Forneça sites e requisitos de dados para Zyte, e eles entregam os dados solicitados em sua programação.

- Zyte AP I: Busca automaticamente HTML de sites usando o proxy mais eficiente e a configuração de extração, permitindo que você se concentre nos dados sem preocupações técnicas.

- Scrapy Cloud : Hospedagem escalável para seus spiders Scrapy, apresentando uma interface da Web amigável para gerenciar, monitorar e controlar seus rastreadores, completo com ferramentas de monitoramento, registro e controle de qualidade de dados.

- API de extração automática de dados : Acesse dados da web instantaneamente por meio da API de extração baseada em IA da Zyte, fornecendo dados estruturados de qualidade rapidamente. Integrar novas fontes torna-se mais simples com esta tecnologia patenteada.

Preços

Zyte tem um modelo de preços flexível que depende da complexidade e volume dos dados que você precisa. Você pode escolher entre três planos:

- Desenvolvedor: US$ 49/mês para 250 mil solicitações

- Negócios: US$ 299/mês para 2 milhões de solicitações

- Empresa: preços personalizados para mais de 10 milhões de solicitações

- Você também pode experimentar o Zyte gratuitamente com 10 mil solicitações por mês.

HTTrackName

O HTTrack é uma ferramenta de rastreamento da Web gratuita e de código aberto que permite aos usuários baixar sites inteiros ou páginas da Web específicas em seu dispositivo local para navegação off-line. Ele oferece uma interface de linha de comando e pode ser usado em sistemas Windows, Linux e Unix.

Características principais

- Ele preserva a estrutura de links relativa do site original.

- Ele pode atualizar um site espelhado existente e retomar downloads interrompidos.

- É totalmente configurável e possui um sistema de ajuda integrado.

- Ele suporta várias plataformas, como Windows, Linux, OSX, Android, etc.

- Possui uma versão de linha de comando e uma versão de interface gráfica do usuário.

Preços

- HTTrack é um software livre licenciado sob a GNU GPL.

Apache Nutch

O Apache Nutch é um rastreador da Web de código aberto extensível, frequentemente usado em campos como análise de dados. Ele pode buscar conteúdo por meio de protocolos como HTTPS, HTTP ou FTP e extrair informações textuais de formatos de documento como HTML, PDF, RSS e ATOM.

Características principais

- É baseado em estruturas de dados Apache Hadoop, que são ótimas para processamento em lote de grandes volumes de dados.

- Possui uma arquitetura altamente modular, permitindo que os desenvolvedores criem plug-ins para análise de tipo de mídia, recuperação de dados, consulta e clustering.

- Ele suporta várias plataformas, como Windows, Linux, OSX, Android, etc.

- Possui uma versão de linha de comando e uma versão de interface gráfica do usuário.

- Ele se integra ao Apache Tika para análise, Apache Solr e Elasticsearch para indexação e Apache HBase para armazenamento.

Preços

- O Apache Nutch é um software gratuito licenciado sob a Apache License 2.0.

Raspador de Hélio

O Helium Scraper é uma ferramenta visual de rastreamento de dados da Web que pode ser personalizada e controlada pelos usuários sem a necessidade de codificação. Ele oferece recursos avançados como rotação de proxy, extração rápida e suporte para vários formatos de dados, como Excel, CSV, MS Access, MySQL, MSSQL, XML ou JSON.

Características principais

- Extração rápida : delegue automaticamente tarefas de extração para navegadores separados

- Big Data : banco de dados SQLite pode conter até 140 terabytes

- Geração de banco de dados : as relações de tabela são geradas com base nos dados extraídos

- Geração SQL : junte e filtre rapidamente tabelas para exportação ou para dados de entrada

- Chamada de API : integre web scraping e chamada de API em um único projeto

- Manipulação de texto : Gere funções para corresponder, dividir ou substituir o texto extraído

- Suporte a JavaScript: injete e execute código JavaScript personalizado em qualquer site

- Rotação de proxy : insira uma lista de proxies e gire-os em qualquer intervalo

- Detecção de elementos semelhantes : detecta elementos semelhantes de uma ou duas amostras

- Detecção de lista : detecta automaticamente listas e linhas de tabelas em sites

- Exportação de dados : exporte dados para CSV, Excel, XML, JSON ou SQLite

- Agendamento : pode ser iniciado a partir da linha de comando ou do Agendador de Tarefas do Windows

Preços

- A licença básica custa US$ 99 por usuário.

Capturador de conteúdo (Sequentum)

O Content Grabber é um software de rastreamento da web voltado para empresas, permitindo que os usuários criem agentes de rastreamento da web independentes. Ele oferece recursos avançados como integração com análise de dados de terceiros ou aplicativos de relatórios, poderosa edição de scripts e interfaces de depuração e suporte para exportação de dados para relatórios do Excel, XML, CSV e a maioria dos bancos de dados.

Características principais

- Interface de apontar e clicar fácil de usar : detecta ações automaticamente com base em elementos HTML

- API robusta : suporta fácil integração de arrastar e soltar com pipelines de dados existentes

- Personalização : personalize seus agentes de raspagem com linguagens de codificação comuns, como Python, C#, JavaScript, expressões regulares

- Integração : Integre bibliotecas de AI, ML, NLP ou APIs de terceiros para enriquecimento de dados

- Confiabilidade e escala : mantenha os custos de infraestrutura baixos enquanto desfruta do monitoramento em tempo real das operações de ponta a ponta

- Conformidade legal : diminua sua responsabilidade e reduza o risco associado a processos judiciais caros e multas regulatórias

- Exportação de dados : exporte dados para qualquer formato e entregue em qualquer endpoint

- Agendamento : inicie seus agentes de raspagem na linha de comando ou no Agendador de Tarefas do Windows

Preços

- A licença básica custa $ 27.500 por ano e permite que você use o software em um computador.

Cyotek WebCopy

O Cyotek WebCopy é um rastreador de sites gratuito que permite aos usuários copiar sites parciais ou completos localmente em seu disco rígido para referência off-line. Ele pode detectar e seguir links dentro de um site e remapear links automaticamente para corresponder ao caminho local. No entanto, o WebCopy não inclui um DOM virtual ou qualquer forma de análise de JavaScript, portanto, pode não lidar corretamente com layouts de sites dinâmicos devido ao uso intenso de JavaScript.

Características principais

- Interface de apontar e clicar fácil de usar com detecção automática de ação baseada em elementos HTML

- API robusta para integração perfeita com pipelines de dados existentes por meio da funcionalidade simples de arrastar e soltar

- Opções de personalização usando linguagens de codificação populares, como Python, C#, JavaScript e Expressões Regulares para adaptar os agentes de raspagem às necessidades específicas

- Recursos de integração com bibliotecas de AI, ML, NLP ou APIs de terceiros para enriquecer os dados extraídos

- Infraestrutura confiável e escalável com monitoramento em tempo real para operações econômicas

- Recursos de conformidade legal para reduzir a responsabilidade e mitigar o risco de ações judiciais e multas regulatórias

- Exportação de dados para qualquer formato desejado e entrega para vários endpoints

- As opções de agendamento permitem iniciar agentes de raspagem a partir da linha de comando ou do Agendador de Tarefas do Windows

Preços

- A licença básica custa $ 27.500 por ano e permite que você use o software em um computador.

80 pernas

O 80legs é uma poderosa ferramenta de rastreamento da web que pode ser configurada com base em requisitos personalizados. Ele suporta a busca de grandes quantidades de dados junto com a opção de baixar os dados extraídos instantaneamente. A ferramenta oferece uma API para os usuários criarem rastreadores, gerenciar dados e muito mais. Alguns de seus principais recursos incluem personalização de scraper, servidores IP para solicitações de web scraping e uma estrutura de aplicativo baseada em JS para configurar rastreamentos da web com comportamentos personalizados.

Características principais

- Escalável e rápido : você pode rastrear até 2 bilhões de páginas por dia com mais de 50.000 solicitações simultâneas.

- Flexível e personalizável: você pode usar seu próprio código para controlar a lógica de rastreamento e a extração de dados ou usar as ferramentas e modelos integrados.

Preços

- Você pode escolher entre diferentes planos de preços com base em suas necessidades, começando em US$ 29/mês para 100.000 URLs/rastreamento até US$ 299/mês para 10 milhões de URLs/rastreamento.

Webhose.io

O Webhose.io permite que os usuários obtenham dados em tempo real rastreando fontes online de todo o mundo e apresentando-os em vários formatos limpos. Essa ferramenta de rastreador da Web pode rastrear dados e extrair palavras-chave em diferentes idiomas usando vários filtros que cobrem uma ampla variedade de fontes. Os usuários podem salvar os dados copiados nos formatos XML, JSON e RSS e acessar os dados históricos de seu arquivo. O Webhose.io oferece suporte a até 80 idiomas com seus resultados de dados de rastreamento, permitindo que os usuários indexem e pesquisem facilmente os dados estruturados rastreados pela ferramenta.

Características principais

- Vários formatos : você pode obter dados nos formatos XML, JSON, RSS ou Excel.

- Resultados estruturados : você pode obter dados normalizados, enriquecidos e categorizados de acordo com suas necessidades.

- Dados históricos : você pode acessar dados arquivados dos últimos 12 meses ou mais.

- Ampla cobertura : você pode obter dados de mais de um milhão de fontes em 80 idiomas e 240 países.

- Variedade de fontes : você pode obter dados de sites de notícias, blogs, fóruns, painéis de mensagens, comentários, críticas e muito mais.

- Integração rápida : você pode integrar o Webhose.io com seus sistemas em minutos com uma API REST simples.

Preços

- Possui um plano gratuito que permite fazer 1000 solicitações por mês sem nenhum custo. Ele também possui planos personalizados que você pode contatá-los para uma cotação.

mozenda

O Mozenda é um software de raspagem da web baseado em nuvem que permite aos usuários extrair dados da web sem escrever uma única linha de código. Ele automatiza o processo de extração de dados e oferece recursos como extração de dados programada, limpeza de dados e desvio de bloqueio com servidores proxy IP. O Mozenda foi projetado para empresas, com uma interface amigável e recursos poderosos de raspagem.

Características principais

- Análise de texto: você pode extrair e analisar dados de texto de qualquer site usando técnicas de processamento de linguagem natural.

- Extração de imagem: você pode baixar e salvar imagens de páginas da web ou extrair metadados de imagem, como tamanho, formato, resolução, etc.

- Coleta de dados diferentes: você pode coletar dados de várias fontes e formatos, como HTML, XML, JSON, RSS, etc.

- Extração de documentos: você pode extrair dados de PDF, Word, Excel e outros tipos de documentos usando o reconhecimento óptico de caracteres (OCR) ou métodos de extração de texto.

- Extração de endereço de e-mail : você pode localizar e extrair endereços de e-mail de páginas da Web ou documentos usando expressões regulares ou correspondência de padrões.

Preços

- O plano pago começa em $ 99 por mês.

UiPathName

O UiPath é um software de automação de processos robóticos (RPA) para raspagem gratuita na web. Ele automatiza o rastreamento de dados da Web e da área de trabalho da maioria dos aplicativos de terceiros. Compatível com Windows, o UiPath pode extrair dados tabulares e baseados em padrões em várias páginas da web. O software também oferece ferramentas integradas para rastrear e manipular interfaces de usuário complexas.

Características principais

- Análise de texto : extraia e analise dados de texto usando processamento de linguagem natural, expressões regulares e correspondência de padrões para tarefas como extração de endereço de e-mail.

- Extração de imagem : baixe e salve imagens de páginas da web, extraia metadados de imagem, incluindo tamanho, formato e resolução.

- Coleta de dados diferentes : reúna dados de várias fontes e formatos como HTML, XML, JSON, RSS, com recursos de integração para conexão com outros serviços online e APIs.

- Extração de documentos : extraia dados de PDF, Word, Excel e outros tipos de documentos usando OCR ou métodos de extração de texto. Processe e extraia informações em diferentes tipos de documentos e estruturas com recursos de compreensão de documentos.

- Automação da Web : automatize atividades baseadas na Web, como fazer login, navegar pelas páginas, preencher formulários e clicar em botões. Utilize o recurso de gravador para capturar ações e gerar scripts de automação.

Preços

- o pago plano começa em $ 420 por mês.

Centro OutWit

OutWit Hub é um complemento do Firefox com dezenas de recursos de extração de dados para simplificar as pesquisas na web dos usuários. Esta ferramenta de rastreador da web pode navegar pelas páginas e armazenar as informações extraídas em um formato adequado. O OutWit Hub oferece uma interface única para coletar pequenas ou grandes quantidades de dados por necessidade e pode criar agentes automáticos para extrair dados de vários sites em questão de minutos.

Características principais

- Visualizar e exportar conteúdo da web: você pode visualizar os links, documentos, imagens, contatos, tabelas de dados, feeds RSS, endereços de e-mail e outros elementos contidos em uma página da web. Você também pode exportá-los para HTML, SQL, CSV, XML, JSON ou outros formatos.

- Organize dados em tabelas e listas: você pode classificar, filtrar, agrupar e editar os dados coletados em tabelas e listas. Você também pode usar vários critérios para selecionar os dados que deseja extrair.

- Configure funções automatizadas : você pode usar o recurso de raspagem para criar raspadores personalizados que podem extrair dados de qualquer site usando comandos simples ou avançados. Você também pode usar o recurso de macro para automatizar a navegação na web e as tarefas de raspagem.

- Gerar consultas e URLs: você pode usar o recurso de consulta para gerar consultas com base em palavras-chave ou padrões. Você também pode usar o recurso de URL para gerar URLs com base em padrões ou parâmetros.

Preços

- A licença Light é gratuita e totalmente operacional, mas não inclui os recursos de automação e limita a extração a uma ou algumas centenas de linhas, dependendo do extrator.

- A licença Pro custa US$ 110 por ano e inclui todos os recursos da licença Light, além dos recursos de automação e extração ilimitada.

Raspador visual

O Visual Scraper, além de ser uma plataforma SaaS, também oferece serviços de web scraping, como serviços de entrega de dados e criação de extratores de software para clientes. Esta ferramenta de rastreamento da web cobre todo o ciclo de vida de um rastreador, desde o download, gerenciamento de URL até a extração de conteúdo. Ele permite que os usuários agendem projetos para execução em horários específicos ou repitam sequências a cada minuto, dia, semana, mês ou ano. O Visual Scraper é ideal para usuários que desejam extrair notícias, atualizações e fóruns com frequência. No entanto, o site oficial parece não estar atualizado agora e essas informações podem não estar atualizadas.

Características principais

- Interface fácil de usar

- Suporta vários formatos de dados (CSV, JSON, XML, etc.)

- Suporta paginação, AJAX e sites dinâmicos

- Suporta servidores proxy e rotação de IP

- Suporta agendamento e automação

Preços

- Possui um plano gratuito e planos pagos a partir de $ 39,99 por mês.

Import.io

Import.io é uma ferramenta de web scraping que permite aos usuários importar dados de uma página da web específica e exportá-los para CSV sem escrever nenhum código. Ele pode coletar facilmente milhares de páginas da Web em minutos e criar mais de 1.000 APIs com base nos requisitos dos usuários. O Import.io integra os dados da web ao aplicativo ou site do usuário com apenas alguns cliques, facilitando a raspagem da web.

Características principais

- Seleção e treinamento de apontar e clicar

- Extração autenticada e interativa

- Downloads de imagens e capturas de tela

- Proxies premium e extratores específicos do país

- CSV, Excel, saída JSON e acesso à API

- SLA e relatórios de qualidade de dados

- Suporte por e-mail, ticket, chat e telefone

Preços

- Iniciante: $ 199 por mês para 5.000 consultas

Dexi.io

O Dexi.io é um rastreador da Web baseado em navegador que permite aos usuários extrair dados com base em seu navegador de qualquer site e fornece três tipos de robôs para criar uma tarefa de raspagem - Extractor, Crawler e Pipes. O freeware fornece servidores proxy da web anônimos e os dados extraídos serão hospedados nos servidores do Dexi.io por duas semanas antes de os dados serem arquivados, ou os usuários podem exportar diretamente os dados extraídos para arquivos JSON ou CSV. Oferece serviços pagos para usuários que precisam de extração de dados em tempo real.

Características principais

- Seleção e treinamento de apontar e clicar

- Extração autenticada e interativa

- Downloads de imagens e capturas de tela

- Proxies premium e extratores específicos do país

- CSV, Excel, saída JSON e acesso à API

- SLA e relatórios de qualidade de dados

- Suporte por e-mail, ticket, chat e telefone

Preços

- Padrão: $ 119 por mês ou $ 1.950 por ano para 1 funcionário

marionetista

Puppeteer é uma biblioteca Node desenvolvida pelo Google, fornecendo uma API para programadores controlarem o Chrome ou Chromium pelo protocolo DevTools. Ele permite que os usuários criem uma ferramenta de raspagem da web com Puppeteer e Node.js. O Puppeteer pode ser utilizado para várias finalidades, como tirar screenshots ou gerar PDFs de páginas da Web, automatizar envios de formulários/entrada de dados e criar ferramentas para testes automatizados.

Características principais

- Gere capturas de tela e PDFs de páginas da web

- Rastreie e raspe dados de sites

- Automatize o envio de formulários, teste de interface do usuário, entrada de teclado, etc.

- Capture métricas e rastreamentos de desempenho

- Testar extensões do Chrome

- Executar no modo headless ou headful

Preços

- O Puppeteer é gratuito e de código aberto.

Crawler4j

Crawler4j é um rastreador da web Java de código aberto com uma interface simples para rastrear a web. Ele permite que os usuários criem rastreadores multiencadeados enquanto são eficientes no uso da memória. Crawler4j é adequado para desenvolvedores que desejam uma solução de rastreamento da Web direta e personalizável baseada em Java.

Características principais

- Ele permite que você especifique quais URLs devem ser rastreados e quais devem ser ignorados usando expressões regulares.

- Permite manipular as páginas baixadas e extrair dados delas.

- Ele respeita o protocolo robots.txt e evita o rastreamento de páginas não permitidas.

- Ele pode rastrear HTML, imagens e outros tipos de arquivo.

- Ele pode coletar estatísticas e executar vários rastreadores simultaneamente.

Preços

- Crawler4j é um projeto Java de código aberto que permite configurar e executar facilmente seus próprios rastreadores da Web.

Rastreamento Comum

O Common Crawl é uma ferramenta de rastreador da web que fornece um corpus aberto de dados da web para fins de pesquisa, análise e educação.

Características principais

- Ele oferece aos usuários acesso a dados de rastreamento da Web, como dados brutos de páginas da Web, metadados extraídos e texto, bem como o Common Crawl Index.

Preços

- Esses dados de rastreamento da Web gratuitos e acessíveis ao público podem ser usados por desenvolvedores, pesquisadores e empresas para várias tarefas de análise de dados.

Sopa Mecânica

MechanicalSoup é uma biblioteca Python usada para analisar sites, baseada na biblioteca Beautiful Soup, com inspiração na biblioteca Mechanize. É ótimo para armazenar cookies, seguir redirecionamentos, hiperlinks e manipular formulários em um site.

Características principais

- MechanicalSoup oferece uma maneira simples de navegar e extrair dados de sites sem ter que lidar com tarefas complexas de programação.

Preços

- É uma ferramenta gratuita.

Rastreador de nó

O Node Crawler é um pacote popular e poderoso para rastrear sites com a plataforma Node.js. Ele é executado com base no Cheerio e vem com muitas opções para personalizar a maneira como os usuários rastreiam ou raspam a web, incluindo limitar o número de solicitações e o tempo gasto entre elas. O Node Crawler é ideal para desenvolvedores que preferem trabalhar com Node.js em seus projetos de rastreamento da web.

Características principais

- Fácil de usar

- API orientada a eventos

- Novas tentativas e tempos limite configuráveis

- Detecção automática de codificação

- Tratamento automático de cookies

- Tratamento de redirecionamento automático

- Manipulação automática de gzip/deflate

Preços

- É uma ferramenta gratuita.

Fatores a considerar ao escolher uma ferramenta de rastreamento da Web

Preços

Considere a estrutura de preços da ferramenta escolhida e garanta que ela seja transparente, sem custos ocultos. Opte por uma empresa que ofereça um modelo de preços claro e forneça informações detalhadas sobre os recursos disponíveis.

Fácil de usar

Escolha uma ferramenta de rastreamento da web que seja fácil de usar e não exija amplo conhecimento técnico. Muitas ferramentas oferecem interfaces de apontar e clicar, tornando mais fácil para não programadores extrair dados de sites.

Escalabilidade

Considere se a ferramenta de rastreamento da web pode lidar com o volume de dados que você precisa extrair e se ela pode crescer junto com sua empresa. Algumas ferramentas são mais adequadas para projetos de pequena escala, enquanto outras são projetadas para extração de dados em grande escala.

Qualidade e precisão dos dados

Certifique-se de que a ferramenta de rastreamento da Web possa limpar e organizar os dados extraídos em um formato utilizável. A qualidade dos dados é crucial para uma análise precisa, então escolha uma ferramenta que forneça recursos eficientes de limpeza e organização de dados.

Suporte ao cliente

Escolha uma ferramenta de rastreamento da Web com suporte ao cliente responsivo e útil para ajudá-lo quando surgirem problemas. Teste o suporte ao cliente entrando em contato com eles e observando quanto tempo leva para eles responderem antes de tomar uma decisão informada.

Conclusão

As ferramentas de rastreamento da Web são essenciais para empresas que desejam extrair dados valiosos de sites para várias finalidades, como pesquisa de mercado, SEO e análise competitiva. Ao considerar fatores como preço, facilidade de uso, escalabilidade, qualidade e precisão dos dados e suporte ao cliente, você pode escolher a ferramenta de rastreamento da Web certa que atenda às suas necessidades. As 25 principais ferramentas de rastreamento da Web mencionadas acima atendem a uma variedade de usuários, de não programadores a desenvolvedores, garantindo que haja uma ferramenta adequada para todos. Você também pode se inscrever para uma avaliação gratuita de 7 dias com Scalenut para otimizar o conteúdo do seu site e melhorar sua classificação.