25 เครื่องมือรวบรวมข้อมูลเว็บที่ดีที่สุดสำหรับการดึงข้อมูลจากเว็บไซต์อย่างมีประสิทธิภาพ

เผยแพร่แล้ว: 2023-06-15ข้อมูลเบื้องต้นเกี่ยวกับเครื่องมือรวบรวมข้อมูลเว็บ

เครื่องมือรวบรวมข้อมูลเว็บหรือที่เรียกว่าสไปเดอร์หรือเว็บสแครปเปอร์เป็นสิ่งจำเป็นสำหรับธุรกิจที่ต้องการดึงข้อมูลที่มีค่าจากเว็บไซต์เพื่อการวิเคราะห์และการทำเหมืองข้อมูล เครื่องมือเหล่านี้มีแอปพลิเคชันที่หลากหลายตั้งแต่การวิจัยตลาดไปจนถึงการปรับแต่งโปรแกรมค้นหา (SEO) พวกเขารวบรวมข้อมูลจากแหล่งข้อมูลสาธารณะต่างๆ และนำเสนอในรูปแบบที่มีโครงสร้างและใช้งานได้ ด้วยการใช้เครื่องมือรวบรวมข้อมูลเว็บ บริษัทต่างๆ สามารถติดตามข่าวสาร โซเชียลมีเดีย รูปภาพ บทความ คู่แข่ง และอื่นๆ อีกมากมาย

25 สุดยอดเครื่องมือรวบรวมข้อมูลเว็บเพื่อดึงข้อมูลจากเว็บไซต์อย่างรวดเร็ว

กระท่อนกระแท่น

Scrapy เป็นเฟรมเวิร์กการรวบรวมข้อมูลเว็บที่ใช้ Python แบบโอเพ่นซอร์สยอดนิยมซึ่งช่วยให้นักพัฒนาสามารถสร้างโปรแกรมรวบรวมข้อมูลเว็บที่ปรับขนาดได้ มีชุดคุณลักษณะที่ครอบคลุมซึ่งช่วยให้ติดตั้งโปรแกรมรวบรวมข้อมูลเว็บและดึงข้อมูลจากเว็บไซต์ได้ง่ายขึ้น Scrapy ทำงานแบบอะซิงโครนัส หมายความว่าจะไม่ส่งคำขอทีละรายการ แต่ดำเนินการพร้อมกัน ส่งผลให้การรวบรวมข้อมูลมีประสิทธิภาพ ในฐานะที่เป็นเครื่องมือรวบรวมข้อมูลเว็บที่มีชื่อเสียง Scrapy เหมาะสำหรับโครงการขูดเว็บขนาดใหญ่

คุณสมบัติที่สำคัญ

- สร้าง การส่งออกฟีด ในรูปแบบต่างๆ เช่น JSON, CSV และ XML

- มีการสนับสนุนในตัวสำหรับ การเลือกและแยกข้อมูล จากแหล่งที่มาโดยใช้ XPath หรือ CSS expressions

- อนุญาตให้ ดึงข้อมูล จากหน้าเว็บโดยอัตโนมัติโดยใช้สไปเดอร์

- มี ความรวดเร็วและทรงพลัง พร้อมด้วยสถาปัตยกรรมที่ปรับขนาดได้และทนทานต่อข้อผิดพลาด

- ขยายได้ง่าย ด้วยระบบปลั๊กอินและ API ที่สมบูรณ์

- เป็น แบบพกพา ทำงานบน Linux, Windows, Mac และ BSD

ราคา

- เป็นเครื่องมือฟรี

ParseHub

ParseHub เป็นเครื่องมือรวบรวมข้อมูลเว็บที่สามารถรวบรวมข้อมูลจากเว็บไซต์ที่ใช้เทคโนโลยี AJAX, JavaScript, คุกกี้ และอื่นๆ เทคโนโลยีแมชชีนเลิร์นนิงสามารถอ่าน วิเคราะห์ และแปลงเอกสารบนเว็บให้เป็นข้อมูลที่เกี่ยวข้องได้ แอปพลิเคชันเดสก์ท็อปของ ParseHub รองรับระบบปฏิบัติการ Windows, Mac OS X และ Linux ด้วยอินเทอร์เฟซที่เป็นมิตรต่อผู้ใช้ ParseHub ได้รับการออกแบบมาสำหรับผู้ที่ไม่ใช่โปรแกรมเมอร์ที่ต้องการดึงข้อมูลจากเว็บไซต์

คุณสมบัติที่สำคัญ

- สามารถขูด เว็บไซต์ไดนามิก ที่ใช้ AJAX, JavaScript, การเลื่อนไม่สิ้นสุด, การแบ่งหน้า, เมนูแบบเลื่อนลง, การเข้าสู่ระบบ และองค์ประกอบอื่นๆ

- ใช้งานง่าย และไม่ต้องใช้ทักษะการเขียนโค้ด

- เป็น ระบบคลาวด์ และสามารถจัดเก็บข้อมูลบนเซิร์ฟเวอร์ได้

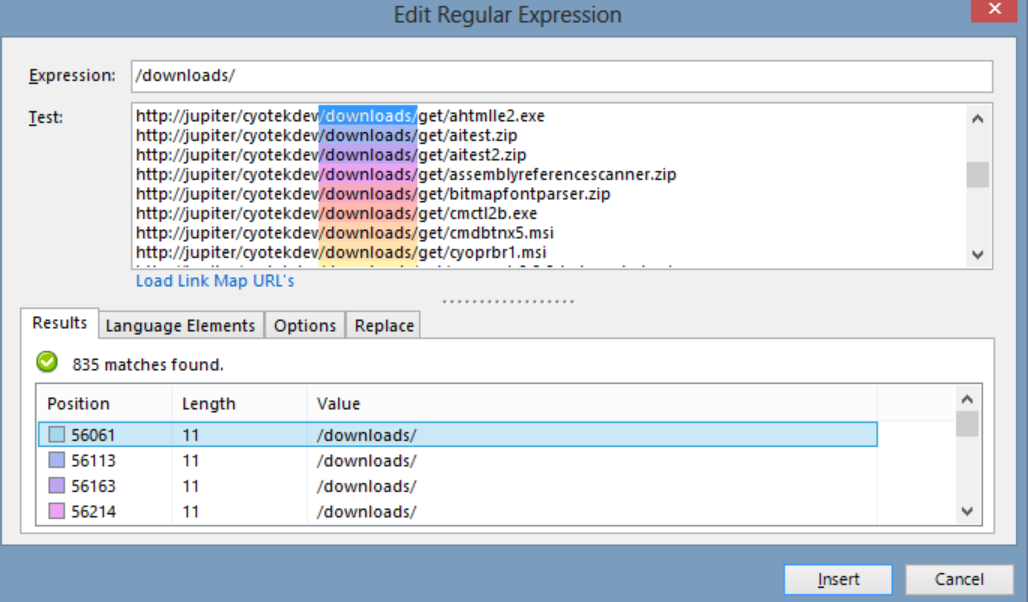

- รองรับ การหมุนเวียน IP การรวบรวมตามกำหนดเวลา นิพจน์ทั่วไป API และเว็บฮุค

- สามารถส่งออกข้อมูลในรูปแบบ JSON และ Excel

ราคา

- ParseHub มีทั้งแบบฟรีและแบบชำระเงิน ราคาสำหรับแผนชำระเงินเริ่มต้นที่ 149 ดอลลาร์ต่อเดือนและเสนอความเร็วโครงการที่อัปเกรด ขีดจำกัดที่สูงขึ้นของจำนวนหน้าที่คัดลอกต่อการเรียกใช้งาน และความสามารถในการสร้างโครงการเพิ่มเติม

ออกโตพาร์ส

Octoparse เป็นเครื่องมือรวบรวมข้อมูลเว็บตามไคลเอ็นต์ที่ช่วยให้ผู้ใช้สามารถแยกข้อมูลเว็บออกเป็นสเปรดชีตโดยไม่ต้องใช้โค้ด ด้วยอินเทอร์เฟซแบบชี้แล้วคลิก Octoparse ถูกสร้างขึ้นโดยเฉพาะสำหรับผู้ที่ไม่ใช่ผู้เขียนโค้ด ผู้ใช้สามารถสร้างโปรแกรมรวบรวมข้อมูลเว็บของตนเองเพื่อรวบรวมข้อมูลจากเว็บไซต์ใดก็ได้ และ Octoparse มีโปรแกรมขูดที่สร้างไว้ล่วงหน้าสำหรับเว็บไซต์ยอดนิยม เช่น Amazon, eBay และ Twitter เครื่องมือนี้ยังมีคุณสมบัติขั้นสูง เช่น การแยกข้อมูลบนคลาวด์ตามกำหนดเวลา การล้างข้อมูล และการบายพาสการบล็อกด้วยเซิร์ฟเวอร์พร็อกซี IP

คุณสมบัติที่สำคัญ

- อินเทอร์เฟซแบบชี้และคลิก : คุณสามารถเลือกองค์ประกอบเว็บที่คุณต้องการขูดได้อย่างง่ายดายโดยคลิกที่องค์ประกอบเหล่านั้น และ Octoparse จะระบุรูปแบบข้อมูลและดึงข้อมูลให้คุณโดยอัตโนมัติ

- โหมดขั้นสูง : คุณสามารถปรับแต่งงานขูดของคุณด้วยการกระทำต่างๆ เช่น การป้อนข้อความ การคลิกปุ่ม การเลื่อนหน้า การวนซ้ำผ่านรายการ ฯลฯ คุณยังสามารถใช้ XPath หรือ RegEx เพื่อค้นหาข้อมูลได้อย่างแม่นยำ

- บริการคลาวด์ : คุณสามารถเรียกใช้งานการขูดบนเซิร์ฟเวอร์คลาวด์ของ Octoparse ได้ตลอด 24 ชั่วโมงทุกวัน และจัดเก็บข้อมูลของคุณในแพลตฟอร์มคลาวด์ คุณยังสามารถกำหนดเวลางานของคุณและใช้การหมุนเวียน IP อัตโนมัติเพื่อหลีกเลี่ยงการถูกบล็อกโดยเว็บไซต์

- API : คุณสามารถเข้าถึงข้อมูลของคุณผ่าน API และรวมเข้ากับแอปพลิเคชันหรือแพลตฟอร์มอื่นๆ คุณยังสามารถเปลี่ยนข้อมูลให้เป็น API แบบกำหนดเองได้ด้วย Octoparse

ราคา

- มีทั้งแบบฟรีและแบบชำระเงิน แผนการชำระเงินเริ่มต้นที่ $89/เดือน

WebHarvy

WebHarvy เป็นซอฟต์แวร์ขูดเว็บแบบชี้และคลิกที่ออกแบบมาสำหรับผู้ที่ไม่ใช่โปรแกรมเมอร์ สามารถคัดลอกข้อความ รูปภาพ URL และอีเมลจากเว็บไซต์โดยอัตโนมัติ และบันทึกในรูปแบบต่างๆ เช่น XML, CSV, JSON หรือ TSV WebHarvy ยังสนับสนุนการรวบรวมข้อมูลแบบไม่ระบุชื่อและการจัดการเว็บไซต์แบบไดนามิกโดยใช้พร็อกซีเซิร์ฟเวอร์หรือบริการ VPN เพื่อเข้าถึงเว็บไซต์เป้าหมาย

คุณสมบัติที่สำคัญ

- อินเทอร์เฟซแบบชี้และคลิกสำหรับการเลือกข้อมูลโดยไม่ต้องเขียนโค้ดหรือเขียนสคริปต์

- การขุดหลายหน้าพร้อมการรวบรวมข้อมูลและการขูดอัตโนมัติ

- การขูดหมวดหมู่สำหรับการขูดข้อมูลจากเพจหรือรายการที่คล้ายกัน

- การดาวน์โหลดรูปภาพจากหน้ารายละเอียดสินค้าของเว็บไซต์อีคอมเมิร์ซ

- การตรวจจับรูปแบบอัตโนมัติสำหรับการขูดรายการหรือตารางโดยไม่ต้องกำหนดค่าเพิ่มเติม

- การแยกตามคำหลักโดยส่งคำหลักที่ป้อนไปยังแบบฟอร์มการค้นหา

- นิพจน์ทั่วไปเพื่อความยืดหยุ่นและการควบคุมการขูด

- การโต้ตอบอัตโนมัติของเบราว์เซอร์สำหรับการทำงานต่างๆ เช่น การคลิกลิงก์ การเลือกตัวเลือก การเลื่อน และอื่นๆ

ราคา

- WebHarvy เป็นซอฟต์แวร์ขูดเว็บที่มีค่าธรรมเนียมใบอนุญาตเพียงครั้งเดียว

- ราคาใบอนุญาตเริ่มต้นที่ 139 ดอลลาร์ต่อปี

ซุปที่สวยงาม

Beautiful Soup เป็นไลบรารี Python แบบโอเพ่นซอร์สที่ใช้สำหรับแยกวิเคราะห์เอกสาร HTML และ XML มันสร้างต้นไม้แยกวิเคราะห์ที่ช่วยให้ดึงข้อมูลจากเว็บได้ง่ายขึ้น แม้ว่าจะไม่เร็วเท่า Scrapy แต่ Beautiful Soup ก็ได้รับคำชื่นชมจากการใช้งานที่ง่ายดายและการสนับสนุนจากชุมชนเมื่อเกิดปัญหาขึ้น

คุณสมบัติที่สำคัญ

- การแยกวิเคราะห์ : คุณสามารถใช้ Beautiful Soup กับโปรแกรมแยกวิเคราะห์ต่างๆ เช่น html.parser, lxml, html5lib ฯลฯ เพื่อแยกวิเคราะห์เอกสารเว็บประเภทต่างๆ

- การนำทาง : คุณสามารถนำทาง parse tree โดยใช้วิธี Pythonic และแอตทริบิวต์ เช่น find(), find_all(), select(), .children, .parent, .next_sibling เป็นต้น

- การค้นหา : คุณสามารถค้นหาโครงสร้างการแยกวิเคราะห์โดยใช้ตัวกรอง เช่น ชื่อแท็ก แอตทริบิวต์ ข้อความ ตัวเลือก CSS นิพจน์ทั่วไป ฯลฯ เพื่อค้นหาองค์ประกอบที่คุณต้องการ

- การแก้ไข : คุณสามารถแก้ไข parse tree โดยการเพิ่ม ลบ แทนที่ หรือแก้ไของค์ประกอบและแอตทริบิวต์

ราคา

Beautiful Soup เป็นไลบรารีโอเพ่นซอร์สฟรีที่คุณสามารถติดตั้งได้โดยใช้ pip

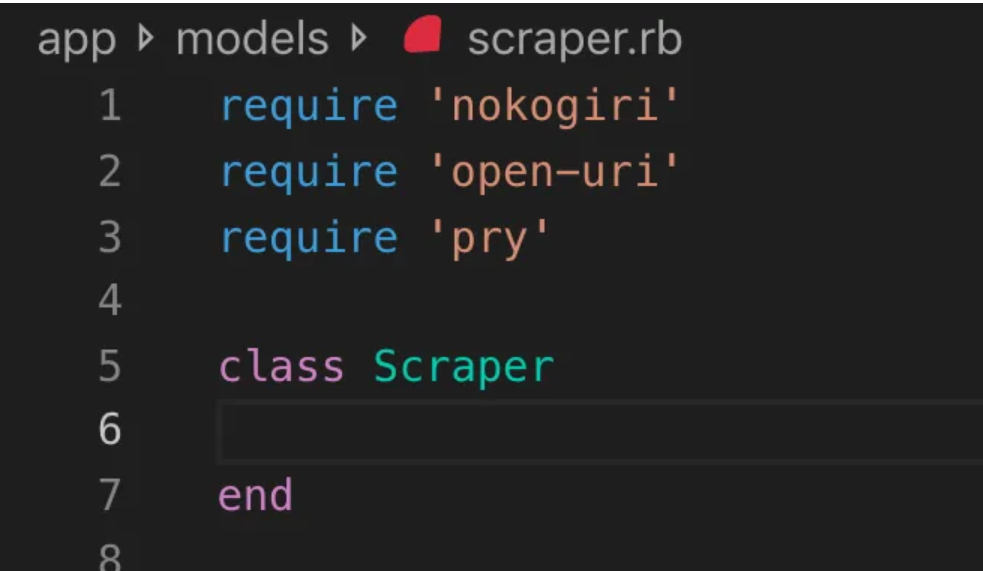

โนโกกิริ

Nokogiri เป็นเครื่องมือรวบรวมข้อมูลเว็บที่ช่วยให้แยกวิเคราะห์เอกสาร HTML และ XML ได้ง่ายโดยใช้ Ruby ซึ่งเป็นภาษาโปรแกรมที่เหมาะสำหรับผู้เริ่มต้นในการพัฒนาเว็บ Nokogiri อาศัยโปรแกรมแยกวิเคราะห์แบบเนทีฟ เช่น libxml2 ของ C และ xerces ของ Java ทำให้เป็นเครื่องมือที่มีประสิทธิภาพในการดึงข้อมูลจากเว็บไซต์ เหมาะอย่างยิ่งสำหรับนักพัฒนาเว็บที่ต้องการทำงานกับไลบรารีการรวบรวมข้อมูลเว็บที่ใช้ Ruby

คุณสมบัติที่สำคัญ

- DOM Parser สำหรับ XML, HTML4 และ HTML5

- โปรแกรมแยกวิเคราะห์ SAX สำหรับ XML และ HTML4

- Push Parser สำหรับ XML และ HTML4

- ค้นหาเอกสารผ่าน XPath 1.0

- ค้นหาเอกสารผ่านตัวเลือก CSS3 พร้อมส่วนขยายคล้าย jquery

- การตรวจสอบ XSD Schema

- การแปลง XSLT

- “ตัวสร้าง” DSL สำหรับเอกสาร XML และ HTML

ราคา

- Nokogiri เป็นโครงการโอเพ่นซอร์สที่ใช้งานได้ฟรี

Zyte (เดิมชื่อ Scrapinghub)

Zyte (เดิมคือ Scrapinghub) เป็นเครื่องมือสกัดข้อมูลบนคลาวด์ที่ช่วยให้นักพัฒนาหลายพันคนเรียกข้อมูลที่มีค่าจากเว็บไซต์ เครื่องมือขูดภาพแบบโอเพ่นซอร์สช่วยให้ผู้ใช้สามารถขูดเว็บไซต์ได้โดยไม่ต้องมีความรู้ด้านการเขียนโปรแกรม Zyte ใช้ Crawlera ซึ่งเป็นตัวหมุนพร็อกซีอัจฉริยะที่รองรับการเลี่ยงผ่านมาตรการต่อต้านบอทเพื่อรวบรวมข้อมูลไซต์ขนาดใหญ่หรือไซต์ที่มีการป้องกันด้วยบอทอย่างง่ายดาย และช่วยให้ผู้ใช้สามารถรวบรวมข้อมูลจาก IP และตำแหน่งที่ตั้งหลายแห่งโดยไม่ต้องเจ็บปวดจากการจัดการพร็อกซีผ่าน HTTP API ที่เรียบง่าย

คุณสมบัติที่สำคัญ

- ข้อมูลตามความต้องการ: จัดหาเว็บไซต์และข้อกำหนดด้านข้อมูลให้กับ Zyte และพวกเขาจะส่งข้อมูลที่ร้องขอตามกำหนดเวลาของคุณ

- Zyte AP I: ดึง HTML จากเว็บไซต์โดยอัตโนมัติโดยใช้การกำหนดค่าพร็อกซีและการแยกข้อมูลที่มีประสิทธิภาพสูงสุด ช่วยให้คุณมุ่งเน้นไปที่ข้อมูลโดยไม่ต้องกังวลด้านเทคนิค

- Scrapy Cloud : โฮสติ้งที่ปรับขนาดได้สำหรับ Scrapy spiders ของคุณ มีเว็บอินเตอร์เฟสที่ใช้งานง่ายสำหรับจัดการ ตรวจสอบ และควบคุมโปรแกรมรวบรวมข้อมูลของคุณ พร้อมด้วยเครื่องมือตรวจสอบ บันทึก และตรวจสอบคุณภาพข้อมูล

- API การสกัดข้อมูล อัตโนมัติ : เข้าถึงข้อมูลเว็บได้ทันทีผ่าน API การสกัดที่ขับเคลื่อนด้วย AI ของ Zyte ส่งมอบข้อมูลที่มีโครงสร้างที่มีคุณภาพอย่างรวดเร็ว การเข้าถึงแหล่งข้อมูลใหม่จะง่ายขึ้นด้วยเทคโนโลยีที่จดสิทธิบัตรนี้

ราคา

Zyte มีรูปแบบการกำหนดราคาที่ยืดหยุ่นซึ่งขึ้นอยู่กับความซับซ้อนและปริมาณของข้อมูลที่คุณต้องการ คุณสามารถเลือกจากสามแผน:

- นักพัฒนา: $49/เดือน สำหรับคำขอ 250,000 รายการ

- ธุรกิจ: $299/เดือน สำหรับคำขอ 2 ล้านครั้ง

- องค์กร: กำหนดราคาเองสำหรับคำขอ 10M+

- คุณสามารถทดลองใช้ Zyte ได้ฟรีด้วยคำขอ 10,000 รายการต่อเดือน

HTTrack

HTTrack เป็นเครื่องมือรวบรวมข้อมูลเว็บแบบโอเพ่นซอร์สฟรีที่ช่วยให้ผู้ใช้ดาวน์โหลดเว็บไซต์ทั้งหมดหรือบางหน้าเว็บลงในอุปกรณ์ท้องถิ่นเพื่อเรียกดูแบบออฟไลน์ มีอินเทอร์เฟซบรรทัดคำสั่งและสามารถใช้กับระบบ Windows, Linux และ Unix

คุณสมบัติที่สำคัญ

- โดยจะรักษาโครงสร้างลิงก์สัมพัทธ์ของไซต์ดั้งเดิมไว้

- สามารถอัปเดตไซต์มิเรอร์ที่มีอยู่และดำเนินการดาวน์โหลดที่ถูกขัดจังหวะต่อได้

- สามารถกำหนดค่าได้อย่างสมบูรณ์และมีระบบช่วยเหลือในตัว

- รองรับแพลตฟอร์มต่างๆ เช่น Windows, Linux, OSX, Android เป็นต้น

- มีเวอร์ชันบรรทัดคำสั่งและเวอร์ชันอินเทอร์เฟซผู้ใช้แบบกราฟิก

ราคา

- HTTrack เป็นซอฟต์แวร์ฟรีที่ได้รับอนุญาตภายใต้ GNU GPL

อาปาเช่ นัทช์

Apache Nutch เป็นโปรแกรมรวบรวมข้อมูลเว็บแบบโอเพ่นซอร์สที่สามารถขยายได้ ซึ่งมักใช้ในฟิลด์ต่างๆ เช่น การวิเคราะห์ข้อมูล สามารถดึงเนื้อหาผ่านโปรโตคอล เช่น HTTPS, HTTP หรือ FTP และดึงข้อมูลที่เป็นข้อความจากรูปแบบเอกสาร เช่น HTML, PDF, RSS และ ATOM

คุณสมบัติที่สำคัญ

- มันขึ้นอยู่กับโครงสร้างข้อมูล Apache Hadoop ซึ่งเหมาะสำหรับการประมวลผลข้อมูลปริมาณมากเป็นชุด

- มีสถาปัตยกรรมแบบโมดูลาร์สูง ช่วยให้นักพัฒนาสามารถสร้างปลั๊กอินสำหรับการแยกประเภทสื่อ การดึงข้อมูล การสอบถาม และการทำคลัสเตอร์

- รองรับแพลตฟอร์มต่างๆ เช่น Windows, Linux, OSX, Android เป็นต้น

- มีเวอร์ชันบรรทัดคำสั่งและเวอร์ชันอินเทอร์เฟซผู้ใช้แบบกราฟิก

- ผสานรวมกับ Apache Tika สำหรับการแยกวิเคราะห์ Apache Solr และ Elasticsearch สำหรับการจัดทำดัชนี และ Apache HBase สำหรับการจัดเก็บ

ราคา

- Apache Nutch เป็นซอฟต์แวร์ฟรีที่ได้รับอนุญาตภายใต้ Apache License 2.0

เครื่องขูดฮีเลียม

Helium Scraper เป็นเครื่องมือรวบรวมข้อมูลเว็บภาพที่สามารถปรับแต่งและควบคุมโดยผู้ใช้โดยไม่ต้องเขียนโค้ด มีคุณสมบัติขั้นสูง เช่น การหมุนเวียนพร็อกซี การดึงข้อมูลอย่างรวดเร็ว และการสนับสนุนรูปแบบข้อมูลที่หลากหลาย เช่น Excel, CSV, MS Access, MySQL, MSSQL, XML หรือ JSON

คุณสมบัติที่สำคัญ

- Fast Extraction : มอบหมายงานการแยกโดยอัตโนมัติไปยังเบราว์เซอร์ที่แยกจากกัน

- Big Data : ฐานข้อมูล SQLite สามารถเก็บได้ถึง 140 เทราไบต์

- การสร้างฐานข้อมูล : ความสัมพันธ์ของตารางถูกสร้างขึ้นตามข้อมูลที่แยกออกมา

- การสร้าง SQL : เข้าร่วมและกรองตารางอย่างรวดเร็วเพื่อส่งออกหรือป้อนข้อมูล

- การเรียก API : รวมการขูดเว็บและการเรียก API ในโครงการเดียว

- การจัดการข้อความ : สร้างฟังก์ชันเพื่อจับคู่ แยก หรือแทนที่ข้อความที่แยกออกมา

- การสนับสนุน JavaScript: แทรกและรันโค้ด JavaScript ที่กำหนดเองบนเว็บไซต์ใดก็ได้

- การหมุนเวียนพร็อกซี : ป้อนรายการพร็อกซีและหมุนเวียนในช่วงเวลาที่กำหนด

- การตรวจจับองค์ประกอบที่คล้ายกัน : ตรวจจับองค์ประกอบที่คล้ายกันจากหนึ่งหรือสองตัวอย่าง

- การตรวจจับรายการ : ตรวจหารายการและแถวของตารางบนเว็บไซต์โดยอัตโนมัติ

- การส่งออกข้อมูล : ส่งออกข้อมูลเป็น CSV, Excel, XML, JSON หรือ SQLite

- การตั้งเวลา : เปิดใช้งานได้จากบรรทัดคำสั่งหรือ Windows Task Scheduler

ราคา

- ใบอนุญาตพื้นฐานราคา $99 ต่อผู้ใช้

ตัวจับเนื้อหา (ลำดับ)

Content Grabber เป็นซอฟต์แวร์รวบรวมข้อมูลเว็บที่มีเป้าหมายเป็นองค์กร โดยอนุญาตให้ผู้ใช้สร้างตัวแทนการรวบรวมข้อมูลเว็บแบบสแตนด์อโลน มีฟีเจอร์ขั้นสูง เช่น การผสานรวมกับแอปพลิเคชันการวิเคราะห์ข้อมูลหรือการรายงานของบุคคลที่สาม การแก้ไขสคริปต์ที่มีประสิทธิภาพ และอินเทอร์เฟซการดีบัก และการสนับสนุนการส่งออกข้อมูลไปยังรายงาน Excel, XML, CSV และฐานข้อมูลส่วนใหญ่

คุณสมบัติที่สำคัญ

- อินเทอร์เฟซแบบชี้และคลิกที่ใช้งานง่าย : ตรวจจับการกระทำโดยอัตโนมัติตามองค์ประกอบ HTML

- API ที่แข็งแกร่ง : รองรับการรวมแบบลากและวางที่ง่ายดายกับไปป์ไลน์ข้อมูลที่มีอยู่

- การปรับแต่ง : ปรับแต่งตัวแทนการขูดของคุณด้วยภาษาการเข้ารหัสทั่วไป เช่น Python, C#, JavaScript, Regular Expressions

- การรวม : รวม AI, ML, ไลบรารี NLP หรือ API ของบุคคลที่สามเพื่อการเพิ่มข้อมูล

- ความน่าเชื่อถือและขนาด : ลดต้นทุนโครงสร้างพื้นฐานในขณะที่เพลิดเพลินกับการตรวจสอบแบบเรียลไทม์ของการดำเนินงานตั้งแต่ต้นทางถึงปลายทาง

- การปฏิบัติตามกฎหมาย : ลดความรับผิดของคุณและลดความเสี่ยงที่เกี่ยวข้องกับการฟ้องร้องที่มีค่าใช้จ่ายสูงและค่าปรับตามกฎระเบียบ

- การส่งออกข้อมูล : ส่งออกข้อมูลเป็นรูปแบบใดก็ได้และส่งไปยังปลายทางใดก็ได้

- การตั้งเวลา : เรียกใช้ตัวแทนการขูดของคุณจากบรรทัดคำสั่งหรือ Windows Task Scheduler

ราคา

- ใบอนุญาตขั้นพื้นฐานมีราคา 27,500 ดอลลาร์ต่อปีและอนุญาตให้คุณใช้ซอฟต์แวร์บนคอมพิวเตอร์เครื่องหนึ่ง

Cyotek WebCopy

Cyotek WebCopy เป็นโปรแกรมรวบรวมข้อมูลเว็บไซต์ฟรีที่ช่วยให้ผู้ใช้สามารถคัดลอกเว็บไซต์บางส่วนหรือทั้งหมดลงในฮาร์ดดิสก์เพื่อใช้อ้างอิงแบบออฟไลน์ สามารถตรวจจับและติดตามลิงก์ภายในเว็บไซต์และทำการแมปลิงก์ใหม่โดยอัตโนมัติเพื่อให้ตรงกับเส้นทางในเครื่อง อย่างไรก็ตาม WebCopy ไม่รวม DOM เสมือนหรือรูปแบบใดๆ ของการแยกวิเคราะห์ JavaScript ดังนั้นจึงอาจจัดการเค้าโครงเว็บไซต์แบบไดนามิกไม่ถูกต้องเนื่องจากการใช้งาน JavaScript อย่างหนัก

คุณสมบัติที่สำคัญ

- อินเทอร์เฟซแบบชี้และคลิกที่ใช้งานง่ายพร้อมการตรวจจับการกระทำอัตโนมัติตามองค์ประกอบ HTML

- API ที่มีประสิทธิภาพสำหรับการผสานรวมอย่างราบรื่นกับท่อข้อมูลที่มีอยู่ผ่านฟังก์ชันการลากและวางที่เรียบง่าย

- ตัวเลือกการปรับแต่งโดยใช้ภาษาการเข้ารหัสยอดนิยมเช่น Python, C#, JavaScript และ Regular Expressions เพื่อปรับแต่งตัวแทนการขูดให้ตรงกับความต้องการเฉพาะ

- ความสามารถในการรวมเข้ากับ AI, ML, NLP libraries หรือ API ของบุคคลที่สามเพื่อเพิ่มข้อมูลที่คัดลอกมา

- โครงสร้างพื้นฐานที่เชื่อถือได้และปรับขนาดได้พร้อมการตรวจสอบแบบเรียลไทม์เพื่อการดำเนินงานที่คุ้มค่า

- คุณสมบัติการปฏิบัติตามกฎหมายเพื่อลดความรับผิดและลดความเสี่ยงของการถูกฟ้องร้องและค่าปรับตามกฎระเบียบ

- ส่งออกข้อมูลไปยังรูปแบบที่ต้องการและจัดส่งไปยังปลายทางต่างๆ

- ตัวเลือกการตั้งเวลาอนุญาตให้เรียกใช้ตัวแทนการขูดจากบรรทัดคำสั่งหรือ Windows Task Scheduler

ราคา

- ใบอนุญาตขั้นพื้นฐานมีราคา 27,500 ดอลลาร์ต่อปีและอนุญาตให้คุณใช้ซอฟต์แวร์บนคอมพิวเตอร์เครื่องหนึ่ง

80ขา

80legs เป็นเครื่องมือรวบรวมข้อมูลเว็บที่มีประสิทธิภาพซึ่งสามารถกำหนดค่าได้ตามความต้องการที่กำหนดเอง รองรับการดึงข้อมูลจำนวนมากพร้อมกับตัวเลือกในการดาวน์โหลดข้อมูลที่แยกออกมาทันที เครื่องมือนำเสนอ API สำหรับผู้ใช้เพื่อสร้างโปรแกรมรวบรวมข้อมูล จัดการข้อมูล และอื่นๆ คุณลักษณะหลักบางประการ ได้แก่ การปรับแต่งมีดโกน เซิร์ฟเวอร์ IP สำหรับคำขอการคัดลอกเว็บ และเฟรมเวิร์กแอปที่ใช้ JS สำหรับกำหนดค่าการรวบรวมข้อมูลเว็บด้วยลักษณะการทำงานที่กำหนดเอง

คุณสมบัติที่สำคัญ

- ปรับขนาดได้และรวดเร็ว : คุณสามารถรวบรวมข้อมูลได้มากถึง 2 พันล้านหน้าต่อวันด้วยคำขอพร้อมกันมากกว่า 50,000 รายการ

- ยืดหยุ่นและปรับแต่งได้: คุณสามารถใช้โค้ดของคุณเองเพื่อควบคุมตรรกะการรวบรวมข้อมูลและการดึงข้อมูล หรือใช้เครื่องมือและเทมเพลตในตัว

ราคา

- คุณสามารถเลือกจากแผนการกำหนดราคาที่แตกต่างกันตามความต้องการของคุณ เริ่มต้นที่ $29/เดือน สำหรับ 100,000 URL/การรวบรวมข้อมูล ไปจนถึง $299/เดือน สำหรับ 10 ล้าน URL/การรวบรวมข้อมูล

เว็บโฮส.io

Webhose.io ช่วยให้ผู้ใช้สามารถรับข้อมูลแบบเรียลไทม์โดยการรวบรวมข้อมูลแหล่งข้อมูลออนไลน์จากทั่วทุกมุมโลกและนำเสนอในรูปแบบที่สะอาดหลากหลาย เครื่องมือรวบรวมข้อมูลเว็บนี้สามารถรวบรวมข้อมูลและแยกคำหลักเพิ่มเติมในภาษาต่างๆ โดยใช้ตัวกรองหลายตัวซึ่งครอบคลุมแหล่งที่มาที่หลากหลาย ผู้ใช้สามารถบันทึกข้อมูลที่คัดลอกมาในรูปแบบ XML, JSON และ RSS และเข้าถึงข้อมูลประวัติได้จากเอกสารเก่า Webhose.io รองรับมากถึง 80 ภาษาพร้อมผลลัพธ์การรวบรวมข้อมูล ทำให้ผู้ใช้สามารถจัดทำดัชนีและค้นหาข้อมูลที่มีโครงสร้างที่เครื่องมือนี้รวบรวมข้อมูลได้อย่างง่ายดาย

คุณสมบัติที่สำคัญ

- หลายรูปแบบ : คุณสามารถรับข้อมูลในรูปแบบ XML, JSON, RSS หรือ Excel

- ผลลัพธ์ที่มีโครงสร้าง : คุณจะได้รับข้อมูลที่ได้รับการทำให้เป็นมาตรฐาน สมบูรณ์ และจัดหมวดหมู่ตามความต้องการของคุณ

- ข้อมูลย้อนหลัง : คุณสามารถเข้าถึงข้อมูลที่เก็บถาวรตั้งแต่ 12 เดือนที่ผ่านมาขึ้นไป

- ครอบคลุมกว้างขวาง : คุณสามารถรับข้อมูลจากกว่าล้านแหล่งใน 80 ภาษาและ 240 ประเทศ

- แหล่งที่มาที่หลากหลาย : คุณสามารถรับข้อมูลจากเว็บไซต์ข่าว บล็อก ฟอรัม กระดานข้อความ ความคิดเห็น บทวิจารณ์ และอื่นๆ

- การผสานรวมอย่างรวดเร็ว : คุณสามารถรวม Webhose.io เข้ากับระบบของคุณได้ภายในไม่กี่นาทีด้วย REST API อย่างง่าย

ราคา

- มีแผนบริการฟรีที่ให้คุณสร้างคำขอได้ 1,000 รายการต่อเดือนโดยไม่มีค่าใช้จ่าย นอกจากนี้ยังมีแผนแบบกำหนดเองที่คุณสามารถติดต่อเพื่อขอใบเสนอราคาได้

โมเซนด้า

Mozenda เป็นซอฟต์แวร์ขูดเว็บบนคลาวด์ที่ช่วยให้ผู้ใช้สามารถแยกข้อมูลเว็บโดยไม่ต้องเขียนโค้ดแม้แต่บรรทัดเดียว ทำให้กระบวนการดึงข้อมูลเป็นไปโดยอัตโนมัติและนำเสนอคุณลักษณะต่างๆ เช่น การดึงข้อมูลตามกำหนดเวลา การล้างข้อมูล และการบายพาสการบล็อกด้วยพร็อกซีเซิร์ฟเวอร์ IP Mozenda ออกแบบมาสำหรับธุรกิจ ด้วยอินเทอร์เฟซที่ใช้งานง่ายและความสามารถในการขูดที่ทรงพลัง

คุณสมบัติที่สำคัญ

- การวิเคราะห์ข้อความ: คุณสามารถแยกและวิเคราะห์ข้อมูลข้อความจากเว็บไซต์ใดก็ได้โดยใช้เทคนิคการประมวลผลภาษาธรรมชาติ

- การแยกรูปภาพ: คุณสามารถดาวน์โหลดและบันทึกรูปภาพจากหน้าเว็บหรือดึงข้อมูลเมตาของรูปภาพ เช่น ขนาด รูปแบบ ความละเอียด ฯลฯ

- การรวบรวมข้อมูลที่แตกต่างกัน: คุณสามารถรวบรวมข้อมูลจากแหล่งที่มาและรูปแบบต่างๆ เช่น HTML, XML, JSON, RSS เป็นต้น

- การแยกเอกสาร: คุณสามารถแยกข้อมูลจาก PDF, Word, Excel และเอกสารประเภทอื่นๆ โดยใช้การรู้จำอักขระด้วยแสง (OCR) หรือวิธีการแยกข้อความ

- การแยกที่อยู่อีเมล : คุณสามารถค้นหาและแยกที่อยู่อีเมลจากหน้าเว็บหรือเอกสารโดยใช้นิพจน์ทั่วไปหรือการจับคู่รูปแบบ

ราคา

- แผนการชำระเงินเริ่มต้นที่ $99 ต่อเดือน

UiPath

UiPath เป็นซอฟต์แวร์ระบบอัตโนมัติสำหรับกระบวนการอัตโนมัติ (RPA) สำหรับการขูดเว็บฟรี ทำการรวบรวมข้อมูลเว็บและเดสก์ท็อปโดยอัตโนมัติจากแอพของบุคคลที่สามส่วนใหญ่ UiPath เข้ากันได้กับ Windows สามารถแยกข้อมูลแบบตารางและแบบตามรูปแบบในหน้าเว็บหลายหน้า ซอฟต์แวร์ยังมีเครื่องมือในตัวสำหรับการรวบรวมข้อมูลเพิ่มเติมและจัดการอินเทอร์เฟซผู้ใช้ที่ซับซ้อน

คุณสมบัติที่สำคัญ

- การวิเคราะห์ข้อความ : แยกและวิเคราะห์ข้อมูลข้อความโดยใช้การประมวลผลภาษาธรรมชาติ นิพจน์ทั่วไป และการจับคู่รูปแบบสำหรับงานต่างๆ เช่น การแยกที่อยู่อีเมล

- การแยกรูปภาพ : ดาวน์โหลดและบันทึกรูปภาพจากหน้าเว็บ ดึงข้อมูลเมตาของรูปภาพ รวมถึงขนาด รูปแบบ และความละเอียด

- การรวบรวมข้อมูลที่แตกต่างกัน : รวบรวมข้อมูลจากแหล่งที่มาและรูปแบบต่างๆ เช่น HTML, XML, JSON, RSS พร้อมความสามารถในการรวมสำหรับการเชื่อมต่อกับบริการออนไลน์และ API อื่นๆ

- การแยกเอกสาร : แยกข้อมูลจาก PDF, Word, Excel และเอกสารประเภทอื่นๆ โดยใช้ OCR หรือวิธีการแยกข้อความ ประมวลผลและแยกข้อมูลในประเภทและโครงสร้างเอกสารต่างๆ ด้วยคุณสมบัติการทำความเข้าใจเอกสาร

- ระบบอัตโนมัติบนเว็บ : ทำกิจกรรมบนเว็บโดยอัตโนมัติ เช่น การเข้าสู่ระบบ การนำทางผ่านหน้าต่างๆ การกรอกแบบฟอร์ม การคลิกปุ่ม ใช้คุณสมบัติเครื่องบันทึกเพื่อบันทึกการกระทำและสร้างสคริปต์การทำงานอัตโนมัติ

ราคา

- ที่จ่าย แผนเริ่มต้นที่ $420 ต่อเดือน

เอ้าท์วิทฮับ

OutWit Hub เป็นโปรแกรมเสริมของ Firefox ที่มีฟีเจอร์การดึงข้อมูลมากมายเพื่อทำให้การค้นหาเว็บของผู้ใช้ง่ายขึ้น เครื่องมือรวบรวมข้อมูลเว็บนี้สามารถเรียกดูผ่านหน้าต่างๆ และจัดเก็บข้อมูลที่แยกออกมาในรูปแบบที่เหมาะสม OutWit Hub นำเสนออินเทอร์เฟซเดียวสำหรับการคัดลอกข้อมูลจำนวนน้อยหรือมากตามความต้องการ และสามารถสร้างตัวแทนอัตโนมัติเพื่อดึงข้อมูลจากเว็บไซต์ต่างๆ ได้ในเวลาไม่กี่นาที

คุณสมบัติที่สำคัญ

- ดูและส่งออกเนื้อหาเว็บ: คุณสามารถดูลิงก์ เอกสาร รูปภาพ รายชื่อติดต่อ ตารางข้อมูล RSS feed ที่อยู่อีเมล และองค์ประกอบอื่น ๆ ที่มีอยู่ในเว็บเพจ คุณยังสามารถส่งออกเป็น HTML, SQL, CSV, XML, JSON หรือรูปแบบอื่นๆ

- จัดระเบียบข้อมูลในตารางและรายการ: คุณสามารถเรียงลำดับ กรอง จัดกลุ่ม และแก้ไขข้อมูลที่คุณรวบรวมในตารางและรายการ คุณยังสามารถใช้หลายเกณฑ์เพื่อเลือกข้อมูลที่คุณต้องการแยก

- ตั้งค่าฟังก์ชั่นอัตโนมัติ : คุณสามารถใช้คุณสมบัติตัวขูดเพื่อสร้างตัวขูดแบบกำหนดเองที่สามารถดึงข้อมูลจากเว็บไซต์ใดก็ได้โดยใช้คำสั่งแบบง่ายหรือขั้นสูง คุณยังสามารถใช้คุณสมบัติมาโครเพื่อทำให้การท่องเว็บและการคัดลอกงานเป็นไปโดยอัตโนมัติ

- สร้างข้อความค้นหาและ URL: คุณสามารถใช้คุณลักษณะข้อความค้นหาเพื่อสร้างข้อความค้นหาตามคำหลักหรือรูปแบบ คุณยังสามารถใช้คุณสมบัติ URL เพื่อสร้าง URL ตามรูปแบบหรือพารามิเตอร์

ราคา

- ใบอนุญาต Light นั้นฟรีและใช้งานได้เต็มรูปแบบ แต่ไม่มีคุณลักษณะการทำงานอัตโนมัติและจำกัดการดึงข้อมูลไว้ที่หนึ่งหรือไม่กี่ร้อยแถว ขึ้นอยู่กับตัวแยกข้อมูล

- ใบอนุญาต Pro มีค่าใช้จ่าย $110 ต่อปี และรวมคุณสมบัติทั้งหมดของใบอนุญาต Light รวมถึงคุณสมบัติการทำงานอัตโนมัติและการดึงข้อมูลที่ไม่จำกัด

เครื่องขูดภาพ

Visual Scraper นอกเหนือจากการเป็นแพลตฟอร์ม SaaS แล้ว ยังมีบริการขูดเว็บ เช่น บริการจัดส่งข้อมูลและการสร้างตัวแยกซอฟต์แวร์สำหรับลูกค้า เครื่องมือรวบรวมข้อมูลเว็บนี้ครอบคลุมวงจรชีวิตทั้งหมดของโปรแกรมรวบรวมข้อมูล ตั้งแต่การดาวน์โหลด การจัดการ URL ไปจนถึงการแยกเนื้อหา ช่วยให้ผู้ใช้สามารถจัดกำหนดการโครงการให้ทำงานตามเวลาที่กำหนด หรือทำซ้ำตามลำดับทุกนาที วัน สัปดาห์ เดือน หรือปี Visual Scraper เหมาะอย่างยิ่งสำหรับผู้ใช้ที่ต้องการดึงข่าวสาร การอัปเดต และฟอรัมบ่อยๆ อย่างไรก็ตาม ดูเหมือนว่าเว็บไซต์อย่างเป็นทางการจะไม่ได้รับการอัปเดตในขณะนี้ และข้อมูลนี้อาจไม่เป็นปัจจุบัน

คุณสมบัติที่สำคัญ

- อินเตอร์เฟซที่ใช้งานง่าย

- รองรับข้อมูลหลายรูปแบบ (CSV, JSON, XML, ฯลฯ)

- รองรับการแบ่งหน้า, AJAX และเว็บไซต์แบบไดนามิก

- รองรับพร็อกซีเซิร์ฟเวอร์และการหมุนเวียน IP

- รองรับการตั้งเวลาและระบบอัตโนมัติ

ราคา

- มีแผนบริการฟรีและแผนชำระเงินเริ่มต้นที่ $39.99 ต่อเดือน

นำเข้า.io

Import.io เป็นเครื่องมือขูดเว็บที่ช่วยให้ผู้ใช้สามารถนำเข้าข้อมูลจากหน้าเว็บเฉพาะและส่งออกเป็น CSV โดยไม่ต้องเขียนโค้ดใดๆ สามารถสแกนหน้าเว็บหลายพันรายการได้อย่างง่ายดายในเวลาไม่กี่นาที และสร้าง API มากกว่า 1,000 รายการตามความต้องการของผู้ใช้ Import.io รวมข้อมูลเว็บเข้ากับแอพหรือเว็บไซต์ของผู้ใช้ด้วยการคลิกเพียงไม่กี่ครั้ง ทำให้การขูดเว็บง่ายขึ้น

คุณสมบัติที่สำคัญ

- ชี้และคลิกการเลือกและการฝึกอบรม

- การสกัดที่รับรองความถูกต้องและการโต้ตอบ

- ดาวน์โหลดรูปภาพและภาพหน้าจอ

- พร็อกซีระดับพรีเมียมและตัวแยกข้อมูลเฉพาะประเทศ

- เอาต์พุต CSV, Excel, JSON และการเข้าถึง API

- SLA คุณภาพข้อมูลและการรายงาน

- การสนับสนุนทางอีเมล ตั๋ว แชท และโทรศัพท์

ราคา

- เริ่มต้น: $ 199 ต่อเดือนสำหรับ 5,000 ข้อความค้นหา

Dexi.io

Dexi.io เป็นโปรแกรมรวบรวมข้อมูลเว็บบนเบราว์เซอร์ที่ช่วยให้ผู้ใช้สามารถขูดข้อมูลตามเบราว์เซอร์ของตนจากเว็บไซต์ใดก็ได้ และมีโรบ็อตสามประเภทเพื่อสร้างงานการคัดลอก - Extractor, Crawler และ Pipes ฟรีแวร์ให้บริการเว็บพร็อกซีเซิร์ฟเวอร์ที่ไม่ระบุชื่อ และข้อมูลที่แยกออกมาจะถูกโฮสต์บนเซิร์ฟเวอร์ของ Dexi.io เป็นเวลาสองสัปดาห์ก่อนที่ข้อมูลจะถูกเก็บถาวร หรือผู้ใช้สามารถส่งออกข้อมูลที่แยกออกมาโดยตรงไปยังไฟล์ JSON หรือ CSV ให้บริการแบบชำระเงินสำหรับผู้ใช้ที่ต้องการดึงข้อมูลแบบเรียลไทม์

คุณสมบัติที่สำคัญ

- ชี้และคลิกการเลือกและการฝึกอบรม

- การสกัดที่รับรองความถูกต้องและการโต้ตอบ

- ดาวน์โหลดรูปภาพและภาพหน้าจอ

- พร็อกซีระดับพรีเมียมและตัวแยกข้อมูลเฉพาะประเทศ

- เอาต์พุต CSV, Excel, JSON และการเข้าถึง API

- SLA คุณภาพข้อมูลและการรายงาน

- การสนับสนุนทางอีเมล ตั๋ว แชท และโทรศัพท์

ราคา

- มาตรฐาน: $119 ต่อเดือนหรือ $1,950 ต่อปีสำหรับพนักงาน 1 คน

คนเชิดหุ่น

Puppeteer เป็นไลบรารีโหนดที่พัฒนาโดย Google ซึ่งให้บริการ API สำหรับโปรแกรมเมอร์ในการควบคุม Chrome หรือ Chromium ผ่าน DevTools Protocol ช่วยให้ผู้ใช้สร้างเครื่องมือขูดเว็บด้วย Puppeteer และ Node.js Puppeteer สามารถใช้เพื่อวัตถุประสงค์ต่างๆ เช่น ถ่ายภาพหน้าจอหรือสร้าง PDF ของหน้าเว็บ การส่งแบบฟอร์มอัตโนมัติ/ป้อนข้อมูล และการสร้างเครื่องมือสำหรับการทดสอบอัตโนมัติ

คุณสมบัติที่สำคัญ

- สร้างภาพหน้าจอและ PDF ของหน้าเว็บ

- รวบรวมข้อมูลและขูดข้อมูลจากเว็บไซต์

- การส่งแบบฟอร์มอัตโนมัติ การทดสอบ UI การป้อนแป้นพิมพ์ ฯลฯ

- บันทึกเมตริกประสิทธิภาพและการติดตาม

- ทดสอบส่วนขยายของ Chrome

- ทำงานในโหมดหัวขาดหรือหัวขาด

ราคา

- Puppeteer ฟรีและโอเพ่นซอร์ส

Crawler4j

Crawler4j เป็นโปรแกรมรวบรวมข้อมูลเว็บ Java แบบโอเพ่นซอร์สพร้อมอินเทอร์เฟซที่เรียบง่ายในการรวบรวมข้อมูลเว็บ ช่วยให้ผู้ใช้สร้างโปรแกรมรวบรวมข้อมูลแบบมัลติเธรดในขณะที่ใช้หน่วยความจำอย่างมีประสิทธิภาพ Crawler4j เหมาะอย่างยิ่งสำหรับนักพัฒนาซอฟต์แวร์ที่ต้องการโซลูชันการรวบรวมข้อมูลเว็บบน Java ที่ตรงไปตรงมาและปรับแต่งได้

คุณสมบัติที่สำคัญ

- ซึ่งช่วยให้คุณระบุ URL ที่ควรได้รับการรวบรวมข้อมูลและ URL ใดที่ควรละเว้นโดยใช้นิพจน์ทั่วไป

- ช่วยให้คุณจัดการหน้าที่ดาวน์โหลดและดึงข้อมูลจากหน้าเหล่านั้น

- ปฏิบัติตามโปรโตคอล robots.txt และหลีกเลี่ยงการรวบรวมข้อมูลหน้าเว็บที่ไม่ได้รับอนุญาต

- สามารถรวบรวมข้อมูล HTML รูปภาพ และไฟล์ประเภทอื่นๆ

- สามารถรวบรวมสถิติและรันโปรแกรมรวบรวมข้อมูลหลายโปรแกรมพร้อมกันได้

ราคา

- Crawler4j เป็นโครงการ Java แบบโอเพ่นซอร์สที่ให้คุณตั้งค่าและเรียกใช้โปรแกรมรวบรวมข้อมูลเว็บของคุณเองได้อย่างง่ายดาย

การรวบรวมข้อมูลทั่วไป

Common Crawl เป็นเครื่องมือรวบรวมข้อมูลเว็บที่ให้คลังข้อมูลเว็บแบบเปิดสำหรับการวิจัย การวิเคราะห์ และการศึกษา

คุณสมบัติที่สำคัญ

- ให้ผู้ใช้เข้าถึงข้อมูลการรวบรวมข้อมูลเว็บ เช่น ข้อมูลดิบของหน้าเว็บ ข้อมูลเมตาที่แยกออกมา และข้อความ ตลอดจนดัชนีการรวบรวมข้อมูลทั่วไป

ราคา

- ข้อมูลการรวบรวมข้อมูลเว็บฟรีและเข้าถึงได้แบบสาธารณะนี้สามารถใช้โดยนักพัฒนา นักวิจัย และธุรกิจสำหรับงานวิเคราะห์ข้อมูลต่างๆ

ซุปเครื่องกล

MechanicalSoup เป็นไลบรารี Python ที่ใช้สำหรับแยกวิเคราะห์เว็บไซต์ โดยอ้างอิงจากไลบรารี Beautiful Soup โดยได้รับแรงบันดาลใจจากไลบรารี Mechanize เหมาะอย่างยิ่งสำหรับการจัดเก็บคุกกี้ ติดตามการเปลี่ยนเส้นทาง ไฮเปอร์ลิงก์ และจัดการแบบฟอร์มบนเว็บไซต์

คุณสมบัติที่สำคัญ

- MechanicalSoup นำเสนอวิธีง่ายๆ ในการเรียกดูและดึงข้อมูลจากเว็บไซต์ โดยไม่ต้องจัดการกับงานโปรแกรมที่ซับซ้อน

ราคา

- เป็นเครื่องมือฟรี

โปรแกรมรวบรวมข้อมูลโหนด

Node Crawler เป็นแพ็คเกจที่ได้รับความนิยมและมีประสิทธิภาพสำหรับการรวบรวมข้อมูลเว็บไซต์ด้วยแพลตฟอร์ม Node.js มันทำงานบนพื้นฐานของ Cheerio และมาพร้อมกับตัวเลือกมากมายในการปรับแต่งวิธีที่ผู้ใช้รวบรวมข้อมูลหรือขูดเว็บ รวมถึงการจำกัดจำนวนคำขอและเวลาที่ใช้ระหว่างกัน Node Crawler เหมาะสำหรับนักพัฒนาที่ต้องการทำงานกับ Node.js สำหรับโครงการรวบรวมข้อมูลเว็บของตน

คุณสมบัติที่สำคัญ

- ง่ายต่อการใช้

- API ที่ขับเคลื่อนด้วยเหตุการณ์

- การลองใหม่และการหมดเวลาที่กำหนดได้

- การตรวจจับการเข้ารหัสอัตโนมัติ

- การจัดการคุกกี้อัตโนมัติ

- การจัดการการเปลี่ยนเส้นทางอัตโนมัติ

- การจัดการ gzip/deflate อัตโนมัติ

ราคา

- เป็นเครื่องมือฟรี

ปัจจัยที่ต้องพิจารณาเมื่อเลือกเครื่องมือรวบรวมข้อมูลเว็บ

ราคา

พิจารณาโครงสร้างราคาของเครื่องมือที่เลือกและตรวจสอบให้แน่ใจว่ามีความโปร่งใสโดยไม่มีค่าใช้จ่ายแอบแฝง เลือกใช้บริษัทที่เสนอรูปแบบราคาที่ชัดเจนและให้ข้อมูลโดยละเอียดเกี่ยวกับคุณสมบัติที่มี

สะดวกในการใช้

เลือกเครื่องมือรวบรวมข้อมูลเว็บที่เป็นมิตรต่อผู้ใช้และไม่จำเป็นต้องมีความรู้ด้านเทคนิคมากมาย เครื่องมือจำนวนมากมีอินเทอร์เฟซแบบชี้และคลิก ทำให้ผู้ที่ไม่ใช่โปรแกรมเมอร์สามารถดึงข้อมูลจากเว็บไซต์ได้ง่ายขึ้น

ความสามารถในการปรับขนาด

พิจารณาว่าเครื่องมือรวบรวมข้อมูลเว็บสามารถจัดการปริมาณข้อมูลที่คุณต้องการดึงออกมาได้หรือไม่ และจะเติบโตไปพร้อมกับธุรกิจของคุณได้หรือไม่ เครื่องมือบางอย่างเหมาะสำหรับโครงการขนาดเล็ก ในขณะที่เครื่องมืออื่นๆ ได้รับการออกแบบมาสำหรับการสกัดข้อมูลขนาดใหญ่

คุณภาพและความถูกต้องของข้อมูล

ตรวจสอบให้แน่ใจว่าเครื่องมือรวบรวมข้อมูลเว็บสามารถล้างและจัดระเบียบข้อมูลที่แยกออกมาในรูปแบบที่ใช้งานได้ คุณภาพของข้อมูลมีความสำคัญอย่างยิ่งต่อการวิเคราะห์ที่แม่นยำ ดังนั้นควรเลือกเครื่องมือที่ให้คุณสมบัติการล้างข้อมูลและการจัดระเบียบที่มีประสิทธิภาพ

สนับสนุนลูกค้า

เลือกเครื่องมือรวบรวมข้อมูลเว็บพร้อมการสนับสนุนลูกค้าที่ตอบสนองและเป็นประโยชน์เพื่อช่วยเหลือคุณเมื่อเกิดปัญหาขึ้น ทดสอบการสนับสนุนลูกค้าโดยติดต่อพวกเขาและสังเกตระยะเวลาที่พวกเขาจะตอบกลับก่อนที่จะตัดสินใจอย่างรอบรู้

บทสรุป

เครื่องมือรวบรวมข้อมูลเว็บเป็นสิ่งจำเป็นสำหรับธุรกิจที่ต้องการดึงข้อมูลที่มีค่าจากเว็บไซต์เพื่อวัตถุประสงค์ต่างๆ เช่น การวิจัยตลาด SEO และการวิเคราะห์การแข่งขัน โดยการพิจารณาปัจจัยต่างๆ เช่น ราคา การใช้งานง่าย ความสามารถในการปรับขนาด คุณภาพและความถูกต้องของข้อมูล และการสนับสนุนลูกค้า คุณสามารถเลือกเครื่องมือรวบรวมข้อมูลเว็บที่เหมาะสมและตรงกับความต้องการของคุณ เครื่องมือรวบรวมข้อมูลเว็บ 25 อันดับแรกที่กล่าวถึงข้างต้นรองรับผู้ใช้หลากหลายประเภท ตั้งแต่ผู้ที่ไม่ใช่โปรแกรมเมอร์ไปจนถึงนักพัฒนา เพื่อให้มั่นใจว่ามีเครื่องมือที่เหมาะสมสำหรับทุกคน คุณยังสามารถลงทะเบียนเพื่อทดลองใช้ Scalenut ฟรี 7 วันเพื่อเพิ่มประสิทธิภาพเนื้อหาเว็บไซต์ของคุณและปรับปรุงอันดับของคุณ