XML-Sitemap: Schlüsselempfehlungen zur Optimierung

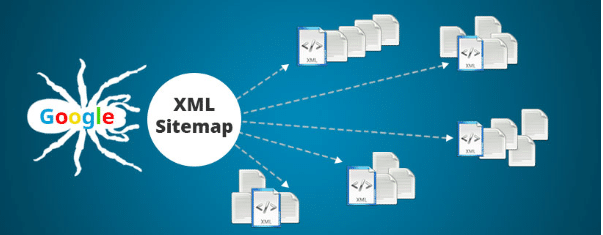

Veröffentlicht: 2021-03-26Die Sitemap.xml auf Ihrer Website kann als gute Navigation für die Seiten dienen, die der Google-Bot indizieren soll. Es hilft Ihnen, Ihre Hauptseiten schneller zu finden, auch wenn Sie keine gute interne Verlinkung haben.

In diesem Artikel stellen wir verschiedene Empfehlungen zur Optimierung von XML-Sitemaps vor und warum es gut ist, dies zu tun.

Funktionalitäten und Vorteile

Erleichtern Sie Bots die Arbeit und ermöglichen Sie es, „Berichte“ für Seiten und Links auf Ihrer Website zu erhalten, die nicht leicht gefunden werden konnten.

Einige der SEO-Vorteile sind wie folgt:

- schnellere Indexierung – Suchmaschinen finden neue Seiten viel schneller, sodass der Prozess der Indexierung und Anzeige der Website in den Suchergebnissen schneller abläuft. Das Besondere dabei ist, dass es Ihnen auch beim Deindexieren helfen kann (mehr Informationen hier);

- bessere Indexierung interner Seiten – Suchmaschinen können Seiten finden, die beim Crawlen der Website nicht gefunden wurden. Dies bedeutet jedoch nicht zwangsläufig, dass sie alle indiziert werden.

- Überwachung von indizierten Seiten. In Kombination mit der Google Search Console können Sie herausfinden, welche URLs in der von Google indexierten XML-Sitemap abgedeckt sind.

Ist eine XML-Sitemap wichtig?

Es ist wichtig für Websites, die:

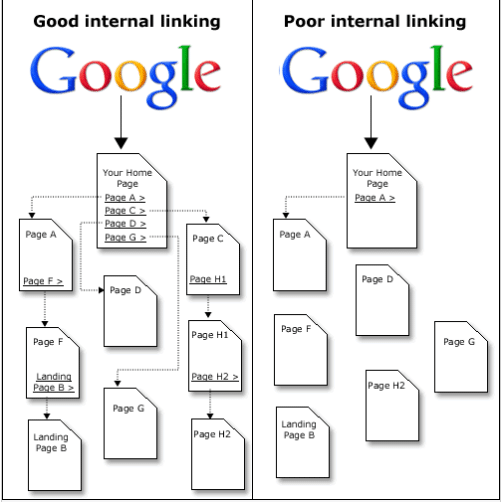

- keine gute Struktur oder keine gute Verteilung interner Links haben;

- viele Seiten haben – XML-Sitemap hilft Suchmaschinen dabei, Seiten zu finden, die neu oder aktualisiert sind;

- nicht viele eingehende Links haben – dies ist eine großartige Möglichkeit, Ihre Seiten zu finden.

Anforderungen und Formate

Google unterstützt mehrere Sitemap-Formate. Alle Formate und Standards finden Sie unter dieser Adresse: https://www.sitemaps.org/index.html.

Alle Formate begrenzen die Sitemap auf 50 MB (unkomprimiert) und 50.000 Adressen. Wenn Sie eine größere Datei oder mehr Adressen haben, müssen Sie eine Indexdatei mit allen Karten erstellen (wie im folgenden Artikel beschrieben).

Die wichtigsten Empfehlungen sind:

- die Datei muss mit UTF-8 kodiert sein;

- Es muss mit einem öffnenden Tag beginnen und mit einem schließenden Tag enden, z. B. …. ;

- geben Sie das Standardprotokoll im Tag an;

- Haupt-Tag für jeden URL-Eintrag ;

- Geben Sie im Tag die URL beginnend mit dem Protokoll (https oder http) an, die zum Speichern am Haupttag teilnehmen muss.

Zusätzliche optionale Attribute für XML-Sitemaps

Google verwendet das Attribut nicht auf seinen Websites. Alle anderen Attribute sind verfügbar, aber es hängt davon ab, ob sie reflektiert werden. Denken Sie daher daran, dass Google diese Tags nicht sehr ernst nimmt. Sie sind:

- – steht für das Datum der letzten Dateiänderung. Muss im W3C Datetime-Format vorliegen;

- – wie oft die Seite voraussichtlich aktualisiert wird. Dieser Wert liefert allgemeine Informationen zu Suchmaschinen. Gültige Werte können immer, stündlich, täglich, wöchentlich, monatlich, jährlich, nie sein.

Es sollte beachtet werden, dass der Wert dieses Tags eher als Hinweis denn als Befehl betrachtet wird. Roboter sehen diese Informationen und berücksichtigen sie, entscheiden aber letztendlich selbst, ob sie sie verwenden, abhängig von vielen anderen Faktoren.

- – Priorisiert die URL gegenüber anderen URLs auf Ihrer Website. Gültige Werte reichen von 0,0. auf 1,0.

Auch hier gilt es zu bedenken, dass diese Priorität relativ ist und keine zwingende Bedingung für Roboter ist oder zumindest noch nicht als solche akzeptiert wird. Wenn Sie sich jedoch entscheiden, es auszuprobieren, verwenden Sie die folgende Anleitung:

- 0 – 0,3: Veraltete Nachrichten, Informationen, die nicht mehr gültig, aber historisch nützlich sind;

- 4 – 0,7: Blogartikel, Seitenkategorien, häufig gestellte Fragen;

- 8 – 1.0: Startseite, Produktseiten, alle Seiten mit gut optimierten Inhalten.

Das folgende Beispiel zeigt eine Sitemap, die nur eine URL enthält und alle optionalen Tags verwendet, die kursiv geschrieben sind.

https://netpeak.bg

2018-09-15

monatlich

0,8

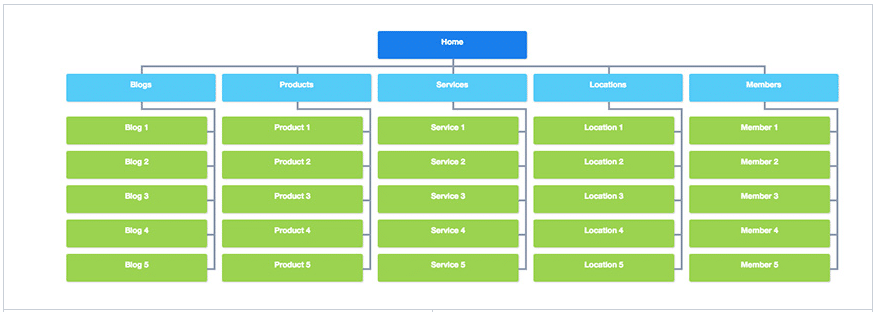

Identifizieren der wichtigen Seiten

Fügen Sie qualitativ hochwertige und gut optimierte Seiten hinzu. Die Gesamtqualität ist für ein besseres Ranking von großer Bedeutung. Dies ist ein schwerwiegender Faktor für Google, der Ihnen eine ernsthafte Priorität gegenüber der Konkurrenz verschaffen kann.

Wir möchten keine Seiten mit geringer Qualität besuchen, Google-Bots auch nicht. Wenn Sie es zu Tausenden von Seiten führen, die für Benutzer nicht nützlich und nicht gut optimiert sind, kann dies für Sie nur schädlich sein. Was sind qualitativ hochwertige Seiten? Einfach ausgedrückt, das sind Seiten, die:

- ausreichend einzigartigen Inhalt haben;

- binden Sie ihre Benutzer schnell ein, indem Sie sie zum Handeln auffordern (Kommentare, Rezensionen usw.);

- Bilder, Videos usw. enthalten;

- nicht gegen Google-Richtlinien verstoßen;

Seiten zum Indizieren geöffnet

Das Crawling-Budget stellt im Allgemeinen die Anzahl der Seiten dar, die pro Zeiteinheit (Tag, Woche, Monat usw.) gecrawlt werden. Daher ist es nicht ratsam, es unnötig zu verschwenden.

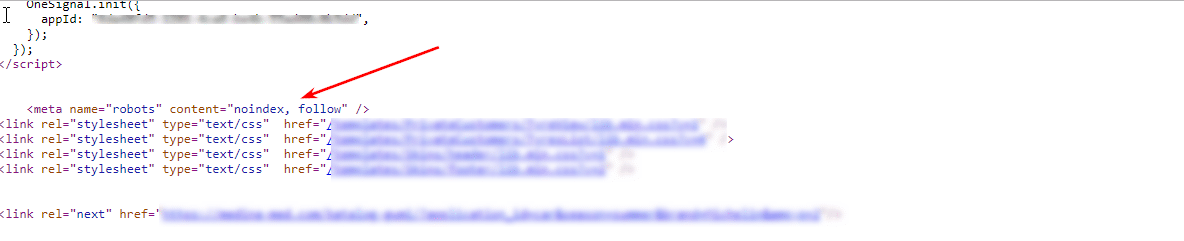

Seiten, die das Meta-Tag „Noindex“ enthalten, sollten nicht zur Sitemap hinzugefügt werden. einer logischen reihenfolge zu folgen ist für alles wichtig.

Es ist notwendig, eine automatisierte Prüfung durchzuführen und Adressen, die für die Indexierung geschlossen sind, nicht aufzunehmen.

Es wird empfohlen, diese Anweisungen zu befolgen:

- Wenn die Seite https://example.com/category/product ein Meta-Tag „noindex“ hat, sollte es nicht in die XML-Karte der Website aufgenommen werden;

- Wenn die Seite für die Indexierung über die robots.txt geschlossen wird, sollte sie nicht in die XML-Karte aufgenommen werden:

Nicht zulassen: /Kategorie/Produkt

Noindex: /Kategorie/Produkt

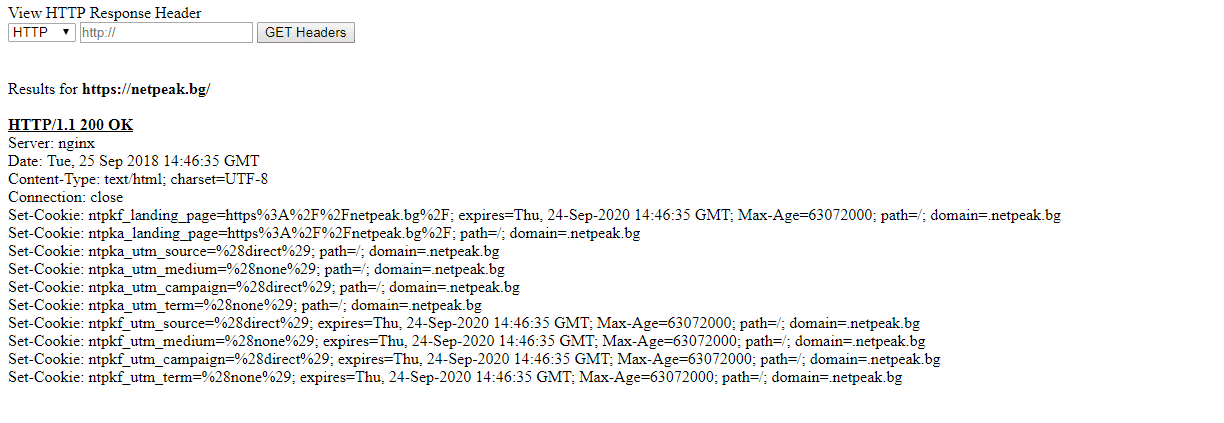

- Wird die Seite per X-Robots-Tag im HTTP-Header zur Indexierung geschlossen, sollte sie auch nicht in die XML-Map der Seite aufgenommen werden:

HTTP/1.1 200 OK

Datum: Di, 25. Mai 2010 21:42:43 GMT

(…)

X-Robots-Tag: noindex

(…)

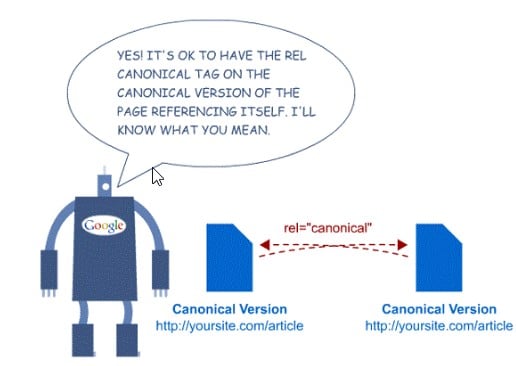

Kanonische Versionen der Seiten

Der Zugriff auf eine einzelne Seite über mehrere URLs mit ähnlichem Inhalt wird von Google als doppelt angesehen.

Sie müssen das Attribut „link rel canonical“ verwenden, um den Bot anzuweisen, welche die „Hauptseite“ ist und welche gecrawlt und indexiert werden soll.

Wenn beispielsweise die Seite https://example.com/category/product-1 kanonisch zu https://example.com/product ist, sollte http://example.com/category/product-1 nicht teilnehmen die XML-Sitemap.

Sie sollten eine automatisierte Prüfung durchführen, da Ihnen die Automatisierung von Prozessen sicherlich weniger Kopfschmerzen bereitet und Ihnen Zeit für manuelle Inspektionen erspart.

Seiten, die 200 OK zurückgeben

Schließen Sie Adressen ein, die eine 200-OK-Antwort zurückgeben. Es ist wichtig, automatisierte Prüfungen durchzuführen und keine Adressen aufzunehmen, die eine andere Antwort als 200 OK zurückgeben – zum Beispiel 404, 301 usw.

Wenn beispielsweise die Seite https://example.com/product eine andere Antwort als 200 OK zurückgibt, sollte sie nicht an der Sitemap teilnehmen.

Sie können das folgende Tool zur Überprüfung verwenden: https://soft.galinov.com/ zur Überprüfung.

Seiten aus Paginierung

Es ist nicht notwendig, absolut alle Seiten in die sitemap.xml aufzunehmen. Der Bot ist schlau genug, um bei richtiger Beschreibung von der ersten Seite in die entsprechende Kategorie zu navigieren. Es wird empfohlen, Folgendes zu tun:

- nur die Hauptseiten der Kategorien enthalten;

- markieren Sie die Seiten mit rel = next / rel = prev, damit der Roboter die Verbindung zwischen ihnen sehen kann;

- Jede Seite der Paginierung sollte eine kanonische Führung zu sich selbst haben, nicht zur Hauptseite, denn wenn es umgekehrt ist, bedeutet dies, dass Sie dem Bot sagen: „Es spielt keine Rolle, dass ich 5.000 Produkte und 20 Seiten habe, sie sind die gleichen wie die erste.“

Beispielsweise sollte die Seite https://example.com/category/page-2 nicht an der Karte teilnehmen. Hier finden Sie die offizielle Meinung von Google, sowie deren Empfehlungen:

Minimieren Sie die Dateigröße

Google und Bing haben die Dateigröße 2016 von 10 MB auf 50 MB erhöht, aber es ist immer noch eine gute Praxis, Ihre Sitemap so klein wie möglich zu halten.

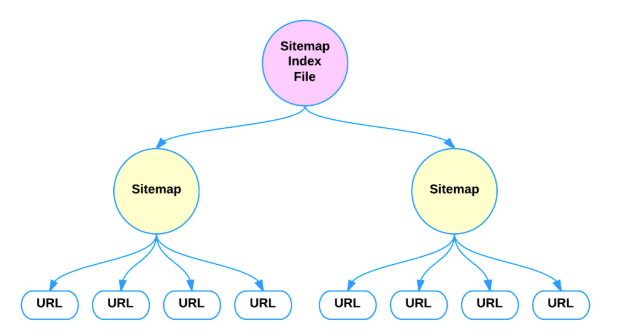

Natürlich ist das kein Grund zur Sorge, aber wenn Ihre Sitemap mehr als 50.000 URLs enthält oder 50 MB groß ist, sollte sie in mehr XML-Maps aufgeteilt werden. In diesem Fall sollten die Verweise auf alle XML-Karten in einer separaten Sitemap-Indexdatei beschrieben werden.

Was ist eine XML-Sitemap-Indexdatei?

Sie können mehrere Sitemap-Dateien einreichen, aber jede Datei muss den oben genannten Regeln entsprechen. Wenn Sie möchten, können Sie die Dateien mit gzip komprimieren, um sie entsprechend den Anforderungen zu verkleinern.

Das XML-Format der Indexdatei ist dem normalen Sitemap-Format sehr ähnlich. Es muss enthalten:

- Tag öffnen und schließen als ;

- einen Eintrag für jede Sitemap, wobei das Haupt-XML-Attribut ;

- -Tag zum Hauptattribut.

Das empfohlene Attribut ist ebenfalls enthalten.

Hinweis: Die Sitemap-Indexdatei kann nur Karten auflisten, die sich auf derselben Site befinden. Zum Beispiel:

https://example.com/sitemap_index.xml kann Karten auf https://example.com enthalten, aber nicht auf https://www.saitprimer.com oder https://www.example.com

Wie alle anderen Dateien muss auch die Indexdatei mit UTF-8 kodiert sein.

Das folgende Beispiel zeigt einen Sitemap-Index, der zwei Karten auflistet:

http://www.example.com/sitemap1.xml.gz

01.10.2018T18:23:17+00:00

http://www.example.com/sitemap2.xml.gz

01.01.2017

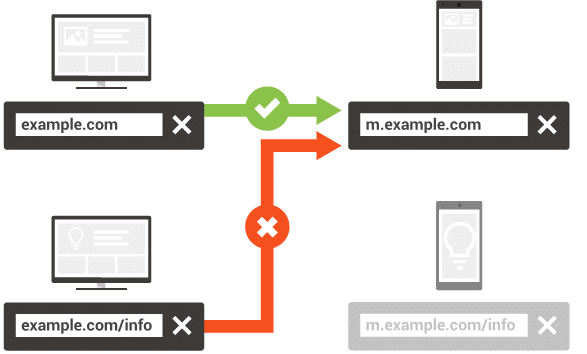

Beschreibung der mobilen Version

Wir müssen dem Google-Bot helfen, unsere Inhalte zu finden und die Verbindung zwischen den Desktop- und mobilen Seiten zu verstehen. In der XML-Sitemap muss das Attribut rel = „alternate“ für die Seiten der Desktop-Version wie folgt hinzugefügt werden:

xmlns:xhtml="http://www.w3.org/1999/xhtml">

http://www.example.com/page-1/

<xhtml:link

rel="alternativ"

media="only screen and (max-width: 640px)"

href="http://m.example.com/page-1" />

Denken Sie daran, dass jede Desktop-Seite einer Seite der mobilen Version entsprechen muss. Es empfiehlt sich beispielsweise nicht, mehrere Desktop-Seiten per rel = „alternate“ auf eine Seite der mobilen Version zu verlinken und umgekehrt.

Sie müssen auch nach Weiterleitungen suchen. Es ist wichtig, dass die Desktop-Seite dem gleichen Inhalt in der mobilen Version entspricht und nicht auf eine andere umgeleitet wird. Weitere Informationen hier.

Wie Bots Ihre XML-Sitemap finden können

Wenn Sie die gesamte Automatisierung des Prozesses abgeschlossen und ihn auf Ihren Server hochgeladen (oder von einem Plugin generiert) haben, müssen Sie einen Hinweis hinterlassen, wo Bots ihn finden können.

Am besten fügen Sie einen Link dazu in Ihre robots.txt-Datei ein. Dies wird auch Sitemap Discovery genannt und wurde bereits 2007 von Google, Bing und Yahoo eingeführt, um ihren Robotern beim Auffinden von XML-Sitemaps zu helfen.

Sie müssen lediglich den vollständigen Pfad zu Ihrer Karten- oder Indexdatei angeben.

Korrekte Transliteration von Adressen

Die offizielle Google-Dokumentation (Sitemap erstellen und einreichen) betont, dass alle Datenwerte (einschließlich URLs) nur ASCII-Zeichen enthalten dürfen. Es darf keine Steuercodes oder Sonderzeichen wie * oder {} enthalten.

Wenn die URL Ihrer Website diese Zeichen enthält, erhalten Sie eine Fehlermeldung, wenn Sie versuchen, sie hinzuzufügen.

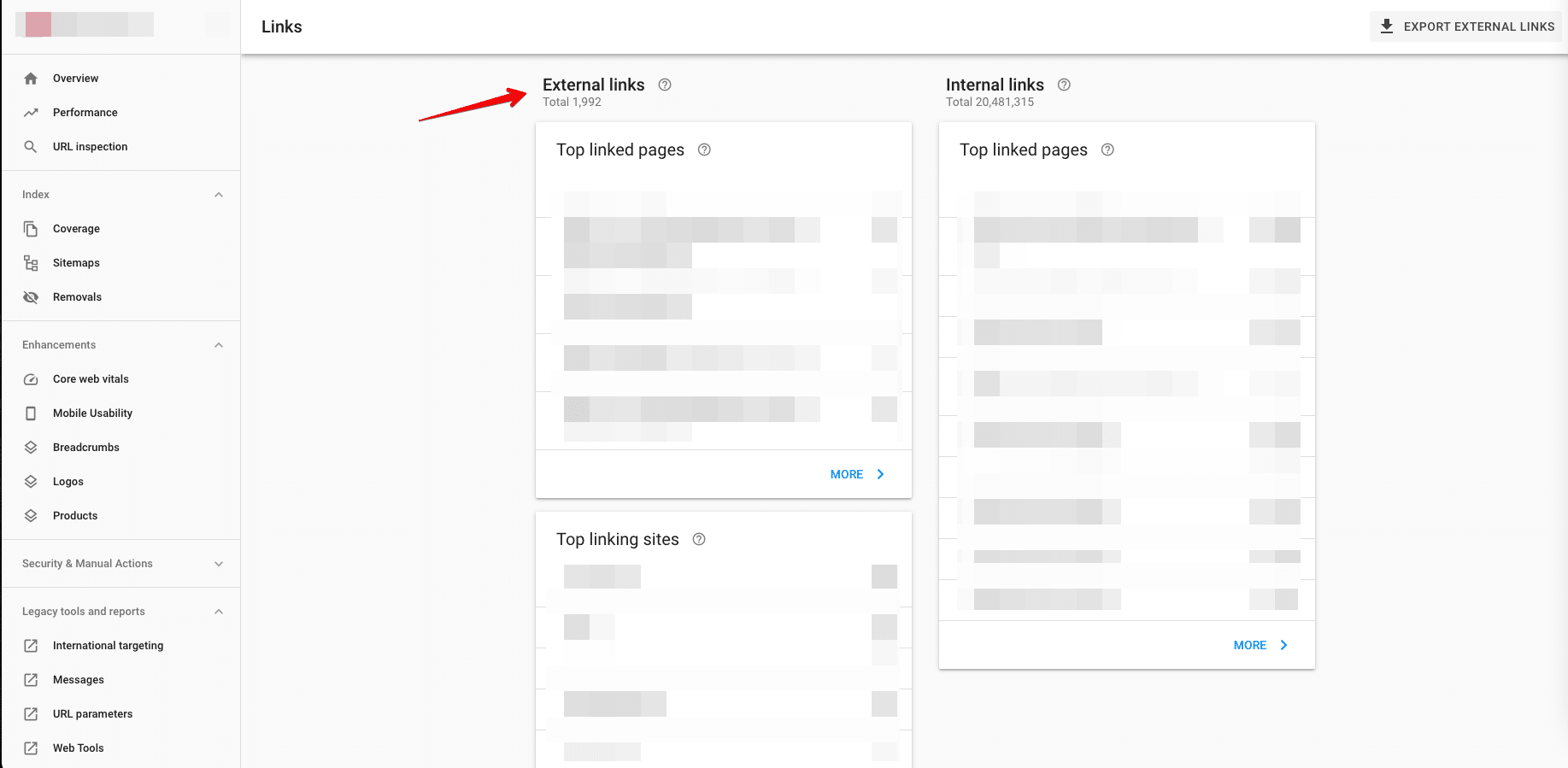

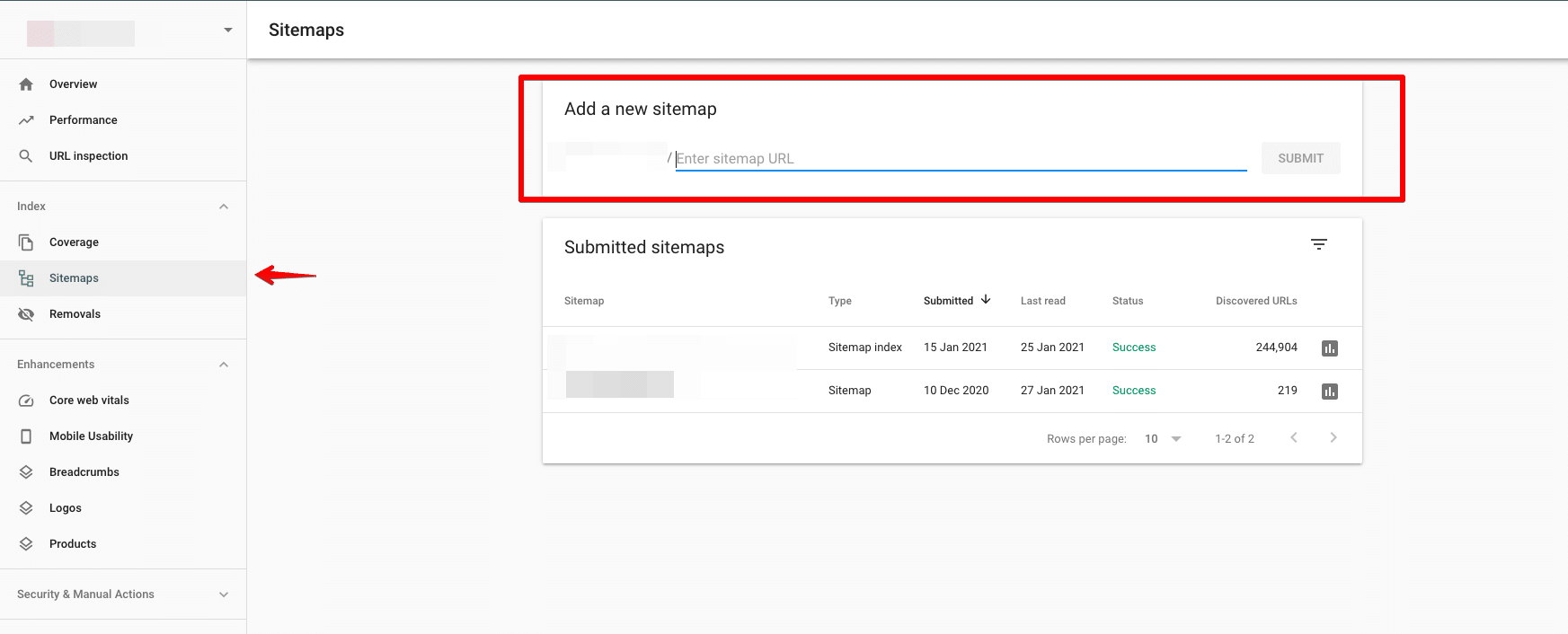

Senden Sie Ihre Karte an Google

Sie können Ihre Sitemap über die Google Search Console an Google übermitteln.

Prüfen Sie vor dem Absenden auf Fehler. Es ist wichtig, alle Fehler zu beseitigen, die ein Hindernis für die Indizierung wichtiger Zielseiten darstellen könnten.

Idealerweise sollte die Anzahl der indizierten Seiten gleich der Anzahl der eingereichten Seiten sein.

Fazit

- Seien Sie konsequent – wenn die Seite durch robots.txt oder durch „noindex“ blockiert wird, ist es besser, wenn sie nicht in Ihrer XML-Karte ist.

- Automatisieren Sie Ihren Prozess – alle oben genannten Empfehlungen sollten für die Automatisierung verfügbar sein, da dies Ihnen Zeit spart, das Crawling-Budget optimiert hält und Ihnen auch eine Menge Kopfschmerzen erspart.

- Wenn Sie eine sehr große Website haben, verwenden Sie eine Indexdatei mit verschiedenen Karten, die Ihnen Serverzeit sparen und alle wichtigen Seiten Ihrer Website abdecken.